翻译

Elasticsearch-PHP 中文手册上线了

文档翻译 • medcl 发表了文章 • 1 个评论 • 4099 次浏览 • 2018-05-17 16:24

【翻译】Elasticsearch索引性能优化(2)

Elasticsearch • nodexy 发表了文章 • 0 个评论 • 9608 次浏览 • 2017-10-15 13:41

作者:Adam Vanderbush 译者:杨振涛@vivo 本系列文章重点关注如何最大化地提升elasticsearch的索引吞吐量和降低监控与管理负荷。 Elasticsearch是准实时的,这表示当索引一个文档后,需要等待下一次刷新后就可以搜索到该文档了。 刷新是一个开销较大的操作,这就是为什么默认要设置一个特定的间隔,而不是每索引一个文档就刷新一次。如果想索引大批量的文档,并不需要立刻就搜索到新的索引信息,为了优化索引性能甚至搜索性能,可以临时降低刷新的频率,直到索引操作完成。 一个索引库的分片由多个段组成。Lucene的核心数据结构中,一个段本质上是索引库的一个变更集。这些段是在每次刷新时所创建,随后会在后台合并到一起,以保证资源的高效使用;每个段都会消耗文件句柄、内存和CPU。工作在该场景背后的Lucene负责段的合并,一旦处理不当,可能会消耗昂贵的计算资源并导致Elasticsearch自动降级索引请求到一个单一线程上。 本文将继续关注Elasticsearch的索引性能调优,重点聚焦在集群和索引级别的各种索引配置项设置。 1 关注refresh_interval参数 这个间隔通过参数index.refresh_interval设置,既可以在Elasticsearch配置文件里全局设置,也可以针对每一个索引库单独设置。如果同时设置,索引库设置会覆盖全局配置。默认值是1s,因此最新索引的文档最多不超过1s后即可搜索到。 因为刷新是非常昂贵的操作,提升索引吞吐量的方式之一就是增大refresh_interval;更少的刷新意味着更低的负载,并且更多的资源可以向索引线程倾斜。因此,根据搜索需求,可以考虑设置刷新间隔为大于1秒的值;甚至可以考虑在某些时候,比如执行批量索引时,临时关闭索引库的刷新操作,执行结束后再手动打开。 更新设置API可以在批量索引时动态改变索引以便更加高效,然后再修改为更加实时的索引状态。在批量索引开始前,设置:本文翻译自QBox官方博客的“Elasticsearch索引性能优化”系列文章中的第二篇,版权归原作者 Adam Vanderbush所有。该系列文章共有三篇,其中第一篇已有同行翻译,参考链接http://www.zcfy.cc/article/how ... .html 后续还会有第三篇的推送,敬请关注。

curl -XPUT 'localhost:9200/test/_settings' -d '{

"index" : {

"refresh_interval" : "-1"

}

}'curl -XPUT 'localhost:9200/my_index/_settings' -d ' {

"index" : {

"number_of_replicas" : 0

}

}'curl -XPUT 'localhost:9200/my_index/_settings' -d '{

"index" : {

"refresh_interval" : "1s"

}

}'curl -XPOST 'localhost:9200/my_index/_forcemerge?max_num_segments=5'curl -XPOST 'localhost:9200/my_index/_refresh'curl -XPUT 'localhost:9200/test/_settings' -d '{

"index" : {

"refresh_interval" : "-1"

}

}'curl -XPUT 'localhost:9200/_cluster/settings' -d '{

"transient" : {

"indices.store.throttle.type" : "none"

}

}'curl -XPUT 'localhost:9200/_cluster/settings' -d '{

"transient" : {

"indices.store.throttle.type" : "merge"

}

}'curl -XPUT 'localhost:9200/my_index/_settings' -d '{

"index.merge.scheduler.max_thread_count" : 1

}'curl -XPUT 'localhost:9200/_settings' -d '{

"index.merge.scheduler.max_thread_count" : 1

}'

未经授权,禁止转载。 英文原文地址:https://qbox.io/blog/maximize- ... art-2杨振涛 vivo互联网搜索引擎团队负责人,开发经理。10年数据和软件领域经验,先后从事基因测序、电商、IM及厂商互联网领域的系统架构设计和实现。专注于实时分布式系统和大数据的存储、检索和可视化,尤其是搜索引擎及深度学习在NLP方向的应用。技术翻译爱好者,TED Translator,InfoQ中文社区编辑。

《Elasticsearch权威指南》中文版背后的故事

文档翻译 • medcl 发表了文章 • 9 个评论 • 7651 次浏览 • 2017-05-31 17:45

《Elasticsearch 权威指南》中文版

资讯动态 • medcl 发表了文章 • 3 个评论 • 30296 次浏览 • 2017-01-09 16:29

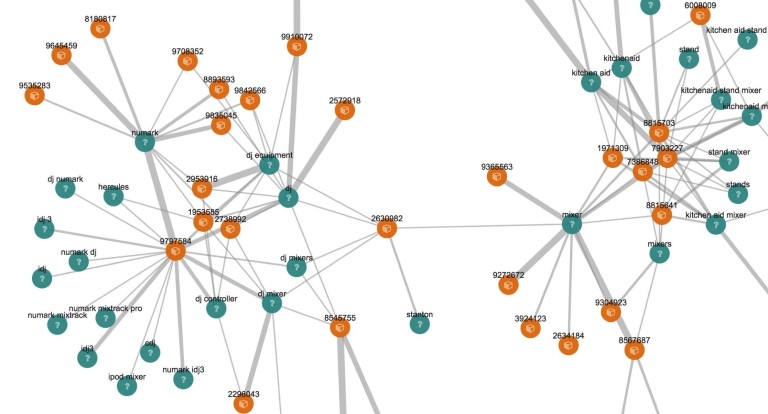

Elastic 为 Elastic Stack 带来新的 Graph 实时图分析功能

资讯动态 • medcl 发表了文章 • 1 个评论 • 14322 次浏览 • 2016-03-31 09:36

Elasticsearch-PHP 中文手册上线了

文档翻译 • medcl 发表了文章 • 1 个评论 • 4099 次浏览 • 2018-05-17 16:24

【翻译】Elasticsearch索引性能优化(2)

Elasticsearch • nodexy 发表了文章 • 0 个评论 • 9608 次浏览 • 2017-10-15 13:41

作者:Adam Vanderbush 译者:杨振涛@vivo 本系列文章重点关注如何最大化地提升elasticsearch的索引吞吐量和降低监控与管理负荷。 Elasticsearch是准实时的,这表示当索引一个文档后,需要等待下一次刷新后就可以搜索到该文档了。 刷新是一个开销较大的操作,这就是为什么默认要设置一个特定的间隔,而不是每索引一个文档就刷新一次。如果想索引大批量的文档,并不需要立刻就搜索到新的索引信息,为了优化索引性能甚至搜索性能,可以临时降低刷新的频率,直到索引操作完成。 一个索引库的分片由多个段组成。Lucene的核心数据结构中,一个段本质上是索引库的一个变更集。这些段是在每次刷新时所创建,随后会在后台合并到一起,以保证资源的高效使用;每个段都会消耗文件句柄、内存和CPU。工作在该场景背后的Lucene负责段的合并,一旦处理不当,可能会消耗昂贵的计算资源并导致Elasticsearch自动降级索引请求到一个单一线程上。 本文将继续关注Elasticsearch的索引性能调优,重点聚焦在集群和索引级别的各种索引配置项设置。 1 关注refresh_interval参数 这个间隔通过参数index.refresh_interval设置,既可以在Elasticsearch配置文件里全局设置,也可以针对每一个索引库单独设置。如果同时设置,索引库设置会覆盖全局配置。默认值是1s,因此最新索引的文档最多不超过1s后即可搜索到。 因为刷新是非常昂贵的操作,提升索引吞吐量的方式之一就是增大refresh_interval;更少的刷新意味着更低的负载,并且更多的资源可以向索引线程倾斜。因此,根据搜索需求,可以考虑设置刷新间隔为大于1秒的值;甚至可以考虑在某些时候,比如执行批量索引时,临时关闭索引库的刷新操作,执行结束后再手动打开。 更新设置API可以在批量索引时动态改变索引以便更加高效,然后再修改为更加实时的索引状态。在批量索引开始前,设置:本文翻译自QBox官方博客的“Elasticsearch索引性能优化”系列文章中的第二篇,版权归原作者 Adam Vanderbush所有。该系列文章共有三篇,其中第一篇已有同行翻译,参考链接http://www.zcfy.cc/article/how ... .html 后续还会有第三篇的推送,敬请关注。

curl -XPUT 'localhost:9200/test/_settings' -d '{

"index" : {

"refresh_interval" : "-1"

}

}'curl -XPUT 'localhost:9200/my_index/_settings' -d ' {

"index" : {

"number_of_replicas" : 0

}

}'curl -XPUT 'localhost:9200/my_index/_settings' -d '{

"index" : {

"refresh_interval" : "1s"

}

}'curl -XPOST 'localhost:9200/my_index/_forcemerge?max_num_segments=5'curl -XPOST 'localhost:9200/my_index/_refresh'curl -XPUT 'localhost:9200/test/_settings' -d '{

"index" : {

"refresh_interval" : "-1"

}

}'curl -XPUT 'localhost:9200/_cluster/settings' -d '{

"transient" : {

"indices.store.throttle.type" : "none"

}

}'curl -XPUT 'localhost:9200/_cluster/settings' -d '{

"transient" : {

"indices.store.throttle.type" : "merge"

}

}'curl -XPUT 'localhost:9200/my_index/_settings' -d '{

"index.merge.scheduler.max_thread_count" : 1

}'curl -XPUT 'localhost:9200/_settings' -d '{

"index.merge.scheduler.max_thread_count" : 1

}'

未经授权,禁止转载。 英文原文地址:https://qbox.io/blog/maximize- ... art-2杨振涛 vivo互联网搜索引擎团队负责人,开发经理。10年数据和软件领域经验,先后从事基因测序、电商、IM及厂商互联网领域的系统架构设计和实现。专注于实时分布式系统和大数据的存储、检索和可视化,尤其是搜索引擎及深度学习在NLP方向的应用。技术翻译爱好者,TED Translator,InfoQ中文社区编辑。

《Elasticsearch权威指南》中文版背后的故事

文档翻译 • medcl 发表了文章 • 9 个评论 • 7651 次浏览 • 2017-05-31 17:45

《Elasticsearch 权威指南》中文版

资讯动态 • medcl 发表了文章 • 3 个评论 • 30296 次浏览 • 2017-01-09 16:29

Elastic 为 Elastic Stack 带来新的 Graph 实时图分析功能

资讯动态 • medcl 发表了文章 • 1 个评论 • 14322 次浏览 • 2016-03-31 09:36