elasticsearch 机器 segment count/system load 突增的情况

Elasticsearch | 作者 ykgarfield | 发布于2020年06月10日 | 阅读数:3519elasticsearch 机器 segment count/system load 突增的情况

数据规模: 1 个集群有 24 个节点的 es, 每天大概有 8T 数据(算上 1 个副本, 就是 16T, 80 亿左右的数据)

1. 查看 zabbix 的监控情况, 每天有几个时间点会出现 es 机器 Disk Read Bytes/sec 突增的情况(会导致 CPU、磁盘 IO 负载变高, 写入速率变低, 并有延迟)

2. 查看 kibana 的监控, Segment Count 在那几个点数量也会变多,system load 也会随着变高

3. 从 kafka 消费写入 es 的速率是比较恒定的, 消息量并没有出现太大的波动.

segment count/system load 的监控信息:

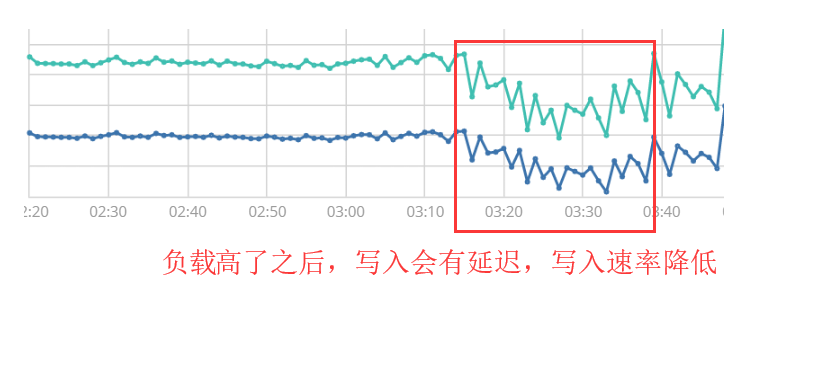

Indexing Rate 的监控信息:

不知道有没有遇到过类似问题的小伙伴.

4 个回复

byx313 - BLOG:https://www.jianshu.com/u/43fd06f9589c

赞同来自:

laoyang360 - 《一本书讲透Elasticsearch》作者,Elastic认证工程师 [死磕Elasitcsearch]知识星球地址:http://t.cn/RmwM3N9;微信公众号:铭毅天下; 博客:https://elastic.blog.csdn.net

赞同来自:

locatelli

赞同来自:

heeexy

赞同来自:

日志的机器read基本就是segment merge引起的。

可以考虑把索引纬度拆细,单个索引小一点