elasticsearch6.3 接收logstash 转发filebeat 的日志数据报错

Elasticsearch | 作者 sun_changlong | 发布于2018年07月02日 | 阅读数:3218

elasticsearch.yml配置如下:

logstash配置如下:

Ps:如果上述hosts 地址后出现异常字符,实属网页乱码。hosts => ["http://192.168.33.85:9200"]

filebeat配置如下:

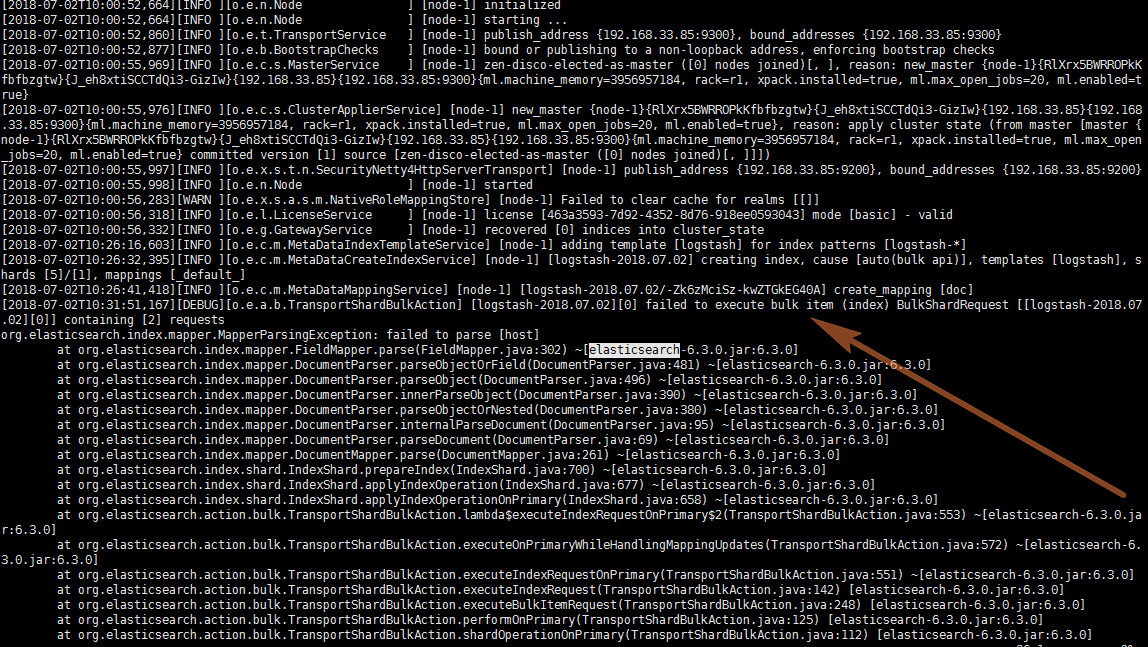

logstash能成功接收filebeat的日志数据,elasticsearch 报错如下:

logstash 在设置输为input { stdin { } }时,elasticsearch 接收不会报错。目前尝试接收filebeat的日志后会出现上述问题,有哪位大牛知道问题所在?

Ps: 还未尝试filebeat 直接发送日志数据到elasticsearch

cluster.name: my-application

node.name: node-1

node.attr.rack: r1

path.data: /home/elasticsearch/data

path.logs: /home/elasticsearch/logs

network.host: 192.168.33.85

http.port: 9200logstash配置如下:

input {

beats {

port => 5044

}

}

filter {

grok {

match => { "message" => "%{COMBINEDAPACHELOG}" }

}

date {

match => [ "timestamp" , "dd/MMM/yyyy:HH:mm:ss Z" ]

}

}

output {

elasticsearch { hosts => ["http://192.168.33.85:9200"] }

stdout { codec => rubydebug }

}Ps:如果上述hosts 地址后出现异常字符,实属网页乱码。hosts => ["http://192.168.33.85:9200"]

filebeat配置如下:

filebeat.inputs:

- type: log

enabled: true

paths:

- /var/log/*.log

filebeat.config.modules:

path: ${path.config}/modules.d/*.yml

reload.enabled: false

setup.template.settings:

index.number_of_shards: 3

setup.kibana:

output.logstash:

hosts: ["localhost:5044"]logstash能成功接收filebeat的日志数据,elasticsearch 报错如下:

logstash 在设置输为input { stdin { } }时,elasticsearch 接收不会报错。目前尝试接收filebeat的日志后会出现上述问题,有哪位大牛知道问题所在?

Ps: 还未尝试filebeat 直接发送日志数据到elasticsearch

1 个回复

garfieldcgf

赞同来自: