ElasticTalk

ElasticTalk #16 ElasticSearch 监控那些事儿

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3632 次浏览 • 2019-06-09 21:15

【直播回放】ElasticTalk #15 Filebeat Modules 简介

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3245 次浏览 • 2019-06-09 21:12

【直播回放】ElasticTalk #14 Elastic 安全功能体验

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3085 次浏览 • 2019-05-25 19:02

【直播报名】ElasticTalk #14 Elastic 安全功能体验

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3254 次浏览 • 2019-05-25 13:41

【直播回放】ElasticTalk #13 如何使用 Kibana 快速分析表单数据

资讯动态 • rockybean 发表了文章 • 0 个评论 • 2936 次浏览 • 2019-05-19 19:30

【直播报名】ElasticTalk #13 如何使用 Kibana 快速分析表单数据

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3201 次浏览 • 2019-05-18 09:49

【直播回放】ElasticTalk #12 Elasticsearch 数据建模

资料分享 • rockybean 发表了文章 • 0 个评论 • 5661 次浏览 • 2019-05-12 08:17

- 数据建模是什么?

- 数据建模的过程有哪些?

- [size=20]Elasticsearch 数据建模要注意哪些?[/size]

【直播报名】ElasticTalk #12 Elasticsearch 数据建模

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3291 次浏览 • 2019-05-11 12:03

【直播回放】ElasticTalk #11 用 ELK 来分析 Elastic 的版本发布情况

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3009 次浏览 • 2019-05-04 19:19

- Logstash 是什么以及主要组成?

- [size=16]如何使用 Logstash 来爬取 github 上的 elastic 版本数据?[/size]

- 如何使用 Kibana 来动态分析 elastic 发布数据?

ElasticTalk #11 用 ELK 来分析 Elastic 的版本发布情况

资讯动态 • rockybean 发表了文章 • 0 个评论 • 4283 次浏览 • 2019-05-02 18:56

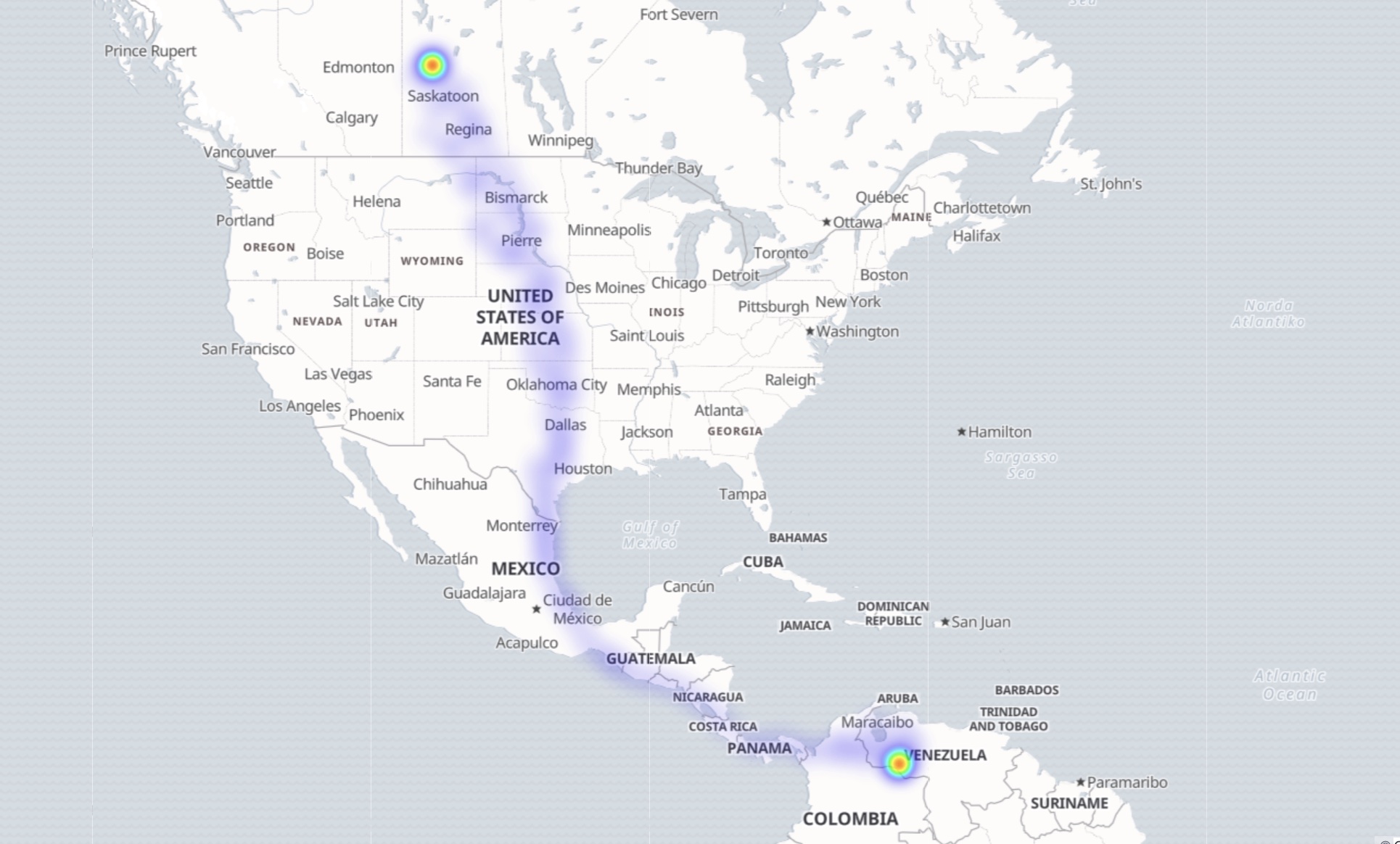

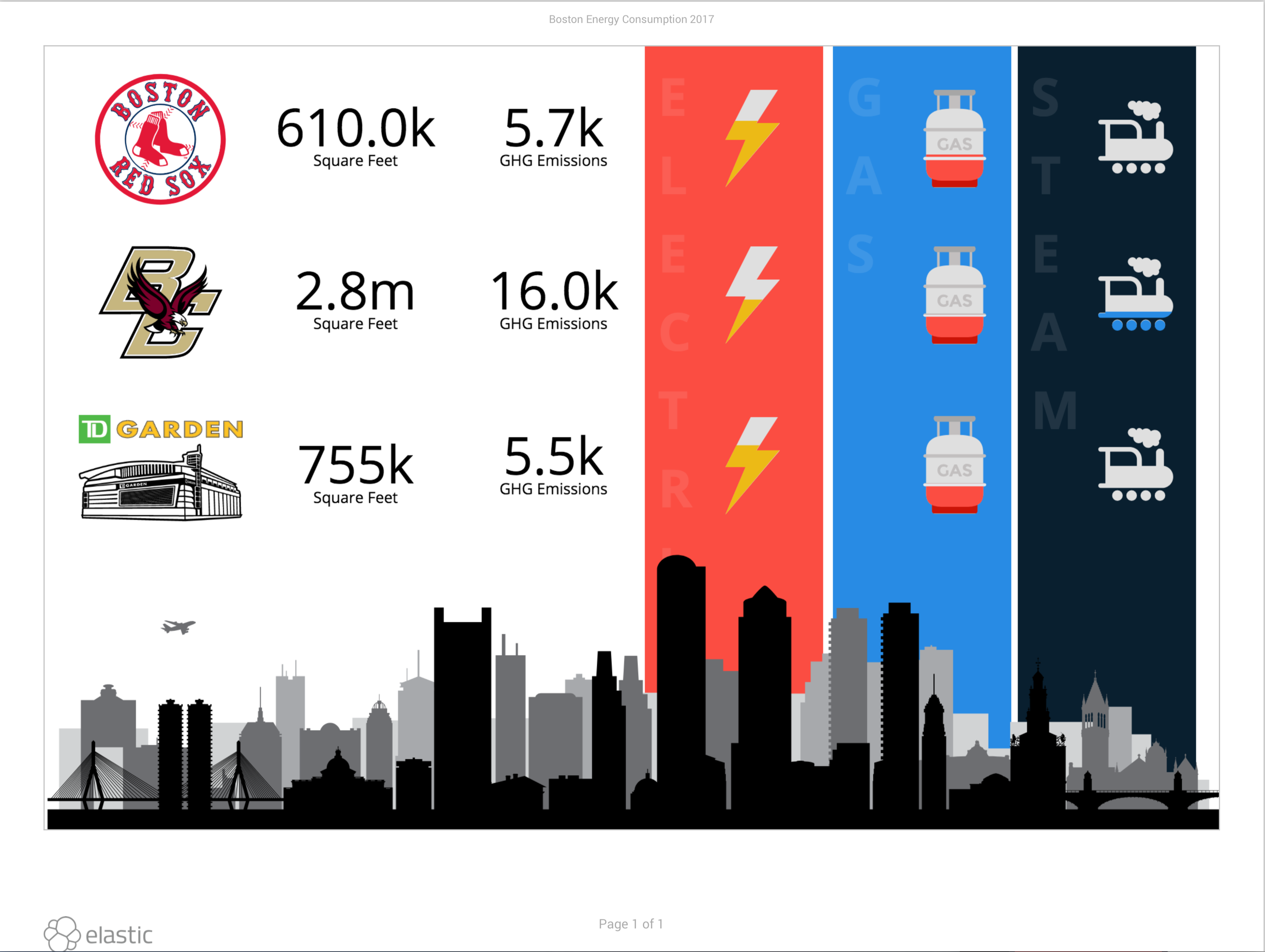

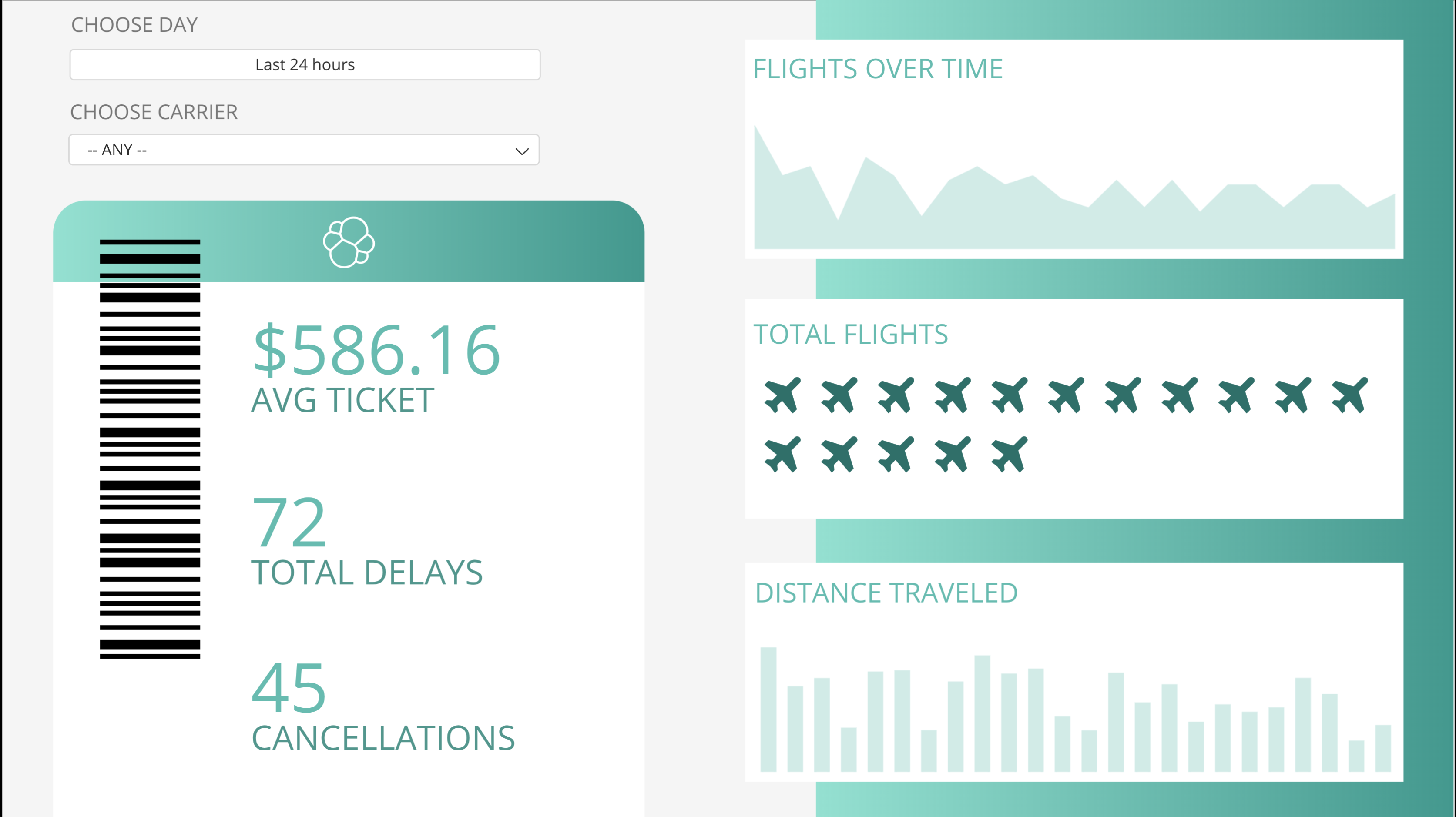

【直播回放】ElasticTalk #10 Kibana Canvas Intro

资料分享 • rockybean 发表了文章 • 0 个评论 • 5802 次浏览 • 2019-04-27 17:03

- Canvas 是什么?

- Canvas 与 Dashboard 的区别

- Canvas 如何上手?

【直播报名】ElasticTalk #10 Kibana Canvas Intro

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3767 次浏览 • 2019-04-27 12:09

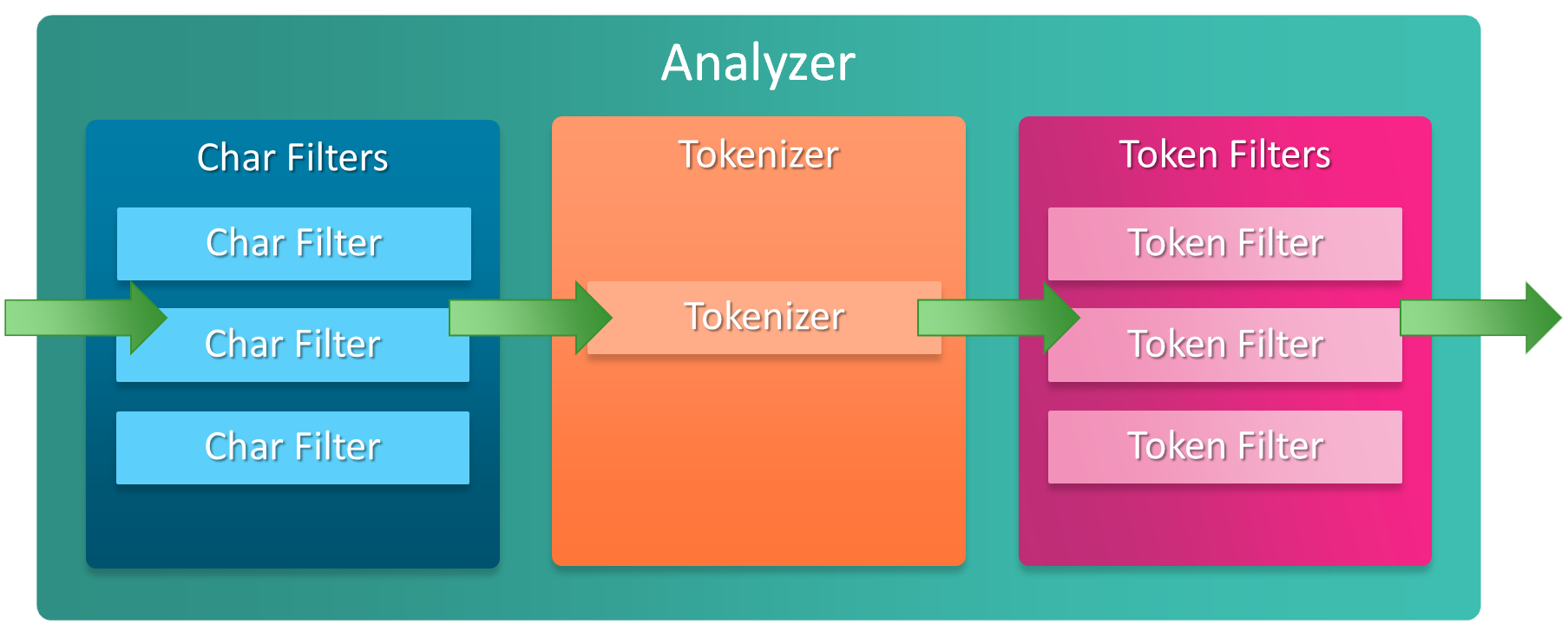

【直播回放】ElasticTalk #9 Elasticsearch 分词器那些事儿

资讯动态 • rockybean 发表了文章 • 9 个评论 • 4145 次浏览 • 2019-04-21 09:14

- 分词是什么?

- 分词器是什么?有哪些组成

- analyze api 如何使用

- 常见的场景

【直播报名】ElasticTalk #9 Elasticsearch 分词器那些事儿

资料分享 • rockybean 发表了文章 • 0 个评论 • 3583 次浏览 • 2019-04-20 08:03

【直播回放】ElasticTalk #8 ECE - 即刻实现 Elasticsearch 私有云

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3901 次浏览 • 2019-04-13 19:53

ElasticTalk #16 ElasticSearch 监控那些事儿

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3632 次浏览 • 2019-06-09 21:15

【直播回放】ElasticTalk #15 Filebeat Modules 简介

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3245 次浏览 • 2019-06-09 21:12

【直播回放】ElasticTalk #14 Elastic 安全功能体验

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3085 次浏览 • 2019-05-25 19:02

【直播报名】ElasticTalk #14 Elastic 安全功能体验

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3254 次浏览 • 2019-05-25 13:41

【直播回放】ElasticTalk #13 如何使用 Kibana 快速分析表单数据

资讯动态 • rockybean 发表了文章 • 0 个评论 • 2936 次浏览 • 2019-05-19 19:30

【直播报名】ElasticTalk #13 如何使用 Kibana 快速分析表单数据

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3201 次浏览 • 2019-05-18 09:49

【直播回放】ElasticTalk #12 Elasticsearch 数据建模

资料分享 • rockybean 发表了文章 • 0 个评论 • 5661 次浏览 • 2019-05-12 08:17

- 数据建模是什么?

- 数据建模的过程有哪些?

- [size=20]Elasticsearch 数据建模要注意哪些?[/size]

【直播报名】ElasticTalk #12 Elasticsearch 数据建模

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3291 次浏览 • 2019-05-11 12:03

【直播回放】ElasticTalk #11 用 ELK 来分析 Elastic 的版本发布情况

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3009 次浏览 • 2019-05-04 19:19

- Logstash 是什么以及主要组成?

- [size=16]如何使用 Logstash 来爬取 github 上的 elastic 版本数据?[/size]

- 如何使用 Kibana 来动态分析 elastic 发布数据?

ElasticTalk #11 用 ELK 来分析 Elastic 的版本发布情况

资讯动态 • rockybean 发表了文章 • 0 个评论 • 4283 次浏览 • 2019-05-02 18:56

【直播回放】ElasticTalk #10 Kibana Canvas Intro

资料分享 • rockybean 发表了文章 • 0 个评论 • 5802 次浏览 • 2019-04-27 17:03

- Canvas 是什么?

- Canvas 与 Dashboard 的区别

- Canvas 如何上手?

【直播报名】ElasticTalk #10 Kibana Canvas Intro

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3767 次浏览 • 2019-04-27 12:09

【直播回放】ElasticTalk #9 Elasticsearch 分词器那些事儿

资讯动态 • rockybean 发表了文章 • 9 个评论 • 4145 次浏览 • 2019-04-21 09:14

- 分词是什么?

- 分词器是什么?有哪些组成

- analyze api 如何使用

- 常见的场景

【直播报名】ElasticTalk #9 Elasticsearch 分词器那些事儿

资料分享 • rockybean 发表了文章 • 0 个评论 • 3583 次浏览 • 2019-04-20 08:03

【直播回放】ElasticTalk #8 ECE - 即刻实现 Elasticsearch 私有云

资讯动态 • rockybean 发表了文章 • 0 个评论 • 3901 次浏览 • 2019-04-13 19:53