agent

【搜索客社区日报】第2138期 (2025-11-03)

社区日报 • Muses 发表了文章 • 0 个评论 • 8215 次浏览 • 2025-11-03 20:22

【搜索客社区日报】第2134期 (2025-10-27)

社区日报 • Muses 发表了文章 • 0 个评论 • 8267 次浏览 • 2025-10-27 17:18

【搜索客社区日报】第2123期 (2025-09-29)

社区日报 • Muses 发表了文章 • 0 个评论 • 10173 次浏览 • 2025-09-29 15:18

【搜索客社区日报】第2119期 (2025-09-22)

社区日报 • Muses 发表了文章 • 0 个评论 • 12158 次浏览 • 2025-09-22 13:44

【搜索客社区日报】第2110期 (2025-09-08)

社区日报 • Muses 发表了文章 • 0 个评论 • 4847 次浏览 • 2025-09-08 16:03

【搜索客社区日报】第2105期 (2025-09-01)

社区日报 • Muses 发表了文章 • 0 个评论 • 5409 次浏览 • 2025-09-01 12:17

INFINI Labs 产品更新 | Console/Gateway/Agent 等产品开源发布首个版本

资讯动态 • INFINI Labs 小助手 发表了文章 • 1 个评论 • 4154 次浏览 • 2024-12-27 16:11

INFINI Labs 产品又更新啦~,包括 Easysearch v1.9.0、Gateway、Console、Agent、Loadgen v1.27.0。本次各产品更新了很多亮点功能,如 Easysearch 新增 rollup 功能,优化了多版本兼容配置;Console/Gateway/Agent/Loadgen 及 Framework 开源后,发布首个重大更新版本,支持过期元数据删除,指标图表懒加载,指标采集协程优化等等,欢迎大家下载体验。

INFINI Easysearch v1.9.0

INFINI Easysearch 是一个分布式的搜索型数据库,实现非结构化数据检索、全文检索、向量检索、地理位置信息查询、组合索引查询、多语种支持、聚合分析等。Easysearch 可以完美替代 Elasticsearch,同时添加和完善多项企业级功能。Easysearch 助您拥有简洁、高效、易用的搜索体验。详情见:https://infinilabs.cn

Easysearch 本次更新如下:

Improvements

-

发布 rollup 功能

- 支持自动对 rollup 索引进行滚动,无需外部触发

- 支持 avg sum max min value_count percentiles 指标类型的聚合

- 支持 terms 聚合

- 支持对指标聚合进行 Pipeline 聚合

- 支持聚合前先对数据进行过滤

- 进行聚合查询时支持直接搜索原始索引,不用更改搜索代码

- 增加适配 logstash 8.x 的请求 header

- _cat/templates 增加 lifecycle 和 rollover 列的展示

Bug fix

- 修复 rest-api template 测试错误

INFINI Console v1.27.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。开源地址:https://github.com/infinilabs/console

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

Console 本次更新如下:

Improvements

- 代码开源,统一采用 Github 仓库进行开发

- 指标采集优化,由原来的单一协程采集调整为每个注册的集群有单独的协程进行采集

- 指标监控页面图表展示采用懒加载、单个图表独立加载,增强用户体验

- 通用时间控件增加超时时间设置

- 集群选择控件增加注册、刷新功能

- 提供指标采集状态

- 表格控件排版优化

Bug fix

- 修复集群元数据更新不及时问题

- 修复帮助文档等链接不正确问题

- 修复节点、索引数据因随机 id 出现重复记录问题

- 修复 Runtime、Agent 实例编辑页面出错问题

- 修复集群、节点、索引、分片元数据无 Loading 问题

- 修复索引健康状态指标采集失败问题

- 修复个别菜单列未国际化问题

INFINI Gateway v1.27.0

INFINI Gateway 是一个面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway 可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。开源地址:https://github.com/infinilabs/gateway

Gateway 本次更新如下:

Improvements

- 调整队列消费者 slice 默认配置为 1

Bug fix

- 修复缓存数据丢失导致队列无法消费问题

- 同步更新 Framework 修复的一些已知问题

INFINI Agent v1.27.0

INFINI Agent 是 INFINI Console 的一个可选探针组件,负责采集和上传集群指标和日志等信息,并可通过 Console 管理。Agent 支持主流操作系统和平台,安装包轻量且无任何外部依赖,可以快速方便地安装。开源地址:https://github.com/infinilabs/agent

探针 Agent 本次更新如下:

Improvements

- 与 INFINI Console 统一版本号

- 同步更新 Framework 修复的已知问题

- 支持 K8S 环境指标采集

INFINI Loadgen v1.27.0

INFINI Loadgen 是一款轻量、无依赖的 Eaysearch/Elasticsearch/OpenSearch 性能压测工具,支持参数模板化配置,支持压测端均衡流量控制,可以模拟高并发请求。开源地址:https://github.com/infinilabs/loadgen

Loadgen 本次更新如下:

Improvements

- 保持与 Console 相同版本

- 同步更新 Framework 修复的已知问题

Bug fix

- 修复 API 接口测试逻辑异常问题

INFINI Framework

INFINI Framework 是 INFINI Labs 各产品依赖的核心公共代码库。开源地址:https://github.com/infinilabs/framework

Improvements

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

下载地址: https://infinilabs.cn/download

邮件:hello@infini.ltd

电话:(+86) 400-139-9200

Discord:https://discord.gg/4tKTMkkvVX

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群一起讨论交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

【搜索客社区日报】第1843期 (2024-06-21)

社区日报 • Fred2000 发表了文章 • 0 个评论 • 2903 次浏览 • 2024-06-22 23:57

【搜索客社区日报】 第1824期 (2024-05-24)

社区日报 • searchkit 发表了文章 • 0 个评论 • 3444 次浏览 • 2024-05-24 13:17

INFINI Labs 产品更新 | 修复 Easysearch 跨集群复制索引同步问题,Gateway 内存异常增长等问题

Easysearch • liaosy 发表了文章 • 0 个评论 • 3506 次浏览 • 2023-12-01 18:45

INFINI Labs 产品又更新啦~,本次更新主要对 Easysearch、Gateway、Console、Agent 等产品功能进行优化和相关 Bug 修复,解决了内存异常增长等问题,以下是详细说明。

INFINI Easysearch v1.6.2

INFINI Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。

Easysearch 本次更新如下:

Bug fix

- 修复跨集群复制(CCR)不能对自动滚动生成的索引进行同步的问题

Improvements

- 优化初始化脚本,增加-s/-slient 参数,自动安装。

- 新增含 jdk/plugins 的 bundle 安装包

INFINI Gateway v1.20.0

INFINI Gateway 是一个面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway 可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。

Gateway 本次更新如下:

Bug fix

- 修复由 Framework Bug 造成连接数不释放、内存异常增长的问题

Improvements

- 增加配置,允许设置 fasthttp client 相关参数

INFINI Console v1.12.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

Console 本次更新如下:

Bug fix

- 修复数据探索 multi fields 字段计算 top values 报错的问题

- 修复由 Framework Bug 造成连接数不释放、内存异常增长的问题

- 修复内网模式下静态资源远程加载的问题

- 修复数据看板数据源配置校验异常的问题

Improvements

- 优化数据探索计算 top values,使用先采样后,后取 top values

- 可通过配置参数 http_client.read_buffer_size 设置读取缓存大小,解决开发工具执行命令时,默认缓存太小的问题

INFINI Agent v0.7.1

INFINI Agent 是 INFINI Console 的一个可选探针组件,负责采集和上传集群指标和日志等信息,并可通过 Console 管理。Agent 支持主流操作系统和平台,安装包轻量且无任何外部依赖,可以快速方便地安装。

Agent 本次更新如下:

Features

- 添加 http processor

Bug fix

- 修复由 Framework Bug 造成连接数不释放、内存异常增长的问题

Improvements

- 进一步优化内存占用,降到 50M 以下

INFINI Framework

INFINI Framework 是 INFINI Labs 各产品依赖的内部核心公共代码库。

Framework 本次更新如下:

- fix: fix the issue of disk queue was blocked

- chore: checkout specify branch before pull

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

欢迎加入 Discord 聊天室:https://discord.gg/4tKTMkkvVX

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群一起讨论交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

INFINI Labs 产品更新 | Agent 全新重构,优化指标采集,支持集中配置管理,支持动态下发等功能

资讯动态 • liaosy 发表了文章 • 0 个评论 • 3990 次浏览 • 2023-11-03 15:32

INFINI Labs 产品又更新啦~

本次更新主要有 Agent、Console、Loadgen 等产品,其中 Agent 进行全新重构升级,新版限制了 CPU 资源消耗,优化了内存,相比旧版内存使用率降低 10 倍,极大的降低了对宿主服务器资源占用的压力。同时 Agent 还优化了指标采集,支持集中配置管理,支持动态下发,支持一键安装和自动注册到 Console,可通过 Console 集中管理,并进行关联集群和节点。

以下是本次更新的详细说明。

INFINI Agent v0.7.0

INFINI Agent 是 INFINI Console 的一个可选探针组件,负责采集和上传集群指标和日志等信息,并可通过 Console 管理。Agent 支持主流操作系统和平台,安装包轻量且无任何外部依赖,可以快速方便地安装。

探针 Agent 本次更新如下:

Features

- 限制探针资源消耗,限制 CPU 的使用

- 优化探针内存使用,10 倍降低

- 支持集中配置管理,支持动态下发

- 支持探针一键安装和自动注册

- 优化节点指标采集,仅采集本节点指标

Improvements

- 重构节点统计信息

- 删除未使用的文件

- 添加发现未知节点的 API

- 重构节点发现

- 重构新的 API

INFINI Console v1.10.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

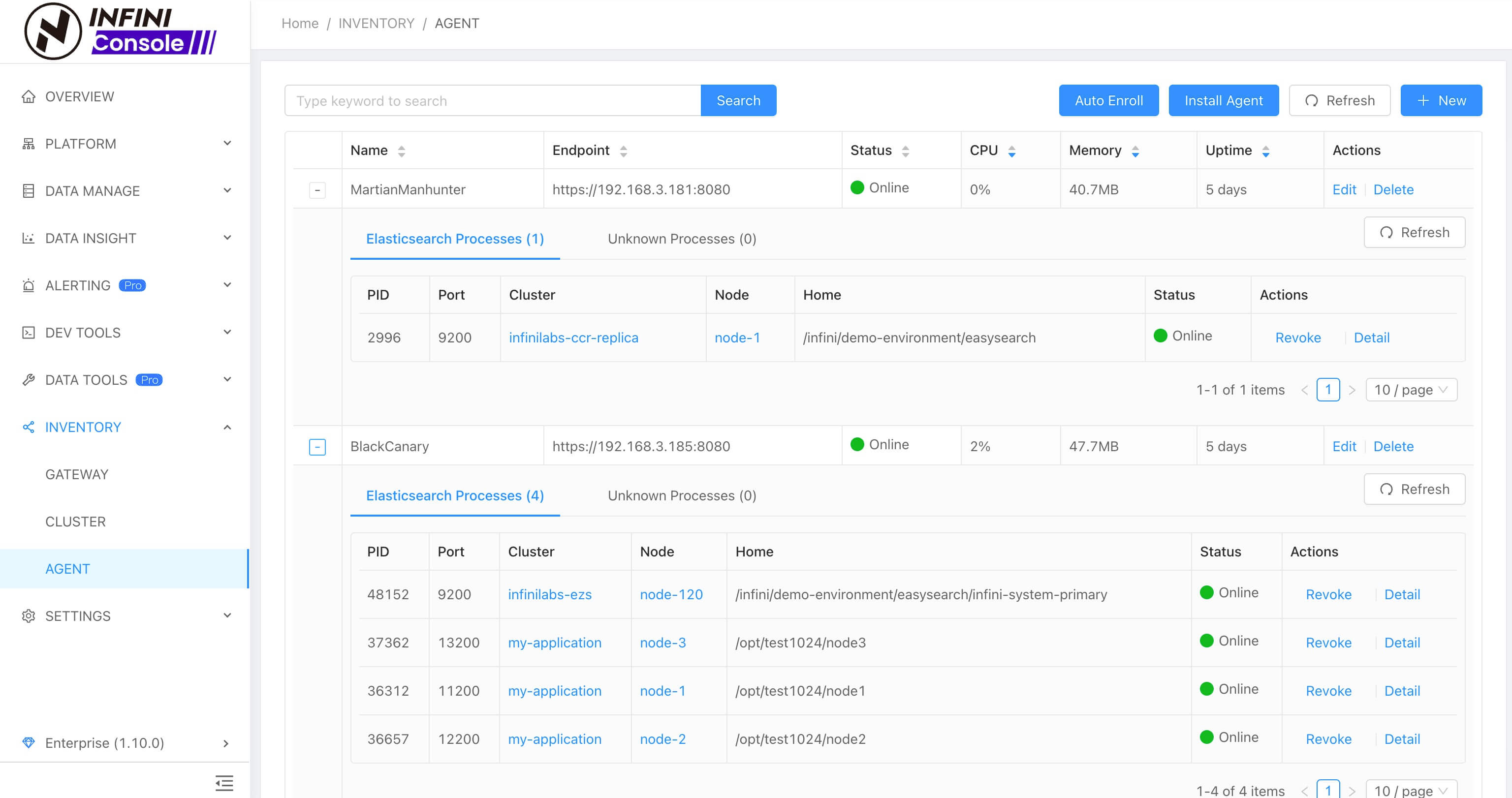

探针管理

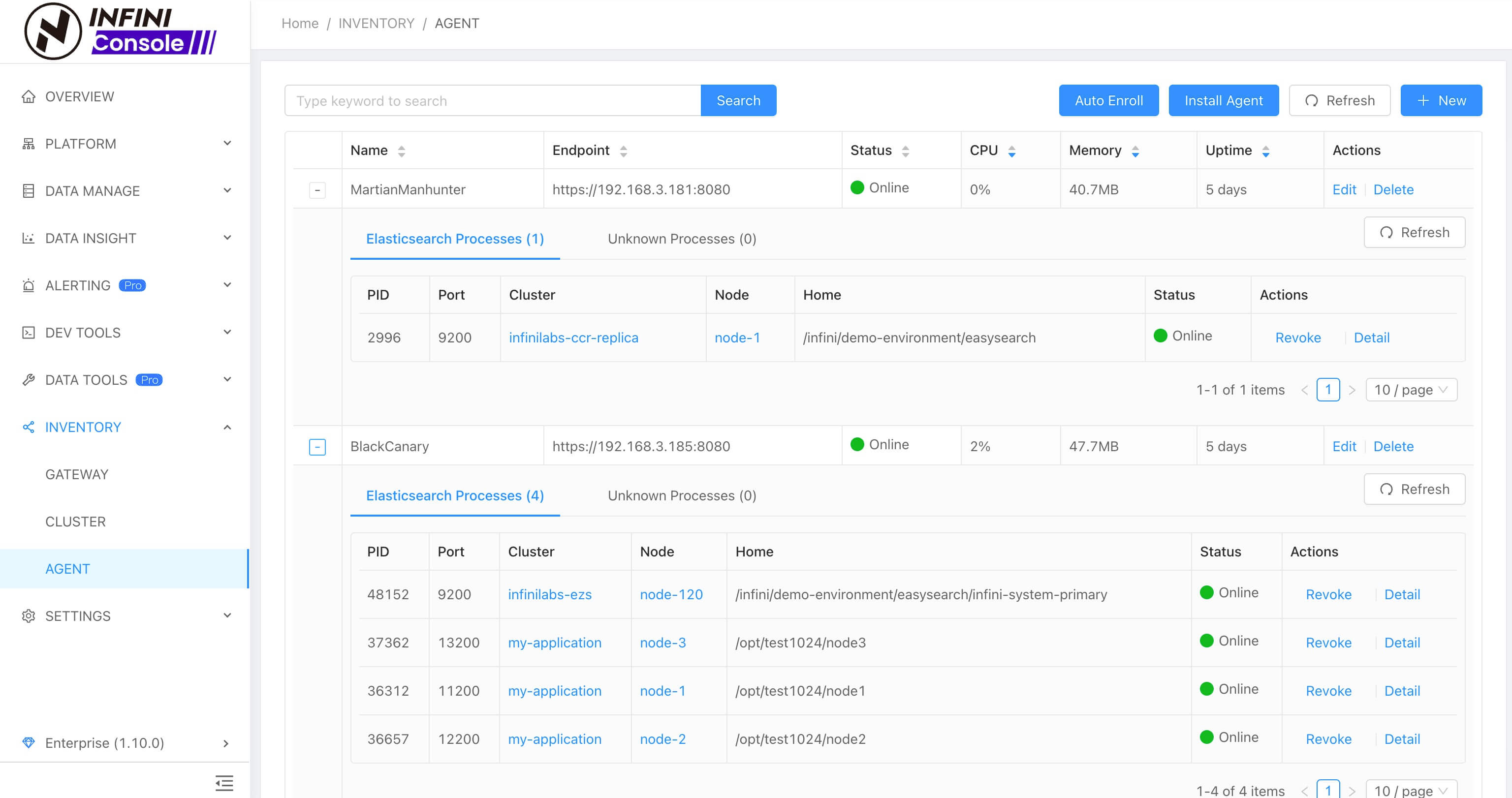

新版 Agent 安装好之后可在 Console 探针管理界面集中纳管,支持发现 ES 进程 和 疑似 ES 进程,并支持手动和自动批量关联到集群。如下图所示:

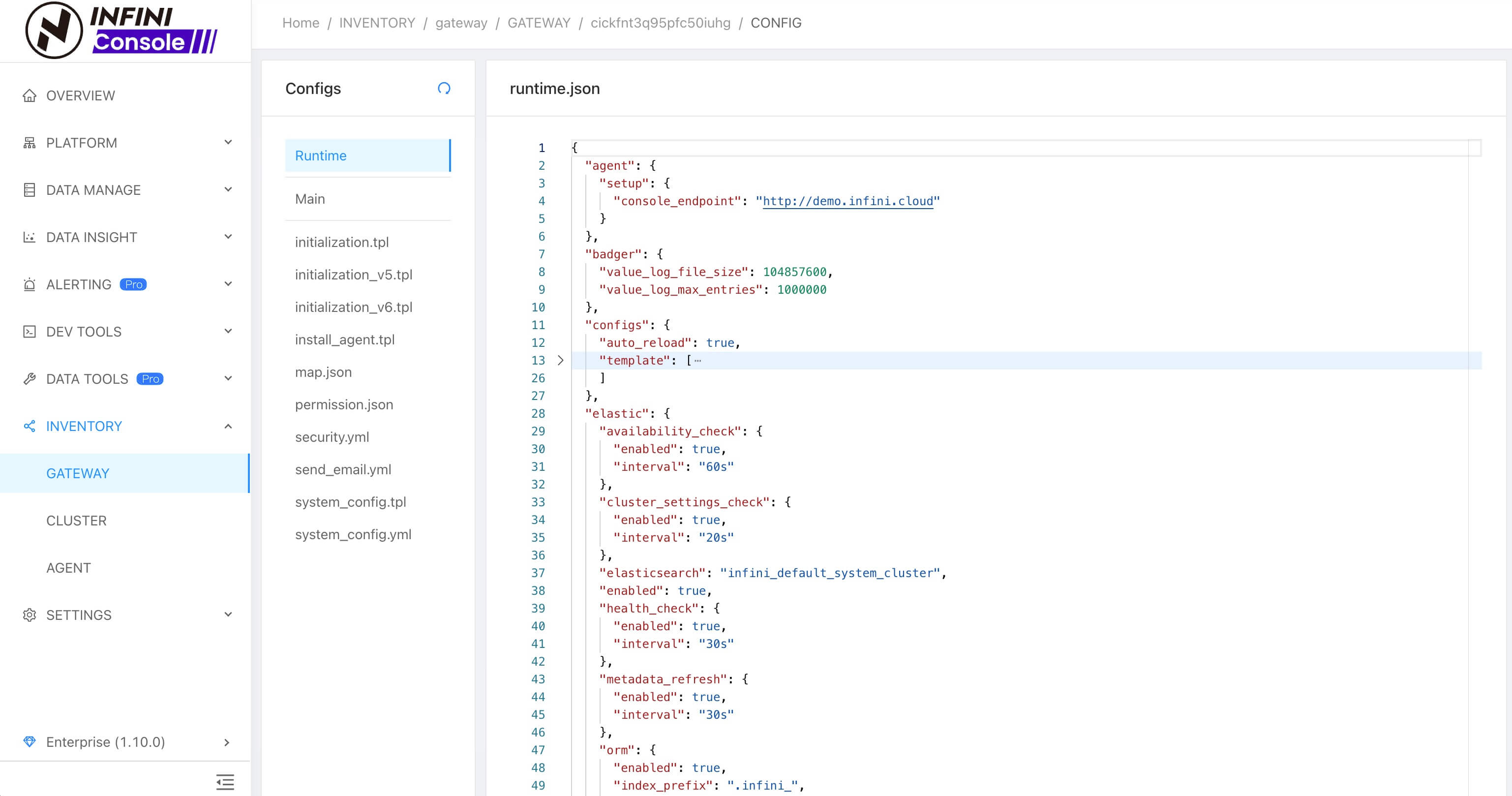

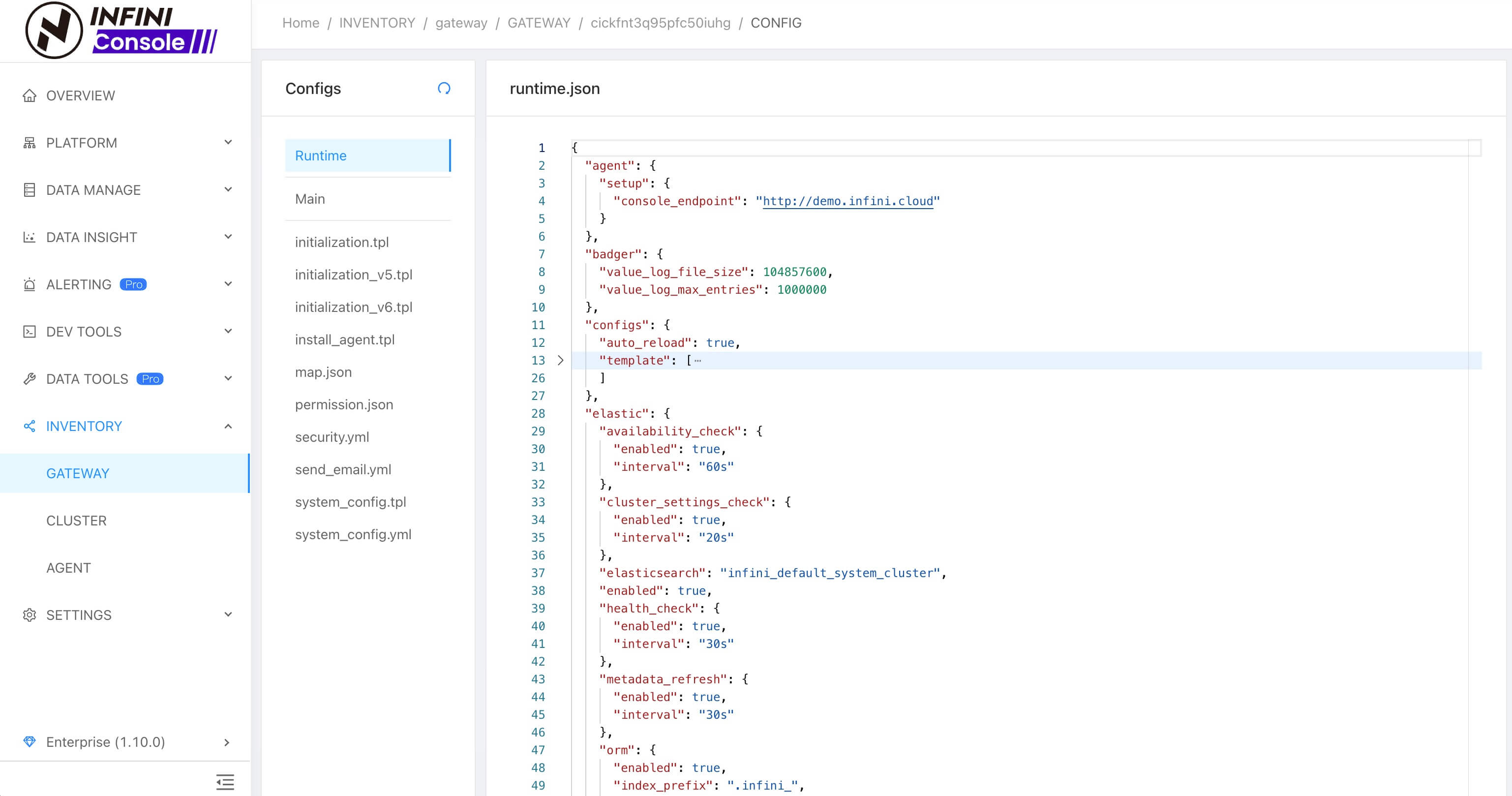

实例动态配置

Console 网关实例模块新增配置管理功能,支持实例配置内容查看和修改,修改后的配置支持自动加载生效,无需再去手动重启实例。如下图所示:

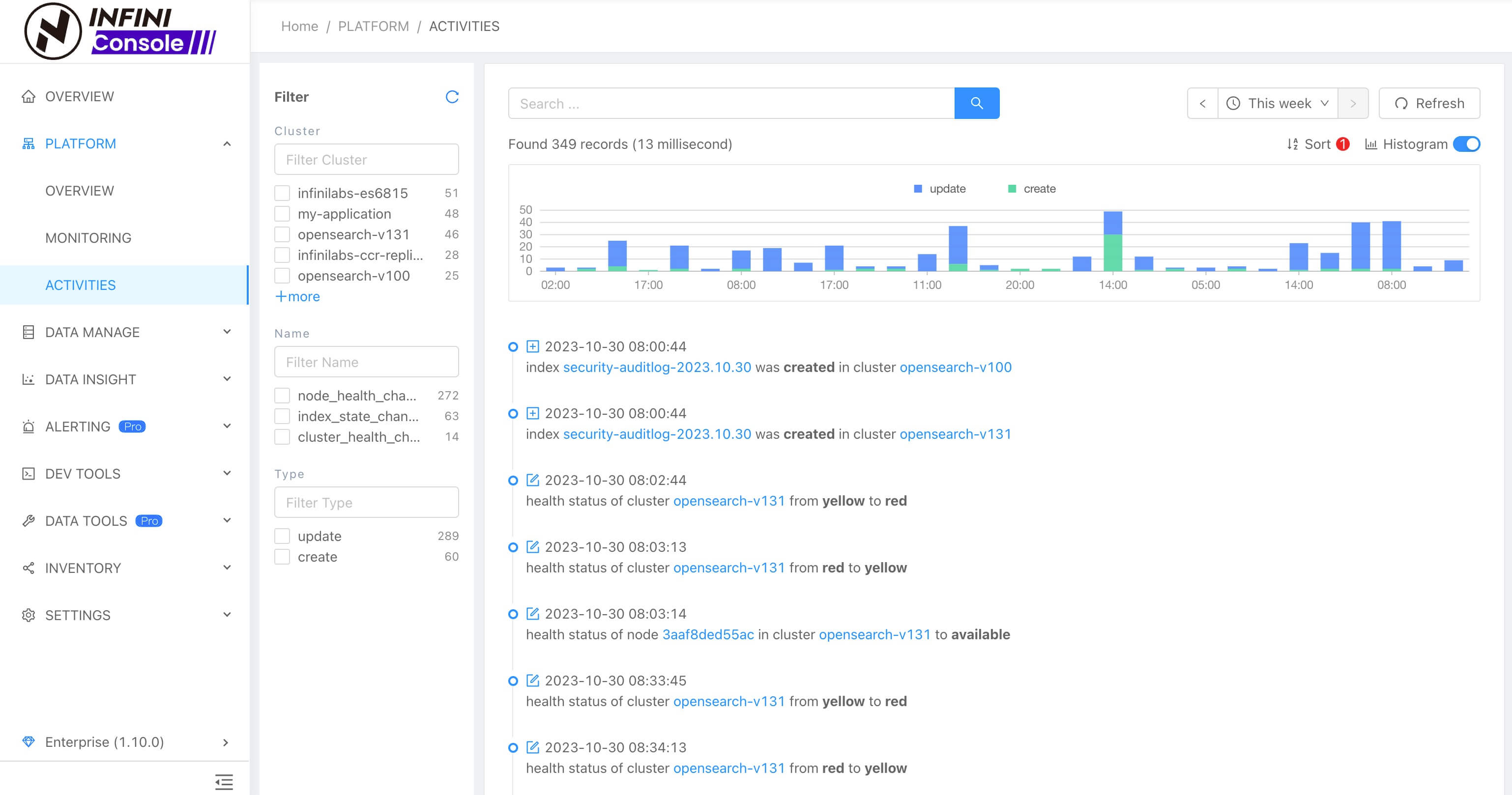

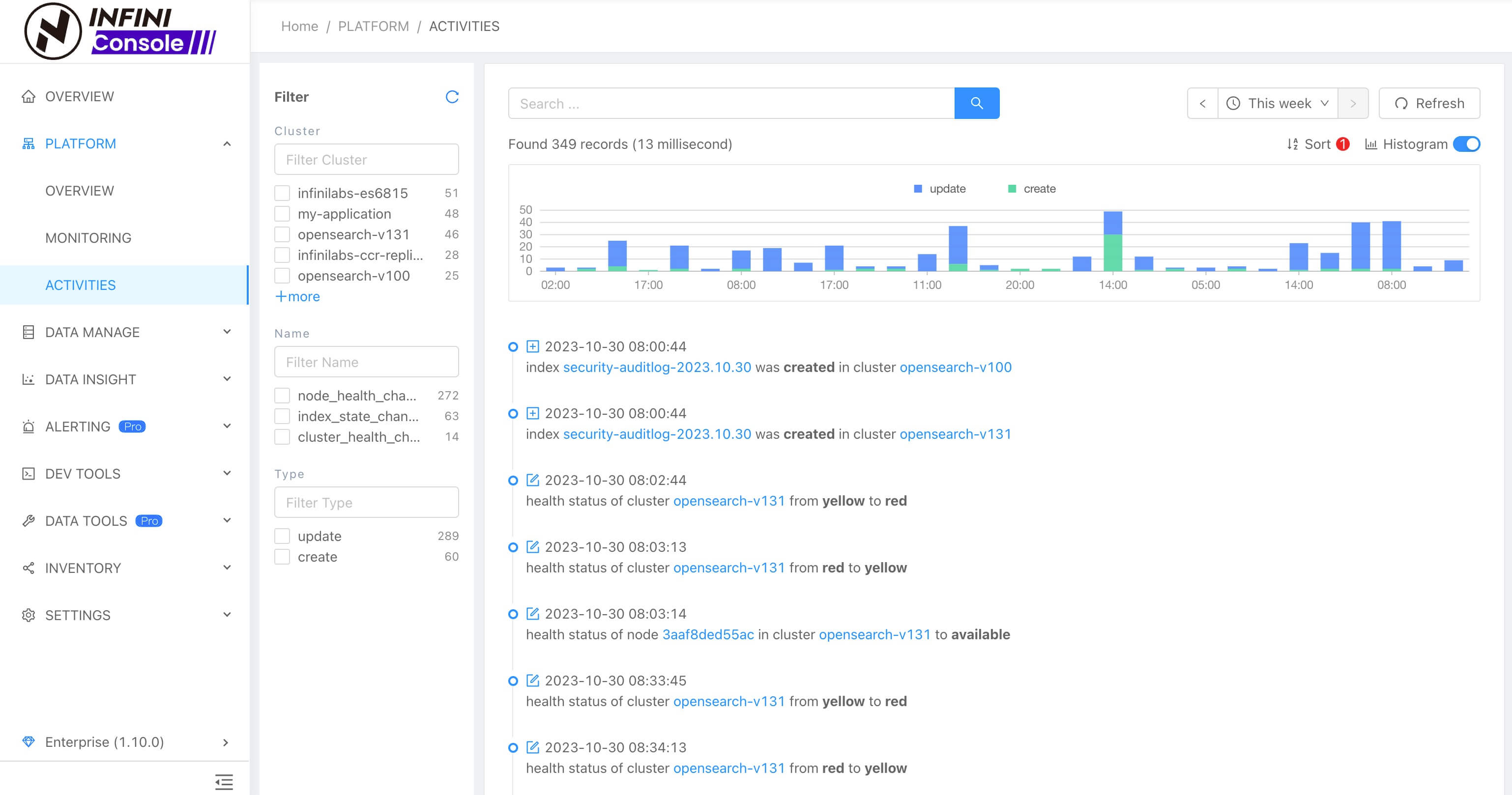

集群动态

集群动态界面进行了优化,新增了筛选过滤、时序图等。如下图所示:

Console 本次更新详细清单如下:

Features

- 重构探针注册流程

- 合并精简冗余接口

- 支持实例的配置查看和动态修改

- 允许准入和移除探针

- 监控新增分片级别指标

- 节点级别添加线程池相关指标

Bug fix

- 修复数据迁移/校验任务列表状态显示异常的问题

- 修复数据探索索引选择列表数据不完整的问题

- 修复开发工具集群列表找不到集群的问题

- 修复监控告警详情点击后查询的数据未包含告警时间点产生的数据问题

Improvements

- 优化数据迁移/校验任务剩余时间显示

- 数据探索查询数据支持自定超时时间

- 数据探索字段 TOP5 统计的总数调整为当前时间范围内的文档数

- 监控指标支持自定义时间桶的大小

- 数据检验任务添加导出文档数提示信息

- 优化集群,网关注册输入框,自动去除两边空格

- 完善探针探测未知 ES 节点的流程

- 优化探针安装脚本,新增远程配置服务器参数

- 优化集群动态界面,新增筛选过滤、时序图等

- 优化集群管理界面,新增筛选过滤

INFINI Loadgen v1.8.0

INFINI Loadgen 是一款支持 Easysearch、Elasticsearch 等搜索引擎压测工具,其特点轻量级无依赖、性能强劲、支持高并发、支持模板化参数随机、支持压测端均衡流量控制等。

Loadgen 本次更新如下:

Breaking changes

- 原 Loadrun 功能并入 Loadgen

- 测试请求、断言等使用新的 Loadgen DSL 语法来配置

下载地址:https://release.infinilabs.com/loadgen

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

欢迎加入 Discord 聊天室:https://discord.com/invite/4tKTMkkvVX

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群一起讨论交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

INFINI Labs 产品更新 | Easysearch 新增分词插件、Gateway 支持邮件发送等功能

资讯动态 • liaosy 发表了文章 • 0 个评论 • 2976 次浏览 • 2023-07-21 17:28

INFINI Labs 产品又更新啦~,本次更新概要如下:Easysearch 新增了分词插件、优化了生命周期管理功能等;Gateway 新增 smtp 过滤器来支持邮件的发送,支持自动跳过因为异常关闭而损坏的磁盘队列文件等;Console 新增熔断器监控指标、新增矩形树图(Treemap)、优化了探针 Agent 指标采集和集群自动关联操作等。欢迎大家下载体验。

INFINI Easysearch v1.4.0

INFINI Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 衍生自基于开源协议 Apache 2.0 的 Elasticsearch 7.10 版本。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。

Easysearch 本次更新如下:

Features

- 索引生命周期管理增加 wait_for_snapshot 操作,在删除索引之前,等待执行指定的快照管理策略,这样可以确保已删除索引的快照可用

- 增加 analysis-hanlp 分词插件

- 增加 jieba 分词插件

Bug fix

- 修复启用 index.source_reuse 时,对复杂多层 json 的 source 字段 解析不正确的 Bug

Improvements

- 更新索引生命周期管理 api 文档,增加策略应用和更新说明,增加 wait_for_snapshot 说明

- 执行

initialize.sh命令时增加初始化确认提示,是否将 admin 密码记录日志

INFINI Gateway v1.17.0

INFINI Gateway 是一个面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway 可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。

Gateway 本次更新如下:

Features

- 新增 consumer Processor 来标准化订阅消息队列

- 新增 smtp 过滤器来支持邮件的发送

Bug fix

- 支持自动跳过因为异常关闭而损坏的磁盘队列文件

INFINI Console v1.4.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

Console 本次更新如下:

Features

- 新增熔断器监控指标

- 网关队列管理支持多选删除消费者

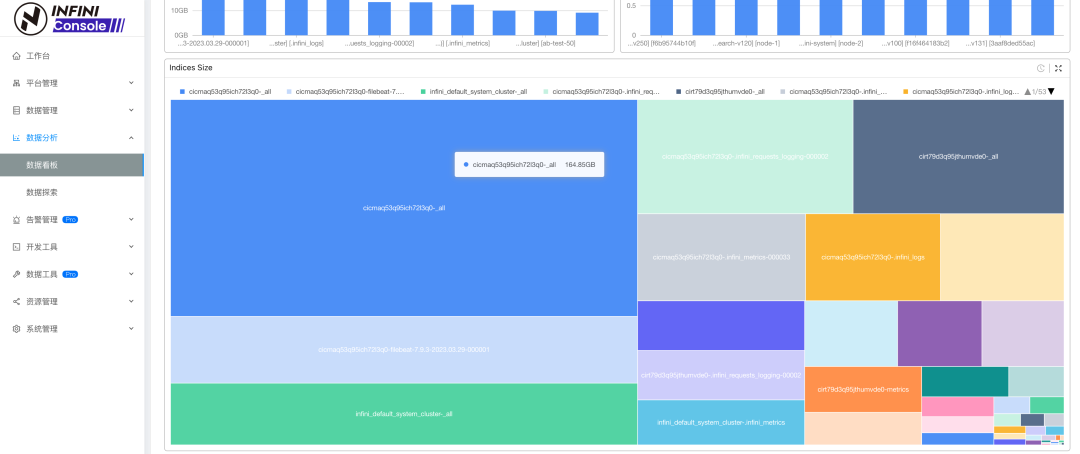

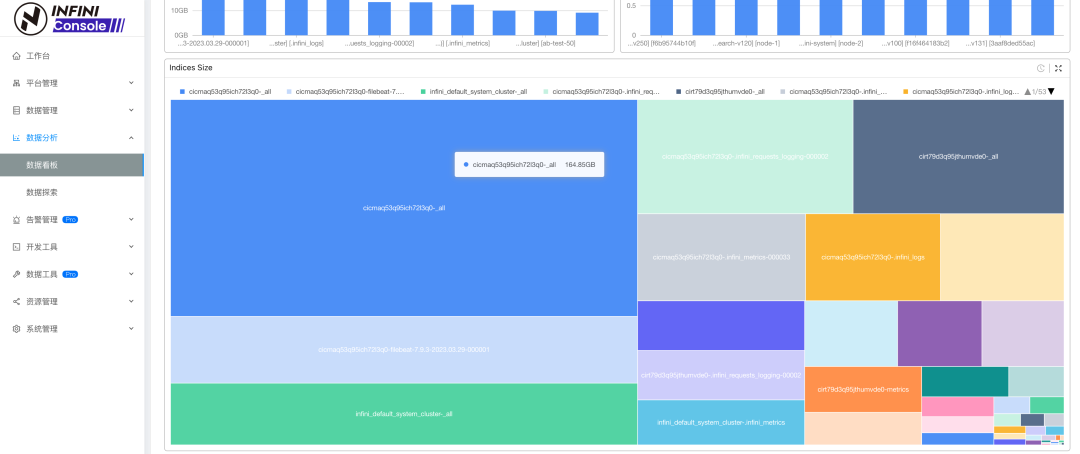

- 数据看板新增组件矩形树图

Bug fix

- 修复开发工具智能提示兼容性问题

- 修复探针列表状态显示异常的问题

- 修复探针列表分页不生效的问题

- 修复数据看板 统计函数显示不对的问题

- 修复探针下发采集指标配置重复的问题

- 修复数据看板设置过滤条件不生效的问题

- 修复主机列表探针状态不对的问题

- 修复网关管理删除队列不成功的问题

- 修复数据探索当前集群没索引时跳转的问题

- 修复数据看板编辑状态下点击事件的问题

Improvements

- 探针进程关联支持通过选择集群自动关联,简化操作

- 探针列表支持排序

- 探针支持向上滚动查看节点日志

- 采集监控指标添加 cluster_uuid 信息

- 数据看板支持配置指标排序

INFINI Agent v0.6.0

INFINI Agent 是 INFINI Console 的一个可选探针组件,负责采集和上传集群指标和日志等信息,并可通过 Console 管理。Agent 支持主流操作系统和平台,安装包轻量且无任何外部依赖,可以快速方便地安装。

Agent 本次更新如下:

Features

- 采集监控指标添加 cluster_uuid 信息

Improvements

- 修复发现节点进程信息时获取不到最新集群配置的问题

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

或者通过 Discord 渠道加入聊天室:https://discord.com/invite/tnZ8S5vQ

欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

INFINI Labs 产品更新 | 重磅推出 Easysearch 一个分布式的近实时搜索与分析引擎

资讯动态 • liaosy 发表了文章 • 0 个评论 • 5456 次浏览 • 2023-05-16 11:57

INFINI Labs 产品又更新啦,包括 Easysearch v1.1.0、Gateway v1.13.0、Console v1.1.0、Agent v0.4.0,其中 Easysearch 经过团队的数月打磨,现正式对外推出。Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 衍生自基于开源协议 Apache 2.0 的 Elasticsearch 7.10.2 版本。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。与 Elasticsearch 相比,Easysearch 更关注在搜索业务场景的优化和继续保持其产品的简洁与易用性。欢迎大家下载体验。

INFINI Easysearch v1.1.0

INFINI Easysearch 本次更新最重要的功能是引入了 ZSTD 压缩算法,对索引进行全方位的压缩,尤其针对日志数据压缩效果更加明显,针对 1.1G 的 Nginx 日志进行测试,采用 ZSTD 策略后,膨胀率只有 0.94,甚至比原始数据还要小,而且还能进一步压缩,和 index.source_reuse 结合使用后,膨胀率只有 0.7,索引大小只有 Elasticsearch 原生 best_compression 的 59%,是 Elasticsearch 6.x 的 49%。下面是一张索引大小对比图:

更多介绍查看 详情。

其他更新功能如下:

Breaking changes

- Lucene 版本升级到 8.11.2

Breaking changes

- 增加 ZSTD codec, 引入 ZSTD 压缩算法,对存储字段,doc_values,词典进行压缩。

- 增加 index.source_reuse 索引级别配置,对 _source 进一步压缩。

- 提供索引生命周期管理 ILM 模块的功能,绝大部分 api 兼容 elasticsearch

Breaking changes

- 减少冗余日志输出。

- 减少 modules 模块整体大小。

下载地址:https://www.infinilabs.com/download

INFINI Gateway v1.13.0

极限网关本次更新如下:

Features

router.rules增加 enabled 选项,控制是否启用 flow- 增加对 loong64 架构的支持

- 增加对 riscv64 架构的支持

- elasticsearch filter 增加 dial_timeout 选项

Bug fix

- 修复 http/elasticsearch 转发后 HTTP 响应头丢失的问题

- 修复 pipeline 热加载出现重复 pipeline 同时运行的问题

- 修复 bulk_indexing 退出后泄漏 goroutine 的问题

Improvements

- 优化 HTTP 头设置方式,避免出现重复的 HTTP 头

- 优化 pipeline 停止的响应速度

- pipeline 增加 enabled 选项,控制是否启用 pipeline

更多 Gateway 更新可参考【Gateway 版本历史】。

INFINI Console v1.1.0

本次 INFINI Console 版本发布主要新增了网关实时日志查看功能、完善了数据迁移功能和数据看板的可视化能力、以及修复了已知 Bug。

实时日志

登录 Console,进入 [资源管理][网关管理] 界面,可以看到网关实时日志入口(前提需要注册网关)如下图所示:

进入实时日志展示界面,点击“开始”按钮后,服务端将 Gateway 日志实时推送到 Console 界面展示,在该界面可以动态调整输出不同的日志级别(DEBUG、INFO、WARN、ERROR 等),同时也支持文件名、方法名、消息内容加通配符进行过滤。

数据迁移

数据迁移模块,基于上个版本做了优化,添加 ILM,Template,Alias 初始化操作。方便用户根据各自的需求迁移索引生命周期、模板、别名等。

数据看板

数据看板图表支持复制、快速切换、时间框选、缩放、标记高亮,进一步增强 Console 可视化能力。

详情查看 操作演示视频。

除以上主要功能更新外,Console 其他功能优化如下:

Bug fix

- 修复数据探索保存查询出现 mapping 错误的问题

- 修复数据看板组件数据源配置的问题

- 修复数据探索左侧字段栏样式的问题

- 修复集群注册向导点击跳转后丢失集群类型的问题

Improvements

- 数据看板汉化

更多 Console 更新可参考【Console 版本历史】。

INFINI Agent v0.4.0

数据采集工具探针(INFINI Agent)更新如下:

Features

- 新增 logs_processor ,配置采集本地日志文件

Breaking changes

- es_logs_processor 调整日志字段

- created 重命名为 timestamp

- 自动提取 payload.timestamp payload.@timestmap 字段到 timestamp

- es_logs_processor 删除 enable 选项

下载地址: https://www.infinilabs.com/download/?product=agent

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

详情参见官网:https://www.infinilabs.com

INFINI 产品更新啦 20220923

资讯动态 • liaosy 发表了文章 • 0 个评论 • 3236 次浏览 • 2022-09-23 22:47

今天 INFINI Labs 为大家又带来了一波产品更新,请查阅。

INFINI Gateway v1.8.0

极限网关本次迭代更新如下:

- 修复上下文条件 consumer_has_lag参数和 配置、文档不一致的 Bug。

- 修改备集群故障,主集群不能正常写数据的 Bug。

- 修复 Bulk 请求处理异常造成数据复制不一致的问题。

- 修复请求日志里面关于 Bulk 统计数据丢失的问题。

- 修复大并发情况下,请求体为空的异常。

INFINI Console v0.6.0

口碑爆棚的 Elasticsearch 多集群管控平台 INFINI Console 更新如下:

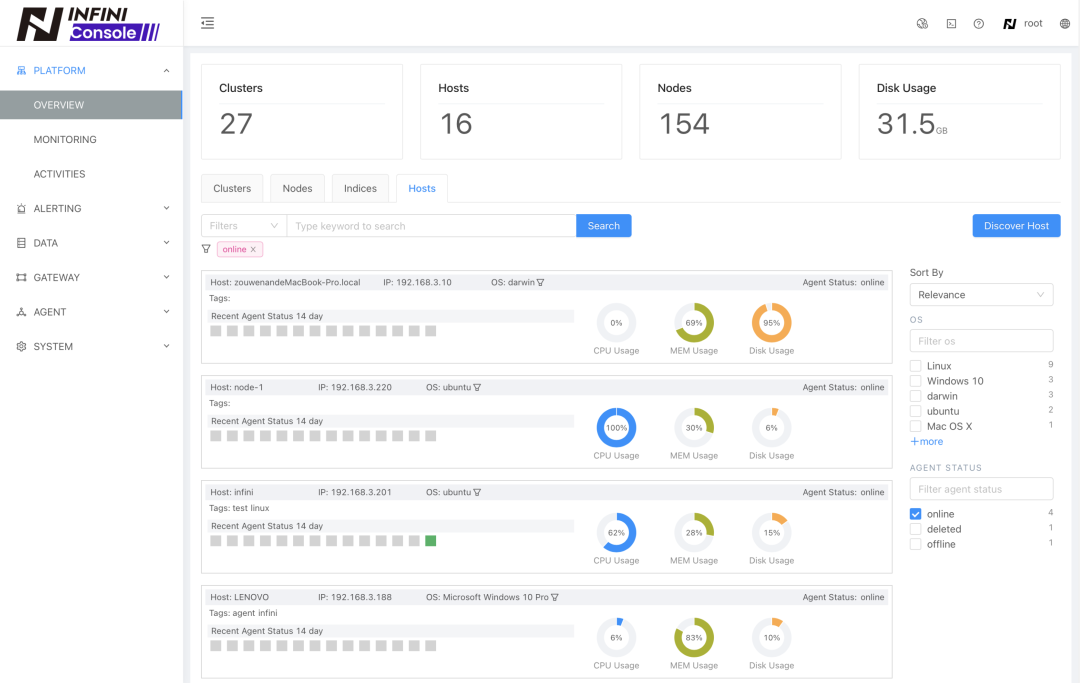

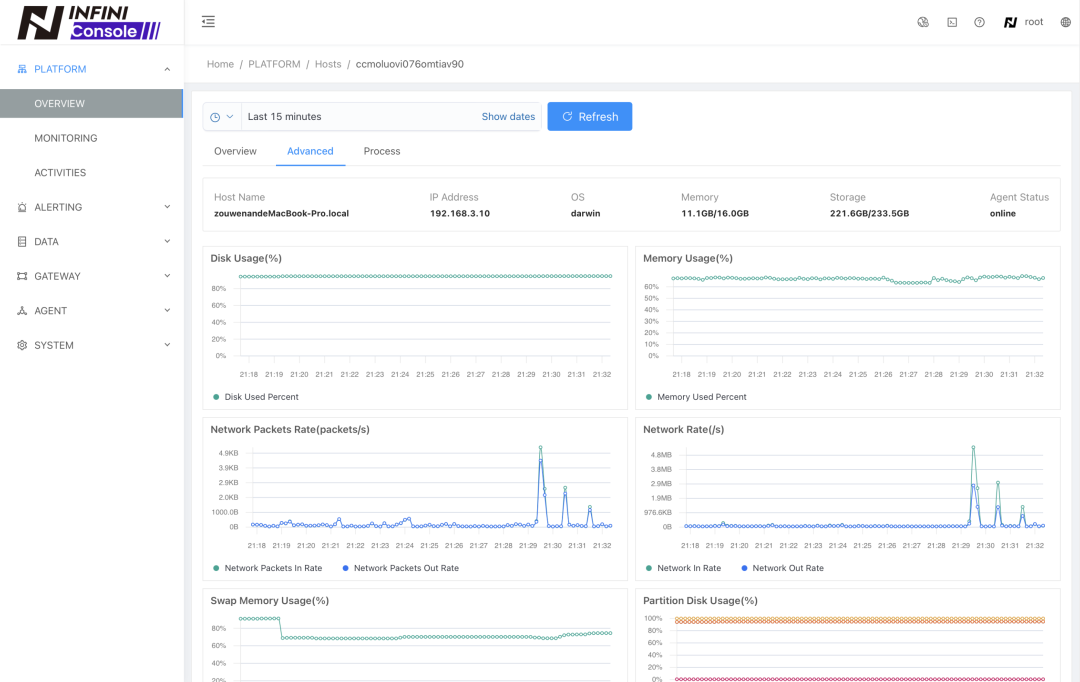

- 新增主机概览。

- 新增主机监控。

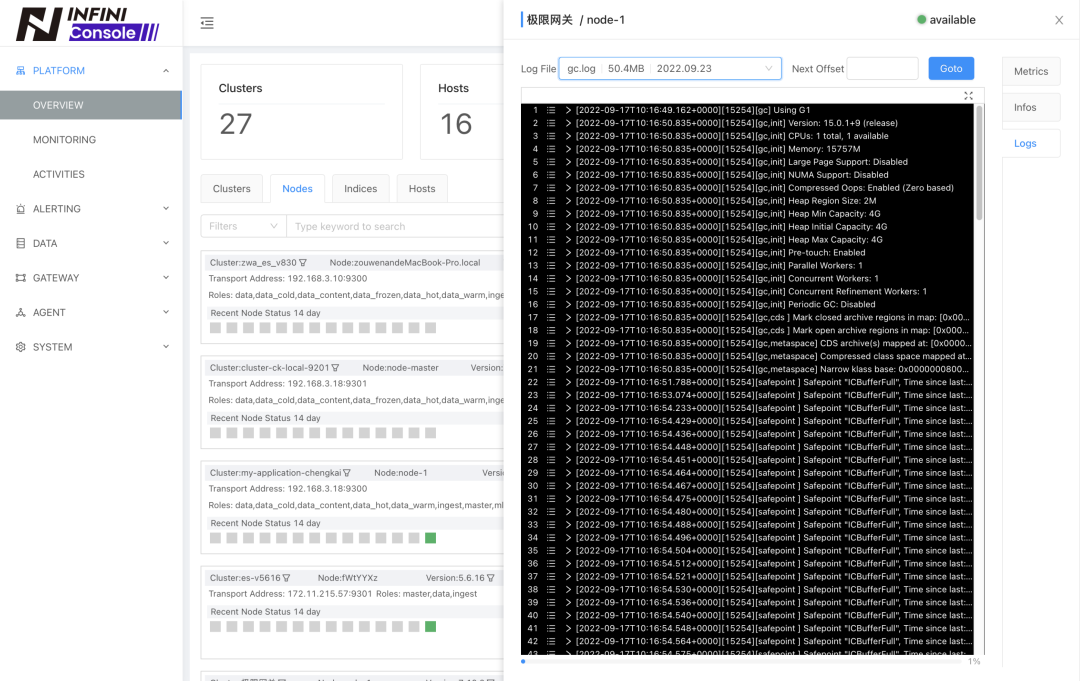

- 节点概览新增日志查看功能(需安装 Agent)。

- Insight 配置框新增 Search 配置。

- 优化 Discover 时间范围 Auto Fit,设为15分钟。

- 优化 Discover 保存搜索,会保存当前的字段过滤和 Insight 图表配置。

- 优化本地列表搜索查找,支持通配符过滤。

- 优化告警规则必填字段标记显示。

- 修复了 Discover 字段过滤白屏问题。

- 修复了 Discover 表格添加字段后排序失效问题。(感谢@卢宝贤反馈)

- 修复了 Elasticsearch 8.x 删除文档报错不兼容的问题。(感谢@卢宝贤反馈)

- 修复了创建新索引不成功时,异常处理的问题。

- 修复了低版本浏览器js不兼容导致集群注册不成功的问题。

- 修复了开发工具中使用加载命令失败报错的问题。

INFINI Agent v0.2.0

数据采集工具探针(INFINI Agent)更新如下:

- 新增按节点读日志文件列表的API

- 新增读具体日志文件内容的API

- 新增 Elasticsearch 节点掉线后的基础信息保存

- 新增主机在线状态的采集

- 新增基于 Centos 的 Docker 镜像

- 新增主机配置信息采集: 操作系统信息、磁盘大小、内存大小、CPU配置等

- 新增主机指标的采集: CPU使用率、磁盘使用率、磁盘IO、内存使用率、swap 使用率、网络IO等

- 新增 Elasticsearch 进程信息采集

- 修复发现 Elasticsearch 进程时频繁提示端口访问错误的Bug

- 修复 Elasticsearch 节点地址为 0.0.0.0 时无法获取节点信息的Bug

- 修复 CPU 指标数据显示异常的Bug

- 修复 stats API 在 Windows 平台的兼容性

INFINI Framework 2000923

INFINI Framework 也带来了很多改进:

- 重构了磁盘队列压缩相关配置,支持段文件的压缩。

- 当集群不可用的情况下,跳过集群节点元数据的获取。

- 完善节点可用性检测,避免频繁的不可用状态切换。

- 修复 Elasticsearch 主机地址为空的异常。

- 完善本地磁盘队列文件的清理,避免删除正在使用的文件。

期待反馈

如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs)中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/#/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手,加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

感谢大家的围观,祝大家周末愉快。

day16 logstash-forwader To Kakfa!

Advent • childe 发表了文章 • 1 个评论 • 6083 次浏览 • 2015-12-18 16:37

{

"files": [

{

"paths": [

"/var/log/nginx/*.log"

],

"Fields":{

"type":"nginx"

},

"DeadTime": "30m"

},

{

"paths": [

"/var/log/tomcat/*.log",

"/var/log/tomcat/*/*.log"

],

"Fields":{

"type":"tomcat"

},

"DeadTime": "30m"

}

],

"kafka": {

"broker_list": ["10.0.0.1:9092","10.0.0.2:9092"],

"topic_id": "topic_name_change_it_{{.type}}",

"compression_codec": "gzip"

}

}- DeadTime:30m 是说超过30分钟没有更新, 就不会再继续跟踪这个文件了(退出goroutine)

- “Fields”:{ “type”:”tomcat” } , 会在每条日志中增加配置的字段

- path目前就是用的golang官方库, 好像是还不支持递归多层目录查找, 反正我翻了一下文档, 没有找到.

"files": [

{

"paths": [

"d:\\target.txt"

],

"FieldNames": ["datetime", "datetime", "s_ip", "cs_method", "cs_uri_stem", "cs_uri_query", "s_port", "time_taken"],

"Delimiter": "\\s+",

"QuoteChar": "\""

}

]【搜索客社区日报】第2138期 (2025-11-03)

社区日报 • Muses 发表了文章 • 0 个评论 • 8215 次浏览 • 2025-11-03 20:22

【搜索客社区日报】第2134期 (2025-10-27)

社区日报 • Muses 发表了文章 • 0 个评论 • 8267 次浏览 • 2025-10-27 17:18

【搜索客社区日报】第2123期 (2025-09-29)

社区日报 • Muses 发表了文章 • 0 个评论 • 10173 次浏览 • 2025-09-29 15:18

【搜索客社区日报】第2119期 (2025-09-22)

社区日报 • Muses 发表了文章 • 0 个评论 • 12158 次浏览 • 2025-09-22 13:44

【搜索客社区日报】第2110期 (2025-09-08)

社区日报 • Muses 发表了文章 • 0 个评论 • 4847 次浏览 • 2025-09-08 16:03

【搜索客社区日报】第2105期 (2025-09-01)

社区日报 • Muses 发表了文章 • 0 个评论 • 5409 次浏览 • 2025-09-01 12:17

INFINI Labs 产品更新 | Console/Gateway/Agent 等产品开源发布首个版本

资讯动态 • INFINI Labs 小助手 发表了文章 • 1 个评论 • 4154 次浏览 • 2024-12-27 16:11

INFINI Labs 产品又更新啦~,包括 Easysearch v1.9.0、Gateway、Console、Agent、Loadgen v1.27.0。本次各产品更新了很多亮点功能,如 Easysearch 新增 rollup 功能,优化了多版本兼容配置;Console/Gateway/Agent/Loadgen 及 Framework 开源后,发布首个重大更新版本,支持过期元数据删除,指标图表懒加载,指标采集协程优化等等,欢迎大家下载体验。

INFINI Easysearch v1.9.0

INFINI Easysearch 是一个分布式的搜索型数据库,实现非结构化数据检索、全文检索、向量检索、地理位置信息查询、组合索引查询、多语种支持、聚合分析等。Easysearch 可以完美替代 Elasticsearch,同时添加和完善多项企业级功能。Easysearch 助您拥有简洁、高效、易用的搜索体验。详情见:https://infinilabs.cn

Easysearch 本次更新如下:

Improvements

-

发布 rollup 功能

- 支持自动对 rollup 索引进行滚动,无需外部触发

- 支持 avg sum max min value_count percentiles 指标类型的聚合

- 支持 terms 聚合

- 支持对指标聚合进行 Pipeline 聚合

- 支持聚合前先对数据进行过滤

- 进行聚合查询时支持直接搜索原始索引,不用更改搜索代码

- 增加适配 logstash 8.x 的请求 header

- _cat/templates 增加 lifecycle 和 rollover 列的展示

Bug fix

- 修复 rest-api template 测试错误

INFINI Console v1.27.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。开源地址:https://github.com/infinilabs/console

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

Console 本次更新如下:

Improvements

- 代码开源,统一采用 Github 仓库进行开发

- 指标采集优化,由原来的单一协程采集调整为每个注册的集群有单独的协程进行采集

- 指标监控页面图表展示采用懒加载、单个图表独立加载,增强用户体验

- 通用时间控件增加超时时间设置

- 集群选择控件增加注册、刷新功能

- 提供指标采集状态

- 表格控件排版优化

Bug fix

- 修复集群元数据更新不及时问题

- 修复帮助文档等链接不正确问题

- 修复节点、索引数据因随机 id 出现重复记录问题

- 修复 Runtime、Agent 实例编辑页面出错问题

- 修复集群、节点、索引、分片元数据无 Loading 问题

- 修复索引健康状态指标采集失败问题

- 修复个别菜单列未国际化问题

INFINI Gateway v1.27.0

INFINI Gateway 是一个面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway 可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。开源地址:https://github.com/infinilabs/gateway

Gateway 本次更新如下:

Improvements

- 调整队列消费者 slice 默认配置为 1

Bug fix

- 修复缓存数据丢失导致队列无法消费问题

- 同步更新 Framework 修复的一些已知问题

INFINI Agent v1.27.0

INFINI Agent 是 INFINI Console 的一个可选探针组件,负责采集和上传集群指标和日志等信息,并可通过 Console 管理。Agent 支持主流操作系统和平台,安装包轻量且无任何外部依赖,可以快速方便地安装。开源地址:https://github.com/infinilabs/agent

探针 Agent 本次更新如下:

Improvements

- 与 INFINI Console 统一版本号

- 同步更新 Framework 修复的已知问题

- 支持 K8S 环境指标采集

INFINI Loadgen v1.27.0

INFINI Loadgen 是一款轻量、无依赖的 Eaysearch/Elasticsearch/OpenSearch 性能压测工具,支持参数模板化配置,支持压测端均衡流量控制,可以模拟高并发请求。开源地址:https://github.com/infinilabs/loadgen

Loadgen 本次更新如下:

Improvements

- 保持与 Console 相同版本

- 同步更新 Framework 修复的已知问题

Bug fix

- 修复 API 接口测试逻辑异常问题

INFINI Framework

INFINI Framework 是 INFINI Labs 各产品依赖的核心公共代码库。开源地址:https://github.com/infinilabs/framework

Improvements

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

下载地址: https://infinilabs.cn/download

邮件:hello@infini.ltd

电话:(+86) 400-139-9200

Discord:https://discord.gg/4tKTMkkvVX

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群一起讨论交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

【搜索客社区日报】第1843期 (2024-06-21)

社区日报 • Fred2000 发表了文章 • 0 个评论 • 2903 次浏览 • 2024-06-22 23:57

【搜索客社区日报】 第1824期 (2024-05-24)

社区日报 • searchkit 发表了文章 • 0 个评论 • 3444 次浏览 • 2024-05-24 13:17

INFINI Labs 产品更新 | 修复 Easysearch 跨集群复制索引同步问题,Gateway 内存异常增长等问题

Easysearch • liaosy 发表了文章 • 0 个评论 • 3506 次浏览 • 2023-12-01 18:45

INFINI Labs 产品又更新啦~,本次更新主要对 Easysearch、Gateway、Console、Agent 等产品功能进行优化和相关 Bug 修复,解决了内存异常增长等问题,以下是详细说明。

INFINI Easysearch v1.6.2

INFINI Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。

Easysearch 本次更新如下:

Bug fix

- 修复跨集群复制(CCR)不能对自动滚动生成的索引进行同步的问题

Improvements

- 优化初始化脚本,增加-s/-slient 参数,自动安装。

- 新增含 jdk/plugins 的 bundle 安装包

INFINI Gateway v1.20.0

INFINI Gateway 是一个面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway 可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。

Gateway 本次更新如下:

Bug fix

- 修复由 Framework Bug 造成连接数不释放、内存异常增长的问题

Improvements

- 增加配置,允许设置 fasthttp client 相关参数

INFINI Console v1.12.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

Console 本次更新如下:

Bug fix

- 修复数据探索 multi fields 字段计算 top values 报错的问题

- 修复由 Framework Bug 造成连接数不释放、内存异常增长的问题

- 修复内网模式下静态资源远程加载的问题

- 修复数据看板数据源配置校验异常的问题

Improvements

- 优化数据探索计算 top values,使用先采样后,后取 top values

- 可通过配置参数 http_client.read_buffer_size 设置读取缓存大小,解决开发工具执行命令时,默认缓存太小的问题

INFINI Agent v0.7.1

INFINI Agent 是 INFINI Console 的一个可选探针组件,负责采集和上传集群指标和日志等信息,并可通过 Console 管理。Agent 支持主流操作系统和平台,安装包轻量且无任何外部依赖,可以快速方便地安装。

Agent 本次更新如下:

Features

- 添加 http processor

Bug fix

- 修复由 Framework Bug 造成连接数不释放、内存异常增长的问题

Improvements

- 进一步优化内存占用,降到 50M 以下

INFINI Framework

INFINI Framework 是 INFINI Labs 各产品依赖的内部核心公共代码库。

Framework 本次更新如下:

- fix: fix the issue of disk queue was blocked

- chore: checkout specify branch before pull

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

欢迎加入 Discord 聊天室:https://discord.gg/4tKTMkkvVX

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群一起讨论交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

INFINI Labs 产品更新 | Agent 全新重构,优化指标采集,支持集中配置管理,支持动态下发等功能

资讯动态 • liaosy 发表了文章 • 0 个评论 • 3990 次浏览 • 2023-11-03 15:32

INFINI Labs 产品又更新啦~

本次更新主要有 Agent、Console、Loadgen 等产品,其中 Agent 进行全新重构升级,新版限制了 CPU 资源消耗,优化了内存,相比旧版内存使用率降低 10 倍,极大的降低了对宿主服务器资源占用的压力。同时 Agent 还优化了指标采集,支持集中配置管理,支持动态下发,支持一键安装和自动注册到 Console,可通过 Console 集中管理,并进行关联集群和节点。

以下是本次更新的详细说明。

INFINI Agent v0.7.0

INFINI Agent 是 INFINI Console 的一个可选探针组件,负责采集和上传集群指标和日志等信息,并可通过 Console 管理。Agent 支持主流操作系统和平台,安装包轻量且无任何外部依赖,可以快速方便地安装。

探针 Agent 本次更新如下:

Features

- 限制探针资源消耗,限制 CPU 的使用

- 优化探针内存使用,10 倍降低

- 支持集中配置管理,支持动态下发

- 支持探针一键安装和自动注册

- 优化节点指标采集,仅采集本节点指标

Improvements

- 重构节点统计信息

- 删除未使用的文件

- 添加发现未知节点的 API

- 重构节点发现

- 重构新的 API

INFINI Console v1.10.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

探针管理

新版 Agent 安装好之后可在 Console 探针管理界面集中纳管,支持发现 ES 进程 和 疑似 ES 进程,并支持手动和自动批量关联到集群。如下图所示:

实例动态配置

Console 网关实例模块新增配置管理功能,支持实例配置内容查看和修改,修改后的配置支持自动加载生效,无需再去手动重启实例。如下图所示:

集群动态

集群动态界面进行了优化,新增了筛选过滤、时序图等。如下图所示:

Console 本次更新详细清单如下:

Features

- 重构探针注册流程

- 合并精简冗余接口

- 支持实例的配置查看和动态修改

- 允许准入和移除探针

- 监控新增分片级别指标

- 节点级别添加线程池相关指标

Bug fix

- 修复数据迁移/校验任务列表状态显示异常的问题

- 修复数据探索索引选择列表数据不完整的问题

- 修复开发工具集群列表找不到集群的问题

- 修复监控告警详情点击后查询的数据未包含告警时间点产生的数据问题

Improvements

- 优化数据迁移/校验任务剩余时间显示

- 数据探索查询数据支持自定超时时间

- 数据探索字段 TOP5 统计的总数调整为当前时间范围内的文档数

- 监控指标支持自定义时间桶的大小

- 数据检验任务添加导出文档数提示信息

- 优化集群,网关注册输入框,自动去除两边空格

- 完善探针探测未知 ES 节点的流程

- 优化探针安装脚本,新增远程配置服务器参数

- 优化集群动态界面,新增筛选过滤、时序图等

- 优化集群管理界面,新增筛选过滤

INFINI Loadgen v1.8.0

INFINI Loadgen 是一款支持 Easysearch、Elasticsearch 等搜索引擎压测工具,其特点轻量级无依赖、性能强劲、支持高并发、支持模板化参数随机、支持压测端均衡流量控制等。

Loadgen 本次更新如下:

Breaking changes

- 原 Loadrun 功能并入 Loadgen

- 测试请求、断言等使用新的 Loadgen DSL 语法来配置

下载地址:https://release.infinilabs.com/loadgen

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

欢迎加入 Discord 聊天室:https://discord.com/invite/4tKTMkkvVX

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群一起讨论交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

INFINI Labs 产品更新 | Easysearch 新增分词插件、Gateway 支持邮件发送等功能

资讯动态 • liaosy 发表了文章 • 0 个评论 • 2976 次浏览 • 2023-07-21 17:28

INFINI Labs 产品又更新啦~,本次更新概要如下:Easysearch 新增了分词插件、优化了生命周期管理功能等;Gateway 新增 smtp 过滤器来支持邮件的发送,支持自动跳过因为异常关闭而损坏的磁盘队列文件等;Console 新增熔断器监控指标、新增矩形树图(Treemap)、优化了探针 Agent 指标采集和集群自动关联操作等。欢迎大家下载体验。

INFINI Easysearch v1.4.0

INFINI Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 衍生自基于开源协议 Apache 2.0 的 Elasticsearch 7.10 版本。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。

Easysearch 本次更新如下:

Features

- 索引生命周期管理增加 wait_for_snapshot 操作,在删除索引之前,等待执行指定的快照管理策略,这样可以确保已删除索引的快照可用

- 增加 analysis-hanlp 分词插件

- 增加 jieba 分词插件

Bug fix

- 修复启用 index.source_reuse 时,对复杂多层 json 的 source 字段 解析不正确的 Bug

Improvements

- 更新索引生命周期管理 api 文档,增加策略应用和更新说明,增加 wait_for_snapshot 说明

- 执行

initialize.sh命令时增加初始化确认提示,是否将 admin 密码记录日志

INFINI Gateway v1.17.0

INFINI Gateway 是一个面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway 可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。

Gateway 本次更新如下:

Features

- 新增 consumer Processor 来标准化订阅消息队列

- 新增 smtp 过滤器来支持邮件的发送

Bug fix

- 支持自动跳过因为异常关闭而损坏的磁盘队列文件

INFINI Console v1.4.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

Console 本次更新如下:

Features

- 新增熔断器监控指标

- 网关队列管理支持多选删除消费者

- 数据看板新增组件矩形树图

Bug fix

- 修复开发工具智能提示兼容性问题

- 修复探针列表状态显示异常的问题

- 修复探针列表分页不生效的问题

- 修复数据看板 统计函数显示不对的问题

- 修复探针下发采集指标配置重复的问题

- 修复数据看板设置过滤条件不生效的问题

- 修复主机列表探针状态不对的问题

- 修复网关管理删除队列不成功的问题

- 修复数据探索当前集群没索引时跳转的问题

- 修复数据看板编辑状态下点击事件的问题

Improvements

- 探针进程关联支持通过选择集群自动关联,简化操作

- 探针列表支持排序

- 探针支持向上滚动查看节点日志

- 采集监控指标添加 cluster_uuid 信息

- 数据看板支持配置指标排序

INFINI Agent v0.6.0

INFINI Agent 是 INFINI Console 的一个可选探针组件,负责采集和上传集群指标和日志等信息,并可通过 Console 管理。Agent 支持主流操作系统和平台,安装包轻量且无任何外部依赖,可以快速方便地安装。

Agent 本次更新如下:

Features

- 采集监控指标添加 cluster_uuid 信息

Improvements

- 修复发现节点进程信息时获取不到最新集群配置的问题

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

或者通过 Discord 渠道加入聊天室:https://discord.com/invite/tnZ8S5vQ

欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

INFINI Labs 产品更新 | 重磅推出 Easysearch 一个分布式的近实时搜索与分析引擎

资讯动态 • liaosy 发表了文章 • 0 个评论 • 5456 次浏览 • 2023-05-16 11:57

INFINI Labs 产品又更新啦,包括 Easysearch v1.1.0、Gateway v1.13.0、Console v1.1.0、Agent v0.4.0,其中 Easysearch 经过团队的数月打磨,现正式对外推出。Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 衍生自基于开源协议 Apache 2.0 的 Elasticsearch 7.10.2 版本。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。与 Elasticsearch 相比,Easysearch 更关注在搜索业务场景的优化和继续保持其产品的简洁与易用性。欢迎大家下载体验。

INFINI Easysearch v1.1.0

INFINI Easysearch 本次更新最重要的功能是引入了 ZSTD 压缩算法,对索引进行全方位的压缩,尤其针对日志数据压缩效果更加明显,针对 1.1G 的 Nginx 日志进行测试,采用 ZSTD 策略后,膨胀率只有 0.94,甚至比原始数据还要小,而且还能进一步压缩,和 index.source_reuse 结合使用后,膨胀率只有 0.7,索引大小只有 Elasticsearch 原生 best_compression 的 59%,是 Elasticsearch 6.x 的 49%。下面是一张索引大小对比图:

更多介绍查看 详情。

其他更新功能如下:

Breaking changes

- Lucene 版本升级到 8.11.2

Breaking changes

- 增加 ZSTD codec, 引入 ZSTD 压缩算法,对存储字段,doc_values,词典进行压缩。

- 增加 index.source_reuse 索引级别配置,对 _source 进一步压缩。

- 提供索引生命周期管理 ILM 模块的功能,绝大部分 api 兼容 elasticsearch

Breaking changes

- 减少冗余日志输出。

- 减少 modules 模块整体大小。

下载地址:https://www.infinilabs.com/download

INFINI Gateway v1.13.0

极限网关本次更新如下:

Features

router.rules增加 enabled 选项,控制是否启用 flow- 增加对 loong64 架构的支持

- 增加对 riscv64 架构的支持

- elasticsearch filter 增加 dial_timeout 选项

Bug fix

- 修复 http/elasticsearch 转发后 HTTP 响应头丢失的问题

- 修复 pipeline 热加载出现重复 pipeline 同时运行的问题

- 修复 bulk_indexing 退出后泄漏 goroutine 的问题

Improvements

- 优化 HTTP 头设置方式,避免出现重复的 HTTP 头

- 优化 pipeline 停止的响应速度

- pipeline 增加 enabled 选项,控制是否启用 pipeline

更多 Gateway 更新可参考【Gateway 版本历史】。

INFINI Console v1.1.0

本次 INFINI Console 版本发布主要新增了网关实时日志查看功能、完善了数据迁移功能和数据看板的可视化能力、以及修复了已知 Bug。

实时日志

登录 Console,进入 [资源管理][网关管理] 界面,可以看到网关实时日志入口(前提需要注册网关)如下图所示:

进入实时日志展示界面,点击“开始”按钮后,服务端将 Gateway 日志实时推送到 Console 界面展示,在该界面可以动态调整输出不同的日志级别(DEBUG、INFO、WARN、ERROR 等),同时也支持文件名、方法名、消息内容加通配符进行过滤。

数据迁移

数据迁移模块,基于上个版本做了优化,添加 ILM,Template,Alias 初始化操作。方便用户根据各自的需求迁移索引生命周期、模板、别名等。

数据看板

数据看板图表支持复制、快速切换、时间框选、缩放、标记高亮,进一步增强 Console 可视化能力。

详情查看 操作演示视频。

除以上主要功能更新外,Console 其他功能优化如下:

Bug fix

- 修复数据探索保存查询出现 mapping 错误的问题

- 修复数据看板组件数据源配置的问题

- 修复数据探索左侧字段栏样式的问题

- 修复集群注册向导点击跳转后丢失集群类型的问题

Improvements

- 数据看板汉化

更多 Console 更新可参考【Console 版本历史】。

INFINI Agent v0.4.0

数据采集工具探针(INFINI Agent)更新如下:

Features

- 新增 logs_processor ,配置采集本地日志文件

Breaking changes

- es_logs_processor 调整日志字段

- created 重命名为 timestamp

- 自动提取 payload.timestamp payload.@timestmap 字段到 timestamp

- es_logs_processor 删除 enable 选项

下载地址: https://www.infinilabs.com/download/?product=agent

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

详情参见官网:https://www.infinilabs.com

INFINI 产品更新啦 20220923

资讯动态 • liaosy 发表了文章 • 0 个评论 • 3236 次浏览 • 2022-09-23 22:47

今天 INFINI Labs 为大家又带来了一波产品更新,请查阅。

INFINI Gateway v1.8.0

极限网关本次迭代更新如下:

- 修复上下文条件 consumer_has_lag参数和 配置、文档不一致的 Bug。

- 修改备集群故障,主集群不能正常写数据的 Bug。

- 修复 Bulk 请求处理异常造成数据复制不一致的问题。

- 修复请求日志里面关于 Bulk 统计数据丢失的问题。

- 修复大并发情况下,请求体为空的异常。

INFINI Console v0.6.0

口碑爆棚的 Elasticsearch 多集群管控平台 INFINI Console 更新如下:

- 新增主机概览。

- 新增主机监控。

- 节点概览新增日志查看功能(需安装 Agent)。

- Insight 配置框新增 Search 配置。

- 优化 Discover 时间范围 Auto Fit,设为15分钟。

- 优化 Discover 保存搜索,会保存当前的字段过滤和 Insight 图表配置。

- 优化本地列表搜索查找,支持通配符过滤。

- 优化告警规则必填字段标记显示。

- 修复了 Discover 字段过滤白屏问题。

- 修复了 Discover 表格添加字段后排序失效问题。(感谢@卢宝贤反馈)

- 修复了 Elasticsearch 8.x 删除文档报错不兼容的问题。(感谢@卢宝贤反馈)

- 修复了创建新索引不成功时,异常处理的问题。

- 修复了低版本浏览器js不兼容导致集群注册不成功的问题。

- 修复了开发工具中使用加载命令失败报错的问题。

INFINI Agent v0.2.0

数据采集工具探针(INFINI Agent)更新如下:

- 新增按节点读日志文件列表的API

- 新增读具体日志文件内容的API

- 新增 Elasticsearch 节点掉线后的基础信息保存

- 新增主机在线状态的采集

- 新增基于 Centos 的 Docker 镜像

- 新增主机配置信息采集: 操作系统信息、磁盘大小、内存大小、CPU配置等

- 新增主机指标的采集: CPU使用率、磁盘使用率、磁盘IO、内存使用率、swap 使用率、网络IO等

- 新增 Elasticsearch 进程信息采集

- 修复发现 Elasticsearch 进程时频繁提示端口访问错误的Bug

- 修复 Elasticsearch 节点地址为 0.0.0.0 时无法获取节点信息的Bug

- 修复 CPU 指标数据显示异常的Bug

- 修复 stats API 在 Windows 平台的兼容性

INFINI Framework 2000923

INFINI Framework 也带来了很多改进:

- 重构了磁盘队列压缩相关配置,支持段文件的压缩。

- 当集群不可用的情况下,跳过集群节点元数据的获取。

- 完善节点可用性检测,避免频繁的不可用状态切换。

- 修复 Elasticsearch 主机地址为空的异常。

- 完善本地磁盘队列文件的清理,避免删除正在使用的文件。

期待反馈

如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs)中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/#/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手,加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

感谢大家的围观,祝大家周末愉快。

day16 logstash-forwader To Kakfa!

Advent • childe 发表了文章 • 1 个评论 • 6083 次浏览 • 2015-12-18 16:37

{

"files": [

{

"paths": [

"/var/log/nginx/*.log"

],

"Fields":{

"type":"nginx"

},

"DeadTime": "30m"

},

{

"paths": [

"/var/log/tomcat/*.log",

"/var/log/tomcat/*/*.log"

],

"Fields":{

"type":"tomcat"

},

"DeadTime": "30m"

}

],

"kafka": {

"broker_list": ["10.0.0.1:9092","10.0.0.2:9092"],

"topic_id": "topic_name_change_it_{{.type}}",

"compression_codec": "gzip"

}

}- DeadTime:30m 是说超过30分钟没有更新, 就不会再继续跟踪这个文件了(退出goroutine)

- “Fields”:{ “type”:”tomcat” } , 会在每条日志中增加配置的字段

- path目前就是用的golang官方库, 好像是还不支持递归多层目录查找, 反正我翻了一下文档, 没有找到.

"files": [

{

"paths": [

"d:\\target.txt"

],

"FieldNames": ["datetime", "datetime", "s_ip", "cs_method", "cs_uri_stem", "cs_uri_query", "s_port", "time_taken"],

"Delimiter": "\\s+",

"QuoteChar": "\""

}

]