问题一:Logstash2.4.1 4台node,配置32核64G内存500G硬盘物理机,消费一个kafka topic,topic的消息量有27k/s,分区有32个,4台logstash的jvm我配置了2g,每台开8个消费线程,1000 fetch_size 10 workers 消费的时候lag一直在9000W左右,一直下不来,单机开32消费线程,输出到stdout,用pv测试只有13KB/S,无论怎么调参数都不行

下图是pv测试的结果,一直维持在11kB到15KB每秒

单机8个消费线程

单机1个线程

感觉两者没多少区别,topic总共有32个分区,很疑惑

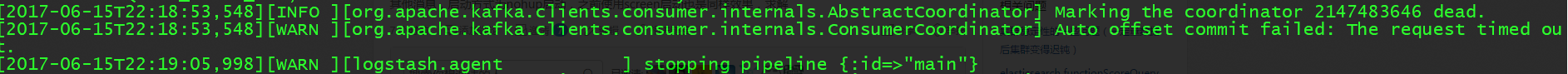

问题二:Logstash5.0.1也是相同配置的节点,10 workers 1000 batch_size,在同一个node上 ,启动一段时间后,进程自动退出,日志只显示stopping pipeline,报stopping之前一直报消费者发送给kafka心跳超时, 无其他消息,启动方式为nohup启动,之前使用screen启动也是同样效果,求解

下面是5.0的停止时的日志

下图是pv测试的结果,一直维持在11kB到15KB每秒

单机8个消费线程

单机1个线程

感觉两者没多少区别,topic总共有32个分区,很疑惑

问题二:Logstash5.0.1也是相同配置的节点,10 workers 1000 batch_size,在同一个node上 ,启动一段时间后,进程自动退出,日志只显示stopping pipeline,报stopping之前一直报消费者发送给kafka心跳超时, 无其他消息,启动方式为nohup启动,之前使用screen启动也是同样效果,求解

下面是5.0的停止时的日志

1 个回复

leighton_buaa

赞同来自:

https://www.elastic.co/guide/e ... .html

将pipeline.batch.size和pipeline.output.workers

调大试试