当日志量很大的时候,redis积压严重。想确定下瓶颈是出现在哪个环节。logstash-server,ES,kibana版本都是5.50

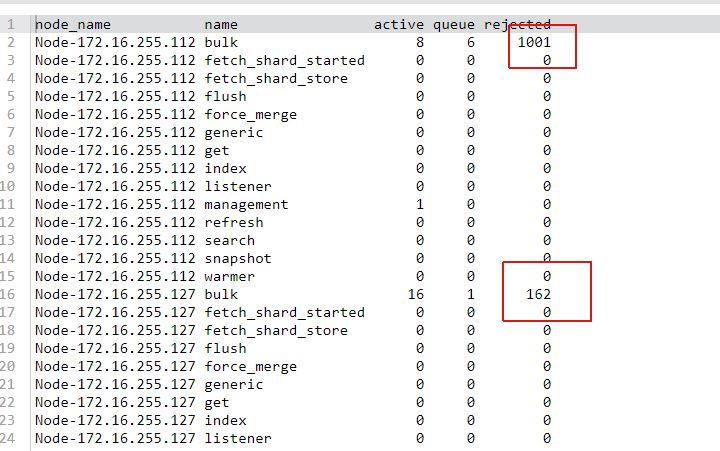

环境信息:logstash-agent---->redis(同一台服务器上3个redis实例)----->logstash-server(三台相同配置的服务器)---->ES----->kibana。每台logstashserver分别单独连接一个redis实例。没有调节logstash-sever配置之前,ES发现有连接被拒的情况。调节logstash-server的这些参数之后,没有ES被拒的情况了

pipeline.workers: 8

pipeline.output.workers: 16

pipeline.batch.size: 5000

logstash-server的配置:硬件信息:4核8线程 8G内存

jvm配置:

-Xms6g

-Xmx6g

其他的都是默认。

logstash-server的logstash.yml配置:(其他默认)

pipeline.workers: 8

pipeline.output.workers: 16

pipeline.batch.size: 5000

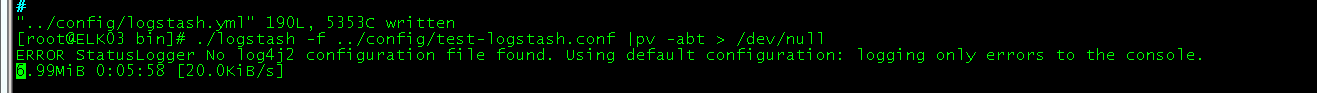

使用pv命令测试的结果如下,更换一台服务器,logstash-server的配置文件相同,相应的jvm的配置也增加了,服务器资源是原来的双倍,但是吞吐量还是上不去。

哪位大神能告知下什么情况吗?或者给个思路

环境信息:logstash-agent---->redis(同一台服务器上3个redis实例)----->logstash-server(三台相同配置的服务器)---->ES----->kibana。每台logstashserver分别单独连接一个redis实例。没有调节logstash-sever配置之前,ES发现有连接被拒的情况。调节logstash-server的这些参数之后,没有ES被拒的情况了

pipeline.workers: 8

pipeline.output.workers: 16

pipeline.batch.size: 5000

logstash-server的配置:硬件信息:4核8线程 8G内存

jvm配置:

-Xms6g

-Xmx6g

其他的都是默认。

logstash-server的logstash.yml配置:(其他默认)

pipeline.workers: 8

pipeline.output.workers: 16

pipeline.batch.size: 5000

使用pv命令测试的结果如下,更换一台服务器,logstash-server的配置文件相同,相应的jvm的配置也增加了,服务器资源是原来的双倍,但是吞吐量还是上不去。

哪位大神能告知下什么情况吗?或者给个思路

3 个回复

netkiller

赞同来自:

白衬衣 - 金桥

赞同来自:

你这样的情况,已经拒绝了,如果es的参数调优了的话,那很可能是es已经瓶颈了。

minchina91

赞同来自: