背景:

kafka中的一条消息是多条json数据压缩的gz文件,目前想通过logstash消费,并输出到es

问题:

请问该如何配置logstash才能正常消费

版本信息:

elasticsearch-7.4.2

logstash-7.5.0

kafka-2.1.1

配置:

其它:

第一次使用logstash,想尝试消费kafka,并写到es,但是从es查询出来后,发现数据是乱码,是不是与kafka的消息是gz压缩有关?

kafka中的一条消息是多条json数据压缩的gz文件,目前想通过logstash消费,并输出到es

问题:

请问该如何配置logstash才能正常消费

版本信息:

elasticsearch-7.4.2

logstash-7.5.0

kafka-2.1.1

配置:

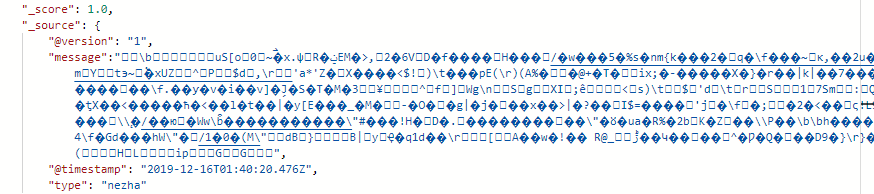

input {

kafka {

type => "nezha"

bootstrap_servers => "xxx"

topics_pattern => "xxx"

group_id => "xxx"

auto_offset_reset => "latest"

sasl_jaas_config => "org.apache.kafka.common.security.scram.ScramLoginModule required username='xxx' password='xxx';"

security_protocol => "SASL_PLAINTEXT"

sasl_mechanism => "SCRAM-SHA-256"

session_timeout_ms => "30000"

auto_commit_interval_ms => "1000"

}

}

output {

if [type] == "nezha" {

elasticsearch {

hosts => ["http://xxx:9200"]

index => "logstash_nezha_%{+YYYY.MM.dd}"

codec => "json"

}

}

}其它:

第一次使用logstash,想尝试消费kafka,并写到es,但是从es查询出来后,发现数据是乱码,是不是与kafka的消息是gz压缩有关?

1 个回复

locatelli

赞同来自:

另外你的问题并没有描述地很清楚:Kafka版本是多少?Logstash/ES版本是多少?当前pipeline如何配置?你查过哪些资料?尝试过哪些方法?结果分别是什么?你现在具体遇到了什么问题或是错误?...等等,都没有写清楚。

把问题写清楚有助于自己整理思路,有助于看你帖子的人回答问题,也是提问的基本礼仪。