Logstash5.4.1 处理速度慢且会自动关闭--已解决

匿名 | 发布于2020年02月14日 | 阅读数:3280问题描述:

1、tar包logstash处理速度慢,经对kafka的Consumer offset 计算可以大概算出每分钟能消费 6000 个 消息 ,根据定义,每分钟的处理速度应该是 5000*8/0.2=200000 条数据, 经观察uptime发现系统负载不高,在0.5~1.2之间 。目前的worker数量已经是cpu cores的2倍了,但处理速度提不上来,如何才能提高处理速度呢?

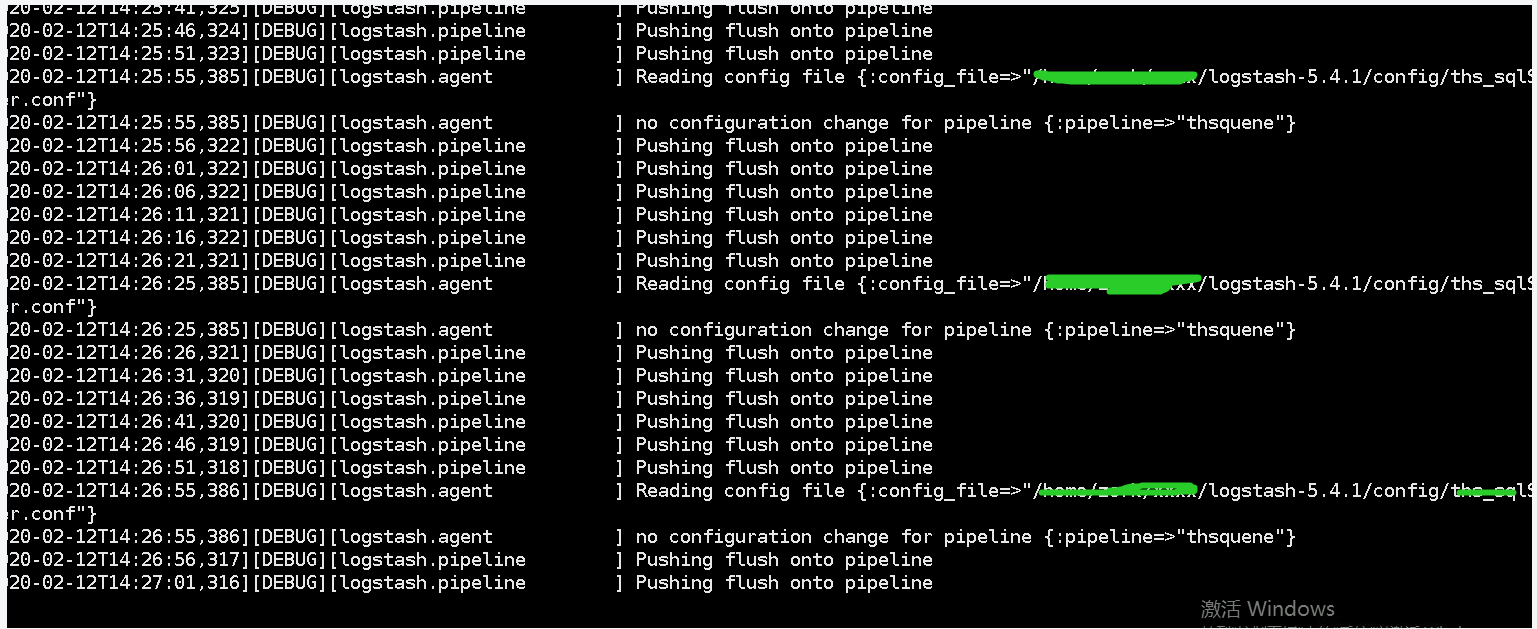

2、logstash运行一段时间后会自动停止,--debug跟踪信息如下

目前使用的方法是定时kill掉进程、清除queue队列数据后重新启动进程。这个报错查了也找不到原因,那位大佬能指点一二,不胜感激。

软件版本:Logstash 5.4.1 二进制tar包

运行环境:

OS: Centos 6.5 64位

Kernel : 2.6.32-431

Java: 1.8.0_181 server工作模式

CPU: Inter(R) Xeon(R) CPU E7-4850 v3@2.20GHz

CPU Cores: 4

Memory : 16GB

Other: 本系统上还运行着另外一个rpm包安装的logstash5.6.14-1的程序

网卡: VMware VMXNET3 Ethernet Controller(rev 01)

JVM.optiosns: -Xms -Xmx为 4GB USEG1GC

Logstash配置:

pipeline.id: main

pipeline.workers: 8

pipeline.output.workers: 8

pipeline.betch.size: 5000

pipeline.bethc.delay: 200

pipeline.unsafe_shutdown: false

path.conf: /home/zzz/logstash-5.4.1/config/conf.d

config.test_and_exit: false

config.reload.automatic: true

config.reload.interval: 30

config.debug: false

quere.type: persisted

path.queue: /home/zzz/logstash-5.4.1/data/mainquene

queue.page_capacity: 25mb

queue.max_events: 0

queue.max_bytes: 75mb

queue.checkpoint.acks: 0

queue.checkpoint.writes: 0

queue.chekcpoint.interval: 1000pipeline配置文件内容如下

input {

kafka {

bootstrap_servers => "t01:9092,tdh03:9092"

group_id => "oring_zz"

topics => "oring_zz"

codec => "json"

jaas_path => "/home/zzz/kerberosConf/jaas.conf"

kerberos_config => "/home/zzzz/kerberosConf/krb5.conf"

securify_protocol => "SASL_PLAINTEXT"

saslkerberos_service_name => "kafka"

}

}

filter {

ruby {

code => ""

remove_field => ["version","htime","type","@timestamp"]

}

}

output {

stdout {codec => rebydebug}

http {

http_method => "post"

format => "json"

url => "http://x.x.x.x:8080/checkkafka/log/PutLog"

automatic_retries => 3

retry_non_idempotent => true

socket_timeout => 30

keepalive => true

}

}

1 个回复

xiaoshancun

赞同来自: