OOM

Easysearch 内核完善之 OOM 内存溢出优化案例一则

Easysearch • liaosy 发表了文章 • 0 个评论 • 2598 次浏览 • 2024-03-15 10:37

最近某客户在使用 Easysearch 做聚合时,报出 OOM 导致掉节点的问题,当时直接让客户试着调整 indices.breaker.request.limit ,但是不起作用,于是又看了下 Easysearch 在断路器相关的代码,并自己测试了下。

断路器的种类和作用

Easysearch 内部有个 Circuit breaker 机制,目的是防止各种请求的负载过大导致 OutOfMemoryError,比较常用的断路器有 7 种,分别是:

- Parent circuit breaker 父断路器

- Field data circuit breaker fielddata 断路器

- Request circuit breaker 请求断路器

- In flight requests circuit breaker 传输请求断路器

- Accounting requests circuit breaker lucene 内存占用断路器

- Script compilation circuit breaker 脚本编译断路器

- Regex circuit breaker 正则表达式断路器

其中在执行消耗内存较多的聚合查询时,Request circuit breaker 用得最多。

复现测试

我在模拟客户场景测试聚合查询时,发现断路器并没有覆盖查询的整个流程,仍然会有 OOM 的风险。我测试了一个高基数 5 百万的 Terms aggregation,就没有触发断路,而是在等待了 1 分多钟后直接 OOM 了。我的测试环境是单节点 内存配置为 -Xmx1g,测试索引只有 1 个 shard。

测试语句如下:

curl -X GET "localhost:9211/leader-01/_search?pretty" -H 'Content-Type: application/json' -d'

{

"size": 1,

"aggs": {

"a": {

"terms": { "field": "agent.id.keyword", "size": 5000000 }

}

}

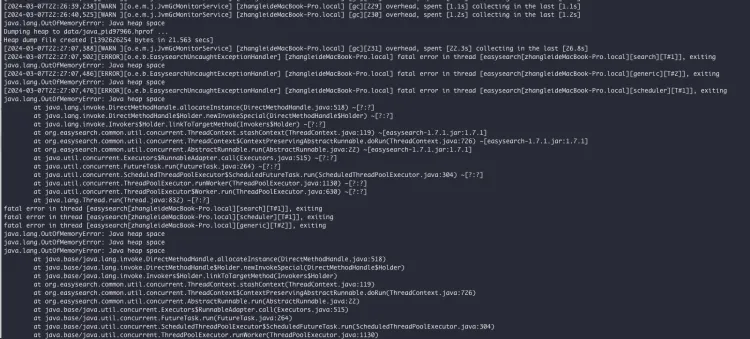

}' > a.txtEasysearch OOM 日志:

内存泄漏分析

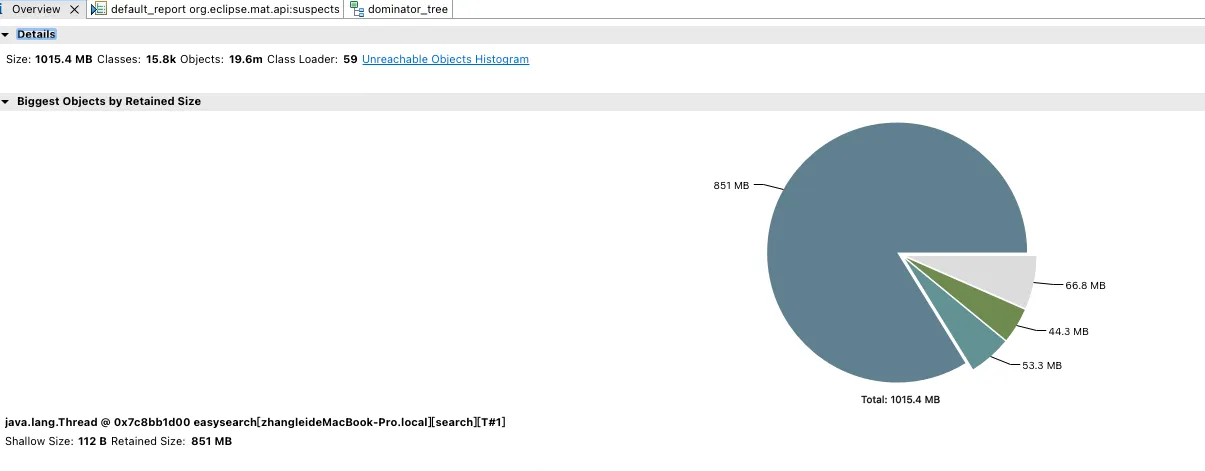

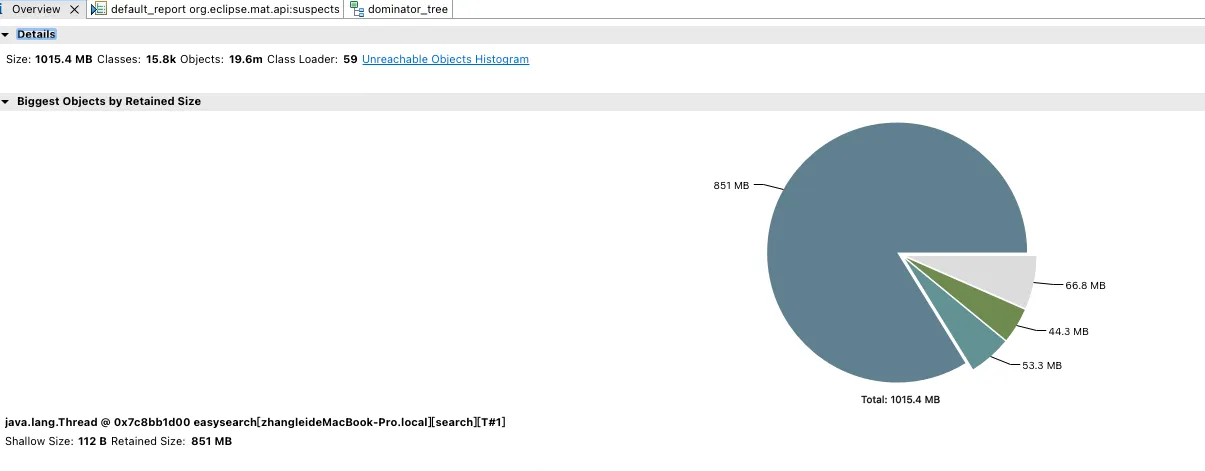

使用 MemoryAnalyzer 分析生成的 jvm 堆转储文件:

最大的内存占用来自 Java 线程java.lang.Thread @ 0x7c8bb1d00。这个线程浅层(Shallow)保留的对象占用了 112.8MB 内存。但该线程实际保留(Retained)的对象内存占用高达 851 MB,成为整个内存占用的绝对大头。

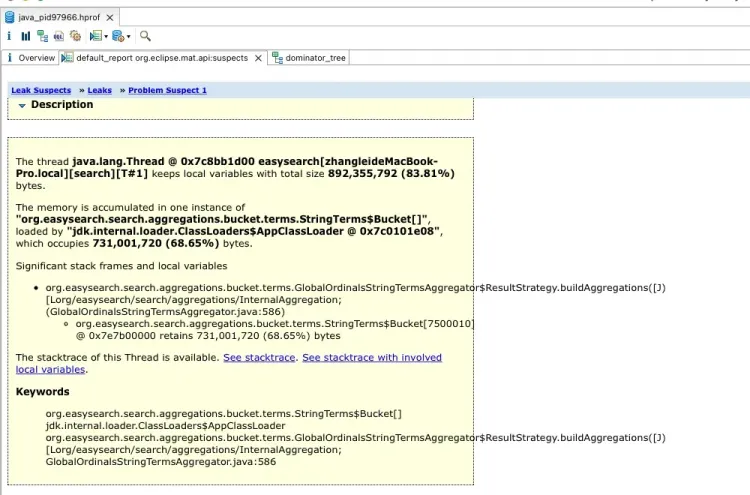

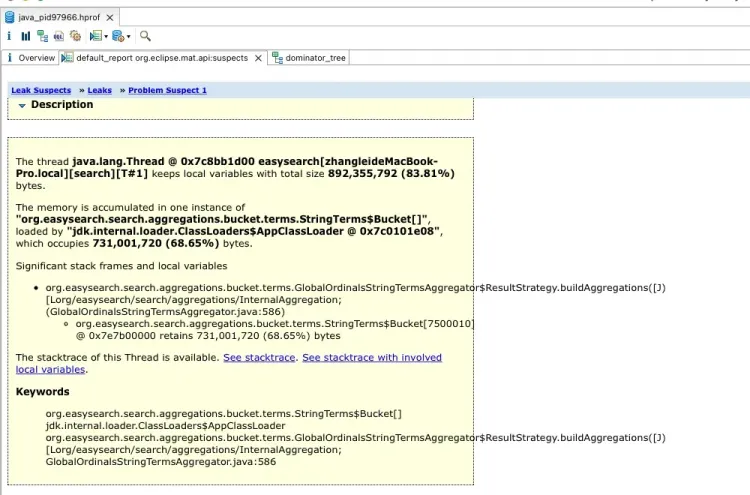

进一步查看 Leak Suspects:

非常明确的给出了具体的内存泄露的对象:StringTerms$Bucket[7500010]

数组长度达到了七百五十万,占用内存:731,001,720 字节(占总内存的 68.65%)。

按照提示的GlobalOrdinalsStringTermsAggregator.java:586 行,去查看代码,实际上是将收集完的OrdBucket 转换为 StringTerms.Bucket,并且有一个 copy BytesRef的操作。

至此,原因和解决办法都清楚了,只要在转换之前预估一下将要增长的内存并调用断路器检测一下内存,一旦超出允许范围就快速触发 CircuitBreakingException,避免长时间等待后 OOM 引起的节点宕机了。

最新版 Elasticsearch 对比

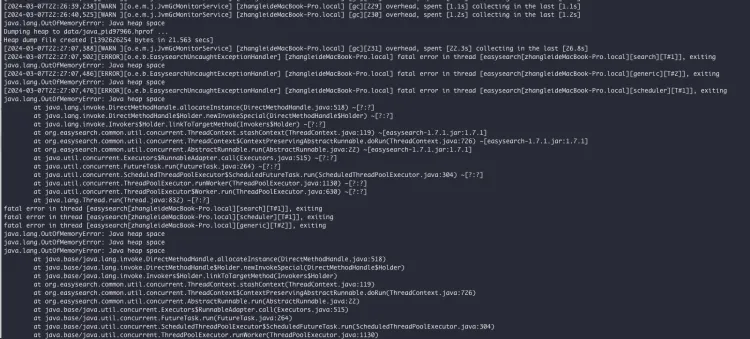

作为对比,我又测试了下 Elasticsearch 最新版本 8.12.2,同样的测试环境和测试方法,结果依然是 OOM:

从这里可以看出 Elasticsearch 即使是最新版的断路器机制也还有很多改进的余地,比如增加对有 OOM 风险查询的覆盖率,还有就是在触发 GC 时,对 GC 堆内存回收的判断过于简单。

Easysearch 最新版本的改进

Easysearch 刚刚发布的 1.7.1 版本已经增加了上面的改进,后面也会持续改进查询聚合操作的内存控制,最新版本的跨集群复制(CCR)也增加了对 source_reuse 索引的支持,能更好的满足客户降本增效的需求,欢迎大家下载试用。

附官网下载链接:https://www.infinilabs.com/download/?product=easysearch

关于 Easysearch

INFINI Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。 与 Elasticsearch 相比,Easysearch 更关注在搜索业务场景的优化和继续保持其产品的简洁与易用性。

官网文档:https://www.infinilabs.com/docs/latest/easysearch

如何防止 Elasticsearch 服务 OOM?

Easysearch • yangmf2040 发表了文章 • 0 个评论 • 3649 次浏览 • 2024-02-26 10:12

Elasticsearch(简称:ES) 和传统关系型数据库有很多区别, 比如传统数据中普遍都有一个叫“最大连接数”的设置。目的是使数据库系统工作在可控的负载下,避免出现负载过高,资源耗尽,谁也无法登录的局面。

那 ES 在这方面有类似参数吗?答案是没有,这也是为何 ES 会被流量打爆的原因之一。

针对大并发访问 ES 服务,造成 ES 节点 OOM,服务中断的情况,极限科技旗下的 INFINI Gateway 产品(以下简称 “极限网关”)可从两个方面入手,保障 ES 服务的可用性。

- 限制最大并发访问连接数。

- 限制非重要索引的请求速度,保障重要业务索引的访问速度。

下面我们来详细聊聊。

架构图

所有访问 ES 的请求都发给网关,可部署多个网关。

所有访问 ES 的请求都发给网关,可部署多个网关。

限制最大连接数

在网关配置文件中,默认有最大并发连接数限制,默认最大 10000。

entry:

- name: my_es_entry

enabled: true

router: my_router

max_concurrency: 10000

network:

binding: $[[env.GW_BINDING]]

# See `gateway.disable_reuse_port_by_default` for more information.

reuse_port: true使用压测程序测试,看看到达10000个连接后,能否限制新的连接。

超过的连接请求,被丢弃。更多信息参考官方文档。

超过的连接请求,被丢弃。更多信息参考官方文档。

限制索引写入速度

我们先看看不做限制的时候,测试环境的写入速度,在 9w - 15w docs/s 之间波动。虽然峰值很高,但不稳定。

接下来,我们通过网关把写入速度控制在最大 1w docs/s 。

对网关的配置文件 gateway.yml ,做以下修改。

接下来,我们通过网关把写入速度控制在最大 1w docs/s 。

对网关的配置文件 gateway.yml ,做以下修改。

env: # env 下添加

THROTTLE_BULK_INDEXING_MAX_BYTES: 40485760 #40MB/s

THROTTLE_BULK_INDEXING_MAX_REQUESTS: 10000 #10k docs/s

THROTTLE_BULK_INDEXING_ACTION: retry #retry,drop

THROTTLE_BULK_INDEXING_MAX_RETRY_TIMES: 10 #1000

THROTTLE_BULK_INDEXING_RETRY_DELAY_IN_MS: 100 #10

router: # route 部分修改 flow

- name: my_router

default_flow: default_flow

tracing_flow: logging_flow

rules:

- method:

- "*"

pattern:

- "/_bulk"

- "/{any_index}/_bulk"

flow:

- write_flow

flow: #flow 部分增加下面两段

- name: write_flow

filter:

- flow:

flows:

- bulking_indexing_limit

- elasticsearch:

elasticsearch: prod

max_connection_per_node: 1000

- name: bulking_indexing_limit

filter:

- bulk_request_throttle:

indices:

"test-index":

max_bytes: $[[env.THROTTLE_BULK_INDEXING_MAX_BYTES]]

max_requests: $[[env.THROTTLE_BULK_INDEXING_MAX_REQUESTS]]

action: $[[env.THROTTLE_BULK_INDEXING_ACTION]]

retry_delay_in_ms: $[[env.THROTTLE_BULK_INDEXING_RETRY_DELAY_IN_MS]]

max_retry_times: $[[env.THROTTLE_BULK_INDEXING_MAX_RETRY_TIMES]]

message: "bulk writing too fast" #触发限流告警message自定义

log_warn_message: true

再次压测,test-index 索引写入速度被限制在了 1w docs/s 。

限制多个索引写入速度

上面的配置是针对 test-index 索引的写入速度控制。如果想添加其他的索引,新增一段配置即可。 比如,我允许 abc 索引写入达到 2w docs/s,test-index 索引最多不超过 1w docs/s ,可配置如下。

- name: bulking_indexing_limit

filter:

- bulk_request_throttle:

indices:

"abc":

max_requests: 20000

action: drop

message: "abc doc写入超阈值" #触发限流告警message自定义

log_warn_message: true

"test-index":

max_bytes: $[[env.THROTTLE_BULK_INDEXING_MAX_BYTES]]

max_requests: $[[env.THROTTLE_BULK_INDEXING_MAX_REQUESTS]]

action: $[[env.THROTTLE_BULK_INDEXING_ACTION]]

retry_delay_in_ms: $[[env.THROTTLE_BULK_INDEXING_RETRY_DELAY_IN_MS]]

max_retry_times: $[[env.THROTTLE_BULK_INDEXING_MAX_RETRY_TIMES]]

message: "bulk writing too fast" #触发限流告警message自定义

log_warn_message: true限速效果如下

限制读请求速度

我们先看看不做限制的时候,测试环境的读取速度,7w qps 。

接下来我们通过网关把读取速度控制在最大 1w qps 。

继续对网关的配置文件 gateway.yml 做以下修改。

接下来我们通过网关把读取速度控制在最大 1w qps 。

继续对网关的配置文件 gateway.yml 做以下修改。

- name: default_flow

filter:

- request_path_limiter:

message: "Hey, You just reached our request limit!" rules:

- pattern: "/(?P<index_name>abc)/_search"

max_qps: 10000

group: index_name

- elasticsearch:

elasticsearch: prod

max_connection_per_node: 1000再次进行测试,读取速度被限制在了 1w qps 。

限制多个索引读取速度

上面的配置是针对 abc 索引的写入速度控制。如果想添加其他的索引,新增一段配置即可。 比如,我允许 abc 索引读取达到 1w qps,test-index 索引最多不超过 2w qps ,可配置如下。

- name: default_flow

filter:

- request_path_limiter:

message: "Hey, You just reached our request limit!"

rules:

- pattern: "/(?P<index_name>abc)/_search"

max_qps: 10000

group: index_name

- pattern: "/(?P<index_name>test-index)/_search"

max_qps: 20000

group: index_name

- elasticsearch:

elasticsearch: prod

max_connection_per_node: 1000

多个网关限速

限速是每个网关自身的控制,如果有多个网关,那么后端 ES 集群收到的请求数等于多个网关限速的总和。

本次介绍就到这里了。相信大家在使用 ES 的过程中也遇到过各种各样的问题。欢迎大家来我们这个平台分享自己的问题、解决方案等。如有任何问题,请随时联系我,期待与您交流!

本次介绍就到这里了。相信大家在使用 ES 的过程中也遇到过各种各样的问题。欢迎大家来我们这个平台分享自己的问题、解决方案等。如有任何问题,请随时联系我,期待与您交流!

求助:es 频发oom

Elasticsearch • tongchuan1992 回复了问题 • 3 人关注 • 1 个回复 • 3004 次浏览 • 2021-08-11 16:12

filebeat遇到二进制文件内存暴增OOM

Beats • just_finy 回复了问题 • 2 人关注 • 1 个回复 • 4248 次浏览 • 2021-04-21 17:07

es集群主节点会因为短时间内大量查询导致OOM吗?之后生成的.hprof文件该怎么处理?

Elasticsearch • medcl 回复了问题 • 4 人关注 • 3 个回复 • 9127 次浏览 • 2018-04-11 09:59

Elasticsearch 内存泄漏 oom 没有bulk输入

回复Elasticsearch • caomaocao 发起了问题 • 1 人关注 • 0 个回复 • 7002 次浏览 • 2017-12-22 18:15

es集群主节点会因为短时间内大量查询导致OOM吗?之后生成的.hprof文件该怎么处理?

回复Elasticsearch • medcl 回复了问题 • 4 人关注 • 3 个回复 • 9127 次浏览 • 2018-04-11 09:59

Elasticsearch 内存泄漏 oom 没有bulk输入

回复Elasticsearch • caomaocao 发起了问题 • 1 人关注 • 0 个回复 • 7002 次浏览 • 2017-12-22 18:15

Easysearch 内核完善之 OOM 内存溢出优化案例一则

Easysearch • liaosy 发表了文章 • 0 个评论 • 2598 次浏览 • 2024-03-15 10:37

最近某客户在使用 Easysearch 做聚合时,报出 OOM 导致掉节点的问题,当时直接让客户试着调整 indices.breaker.request.limit ,但是不起作用,于是又看了下 Easysearch 在断路器相关的代码,并自己测试了下。

断路器的种类和作用

Easysearch 内部有个 Circuit breaker 机制,目的是防止各种请求的负载过大导致 OutOfMemoryError,比较常用的断路器有 7 种,分别是:

- Parent circuit breaker 父断路器

- Field data circuit breaker fielddata 断路器

- Request circuit breaker 请求断路器

- In flight requests circuit breaker 传输请求断路器

- Accounting requests circuit breaker lucene 内存占用断路器

- Script compilation circuit breaker 脚本编译断路器

- Regex circuit breaker 正则表达式断路器

其中在执行消耗内存较多的聚合查询时,Request circuit breaker 用得最多。

复现测试

我在模拟客户场景测试聚合查询时,发现断路器并没有覆盖查询的整个流程,仍然会有 OOM 的风险。我测试了一个高基数 5 百万的 Terms aggregation,就没有触发断路,而是在等待了 1 分多钟后直接 OOM 了。我的测试环境是单节点 内存配置为 -Xmx1g,测试索引只有 1 个 shard。

测试语句如下:

curl -X GET "localhost:9211/leader-01/_search?pretty" -H 'Content-Type: application/json' -d'

{

"size": 1,

"aggs": {

"a": {

"terms": { "field": "agent.id.keyword", "size": 5000000 }

}

}

}' > a.txtEasysearch OOM 日志:

内存泄漏分析

使用 MemoryAnalyzer 分析生成的 jvm 堆转储文件:

最大的内存占用来自 Java 线程java.lang.Thread @ 0x7c8bb1d00。这个线程浅层(Shallow)保留的对象占用了 112.8MB 内存。但该线程实际保留(Retained)的对象内存占用高达 851 MB,成为整个内存占用的绝对大头。

进一步查看 Leak Suspects:

非常明确的给出了具体的内存泄露的对象:StringTerms$Bucket[7500010]

数组长度达到了七百五十万,占用内存:731,001,720 字节(占总内存的 68.65%)。

按照提示的GlobalOrdinalsStringTermsAggregator.java:586 行,去查看代码,实际上是将收集完的OrdBucket 转换为 StringTerms.Bucket,并且有一个 copy BytesRef的操作。

至此,原因和解决办法都清楚了,只要在转换之前预估一下将要增长的内存并调用断路器检测一下内存,一旦超出允许范围就快速触发 CircuitBreakingException,避免长时间等待后 OOM 引起的节点宕机了。

最新版 Elasticsearch 对比

作为对比,我又测试了下 Elasticsearch 最新版本 8.12.2,同样的测试环境和测试方法,结果依然是 OOM:

从这里可以看出 Elasticsearch 即使是最新版的断路器机制也还有很多改进的余地,比如增加对有 OOM 风险查询的覆盖率,还有就是在触发 GC 时,对 GC 堆内存回收的判断过于简单。

Easysearch 最新版本的改进

Easysearch 刚刚发布的 1.7.1 版本已经增加了上面的改进,后面也会持续改进查询聚合操作的内存控制,最新版本的跨集群复制(CCR)也增加了对 source_reuse 索引的支持,能更好的满足客户降本增效的需求,欢迎大家下载试用。

附官网下载链接:https://www.infinilabs.com/download/?product=easysearch

关于 Easysearch

INFINI Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。 与 Elasticsearch 相比,Easysearch 更关注在搜索业务场景的优化和继续保持其产品的简洁与易用性。

官网文档:https://www.infinilabs.com/docs/latest/easysearch

如何防止 Elasticsearch 服务 OOM?

Easysearch • yangmf2040 发表了文章 • 0 个评论 • 3649 次浏览 • 2024-02-26 10:12

Elasticsearch(简称:ES) 和传统关系型数据库有很多区别, 比如传统数据中普遍都有一个叫“最大连接数”的设置。目的是使数据库系统工作在可控的负载下,避免出现负载过高,资源耗尽,谁也无法登录的局面。

那 ES 在这方面有类似参数吗?答案是没有,这也是为何 ES 会被流量打爆的原因之一。

针对大并发访问 ES 服务,造成 ES 节点 OOM,服务中断的情况,极限科技旗下的 INFINI Gateway 产品(以下简称 “极限网关”)可从两个方面入手,保障 ES 服务的可用性。

- 限制最大并发访问连接数。

- 限制非重要索引的请求速度,保障重要业务索引的访问速度。

下面我们来详细聊聊。

架构图

所有访问 ES 的请求都发给网关,可部署多个网关。

所有访问 ES 的请求都发给网关,可部署多个网关。

限制最大连接数

在网关配置文件中,默认有最大并发连接数限制,默认最大 10000。

entry:

- name: my_es_entry

enabled: true

router: my_router

max_concurrency: 10000

network:

binding: $[[env.GW_BINDING]]

# See `gateway.disable_reuse_port_by_default` for more information.

reuse_port: true使用压测程序测试,看看到达10000个连接后,能否限制新的连接。

超过的连接请求,被丢弃。更多信息参考官方文档。

超过的连接请求,被丢弃。更多信息参考官方文档。

限制索引写入速度

我们先看看不做限制的时候,测试环境的写入速度,在 9w - 15w docs/s 之间波动。虽然峰值很高,但不稳定。

接下来,我们通过网关把写入速度控制在最大 1w docs/s 。

对网关的配置文件 gateway.yml ,做以下修改。

接下来,我们通过网关把写入速度控制在最大 1w docs/s 。

对网关的配置文件 gateway.yml ,做以下修改。

env: # env 下添加

THROTTLE_BULK_INDEXING_MAX_BYTES: 40485760 #40MB/s

THROTTLE_BULK_INDEXING_MAX_REQUESTS: 10000 #10k docs/s

THROTTLE_BULK_INDEXING_ACTION: retry #retry,drop

THROTTLE_BULK_INDEXING_MAX_RETRY_TIMES: 10 #1000

THROTTLE_BULK_INDEXING_RETRY_DELAY_IN_MS: 100 #10

router: # route 部分修改 flow

- name: my_router

default_flow: default_flow

tracing_flow: logging_flow

rules:

- method:

- "*"

pattern:

- "/_bulk"

- "/{any_index}/_bulk"

flow:

- write_flow

flow: #flow 部分增加下面两段

- name: write_flow

filter:

- flow:

flows:

- bulking_indexing_limit

- elasticsearch:

elasticsearch: prod

max_connection_per_node: 1000

- name: bulking_indexing_limit

filter:

- bulk_request_throttle:

indices:

"test-index":

max_bytes: $[[env.THROTTLE_BULK_INDEXING_MAX_BYTES]]

max_requests: $[[env.THROTTLE_BULK_INDEXING_MAX_REQUESTS]]

action: $[[env.THROTTLE_BULK_INDEXING_ACTION]]

retry_delay_in_ms: $[[env.THROTTLE_BULK_INDEXING_RETRY_DELAY_IN_MS]]

max_retry_times: $[[env.THROTTLE_BULK_INDEXING_MAX_RETRY_TIMES]]

message: "bulk writing too fast" #触发限流告警message自定义

log_warn_message: true

再次压测,test-index 索引写入速度被限制在了 1w docs/s 。

限制多个索引写入速度

上面的配置是针对 test-index 索引的写入速度控制。如果想添加其他的索引,新增一段配置即可。 比如,我允许 abc 索引写入达到 2w docs/s,test-index 索引最多不超过 1w docs/s ,可配置如下。

- name: bulking_indexing_limit

filter:

- bulk_request_throttle:

indices:

"abc":

max_requests: 20000

action: drop

message: "abc doc写入超阈值" #触发限流告警message自定义

log_warn_message: true

"test-index":

max_bytes: $[[env.THROTTLE_BULK_INDEXING_MAX_BYTES]]

max_requests: $[[env.THROTTLE_BULK_INDEXING_MAX_REQUESTS]]

action: $[[env.THROTTLE_BULK_INDEXING_ACTION]]

retry_delay_in_ms: $[[env.THROTTLE_BULK_INDEXING_RETRY_DELAY_IN_MS]]

max_retry_times: $[[env.THROTTLE_BULK_INDEXING_MAX_RETRY_TIMES]]

message: "bulk writing too fast" #触发限流告警message自定义

log_warn_message: true限速效果如下

限制读请求速度

我们先看看不做限制的时候,测试环境的读取速度,7w qps 。

接下来我们通过网关把读取速度控制在最大 1w qps 。

继续对网关的配置文件 gateway.yml 做以下修改。

接下来我们通过网关把读取速度控制在最大 1w qps 。

继续对网关的配置文件 gateway.yml 做以下修改。

- name: default_flow

filter:

- request_path_limiter:

message: "Hey, You just reached our request limit!" rules:

- pattern: "/(?P<index_name>abc)/_search"

max_qps: 10000

group: index_name

- elasticsearch:

elasticsearch: prod

max_connection_per_node: 1000再次进行测试,读取速度被限制在了 1w qps 。

限制多个索引读取速度

上面的配置是针对 abc 索引的写入速度控制。如果想添加其他的索引,新增一段配置即可。 比如,我允许 abc 索引读取达到 1w qps,test-index 索引最多不超过 2w qps ,可配置如下。

- name: default_flow

filter:

- request_path_limiter:

message: "Hey, You just reached our request limit!"

rules:

- pattern: "/(?P<index_name>abc)/_search"

max_qps: 10000

group: index_name

- pattern: "/(?P<index_name>test-index)/_search"

max_qps: 20000

group: index_name

- elasticsearch:

elasticsearch: prod

max_connection_per_node: 1000

多个网关限速

限速是每个网关自身的控制,如果有多个网关,那么后端 ES 集群收到的请求数等于多个网关限速的总和。

本次介绍就到这里了。相信大家在使用 ES 的过程中也遇到过各种各样的问题。欢迎大家来我们这个平台分享自己的问题、解决方案等。如有任何问题,请随时联系我,期待与您交流!

本次介绍就到这里了。相信大家在使用 ES 的过程中也遇到过各种各样的问题。欢迎大家来我们这个平台分享自己的问题、解决方案等。如有任何问题,请随时联系我,期待与您交流!