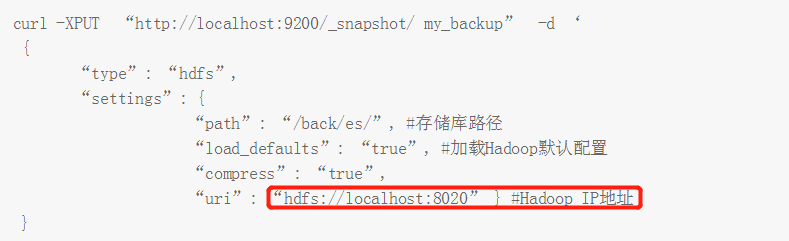

ES安装HDFS插件后,可以使用HDFS的方式进行数据备份,在配置备份仓库时,需要配置如下几个项目:

这个uri可以配置多个IP吗?应为Hadoop的namenode有两个,主备关系,当一个挂掉后,自动切换到另一个IP。但是这种情况下,这个ES的存储库会一直发生改变。

我自己试了一下,如果这样配置是不行的。

请教

curl -XPUT “http://localhost:9200/_snapshot/ my_backup” -d ‘

{

“type”: “hdfs”,

“settings”: {

“path”: “/back/es/”, #存储库路径

“load_defaults”: “true”, #加载Hadoop默认配置

“compress”: “true”,

“uri”: “hdfs://localhost:8020” } #Hadoop IP地址

}这个uri可以配置多个IP吗?应为Hadoop的namenode有两个,主备关系,当一个挂掉后,自动切换到另一个IP。但是这种情况下,这个ES的存储库会一直发生改变。

我自己试了一下,如果这样配置是不行的。

"uri":"hdfs://10.100.10.11:8020,10.100.10.12:8020"请教

3 个回复

yayg2008

赞同来自:

jianjianhe

赞同来自:

zqc0512 - andy zhou

赞同来自: