Elasticsearch

【搜索客社区日报】第2174期 (2026-01-05)

社区日报 • Muses 发表了文章 • 0 个评论 • 15521 次浏览 • 2026-01-05 10:49

【搜索客社区日报】第2150期 (2025-11-24)

社区日报 • Muses 发表了文章 • 0 个评论 • 8314 次浏览 • 2025-11-24 16:00

【搜索客社区日报】第2138期 (2025-11-03)

社区日报 • Muses 发表了文章 • 0 个评论 • 8220 次浏览 • 2025-11-03 20:22

搜索百科(6):Meilisearch — Rust 打造的轻量级搜索新锐

开源项目 • liaosy 发表了文章 • 0 个评论 • 9851 次浏览 • 2025-10-31 18:00

大家好,我是 INFINI Labs 的石阳。

欢迎关注 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

在之前的几期中,我们认识了搜索技术的基石 Lucene、企业级搜索先锋 Solr、搜索界的“流量明星” Elasticsearch 以及它的分叉兄弟 OpenSearch 和 ES 国产替代方案 Easysearch。它们大多基于 Lucene 构建,形成了庞大且功能丰富的生态。

今天,我们将介绍一位“非主流”选手:一款基于 Rust 编写、主打“快”和“简单”的现代搜索引擎——Meilisearch。它以全新的姿态,为开发者带来了不同的搜索体验。

Meilisearch 概述

Meilisearch 是一款开源的、用 Rust 编写的即时搜索引擎。它提供了一个快速、轻量且可定制的搜索 API,旨在为用户提供毫秒级的搜索体验。

它的核心优势在于为应用内搜索和电商搜索等对延迟敏感的场景提供了出色的用户体验。

- 首次发布:2020 年

- 最新版本:1.24.0(截止 2025 年 10 月)

- 核心语言:Rust

- 开源协议:MIT License

- 官方网址:https://www.meilisearch.com/

- GitHub 仓库:https://github.com/meilisearch/meilisearch

诞生故事

Meilisearch 的故事始于 2018 年,当时法国工程师 Quentin de Quelen 在开发一个电商项目时,发现现有的搜索引擎要么太重量级,要么配置太复杂。他想要一个"开箱即用"的搜索解决方案,能够快速集成到应用中,并提供优秀的搜索体验。

于是,他决定用 Rust 语言从头编写一个搜索引擎。选择 Rust 是因为其出色的性能、内存安全性和并发能力,非常适合构建高性能的搜索核心。

项目最初只是一个内部工具,但随着功能的完善和社区的反馈,Meilisearch 在 2019 年正式开源,并迅速获得了开发者的青睐。2020 年,团队获得了 150 万美元的种子轮融资,正式成立了 Meilisearch 公司。

核心特性

Meilisearch 在设计上做了大量的取舍,专注于核心的搜索功能,但做到了极致。

- 极速响应:核心目标是实现 50 毫秒以下的响应时间,即使在大型数据集中也能提供“所见即所得”的搜索体验。

- 零配置:开箱即用,部署和索引数据都非常简单,不需要预定义 Schema 或复杂的配置文件。

- 相关的默认值:内置一个强大的 相关性排名(Relevance Ranking) 算法,结合 Typos(拼写错误)、Word Proximity(词语距离)和 Attributes(字段权重)等因素,无需额外调优即可获得高质量的搜索结果。

- 语言无关性:支持多种语言的分词与搜索,能很好地处理中文、日文等非拉丁语系文本。

- 无分布式架构:为了追求极致的速度和简单性,Meilisearch 被设计为单机搜索引擎,不支持开箱即用的分布式集群,这简化了运维,但也限制了其 PB 级数据的处理能力。

对比优势:Meilisearch vs Lucene/ES 体系

Meilisearch 与基于 Lucene 的 Elasticsearch 体系,在设计哲学上有着本质区别:

| 特性 | Meilisearch | Elasticsearch |

|---|---|---|

| 核心目标 | 极速的应用内搜索体验 | 分布式搜索、日志分析、可观测性 |

| 基础架构 | 单机、轻量级 | 分布式集群(主从节点、分片) |

| 核心语言 | Rust | Java(基于 Lucene) |

| 性能瓶颈 | 单机 CPU / 内存限制 | 分布式协调开销 |

| 上手难度 | 简单,开箱即用,REST API | 相对复杂,需要了解集群、分片等概念 |

| 数据规模 | 适合中小型数据集(GB 级别) | 适合大型和超大型数据集(TB/PB 级别) |

| 全文检索 | 依赖内置的强相关性算法 | 依赖 Lucene 强大的分词、查询解析器 |

总结:

- 如果你的应用需要超低延迟、简单部署、数据量在 GB 级别,并且搜索是应用的核心功能,Meilisearch 是一个极佳的选择。

- 如果你的需求涉及日志分析、大规模数据存储、集群高可用和复杂的聚合分析,那么 Elasticsearch 仍然是更成熟和全面的解决方案。

快速上手:5 分钟体验 Meilisearch

部署 Meilisearch 非常简单,你甚至不需要 Docker,只需一个命令即可运行。

1. 运行 Meilisearch

# 安装 Meilisearch

curl -L https://install.meilisearch.com | sh

# 启动 Meilisearch

meilisearch --master-key 'aStrongMasterKey'

# 或使用 Docker

docker run -it --rm -p 7700:7700 getmeili/meilisearch:latest --master-key 'aStrongMasterKey'2. 添加索引(创建 Index)

Meilisearch 不需要预先定义索引结构(Schema-less)。

curl -X POST 'http://localhost:7700/indexes' \

-H 'Authorization: Bearer aStrongMasterKey' \

-H 'Content-Type: application/json' \

--data-binary '{

"uid": "movies",

"primaryKey": "id"

}'3. 索引文档(添加 Documents)

curl -X POST 'http://localhost:7700/indexes/movies/documents' \

-H 'Authorization: Bearer aStrongMasterKey' \

-H 'Content-Type: application/json' \

--data-binary '[

{"id": 1, "title": "泰坦尼克号", "genres": ["剧情", "爱情"]},

{"id": 2, "title": "黑客帝国", "genres": ["科幻", "动作"]}

]'4. 执行搜索

# 搜索关键词 "泰坦"

curl -X GET 'http://localhost:7700/indexes/movies/search?q=泰坦'返回结果:

{

"hits": [

{

"id": 1,

"title": "泰坦尼克号",

"genres": ["剧情", "爱情"]

}

],

"offset": 0,

"limit": 20,

"estimatedTotalHits": 1,

"processingTimeMs": 1,

"query": "泰坦"

}注意 processingTimeMs: 1,这是 Meilisearch 速度的最好证明!

5. 场景演示

结语

Meilisearch 的出现,代表了新一代搜索引擎对于开发者体验和即时性的追求。它在应用内搜索领域展现了强大的竞争力,证明了不必依赖 Lucene 的庞大体系,也能打造出极致性能的搜索产品。

虽然它还无法完全取代 Elasticsearch 在日志分析、可观测性等大型分布式场景的地位,但在许多新兴应用和对搜索速度有极高要求的场景中,它无疑是一个值得尝试的开源新星。

🚀 下期预告

下一篇我们将把目光转向搜索领域的云端先锋 —— Algolia。作为搜索即服务(Search-as-a-Service)的开创者,Algolia 如何以其卓越的 API 设计、惊人的搜索速度和精准的相关性排序,重新定义云端搜索体验?

💬 三连互动

- 你会把 ES/Solr 换成 Meilisearch 吗?

- 在你的应用中,搜索延迟达到多少毫秒你会觉得无法接受?

- 在什么场景下你会考虑使用 Meilisearch 而不是 Elasticsearch?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

- 搜索百科(5):Easysearch — 自主可控的国产分布式搜索引擎

- 搜索百科(4):OpenSearch — 开源搜索的新选择

- 搜索百科(3):Elasticsearch — 搜索界的"流量明星"

- 搜索百科(2):Apache Solr — 企业级搜索的开源先锋

- 搜索百科(1):Lucene — 打开现代搜索世界的第一扇门

🔗 参考资源

【搜索客社区日报】第2134期 (2025-10-27)

社区日报 • Muses 发表了文章 • 0 个评论 • 8275 次浏览 • 2025-10-27 17:18

搜索百科(5):Easysearch — 自主可控的国产分布式搜索引擎

Easysearch • liaosy 发表了文章 • 0 个评论 • 7464 次浏览 • 2025-10-20 15:54

大家好,我是 INFINI Labs 的石阳。

欢迎关注 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

在上一篇我们介绍了 OpenSearch —— 那个因协议争议而诞生的开源搜索分支。今天,我们把目光转向国内,聊聊极限科技研发的一款轻量级搜索引擎:Easysearch。

引言

在搜索技术的世界里,从 Lucene 的出现到 Solr、Elasticsearch 的崛起,搜索引擎技术已经发展了二十余年。然而,随着开源协议的变更与国际形势的变化,国产自主搜索引擎的需求愈发迫切。在这样的背景下,Easysearch 作为一款自主可控、轻量高效、兼容 Elasticsearch 的分布式搜索引擎应运而生,为国内企业带来了全新的选择。

Easysearch 概述

Easysearch 是一款分布式搜索型数据库,实现非结构化数据检索、全文检索、向量检索、地理位置信息查询、组合索引查询、多语种支持、聚合分析、AI 集成等。Easysearch 衍生自开源协议 Apache 2.0 的 Elasticsearch 7.10 版本,并不断往前迭代更新,紧跟 Lucene 最新版本的更新。Easysearch 可以替代 Elasticsearch,同时添加和完善多项企业级功能。

- 首次发布:2023 年 4 月

- 最新版本:1.15.4(截止 2025 年 10 月)

- 主导企业:极限科技 (INFINI Labs)

- 官方网址:https://easysearch.cn

诞生背景:为什么要有 Easysearch?

Easysearch 由极限科技(INFINI Labs)团队推出。项目的起点源于团队长期在搜索引擎和大数据领域的深厚实践积累,团队深刻认识到国内企业在使用 Elasticsearch 时普遍面临以下痛点:

- 开源协议变化带来的商业风险 —— Elastic 于 2021 年将许可更改为 SSPL,导致社区分裂,增加了企业在合规和商用上的不确定性;

- 高并发与高可靠性场景下对稳定可控方案的需求 —— 企业级应用亟需一个性能可靠、可深度优化的搜索基础设施;

- 技术栈自主可控的迫切需求 —— 随着国产化进程加快,国内生态中缺乏轻量化、易部署、且完全可控的搜索引擎产品;

- 本地化服务与快速响应能力的缺口 —— 国内企业更需要本地团队提供高效的技术支持与服务,对本土化、个性化功能需求能得到及时响应与反馈。

基于这些考虑,Easysearch 在设计之初就明确了目标:构建一款兼容 Elasticsearch API、简洁易用、性能出众且完全自主可控的国产搜索引擎。

核心特性

- 轻量级:安装包大小不到 60 MB,安装部署简洁,资源占用低,开箱即用;

- 跨平台:支持主流操作系统和 CPU 架构,支持国产信创运行环境;

- 高性能:针对不同场景进行的极致优化,可用更少硬件成本获得更高服务性能,降本增效。

- 稳定可靠:修复大量内核问题,解决内存泄露,集群卡顿、查询缓慢等问题,久经严苛业务环境考验。

- 安全增强:默认就提供完整的企业级安全功能,支持 LDAP/AD 集成,支持索引、文档、字段粒度细权管控。

- 兼容性强:兼容 Elasticsearch 7.x 的 REST API 和数据格式,迁移成本低;

- 可视化运维:无需 Kibana 即可通过内置 Web UI 插件界面管理索引、节点与监控指标等。

对比优势

| 对比维度 | Easysearch | Elasticsearch | OpenSearch |

|---|---|---|---|

| 用户协议 | 社区免费+商业授权 | SSPL/AGPL v3 | Apache 2.0 |

| API 兼容性 | 高度兼容 ES | 原生 | 高度兼容 ES |

| 最小安装体积 | 57MB | 482MB | 682MB |

| 部署复杂度 | 简单 | 中等 | 相对复杂 |

| 信创环境支持 | 全面兼容 | 无 | 无 |

| 可视化管理 | 开箱即用管理后台 | 需独立部署 Kibana | 需独立部署 OpenSearch Dashboards |

| 本地化与中文支持 | 强 | 弱 | 弱 |

| AI 插件支持 | 较弱 | 强 | 较强 |

| 社区与生态 | 快速成长中 | 成熟广泛 | 活跃增长 |

快速开始:5 分钟体验 Easysearch

1. 使用 Docker 启动

# 直接运行镜像使用随机密码(数据及配置未持久化)

docker run --name easysearch \

--ulimit memlock=-1:-1 \

-p 9200:9200 \

infinilabs/easysearch:1.15.42. 验证集群状态

curl -ku "username:password" -X GET "https://localhost:9200/"返回结果示例:

{

"name": "easysearch-node",

"cluster_name": "easysearch-6yhwn91v80gf",

"cluster_uuid": "Gfu_fuF1QViJfeUWVbiFCA",

"version": {

"distribution": "easysearch",

"number": "1.15.4",

"distributor": "INFINI Labs",

"build_hash": "9110128946b0af3de639966cfa74b5498346949d",

"build_date": "2025-10-14T03:30:41.948590Z",

"build_snapshot": false,

"lucene_version": "8.11.4",

"minimum_wire_lucene_version": "7.7.0",

"minimum_lucene_index_compatibility_version": "7.7.0"

},

"tagline": "You Know, For Easy Search!"

}3. 索引与搜索示例

# 写入文档

curl -ku "username:password" -X POST "https://localhost:9200/my_index/_doc" -H 'Content-Type: application/json' -d'

{

"title": "Easysearch 入门",

"content": "这是一个轻量级搜索引擎的示例文档。",

"tags": ["搜索", "国产", "轻量级"]

}'

# 搜索文档

curl -ku "username:password" -X GET "https://localhost:9200/my_index/_search" -H 'Content-Type: application/json' -d'

{

"query": {

"match": {

"content": "搜索引擎"

}

}

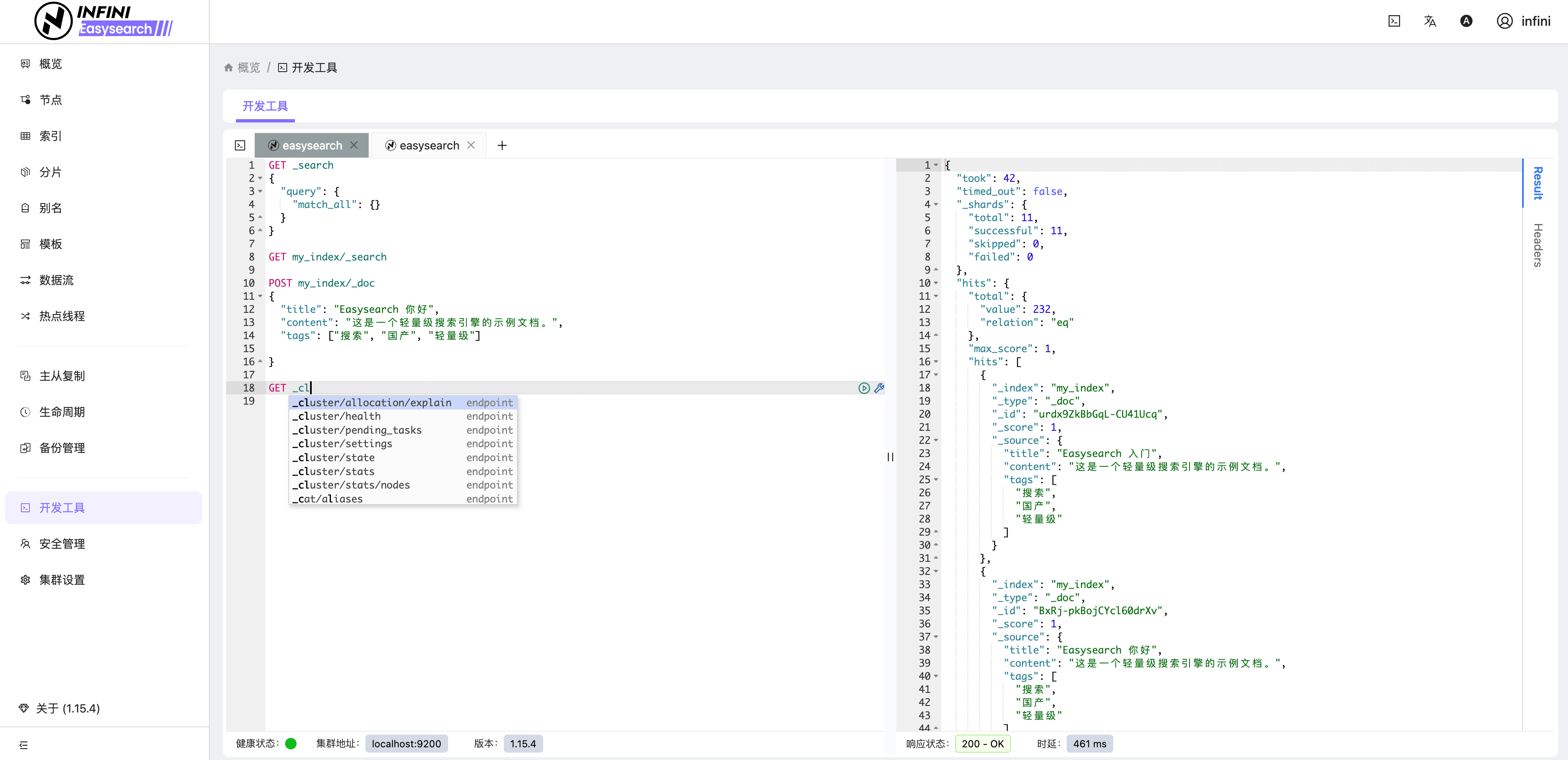

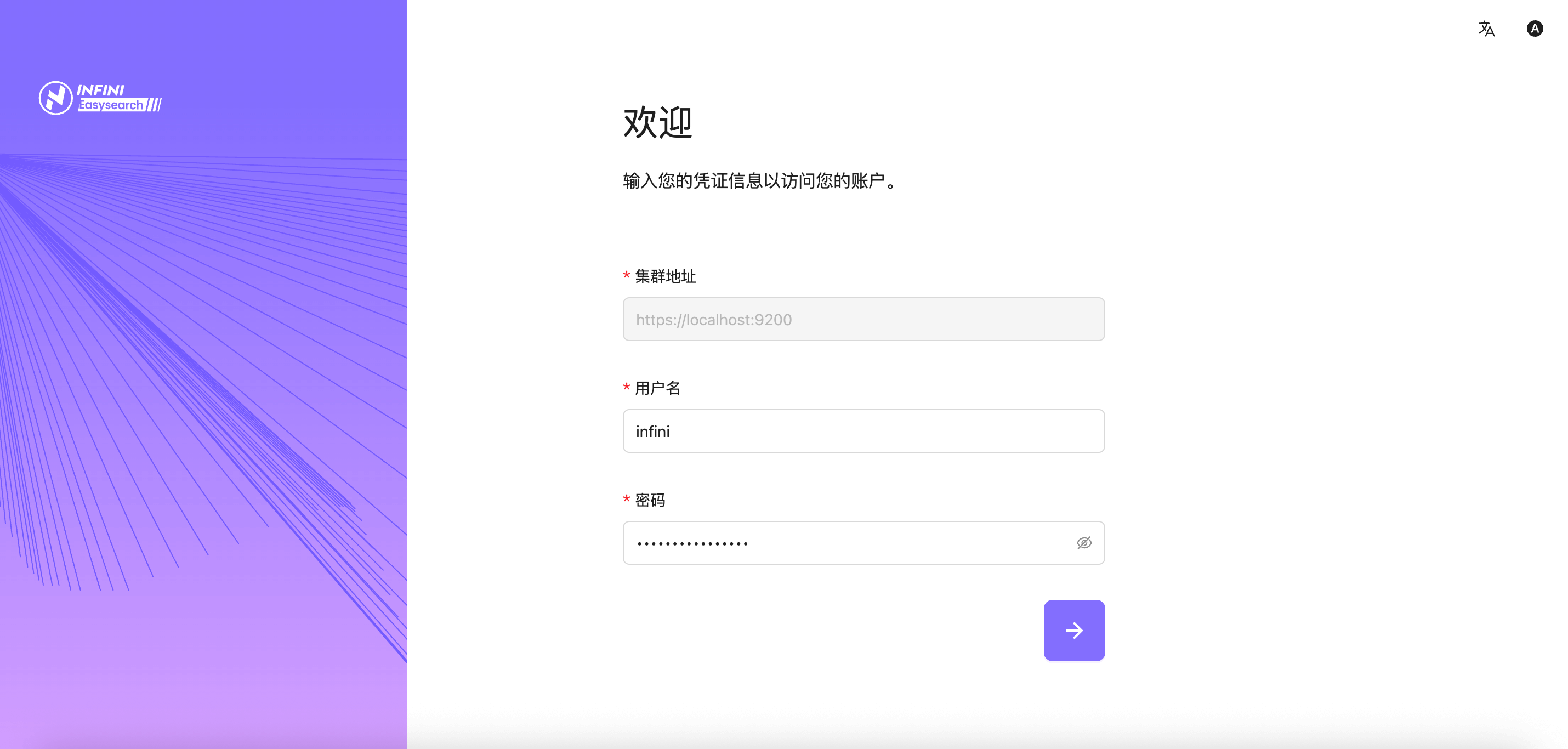

}'4. 使用 Easysearch UI

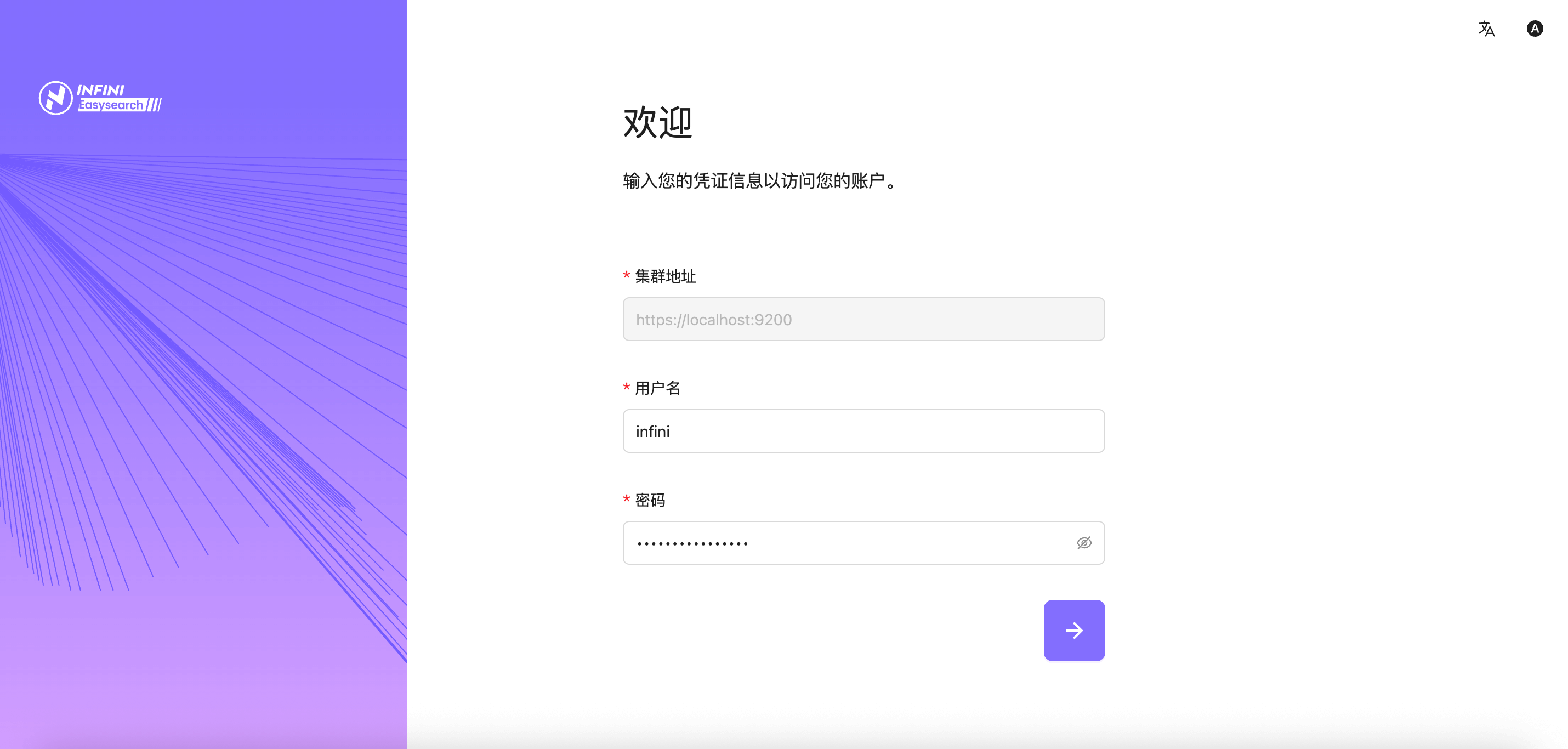

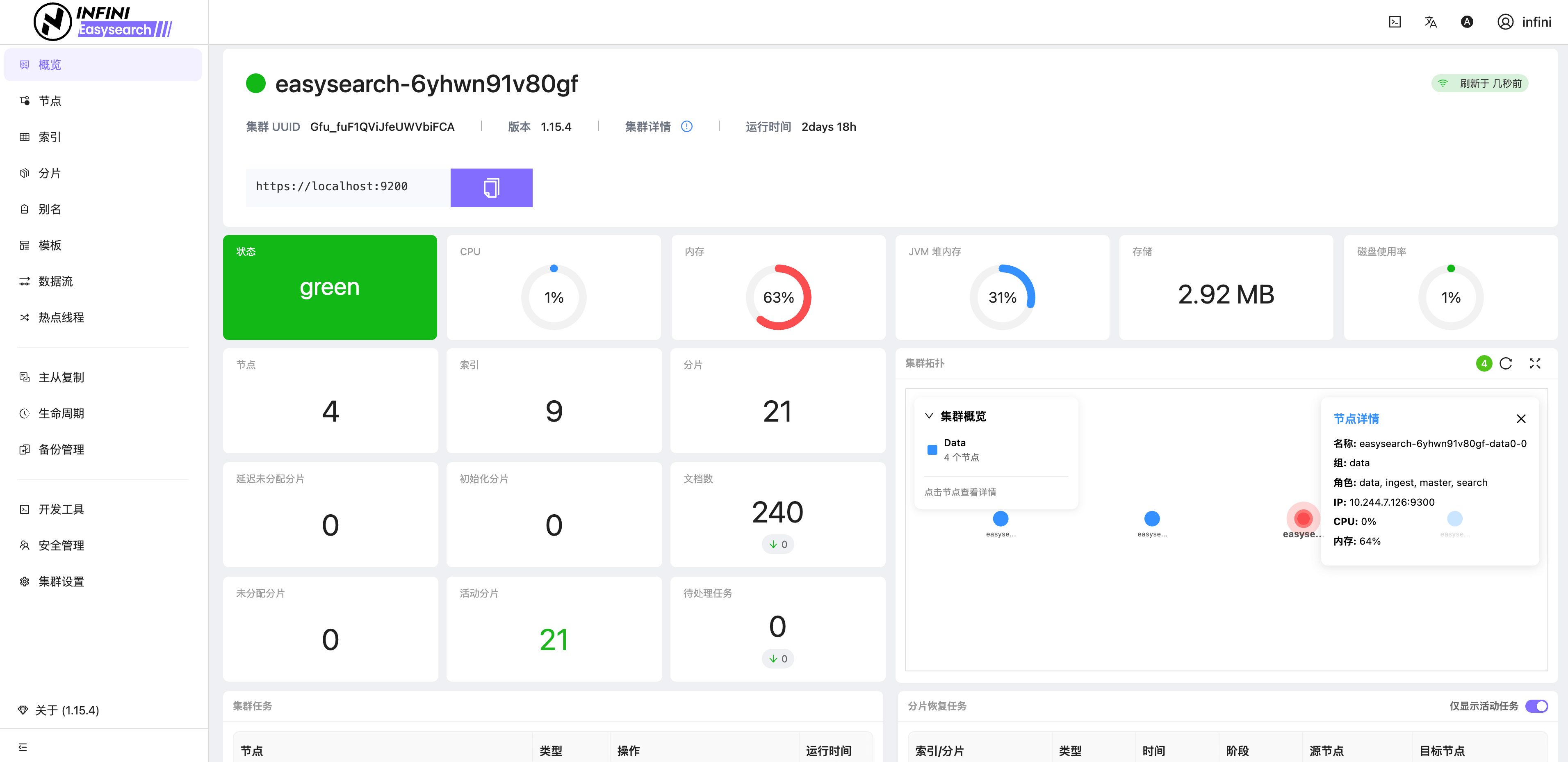

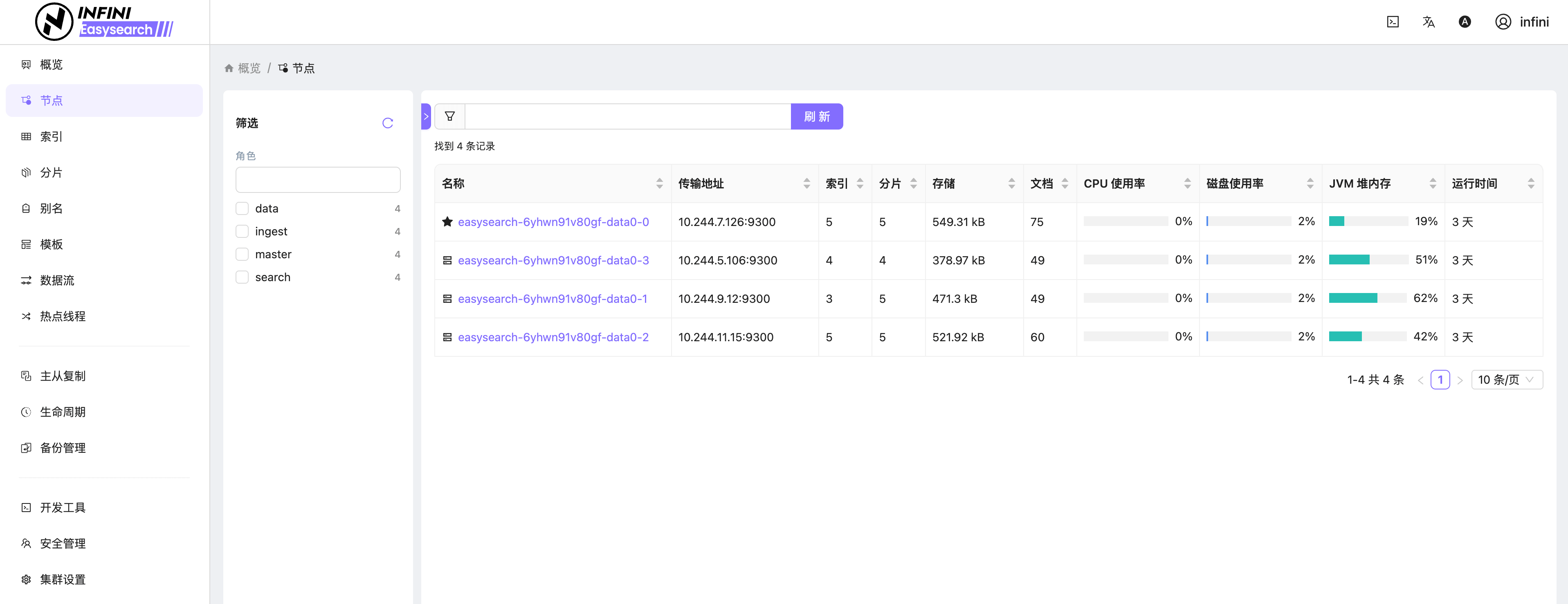

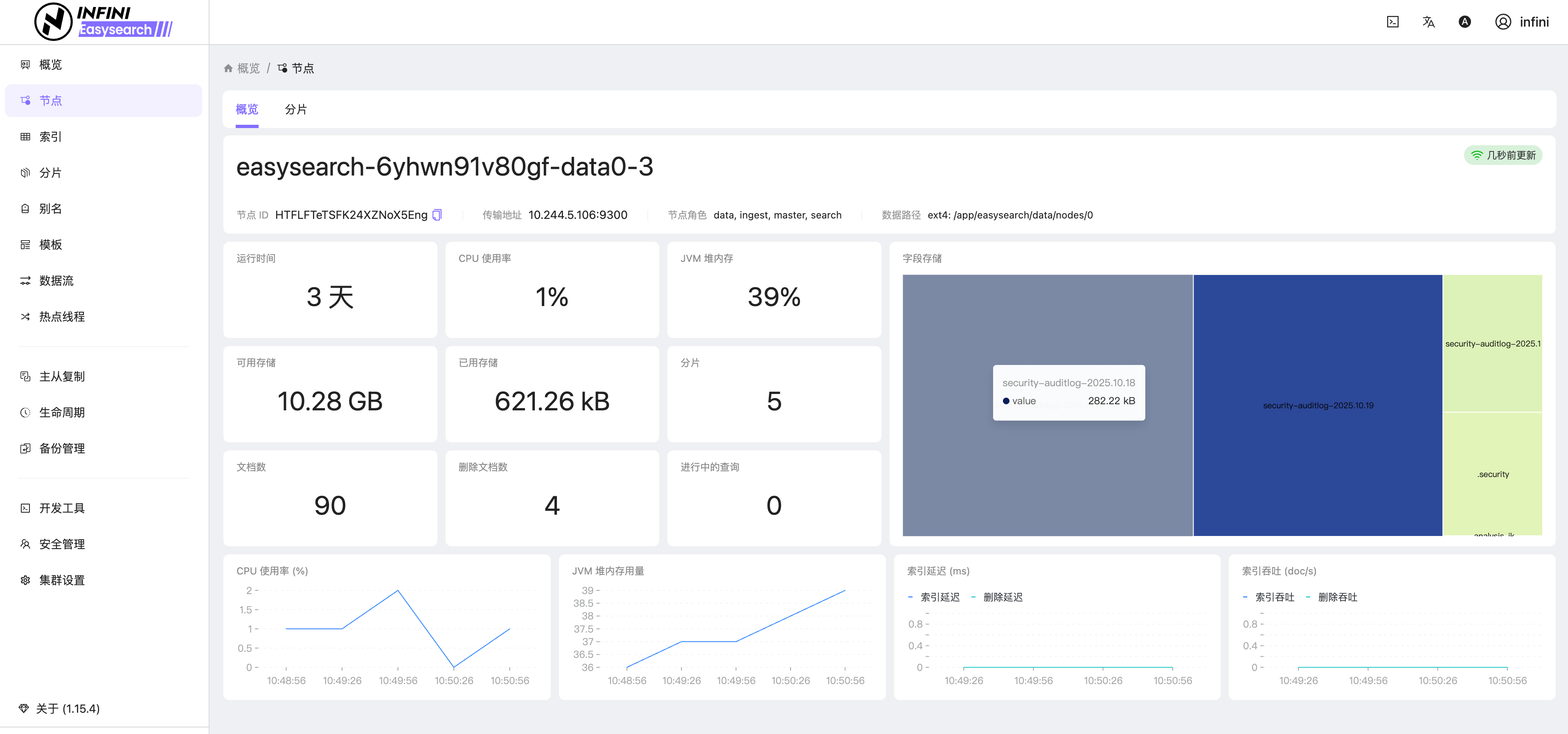

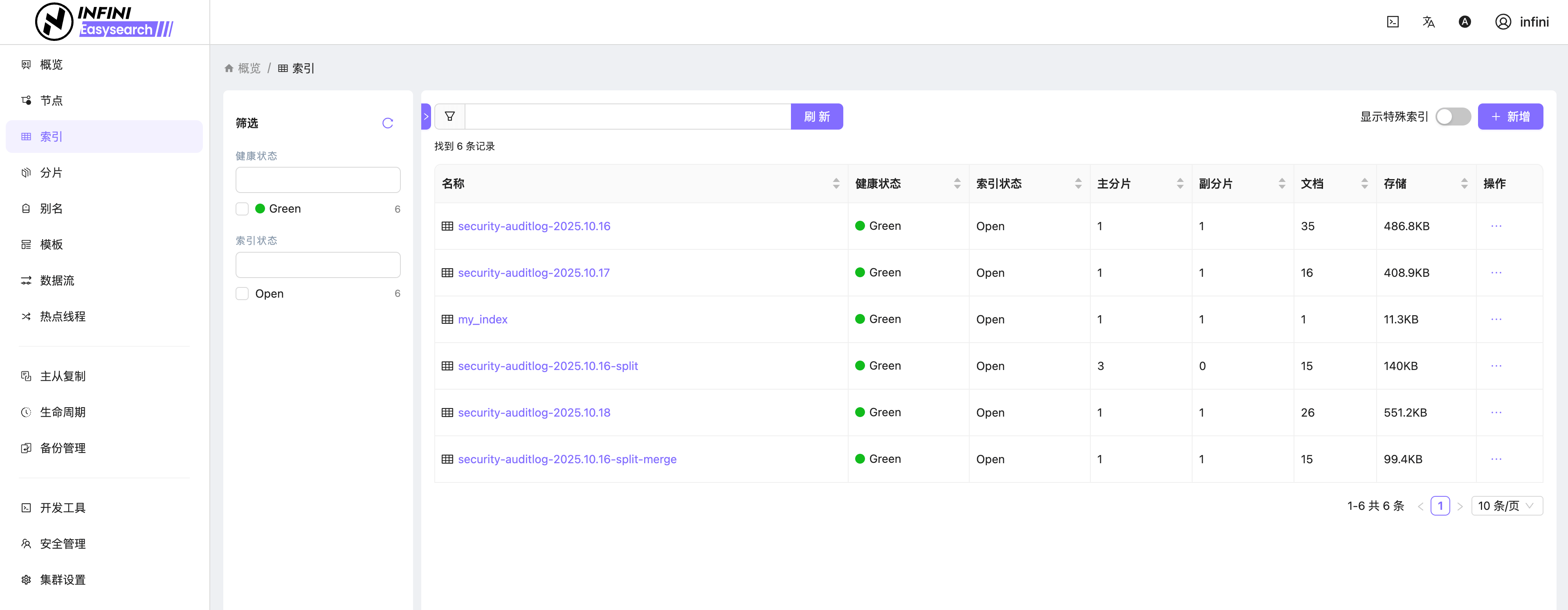

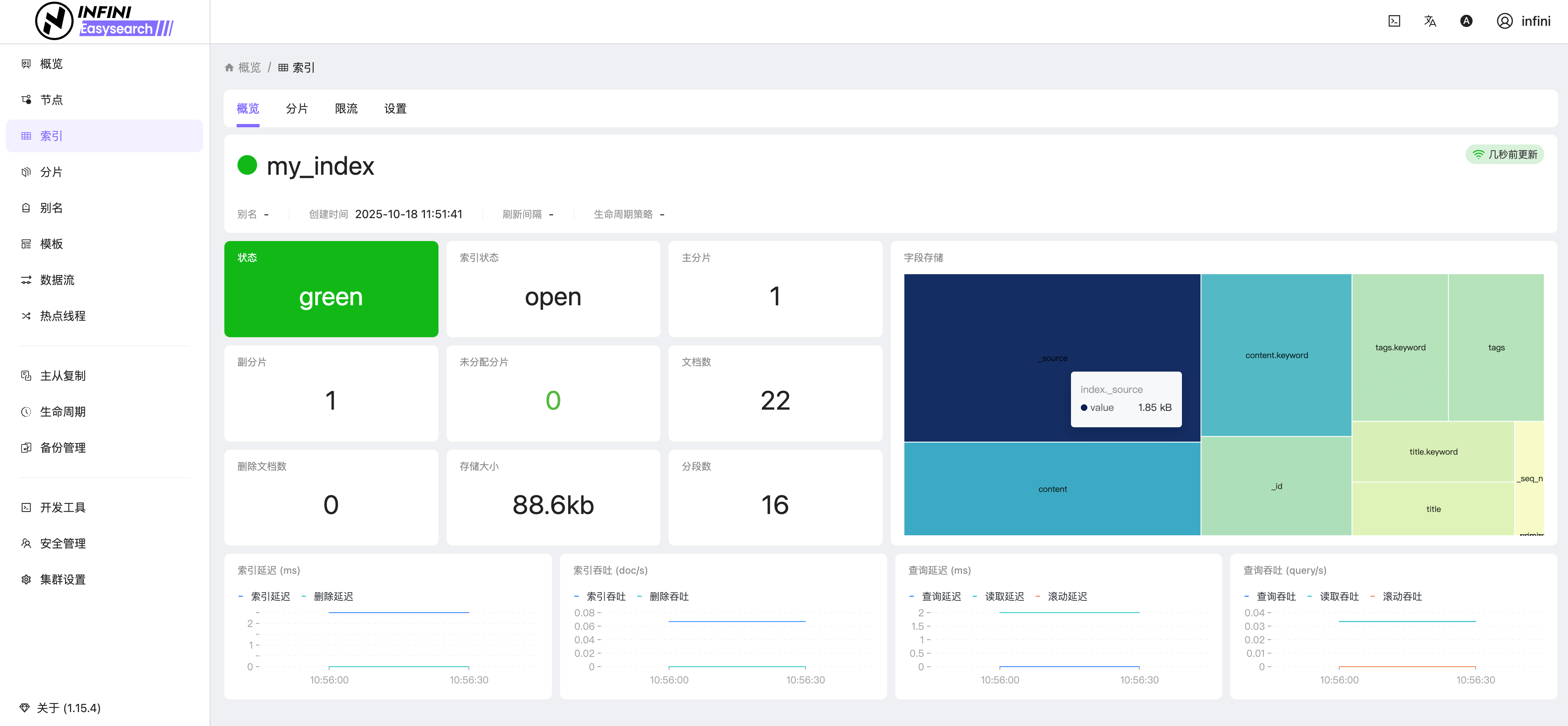

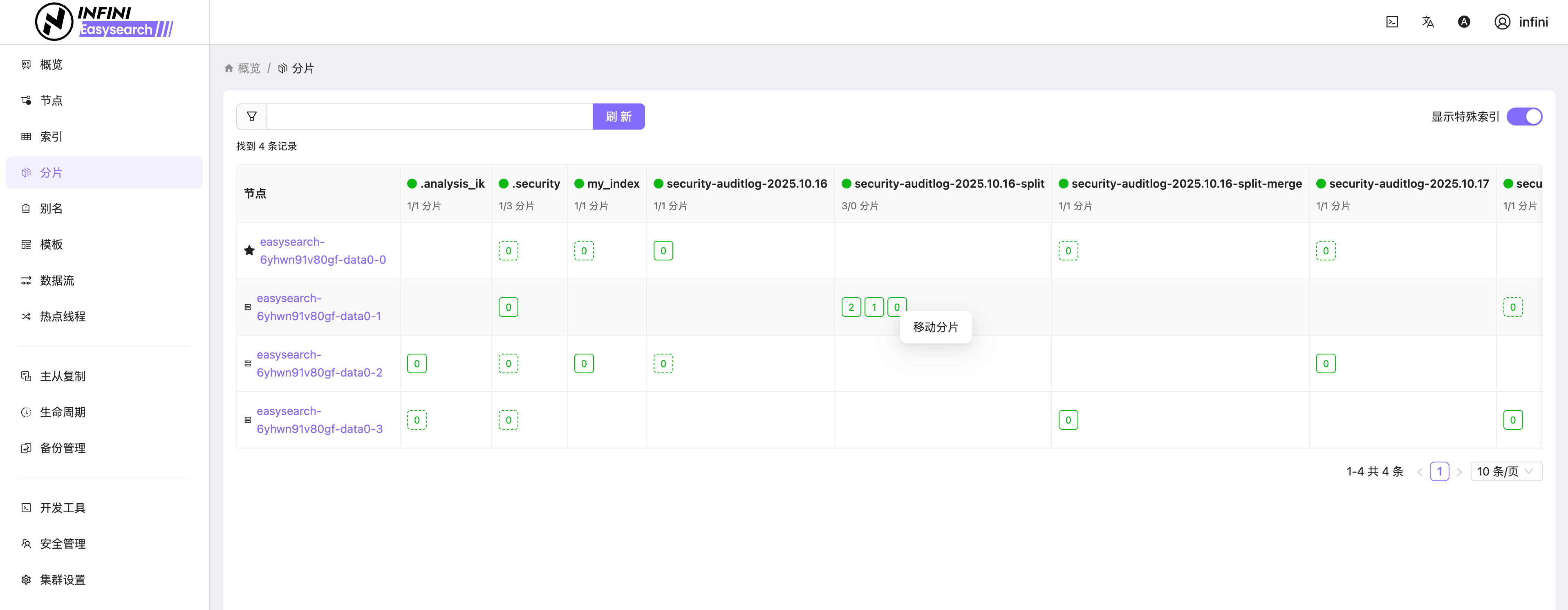

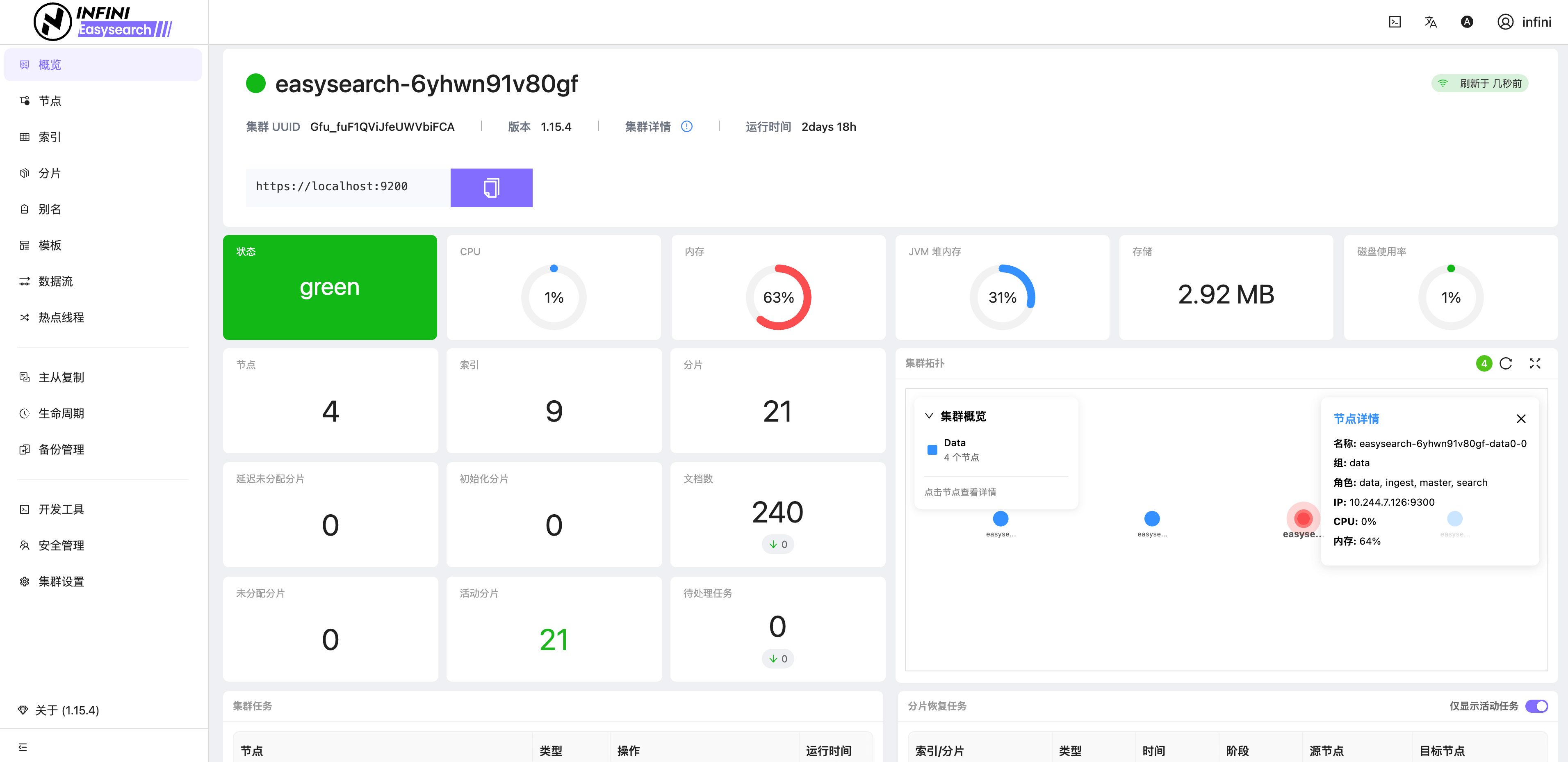

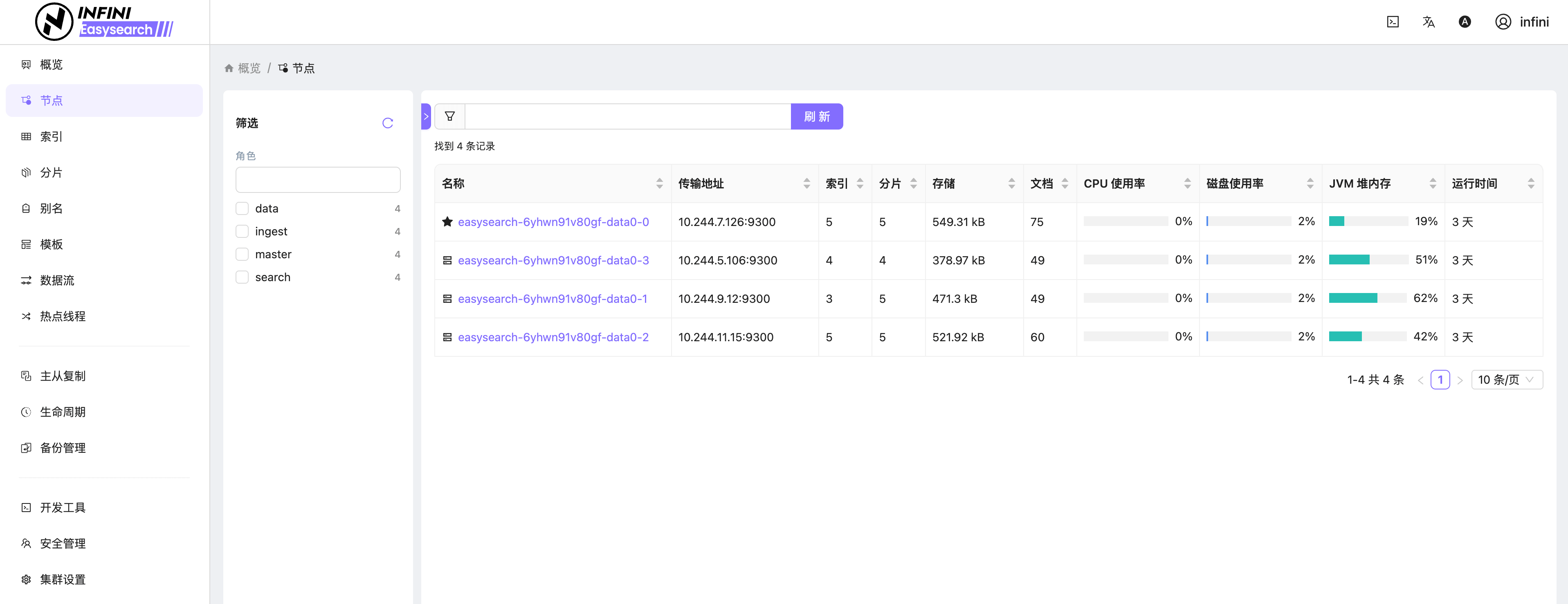

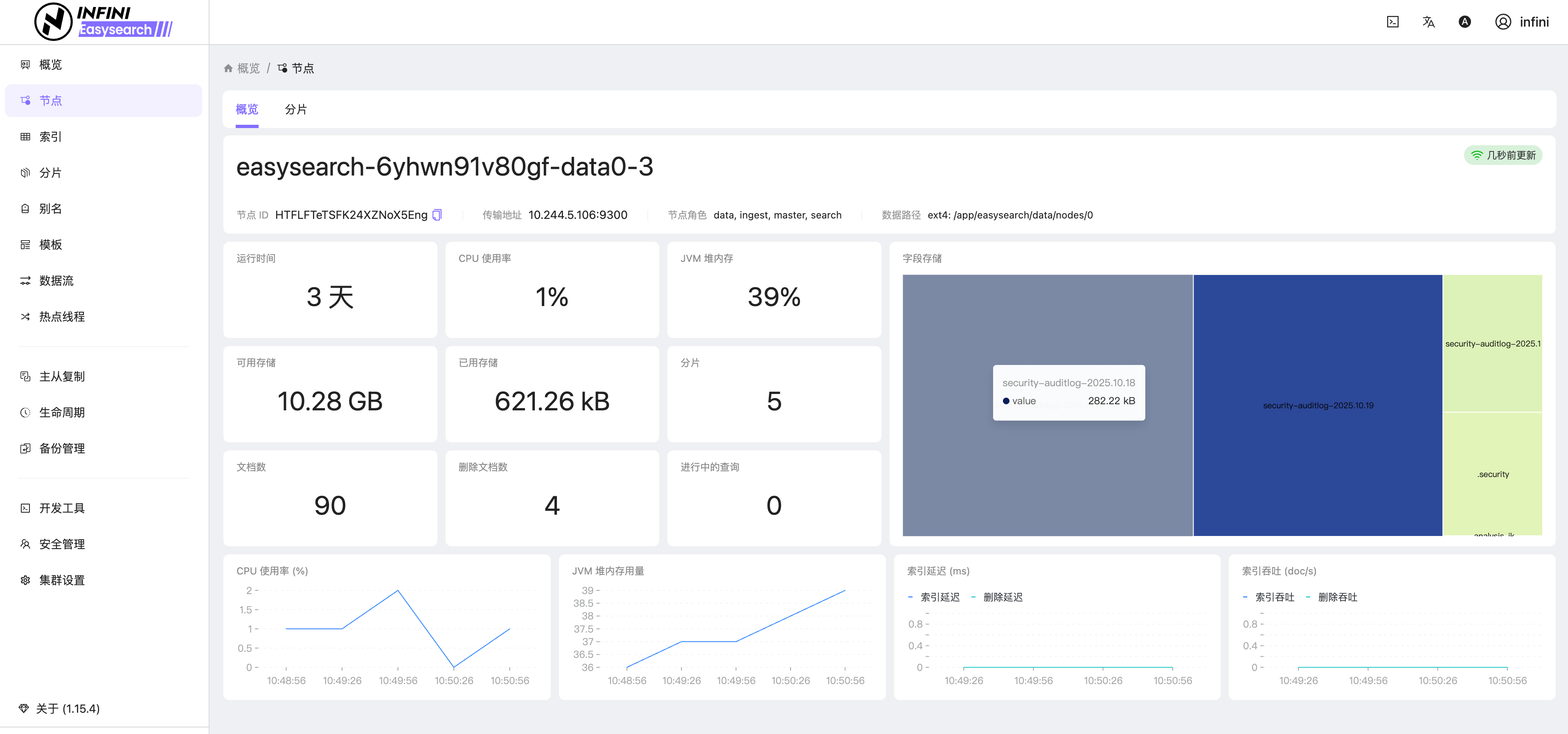

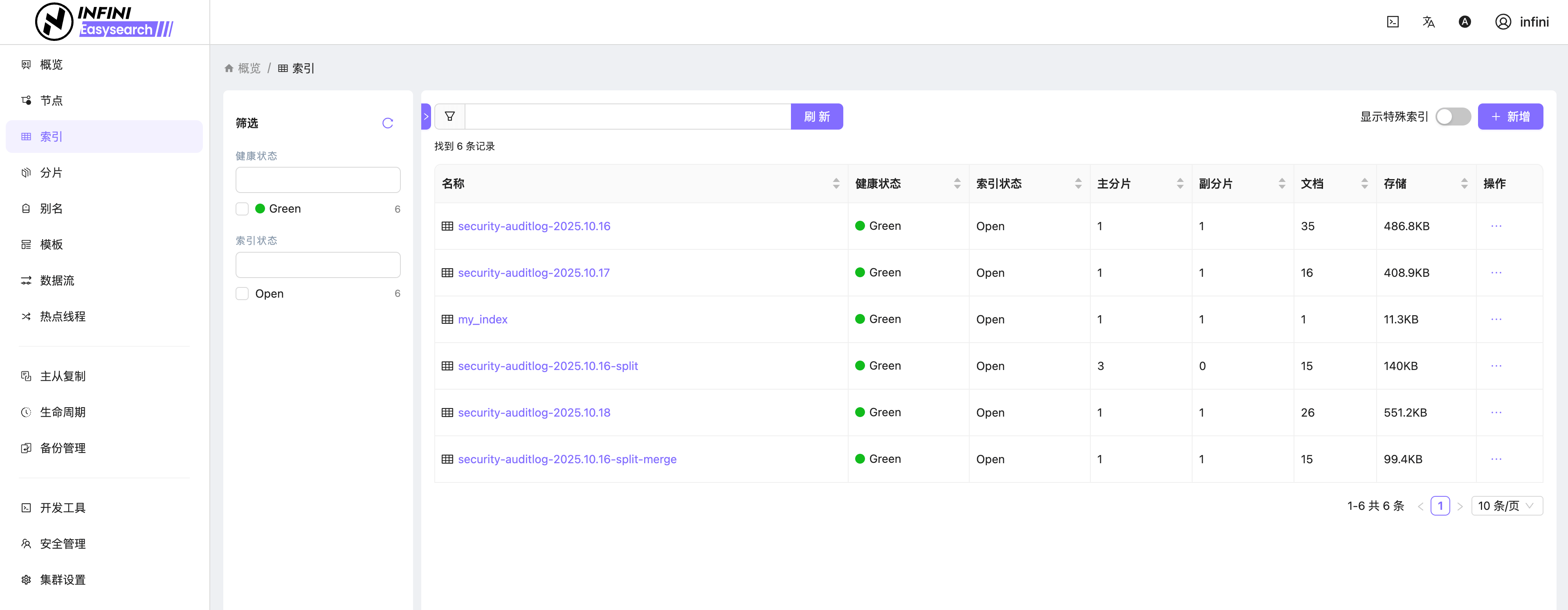

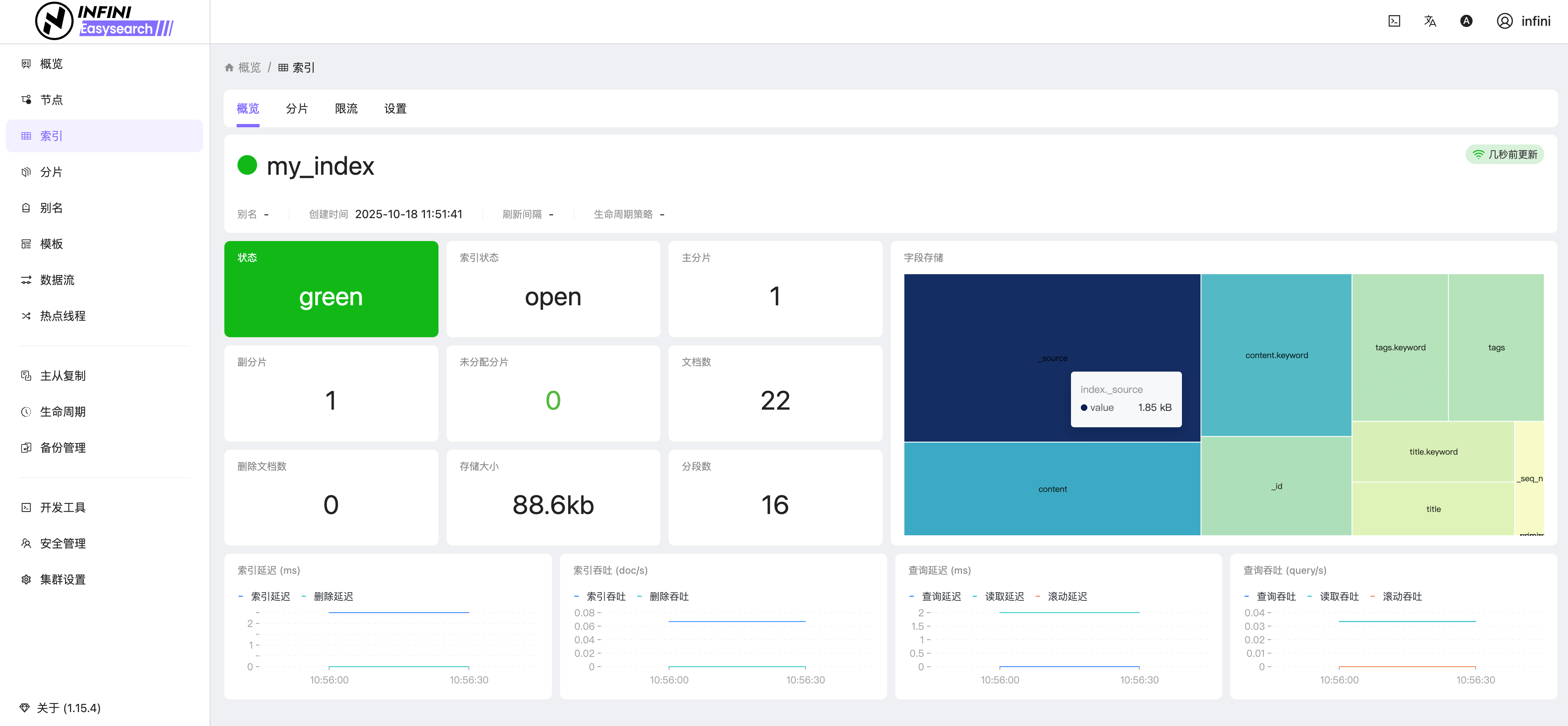

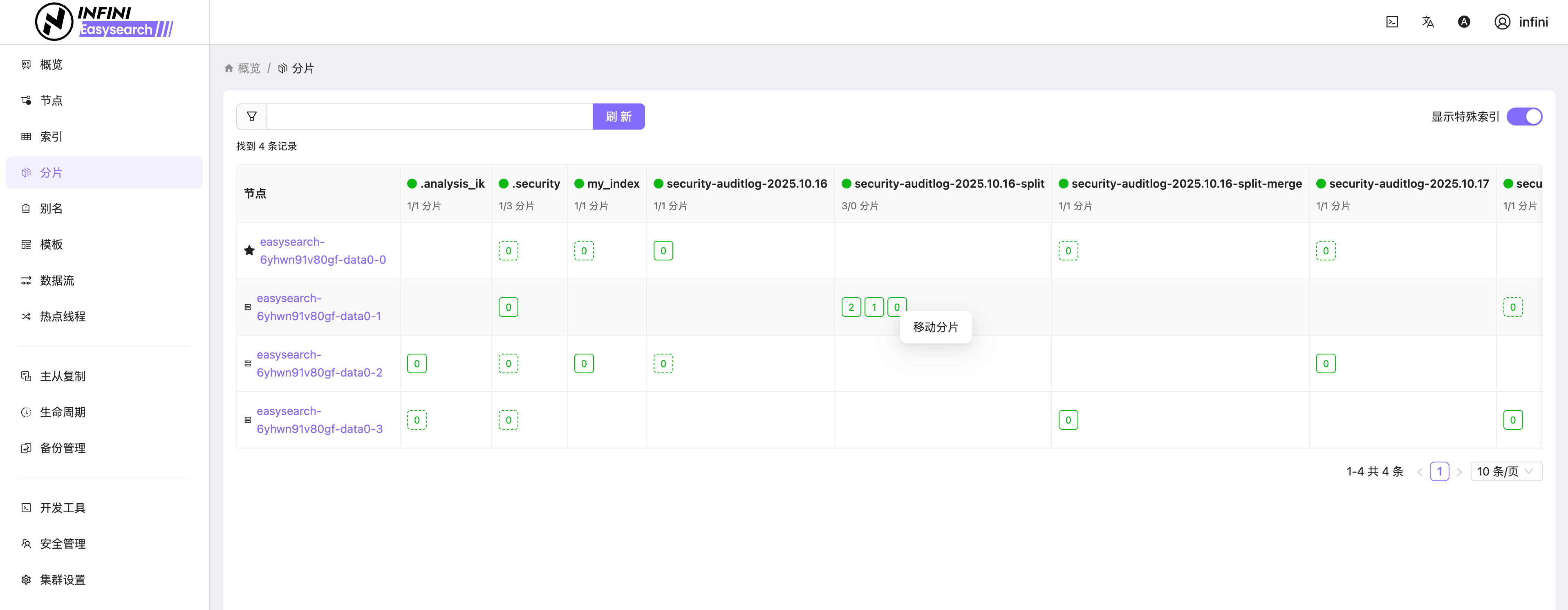

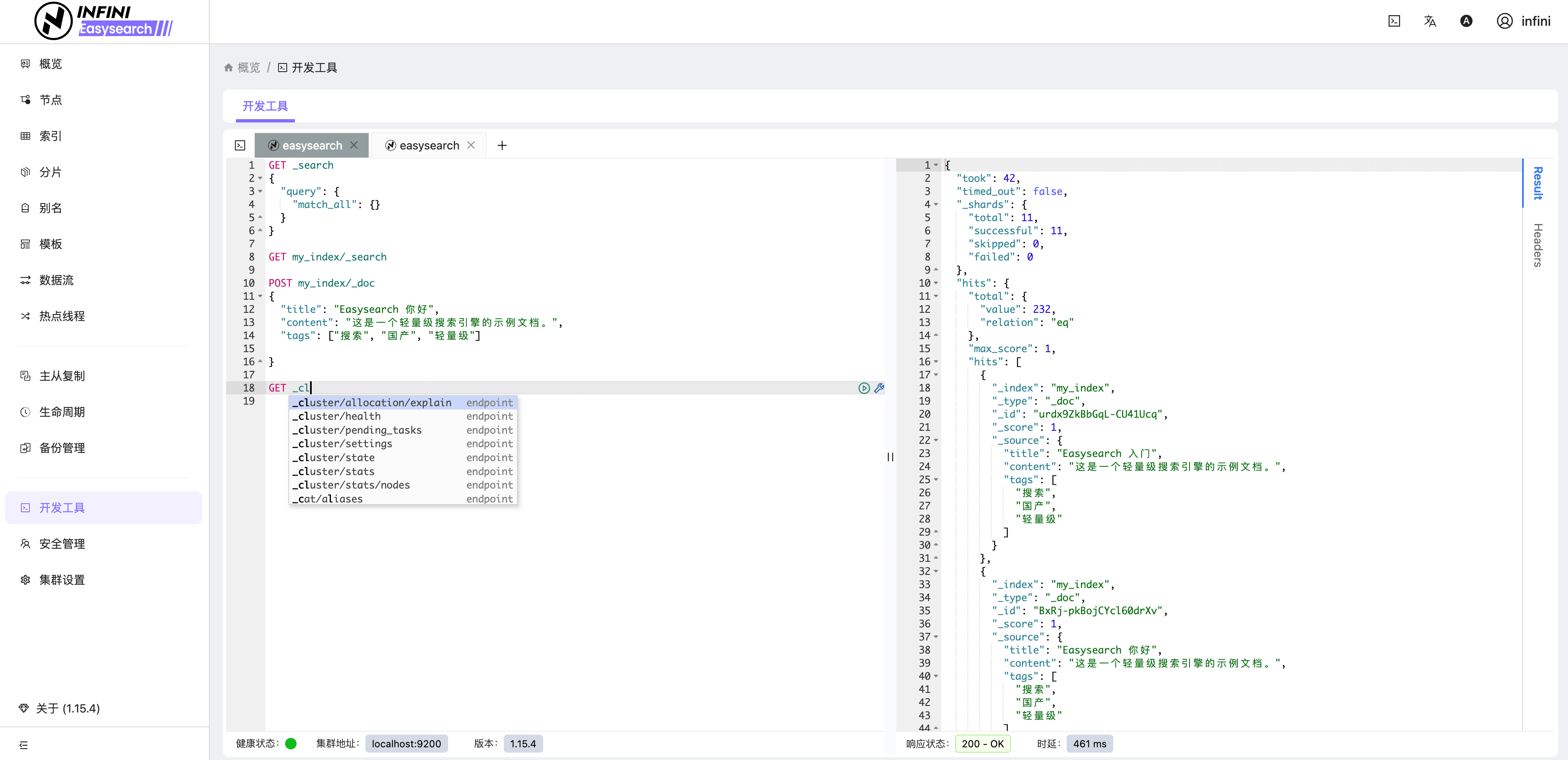

Easysearch 提供了轻量级界面化管理功能,不再依赖第三方组件即可对集群进行管理,真正做到开箱即用。如果你安装了 Easysearch UI 插件或者下载捆绑包,可通过 https://localhost:9200/\_ui/ 访问,进行节点、索引、分片、查询调试和监控查看等管理。

图 1:系统登录

图 2:集群概览

图 3:节点列表

图 4:节点概览

图 5:索引列表

图 6:索引概览

图 7:分片管理

图 8:开发工具

以上仅列出了一些基本功能,其他如安全管理、主从复制、备份管理、生命周期管理等更多高级功能由于篇幅限制不一一展示,有兴趣的朋友可自行部署探索。

结语

Easysearch 的诞生,不仅填补了国产搜索引擎在分布式与轻量化领域的空白,也让更多企业在面对开源协议变动与外部技术依赖时,拥有了更加安全、灵活、可控的选择。

它既是国产替代方案的有力代表,更是新一代搜索技术生态的积极探索者,为企业级实时搜索与分析带来新的可能。

🚀 下期预告

下一篇我们将介绍 一款 AI 驱动的现代搜索引擎 - Meilisearch,基于 Rust 构建的开源搜索引擎,性能高、部署简单。号称比 Elasticsearch 快 10 倍,真的这么牛吗?

💬 三连互动

- 你是否在使用或考虑国产搜索替代方案?

- 在实际项目中,你最看重搜索引擎的哪些特性?(性能、兼容性、运维、成本)

- 对 Easysearch 有什么功能上的期待?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

- 搜索百科(4):OpenSearch — 开源搜索的新选择

- 搜索百科(3):Elasticsearch — 搜索界的"流量明星"

- 搜索百科(2):Apache Solr — 企业级搜索的开源先锋

- 搜索百科(1):Lucene — 打开现代搜索世界的第一扇门

🔗 参考资源

原文:https://infinilabs.cn/blog/2025/search-wiki-5-easysearch/

【搜索客社区日报】第2130期 (2025-10-20)

社区日报 • Muses 发表了文章 • 0 个评论 • 6542 次浏览 • 2025-10-20 14:45

【搜索客社区日报】第2123期 (2025-09-29)

社区日报 • Muses 发表了文章 • 0 个评论 • 10181 次浏览 • 2025-09-29 15:18

【搜索客社区日报】第2119期 (2025-09-22)

社区日报 • Muses 发表了文章 • 0 个评论 • 12165 次浏览 • 2025-09-22 13:44

招聘!搜索运维工程师(Elasticsearch/Easysearch)-全职/北京/12-20K

求职招聘 • INFINI Labs 小助手 发表了文章 • 0 个评论 • 10597 次浏览 • 2025-09-22 12:33

极限科技诚招全职搜索运维工程师(Elasticsearch/Easysearch)!

欢迎搜索技术热爱者加入我们,共同打造高效、智能的搜索解决方案!

在招岗位介绍

岗位名称

搜索运维工程师(Elasticsearch/Easysearch)

Base:北京

薪资待遇:12-20K,五险一金,双休等

岗位职责

- 负责客户现场的 Elasticsearch/Easysearch/OpenSearch 搜索引擎集群的日常维护、监控和优化,确保集群的高可用性和性能稳定;

- 协助客户进行搜索引擎集群的部署、配置及版本升级;

- 排查和解决 Elasticsearch/Easysearch/OpenSearch 集群中的各种技术问题,及时响应并处理集群异常;

- 根据业务需求设计和实施搜索索引的调优、数据迁移和扩展方案;

- 负责与客户沟通,提供技术支持及相关培训,确保客户需求得到有效满足;

- 制定并实施搜索引擎的备份、恢复和安全策略,保障数据安全;

- 与内部研发团队和外部客户进行协作,推动集群性能改进和功能优化。

岗位要求

- 全日制本科及以上学历,2 年以上运维工作经验;

- 拥有 Elasticsearch/Easysearch/OpenSearch 使用经验,熟悉搜索引擎的原理、架构和相关生态工具(如 Logstash、Kibana 等);

- 熟悉 Linux 操作系统的使用及常见性能调优方法;

- 熟练掌握 Shell 或 Python 等至少一种脚本语言,能够编写自动化运维脚本;

- 具有优秀的问题分析与解决能力,能够快速应对突发情况;

- 具备良好的沟通能力和团队合作精神,能够接受客户驻场工作;

- 提供 五险一金,享有带薪年假及法定节假日。

加分项

- 计算机科学、信息技术或相关专业;

- 具备丰富的大规模分布式系统运维经验;

- 熟悉 Elasticsearch/Easysearch/OpenSearch 分片、路由、查询优化等高级功能;

- 拥有 Elastic Certified Engineer 认证;

- 具备大规模搜索引擎集群设计、扩展和调优经验;

- 熟悉其他搜索引擎技术(如 Solr、Lucene)者优先;

- 熟悉大数据处理相关技术(比如: Kafka 、Flink 等)者优先。

简历投递

- 邮件:hello@infini.ltd(邮件标题请备注姓名 求职岗位)

- 微信:INFINI-Labs (加微请备注求职岗位)

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

我们在做什么

极限科技(INFINI Labs)正在致力于以下几个核心方向:

1、开发近实时搜索引擎 INFINI Easysearch INFINI Easysearch 是一个分布式的搜索型数据库,实现非结构化数据检索、全文检索、向量检索、地理位置信息查询、组合索引查询、多语种支持、聚合分析等。Easysearch 可以替代 Elasticsearch,同时添加和完善多项企业级功能。Easysearch 助您拥有简洁、高效、易用的搜索体验。详情参见:https://infinilabs.cn

2、打造下一代实时搜索引擎 INFINI Pizza INFINI Pizza 是一个分布式混合搜索数据库系统。我们的使命是充分利用现代硬件和人工智能的潜力,为企业提供量身定制的实时智能搜索体验。我们致力于满足具有挑战性的环境中高并发和高吞吐量的需求,同时提供无缝高效的搜索功能。详情参见:https://pizza.rs

3、为现代团队打造的统一搜索与 AI 智能助手 Coco AI Coco AI 是一款完全开源的统一搜索与 AI 助手平台,它通过统一搜索入口,连接企业内外部的异构数据源,融合大模型能力,帮助团队高效访问知识,智能决策协作。详情参见:https://coco.rs

4、积极参与全球开源生态建设 通过开源 Coco AI、Console、Gateway、Agent、Loadgen 等搜索领域产品和社区贡献,推动全球开源技术的发展,提升中国在全球开源领域的影响力。INFINI Labs Github 主页:https://github.com/infinilabs

5、提供专业服务 为客户提供包括搜索技术支持、迁移服务、定制解决方案和培训在内的全方位服务。

6、提供国产化搜索解决方案 针对中国市场的特殊需求,提供符合国产化标准的搜索产品和解决方案,帮助客户解决使用 Elasticsearch 时遇到的挑战。

极限科技(INFINI Labs)通过这些努力,旨在成为全球领先的实时搜索和数据分析解决方案提供商。

如何使用极限网关实现 Elasticsearch 集群迁移至 Easysearch

Elasticsearch • INFINI Labs 小助手 发表了文章 • 0 个评论 • 15001 次浏览 • 2025-09-21 14:50

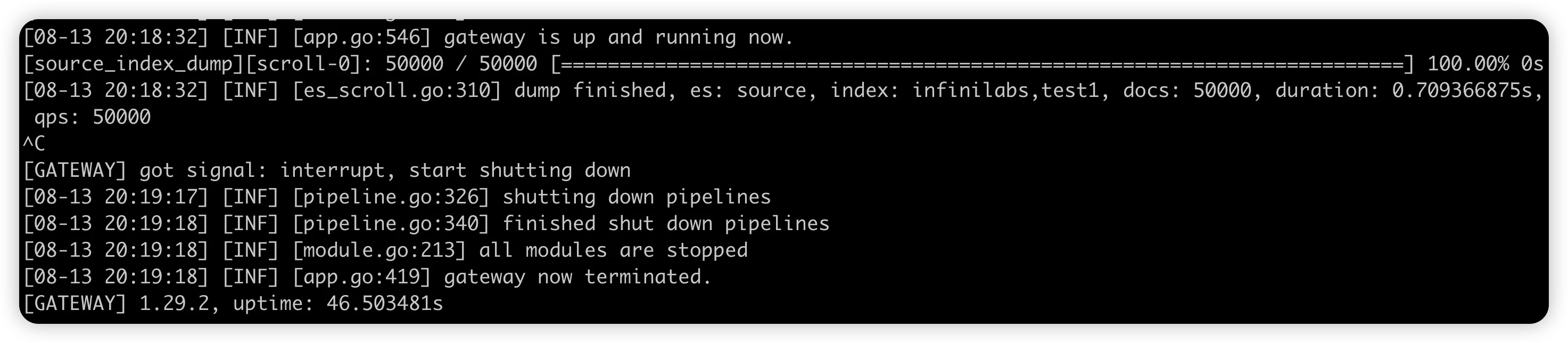

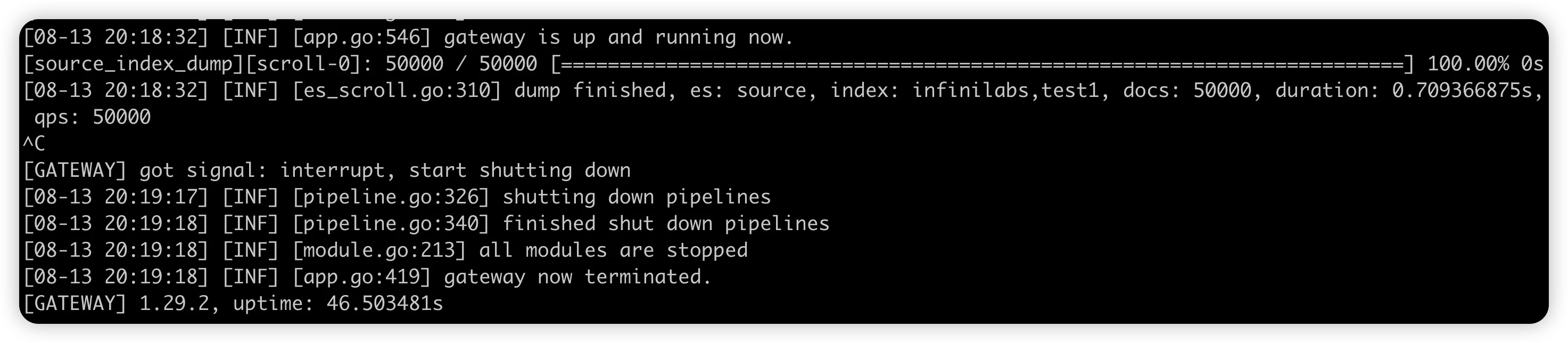

之前有博客介绍过通过 Reindex 的方法将 Elasticsearch 的数据迁移到 Easysearch 集群,今天再介绍一个方法,通过 极限网关(INFINI Gateway) 来进行数据迁移。

测试环境

| 软件 | 版本 |

|---|---|

| Easysearch | 1.12.0 |

| Elasticsearch | 7.17.29 |

| INFINI Gateway | 1.29.2 |

迁移步骤

- 选定要迁移的索引

- 在目标集群建立索引的 mapping 和 setting

- 准备 INFINI Gateway 迁移配置

- 运行 INFINI Gateway 进行数据迁移

迁移实战

- 选定要迁移的索引

在 Elasticsearch 集群中选择目标索引:infinilabs 和 test1,没错,我们一次可以迁移多个。

- 在 Easysearch 集群使用源索引的 setting 和 mapping 建立目标索引。(略)

- INFINI Gateway 迁移配置准备

去 github 下载配置,修改下面的连接集群的部分

1 env:

2 LR_GATEWAY_API_HOST: 127.0.0.1:2900

3 SRC_ELASTICSEARCH_ENDPOINT: http://127.0.0.1:9200

4 DST_ELASTICSEARCH_ENDPOINT: http://127.0.0.1:9201

5 path.data: data

6 path.logs: log

7 progress_bar.enabled: true

8 configs.auto_reload: true

9

10 api:

11 enabled: true

12 network:

13 binding: $[[env.LR_GATEWAY_API_HOST]]

14

15 elasticsearch:

16 - name: source

17 enabled: true

18 endpoint: $[[env.SRC_ELASTICSEARCH_ENDPOINT]]

19 basic_auth:

20 username: elastic

21 password: goodgoodstudy

22

23 - name: target

24 enabled: true

25 endpoint: $[[env.DST_ELASTICSEARCH_ENDPOINT]]

26 basic_auth:

27 username: admin

28 password: 14da41c79ad2d744b90cpipeline 部分修改要迁移的索引名称,我们迁移 infinilabs 和 test1 两个索引。

31 pipeline:

32 - name: source_scroll

33 auto_start: true

34 keep_running: false

35 processor:

36 - es_scroll:

37 slice_size: 1

38 batch_size: 5000

39 indices: "infinilabs,test1"

40 elasticsearch: source

41 output_queue: source_index_dump

42 partition_size: 1

43 scroll_time: "5m"- 迁移数据

./gateway-mac-arm64

#如果你保存的配置文件名称不叫 gateway.yml,则需要加参数 -config 文件名

数据导入完成后,网关 ctrl+c 退出。

至此,数据迁移就完成了。下一篇我们来介绍 INFINI Gateway 的数据比对功能。

有任何问题,欢迎加我微信沟通。

关于极限网关(INFINI Gateway)

INFINI Gateway 是一个开源的面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway,可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。

官网文档:https://docs.infinilabs.com/gateway

开源地址:https://github.com/infinilabs/gateway

搜索百科(4):OpenSearch — 开源搜索的新选择

OpenSearch • liaosy 发表了文章 • 0 个评论 • 9272 次浏览 • 2025-09-21 14:31

大家好,我是 INFINI Labs 的石阳。

欢迎关注 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

上一篇我们围观了 “流量明星” Elasticsearch — 从食谱搜索到 PB 级明星产品,从 Apache 2.0 到 SSPL 协议风波;今天我们来聊聊它的“分叉兄弟” OpenSearch。

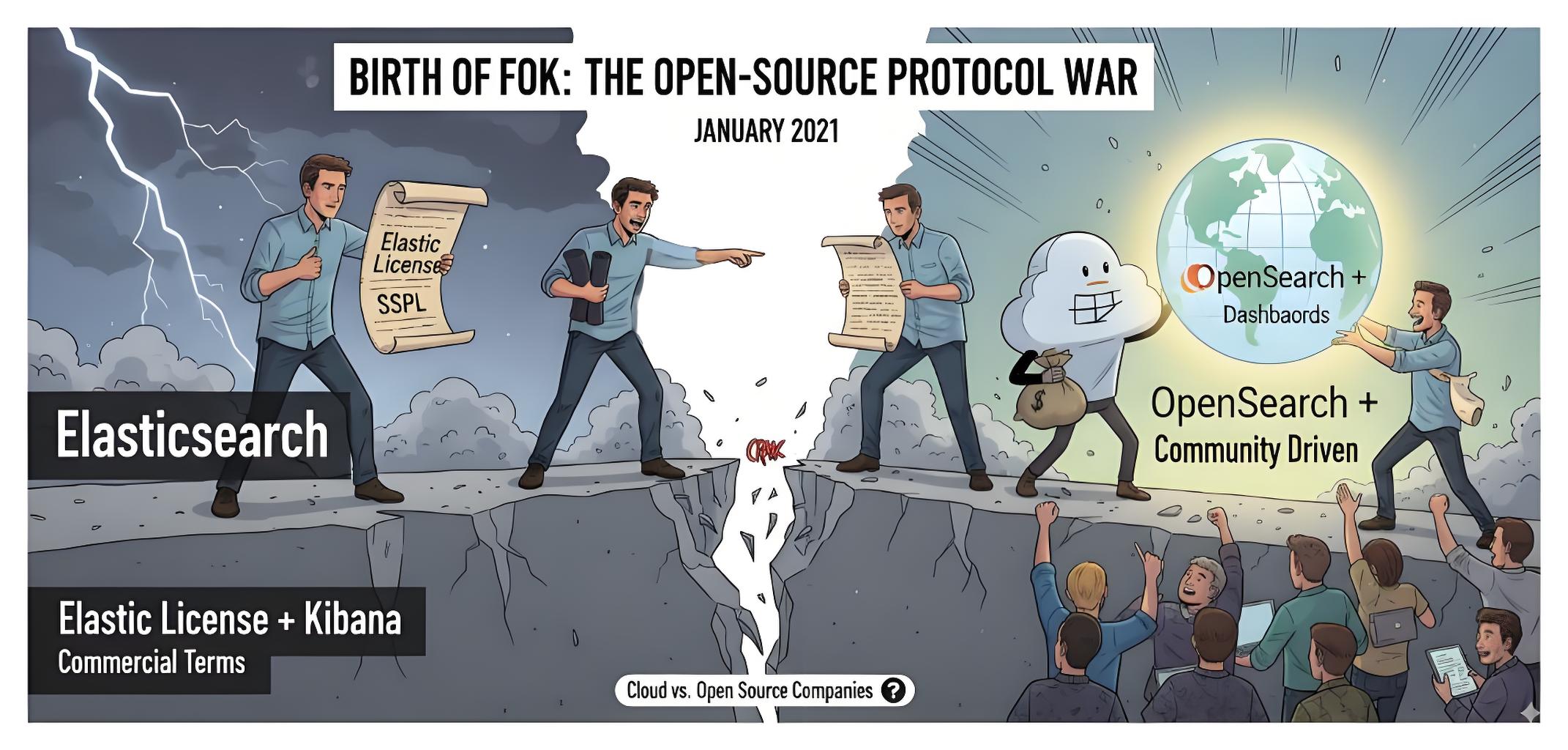

引言

2021 年,当 Elasticsearch 宣布将其许可证从 Apache 2.0 变更为 SSPL/Elastic License 时,整个搜索社区为之震动。这一变更直接催生了一个新的开源分支 — OpenSearch。这个由 AWS 主导的项目不仅在短短几年内迅速发展成熟,更成为了许多企业在云原生环境下搜索解决方案的新选择。

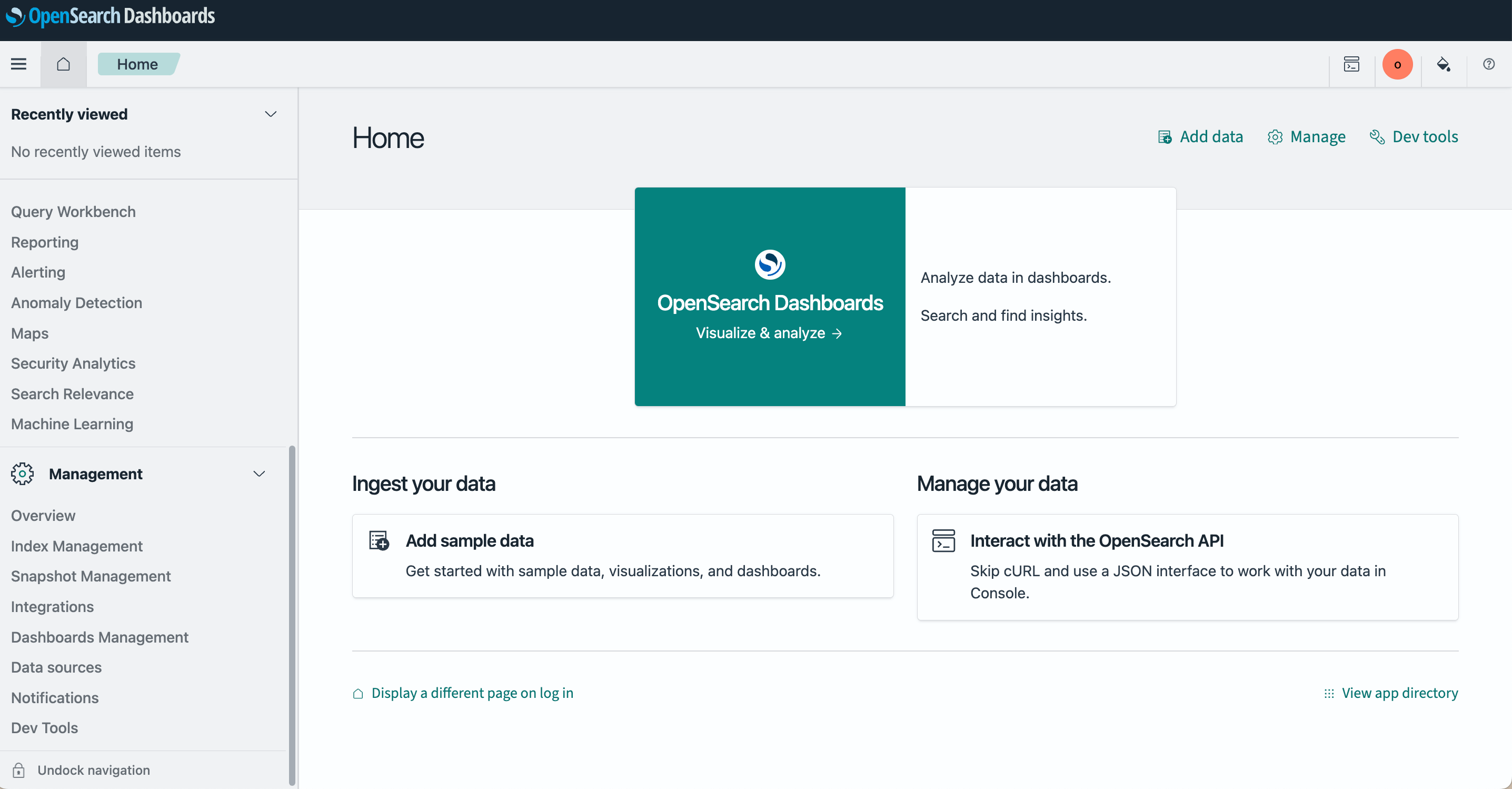

OpenSearch 概述

OpenSearch 是从 Elasticsearch 7.10.2 分支而来的开源搜索与分析套件,由 AWS 主导开发并贡献给开源社区。OpenSearch 包括 OpenSearch(搜索引擎)和 OpenSearch Dashboards(可视化界面),完全兼容 Apache 2.0 协议,旨在为用户提供一个真正开源、社区驱动的搜索与分析解决方案。

- 首次发布:2021 年 4 月

- 最新版本:3.2.0(截止 2025 年 9 月)

- 开源协议:Apache License 2.0

- 主导企业:Amazon Web Services (AWS)

- 官方网址:https://opensearch.org/

- GitHub 仓库:https://github.com/opensearch-project

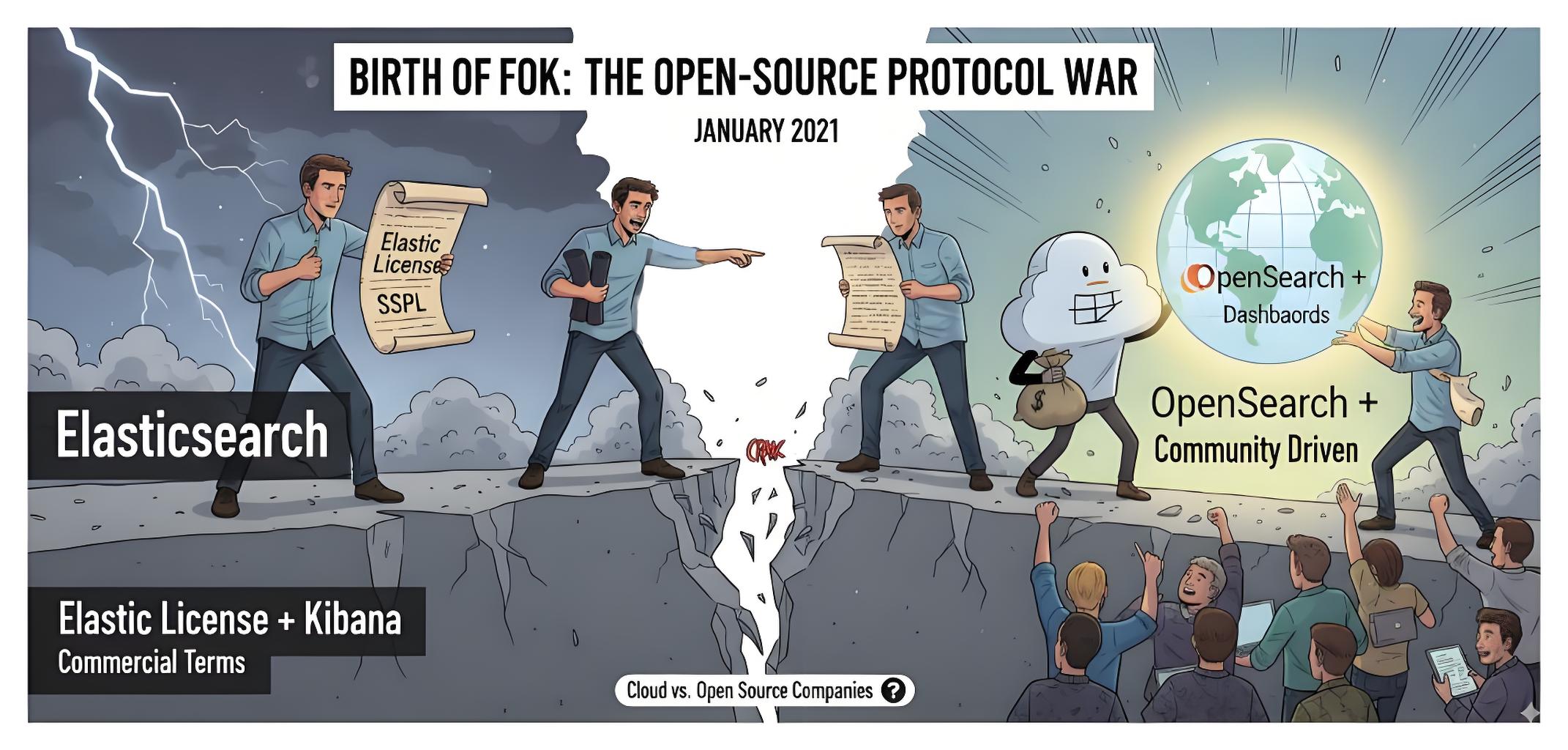

诞生故事:开源协议争议的产物

时间回到 2021 年 1 月,Elastic 公司宣布 Elasticsearch 从 7.11 版本起不再使用 Apache 2.0 协议,而改为 Elastic License 与 SSPL。这一决定立刻在社区和产业界引发巨大争议。

AWS(亚马逊云)作为 Elasticsearch 的重要用户与云服务提供商,不愿意被 Elastic 的商业条款所限制,随即牵头将 Elasticsearch 7.10 版本 fork 出来,并与 Kibana 一起重命名为 OpenSearch 与 OpenSearch Dashboards。

从此,开源世界分裂成了两条路线:

- Elastic 官方的 Elasticsearch + Kibana(带有商业许可)。

- 社区驱动的 OpenSearch + OpenSearch Dashboards(继续遵循 Apache 2.0 协议)。

这个分叉,既是开源协议之争的产物,也是云厂商与开源公司之间博弈的缩影。虽然初期被质疑过“是否真开源”,但经过数年的迭代,OpenSearch 已形成了相对独立的开发节奏和用户群体,插件和生态也逐渐丰富。

技术架构与特性

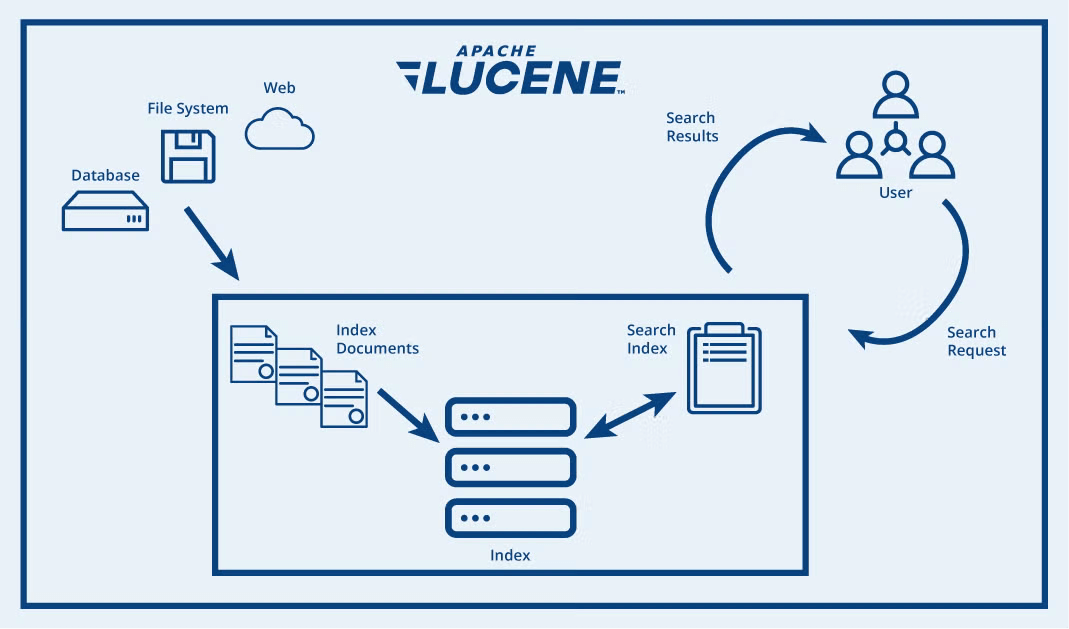

OpenSearch 是一个基于 Apache Lucene 的分布式搜索与分析引擎。在将数据添加到 OpenSearch 后,可以对其执行各种功能完备的全文搜索操作:按字段搜索、跨多个索引搜索、提升字段权重、按得分排序结果、按字段排序结果以及对结果进行聚合。

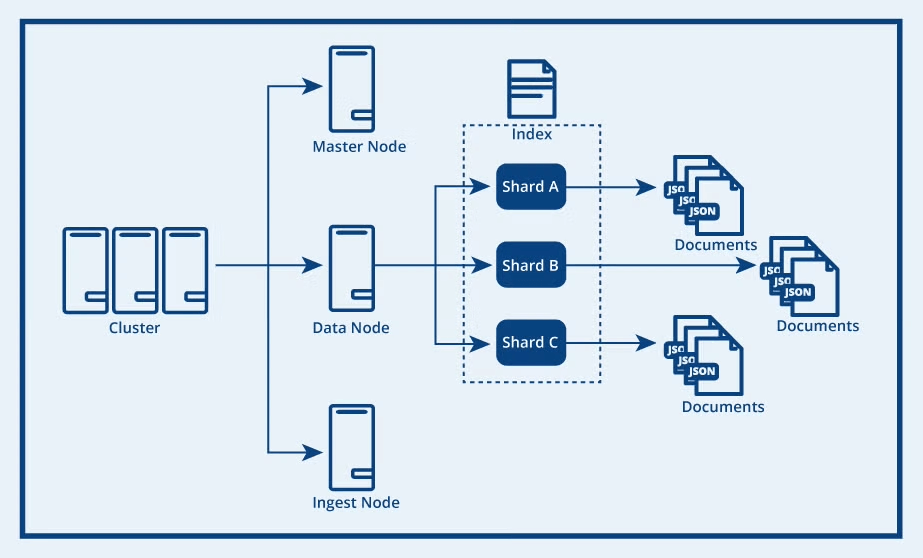

OpenSearch 的核心架构由集群、节点、索引、分片和文档组成。最高层是 OpenSearch 集群,它是由多个节点组成的分布式网络,每个节点会根据其类型负责不同的集群操作。数据节点负责存储索引(即文档的逻辑分组),并处理数据写入、搜索和聚合等任务。

每个索引会被划分为多个分片,分片包含主数据和副本数据。分片会分布在多台机器上,从而实现水平扩展,提升性能并高效利用存储资源。

OpenSearch vs Elasticsearch:详细对比

| 特性 | OpenSearch | Elasticsearch |

|---|---|---|

| 许可证 | Apache 2.0(完全开源) | SSPL/Elastic License/AGPLv3 |

| 起始版本 | 基于 Elasticsearch 7.10.2 | 从 7.11 开始协议变更 |

| 社区治理 | 开放治理模式,由社区驱动 | 由 Elastic NV 公司主导 |

| 安全性 | 所有安全功能默认开源 | 部分高级安全功能需要付费 |

| AI/向量检索 | 近年快速跟进,兼容性较好 | 原生支持,功能逐步增强 |

| 部署选择 | AWS OpenSearch Service / 自建 | Elastic Cloud / 自建 |

| 升级路径 | 从 Elasticsearch 7.x 平滑迁移 | 原生升级路径 |

| 社区活跃度 | 社区逐渐壮大,受到纯开源拥护者欢迎 | 用户基础庞大,但分裂带来争议 |

快速开始:5 分钟部署 OpenSearch

1. 使用 Docker 部署

# 拉取 OpenSearch 镜像

docker pull opensearchproject/opensearch:3.2.0

# 启动 OpenSearch 节点

docker run -d --name opensearch-node \

-p 9200:9200 -p 9600:9600 \

-e "discovery.type=single-node" \

-e "plugins.security.disabled=true" \

opensearchproject/opensearch:3.2.0

# 拉取 OpenSearch Dashboards

docker pull opensearchproject/opensearch-dashboards:3.2.0

# 启动 Dashboards

docker run -d --name opensearch-dashboards \

-p 5601:5601 \

-e "OPENSEARCH_HOSTS=http://opensearch-node:9200" \

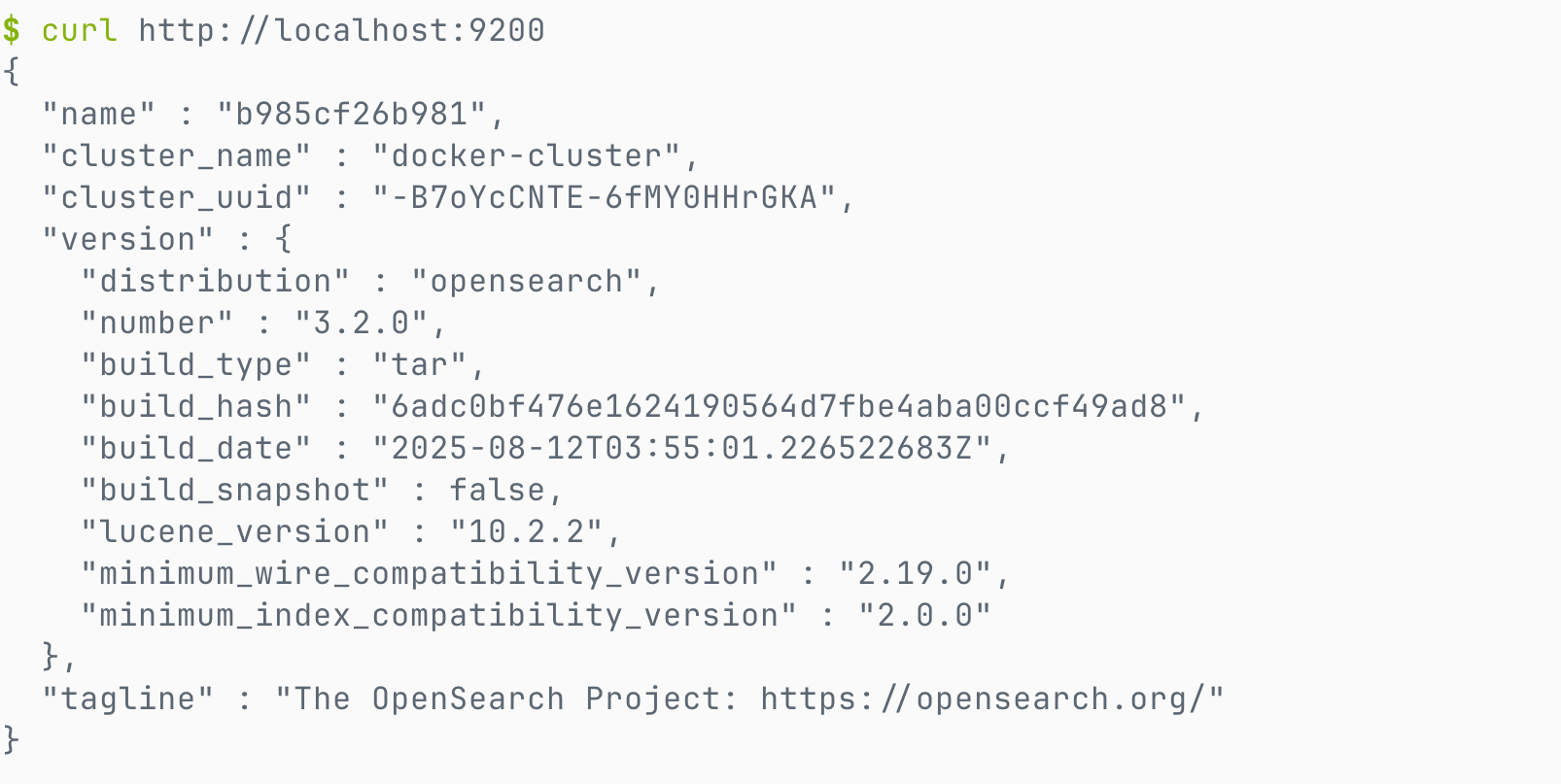

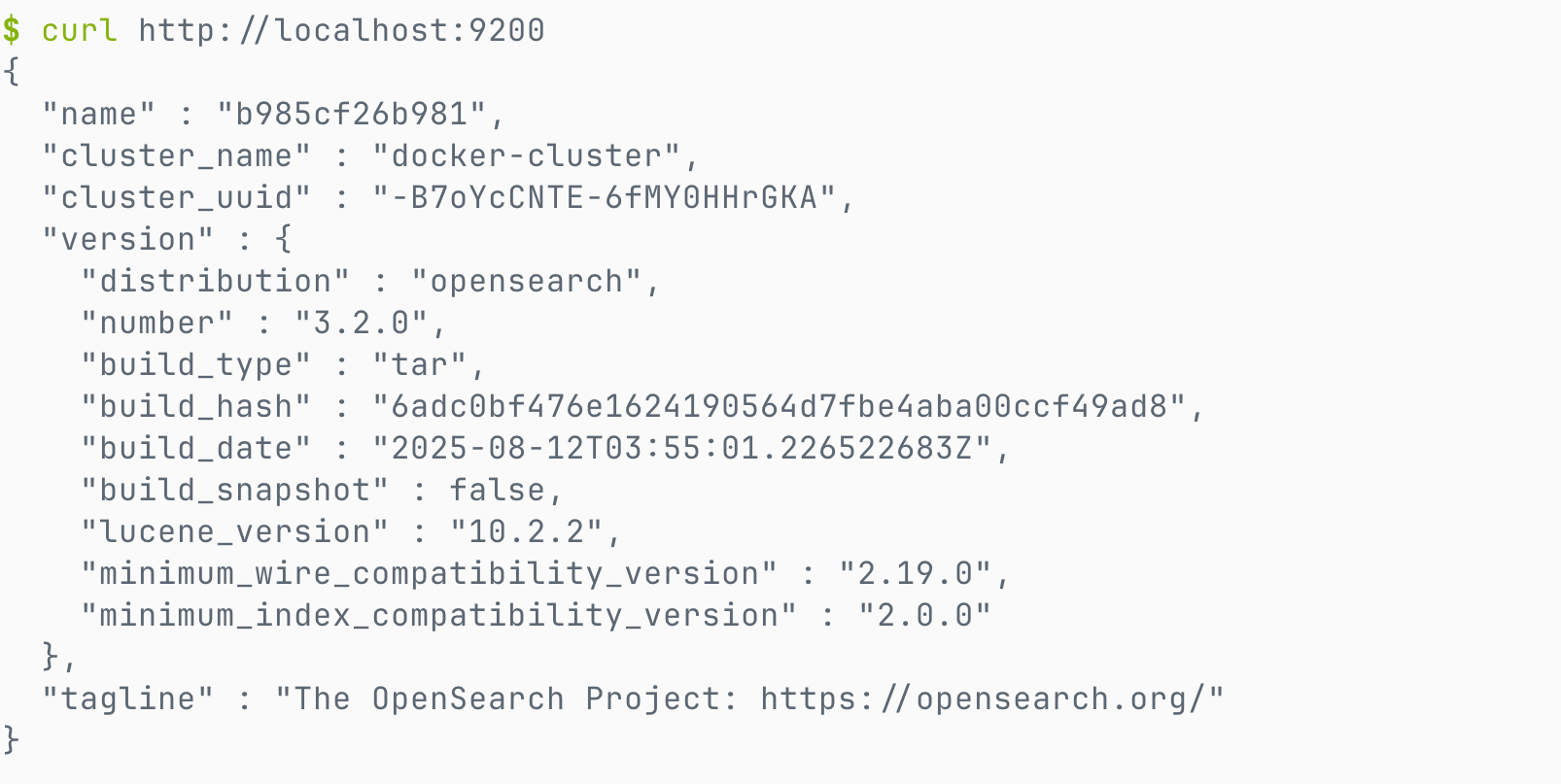

opensearchproject/opensearch-dashboards:3.2.02. 验证安装

# 检查集群状态

curl -X GET "http://localhost:9200/"出现如下结果说明安装成功。

3. 创建索引和搜索

# 索引文档

curl -X POST "http://localhost:9200/my-first-index/_doc" -H 'Content-Type: application/json' -d'

{

"title": "OpenSearch 入门指南",

"content": "这是我在 OpenSearch 中的第一个文档",

"timestamp": "2025-09-18T10:00:00"

}'

# 执行搜索

curl -X GET "http://localhost:9200/my-first-index/_search" -H 'Content-Type: application/json' -d'

{

"query": {

"match": {

"content": "第一个文档"

}

}

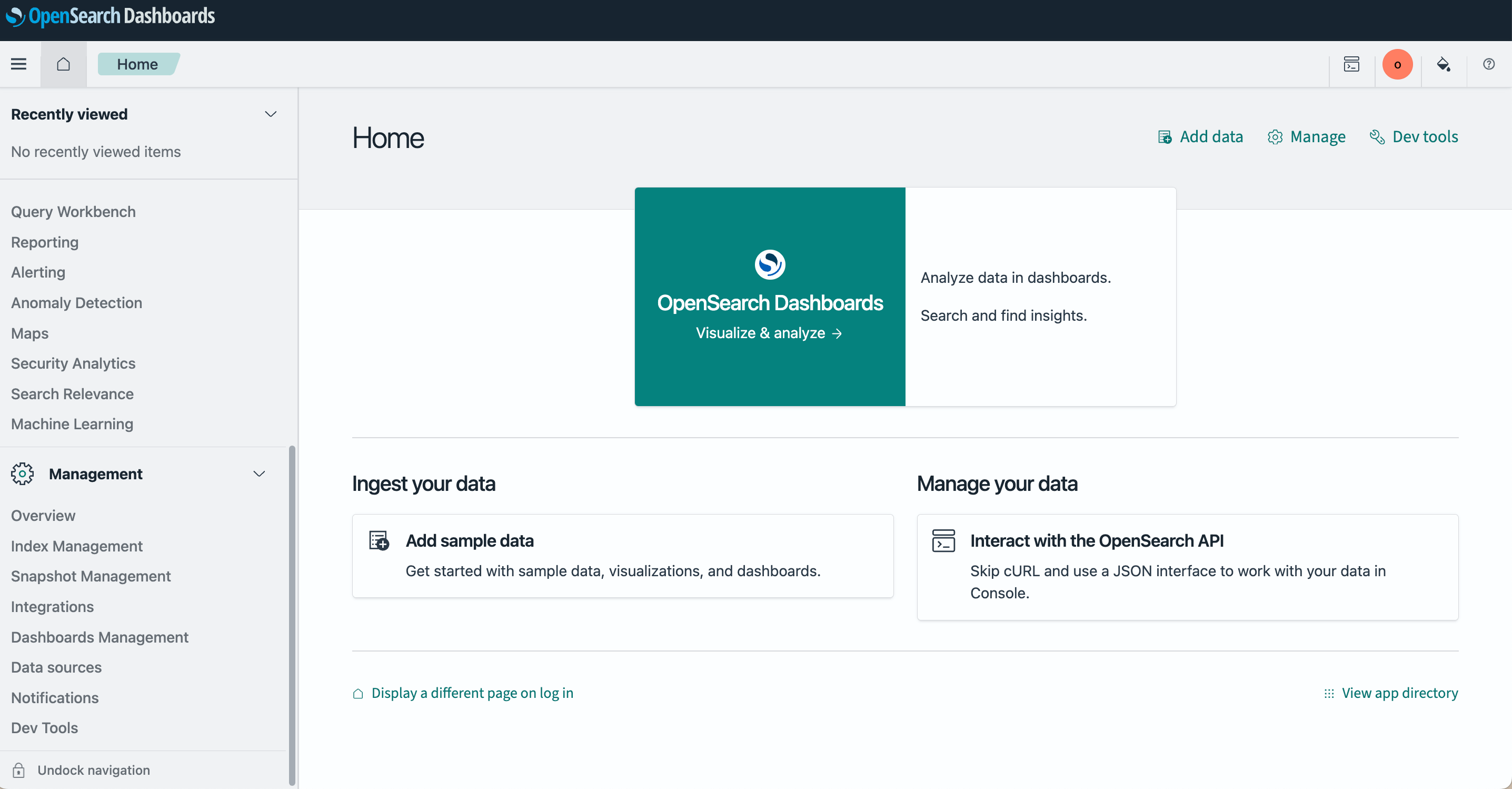

}'4. 访问控制台

打开浏览器访问 http://localhost:5601 即可使用 OpenSearch Dashboards 界面。

结语

OpenSearch 的出现,是开源社区的一次“自救”。它不仅延续了 Elasticsearch 的核心功能,还代表了另一种治理模式:由云厂商和社区共同维护,保证了开源协议的延续。

在搜索技术的版图里,Elasticsearch 与 OpenSearch 的分叉,注定会成为一个重要的历史节点。未来,两者可能会继续竞争,也可能各自发展出独特的生态。

🚀 下期预告

下一篇我们将介绍 OpenSearch 的另一个兄弟 Easysearch,一个衍生自开源协议 Apache 2.0 的 Elasticsearch 7.10.2 版本的轻量级搜索引擎,作为一个 ES 国产替代方案,看看它如何以其极致的速度和易用性在国内搜索领域占据一席之地。

💬 三连互动

- 您是否考虑过从 Elasticsearch 迁移到 OpenSearch?

- 在开源协议方面,您更倾向于哪种模式?Apache 2.0 还是 Elastic 的多重许可?

- 对于云厂商与开源项目之间的关系,您有什么看法?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

🔗 参考资源

原文:https://infinilabs.cn/blog/2025/search-wiki-4-opensearch/

Easysearch 国产替代 Elasticsearch:8 大核心问题解读

Easysearch • liaosy 发表了文章 • 0 个评论 • 11905 次浏览 • 2025-09-18 09:43

近年来,随着数据安全与自主可控需求的不断提升,越来越多的企业开始关注国产化的搜索与日志分析解决方案。作为极限科技推出的国产 Elasticsearch 替代产品,Easysearch 凭借其对搜索场景的深入优化、轻量级架构设计以及对 ES 生态的高度兼容,成为众多企业替代 Elasticsearch 的新选择。

我们在近期与用户的交流中,整理出了大家最关心的八大问题,并将它们浓缩为一篇技术解读,希望帮助你快速了解 Easysearch 的优势与定位。

用户最关心的八大问题

- Easysearch 对数据量的支撑能力如何,能应对 PB 级数据存储吗?

答:完全可以。Easysearch 支持水平扩展,通过增加节点即可线性提升存储与计算能力。在实际应用中,已成功支撑 PB 级日志与检索数据。同时,其存储压缩率相比 Elasticsearch 7.10.2 平均高出 2.5~3 倍,显著节省硬件成本。

- 在高并发写入场景下,Easysearch 和 ES 的性能差异有多大?

答:在相同硬件配置下,使用 Nginx 日志进行 bulk 写入压测,Easysearch 在多种分片配置下的写入性能相比 Elasticsearch 7.10.2 提升 40%-70%,更适合高并发写入场景。

- 是否支持中文分词?需要额外插件吗?

答:中文分词一直是 Elasticsearch 用户的「必装插件」。而在 Easysearch 中,中文分词是开箱即用的,同时支持 ik、pinyin 等主流分词器,还能自定义词典,方便电商、内容平台等场景。

- 从 ES 迁移到 Easysearch 是否复杂?会影响业务吗?

答:迁移往往是国产替代的最大顾虑。为此,Easysearch 提供了 极限网关 工具,支持全量同步和实时增量同步。迁移过程中业务可继续读写,只需短暂切换连接地址,几乎无感知。

- 监控与运维工具是否完善?是否支持 Kibana?

答:Easysearch 提供完整的监控与运维体系。从 Easysearch 1.15.x 版本起自带 Web UI 管理控制台(类似简化版 Kibana),支持索引管理、查询调试、权限控制等功能。同时还提供 INFINI Console 实现多集群管理与深度监控等。也可以通过配置让 Kibana 连接 Easysearch(部分高级功能可能受限)。

- 小型团队技术能力有限,用 Easysearch 运维难度高吗?

答:Easysearch 的一大设计理念就是降低运维门槛。Easysearch 提供一键部署脚本,减少手动配置参数,支持自动分片均衡与故障节点恢复,无需专职运维人员也能稳定运行,非常适合技术资源有限的团队。

- Easysearch 是否支持数据备份与恢复?操作复杂吗?

答:支持快照(Snapshot),可备份到本地磁盘或对象存储(S3、OSS 等)。恢复时仅需执行快照恢复命令,满足企业级数据安全需求。

- 对比 ES,Easysearch 在使用体验上最大的不同是什么?

答:Easysearch 保持与 Elasticsearch 类似的接口与查询 DSL,用户几乎无学习成本即可上手。同时,它针对国产化环境和搜索场景做了优化,运维更轻量,成本更可控。

结语:Easysearch,国产化搜索的新选择

作为一款国产自主可控的搜索与日志分析引擎,Easysearch 不仅继承了 Elasticsearch 的核心能力,更在性能、易用性、资源效率和中文支持等方面进行了深度优化。对于希望实现国产化替代、降低运维成本、提升系统性能的企业来说,Easysearch 是一个值得认真考虑的新选择。

如果你正在评估 Elasticsearch 的替代方案,不妨从 Easysearch 开始,体验更轻量、更高效的搜索新架构。

如需了解更多技术细节与使用案例,欢迎访问官方文档与社区资源:

- Easysearch 官网文档

- Elasticsearch VS Easysearch 性能测试

- 使用 Easysearch,日志存储少一半

- Kibana OSS 7.10.2 连接 Easysearch

- 自建 ES 集群通过极限网关无缝迁移到云上

- INFINI Console 一站式的数据搜索分析与管理平台

搜索百科(3):Elasticsearch — 搜索界的“流量明星”

Elasticsearch • liaosy 发表了文章 • 0 个评论 • 16824 次浏览 • 2025-09-16 11:20

大家好,我是 INFINI Labs 的石阳。

欢迎关注 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

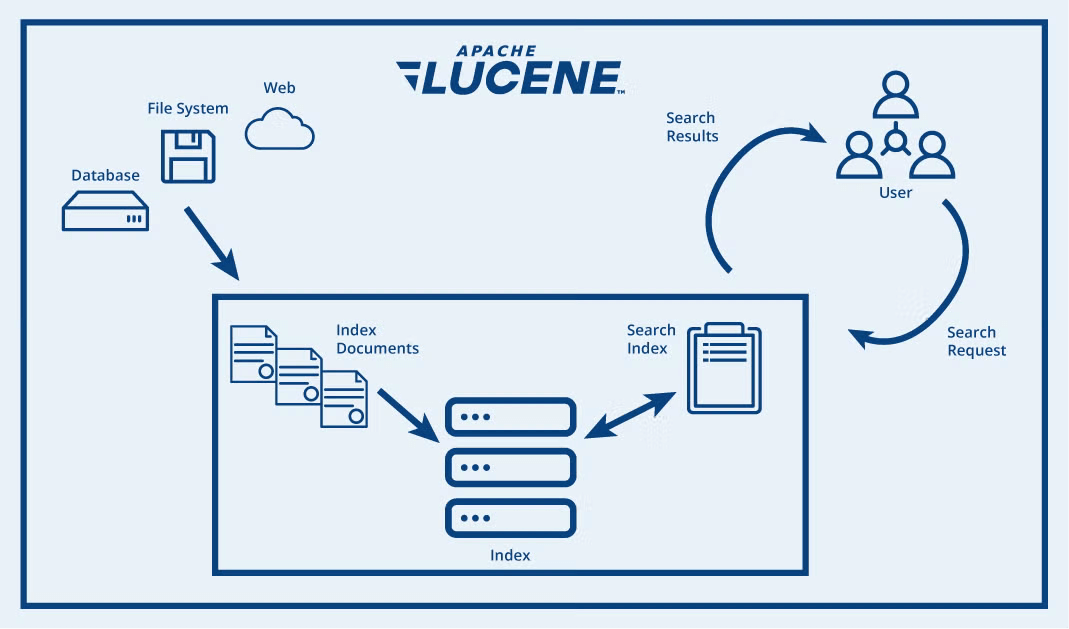

前两篇我们探讨了搜索技术的基石 Apache Lucene 和企业级搜索解决方案 Apache Solr。今天,我们来聊聊一个真正改变搜索游戏规则,但也充满争议的产品 — Elasticsearch。

引言

如果说 Lucene 是幕后英雄,那么 Elasticsearch 就是舞台中央的明星。借助 REST API、分布式架构、强大的生态系统,它让搜索 + 分析成为“马上可用”的服务形式。

在日志平台、可观察性、安全监控、AI 与语义检索等领域,Elasticsearch 的名字几乎成了默认选项。

Elasticsearch 概述

Elasticsearch 是一个开源的分布式搜索和分析引擎,构建于 Apache Lucene 之上。作为一个检索平台,它可以实时存储结构化、非结构化和向量数据,提供快速的混合和向量搜索,支持可观测性与安全分析,并以高性能、高准确性和高相关性实现 AI 驱动的应用。

- 首次发布:2010 年 2 月

- 最新版本:9.1.3(截止 2025 年 9 月)

- 核心依赖:Apache Lucene

- 开源协议:AGPL v3

- 官方网址:https://www.elastic.co/elasticsearch/

- GitHub 仓库:https://github.com/elastic/elasticsearch

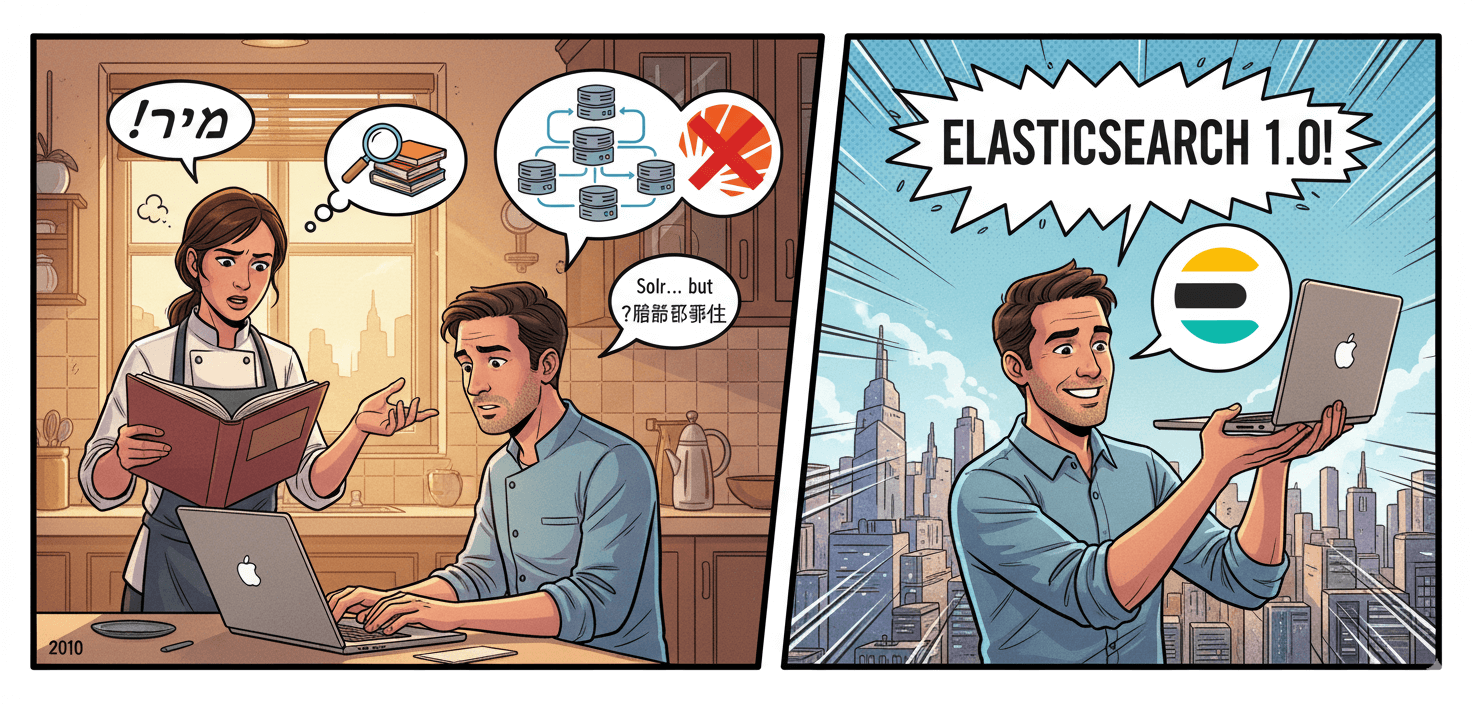

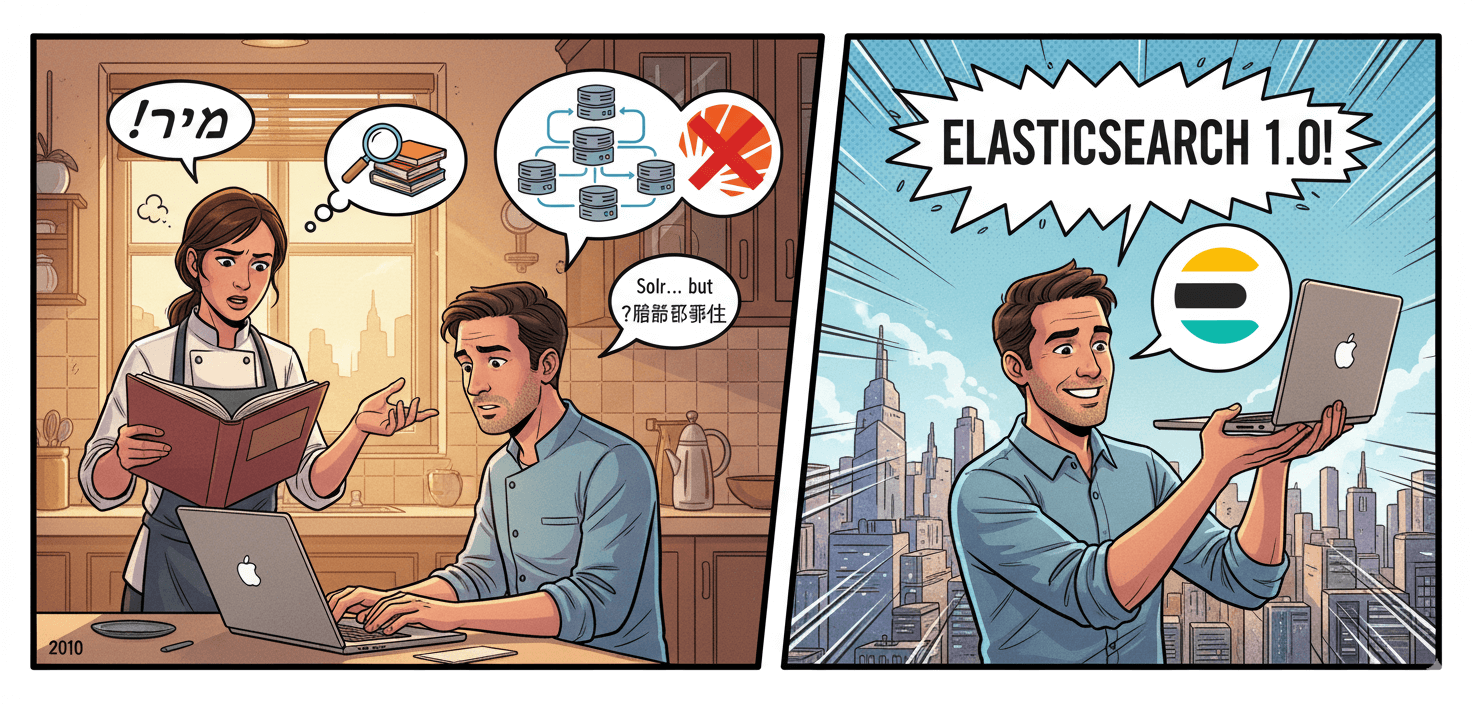

起源:从食谱搜索到全球“流量明星”

Elasticsearch 的故事始于以色列开发者 Shay Banon。2010 年,当时他在学习厨师课程的妻子需要一款能够快速搜索食谱的工具。虽然当时已经有 Solr 这样的搜索解决方案,但 Shay 认为它们对于分布式场景的支持不够完善。

基于之前开发 Compass(一个基于 Lucene 的搜索库)的经验,Shay 开始构建一个完全分布式的、基于 JSON 的搜索引擎。2010 年 2 月,Elasticsearch 的第一个版本发布。

随着用户日益增多、企业级需求增强,Shay 在 2012 年创立了 Elastic 公司,把 Elasticsearch 不仅作为开源项目,也逐渐商业化运营起来,包括提供托管服务、企业支持,加入 Logstash 日志处理、Kibana 可视化工具等,Elastic 公司也逐渐从一个纯搜索引擎项目演变为一个更广泛的“数据搜索与分析”平台。

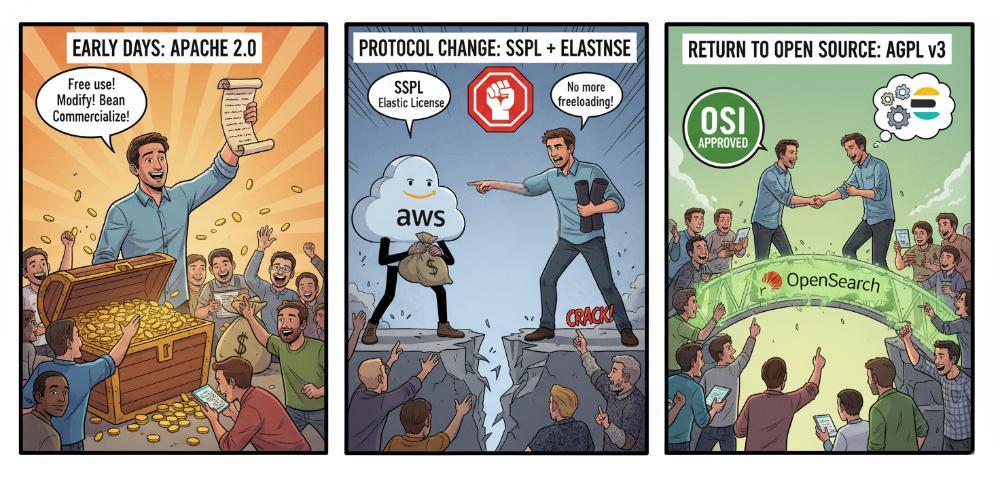

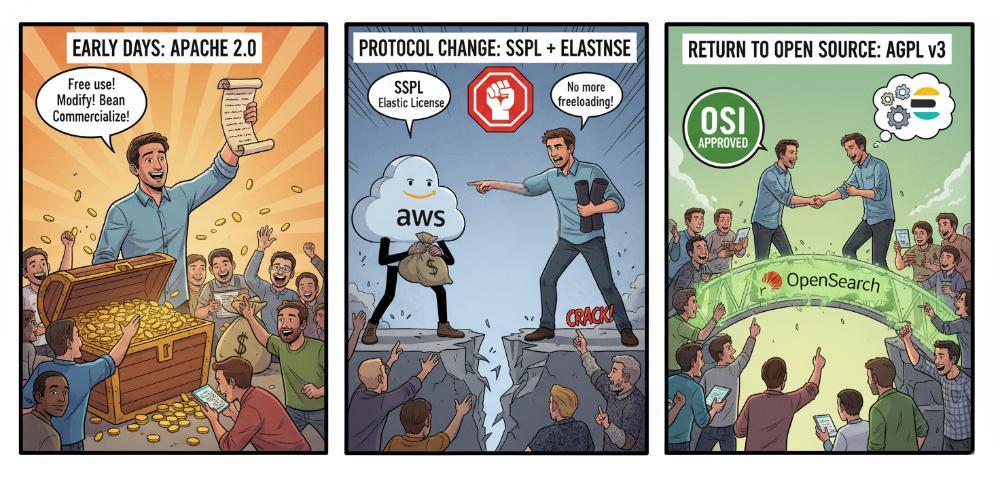

协议变更:开源和商业化的博弈

Elasticsearch 的发展并非一帆风顺。其历史上最具转折性的事件当属与 AWS 的冲突及随之而来的开源协议变更。

- 早期:Apache 2.0 协议

2010 年 Shay Banon 开源 Elasticsearch 时,最初采用的是 Apache 2.0 协议。Apache 2.0 属于宽松的自由协议,允许任何人免费使用、修改和商用(包括 SaaS 模式)。这帮助 Elasticsearch 快速壮大,成为事实上的“搜索引擎标准”。

- 协议变更:应对云厂商“白嫖”

随着 Elasticsearch 的流行,像 AWS(Amazon Web Services) 等云厂商直接将 Elasticsearch 做成托管服务,并从中获利。Elastic 公司认为这损害了他们的商业利益,因为云厂商“用开源赚钱,却没有回馈社区”。2021 年 1 月,Elastic 宣布 Elasticsearch 和 Kibana 不再采用 Apache 2.0,改为 双重协议:SSPL + Elastic License。这一步导致社区巨大分裂,AWS 带头将 Elasticsearch 分叉为 OpenSearch,并继续以 Apache 2.0 协议维护。

- 再次转向开源:AGPL v3

2024 年 3 月,Elastic 宣布新的版本(Elasticsearch 8.13 起)又新增 AGPL v3 作为一个开源许可选项。AGPL v3 既符合 OSI 真正开源标准,又能约束云厂商闭源托管服务,同时修复社区关系,Elastic 希望通过重新拥抱开源,减少分裂,吸引开发者回归。

Elasticsearch 从宽松到收紧,再到回归开源,是在社区生态与商业利益间寻找平衡的过程。

基本概念

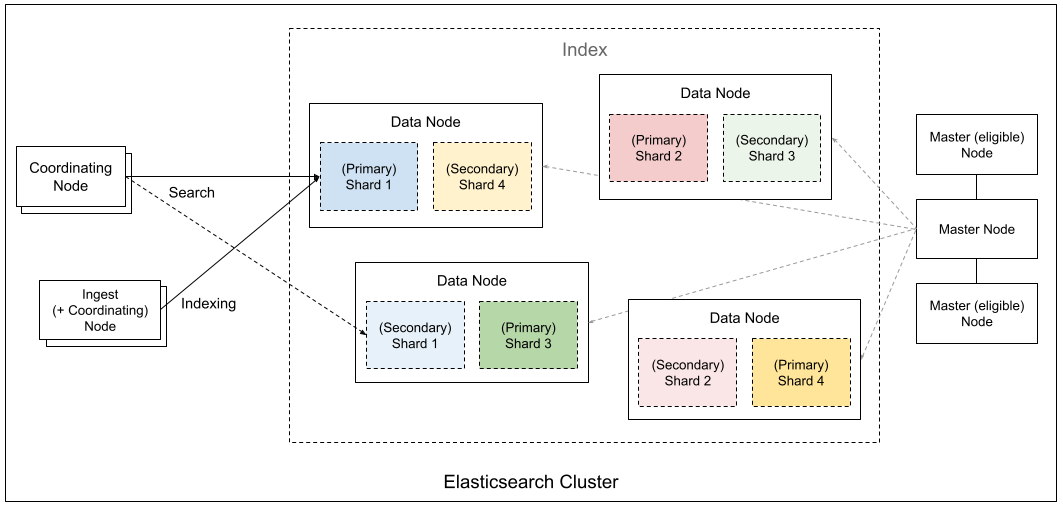

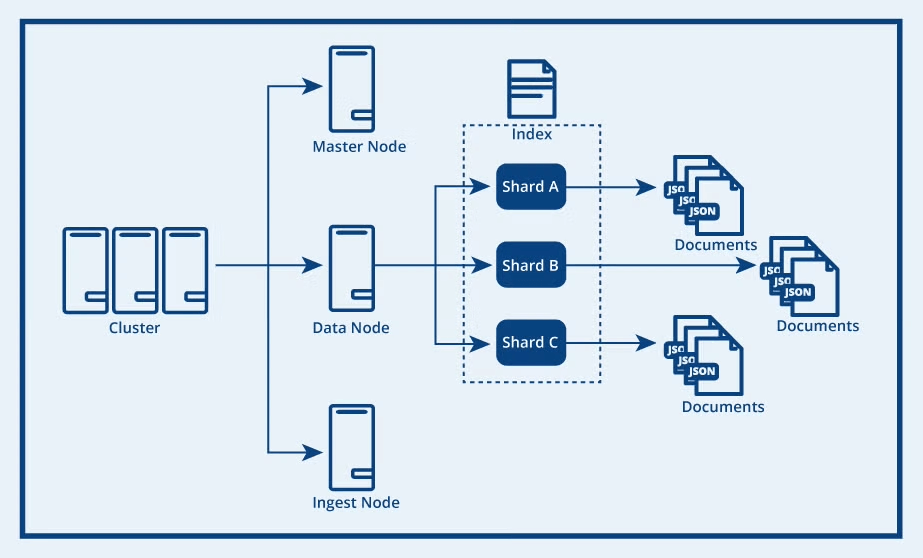

要学习 Elasticsearch,得先了解其五大基本概览:集群、节点、分片、索引和文档。

- 集群(Cluster)

由一个或多个节点组成的整体,提供统一的搜索与存储服务。对外看起来像一个单一系统。

- 节点(Node)

集群中的一台服务器实例。节点有不同角色:

- Master 节点:负责集群管理(分片分配、元数据维护)。

- Data 节点:存储数据、处理搜索和聚合。

- Coordinating 节点:接收请求并调度任务。

- Ingest 节点:负责数据写入前的预处理。

- 索引(Index)

类似于传统数据库的“库”,按逻辑组织数据。一个索引往往对应一个业务场景(如日志、商品信息)。

- 分片(Shard)

为了让索引能水平扩展,Elasticsearch 会把索引拆分为多个 主分片,并为每个主分片创建 副本分片,提升高可用和查询性能。

- 文档(Document)

Elasticsearch 存储和检索的最小数据单元,通常是 JSON 格式。多个文档组成一个索引。

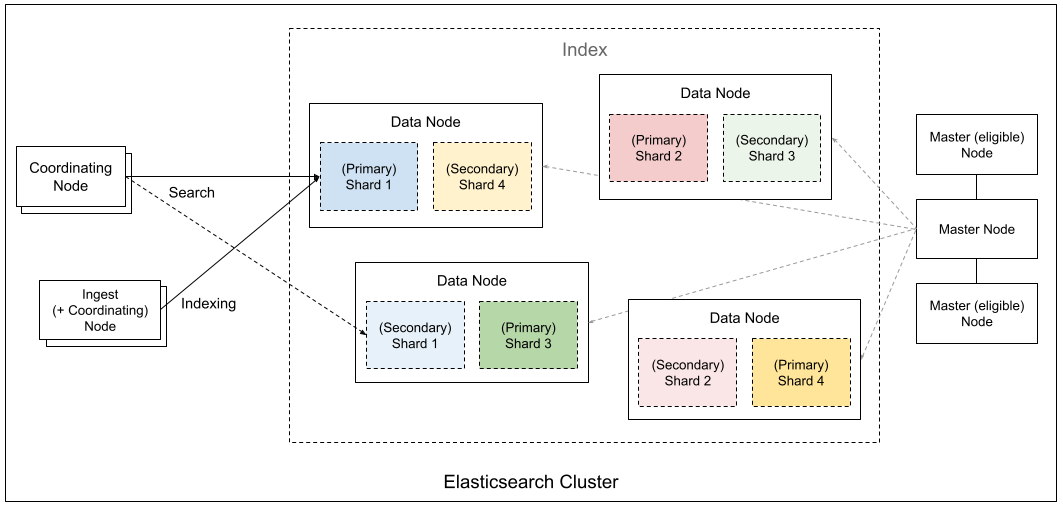

集群架构

Elasticsearch 通过 Master、Data、Coordinating、Ingest 等不同角色节点的协作,将数据切分成分片并分布式存储,实现了高可用、可扩展的搜索与分析引擎架构。

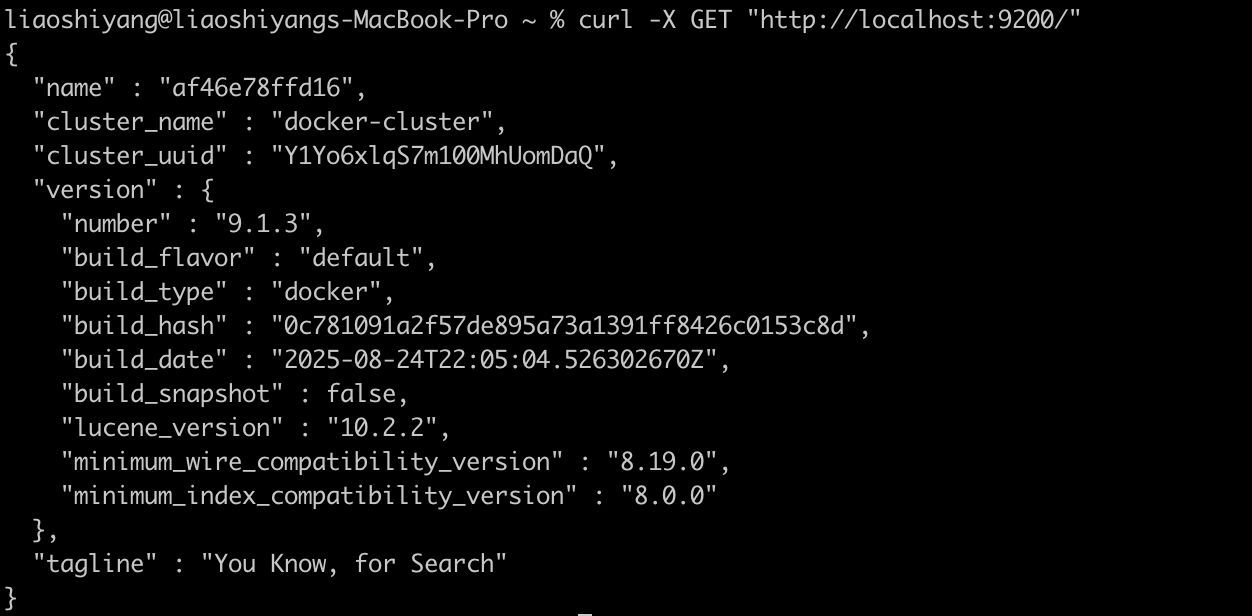

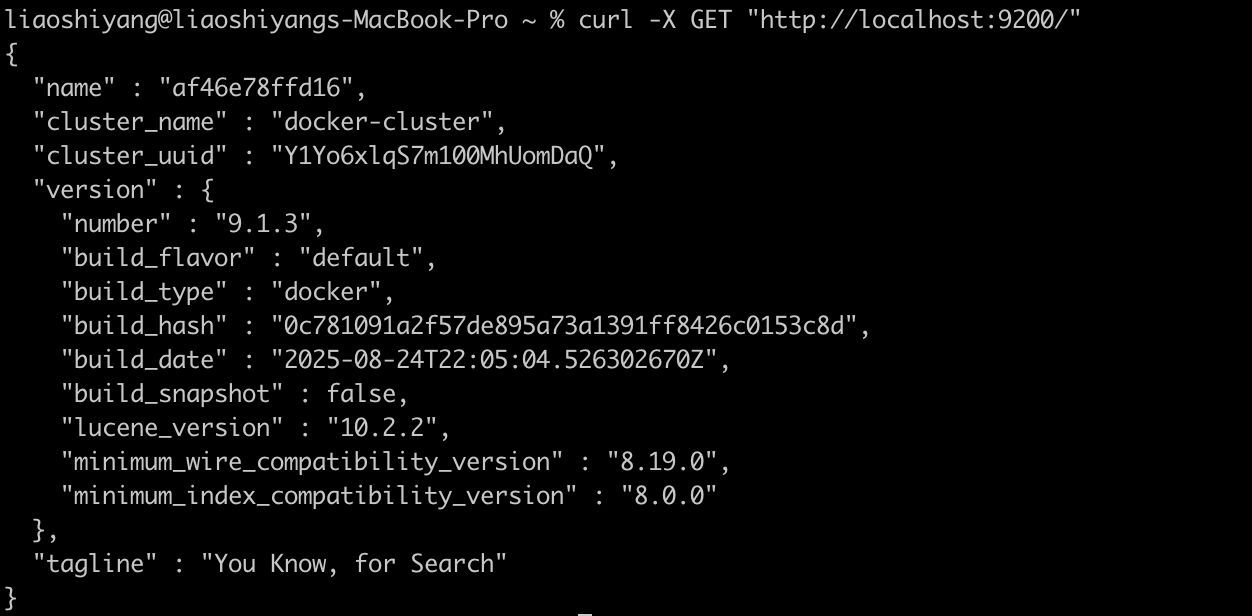

快速开始:5 分钟体验 Elasticsearch

1. 使用 Docker 启动

# 拉取最新镜像

docker pull docker.elastic.co/elasticsearch/elasticsearch:9.1.3

# 启动单节点集群

docker run -d --name elasticsearch \

-p 9200:9200 -p 9300:9300 \

-e "discovery.type=single-node" \

-e "xpack.security.enabled=false" \

docker.elastic.co/elasticsearch/elasticsearch:9.1.32. 验证安装

# 检查集群状态

curl -X GET "http://localhost:9200/"

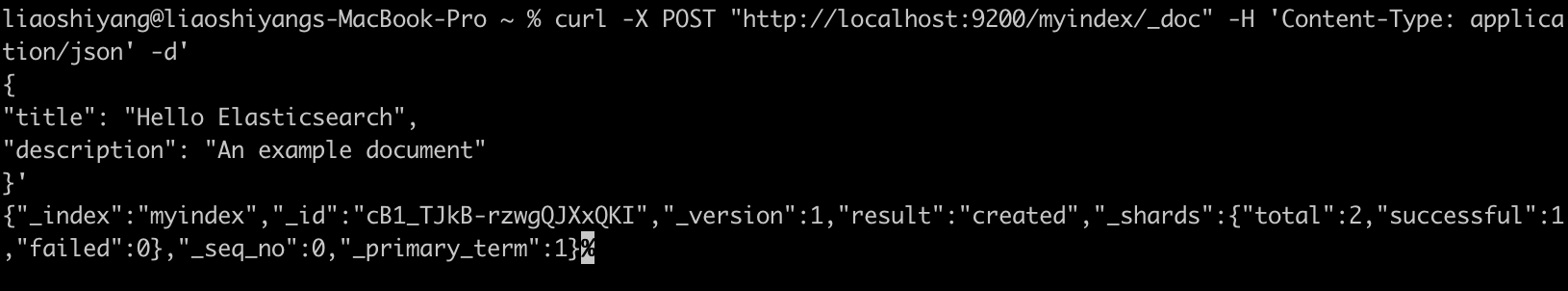

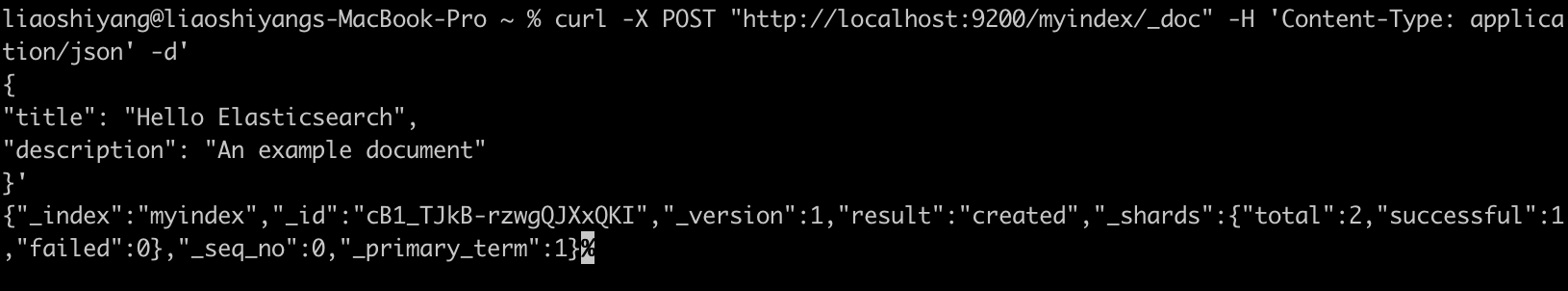

3. 索引文档

# 索引文档

curl -X POST "http://localhost:9200/myindex/_doc" -H 'Content-Type: application/json' -d'

{

"title": "Hello Elasticsearch",

"description": "An example document"

}'

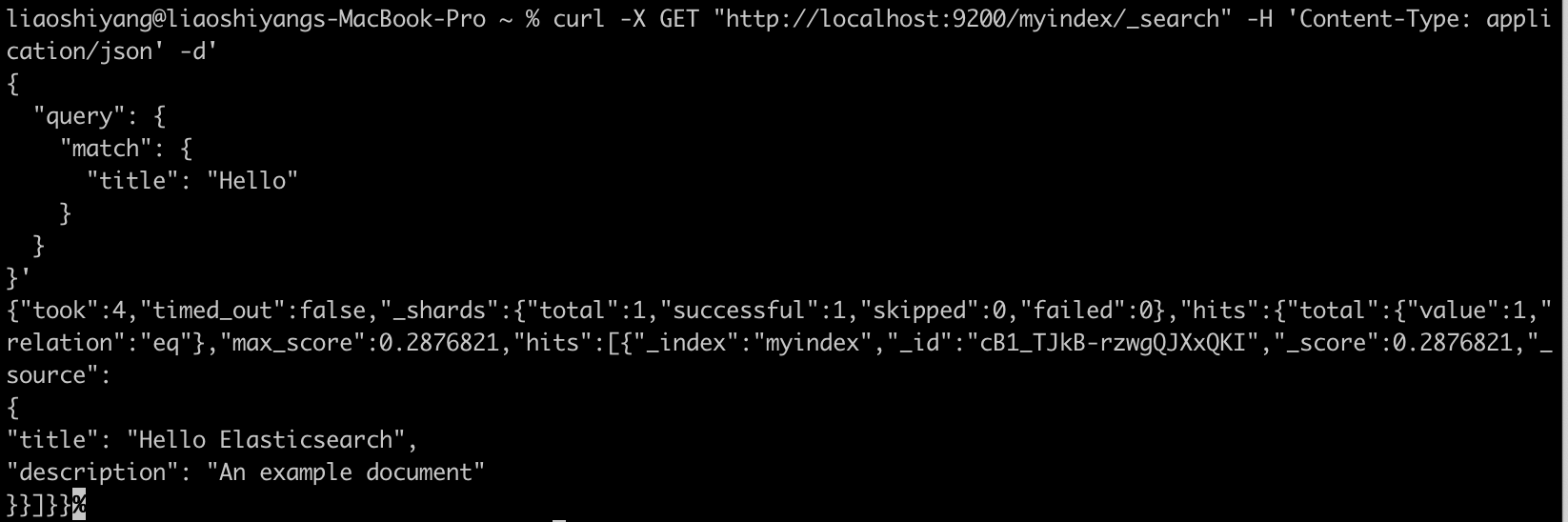

3. 搜索文档

# 搜索文档

curl -X GET "http://localhost:9200/myindex/_search" -H 'Content-Type: application/json' -d'

{

"query": {

"match": {

"title": "Hello"

}

}

}'

结语

Elasticsearch 是搜索与分析领域标杆性的产品。它将 Lucene 的能力包装起来,加上分布式、易用以及与数据可视化、安全监控等功能的整合,使搜索引擎从专业技术逐渐变为“随手可用”的基础设施。

虽然协议变动、与 OpenSearch 的分叉引发争议,但它在企业与开发者群体中的实际应用价值依然难以替代。

🚀 下期预告

下一篇我们将介绍 OpenSearch,探讨这个 Elasticsearch 分支项目的发展现状、技术特点以及与 Elasticsearch 的详细对比。如果您有特别关注的问题,欢迎提前提出!

💬 三连互动

- 你或公司最近在用 Elasticsearch 吗?拿来做了什么场景?

- 在 Elasticsearch 和 OpenSearch 之间做过技术选型?

- 对 Elasticsearch 的许可证变化有什么看法?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

🔗 参考

原文:https://infinilabs.cn/blog/2025/search-wiki-3-elasticsearch/

搜索百科(2):Apache Solr — 企业级搜索的开源先锋

开源项目 • liaosy 发表了文章 • 0 个评论 • 5743 次浏览 • 2025-09-15 18:12

大家好,我是 INFINI Labs 的石阳。

欢迎回到 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

上一篇我们认识了搜索技术的基石 Apache Lucene,今天我们将继续这个旅程,了解基于 Lucene 构建的第一个成功商业级搜索平台 —— Apache Solr。

Solr 是什么?

Solr 是一款极速的开源多模态搜索平台,基于 Apache Lucene 的全文、向量和地理空间搜索能力构建而成。Solr 具备高可靠性、可扩展性和容错性,支持分布式索引、复制与负载均衡查询,提供自动故障转移与恢复、集中化配置等功能。如今,Solr 为全球众多大型互联网网站提供搜索和导航功能。

- 首次发布:2004 年,2006 年进入 Apache

- 最新版本:截至 2025 年,已更新至 9.x 系列

- 核心依赖:Apache Lucene

- 开源协议:Apache License 2.0

- 官方网址:https://solr.apache.org

- GitHub 仓库:https://github.com/apache/solr

它的定位是:把 Lucene 打造成独立的企业级搜索服务。相比 Lucene 需要写代码调用,Solr 提供了 Web 管理界面、REST API 和配置文件,让开发者更容易上手。

起源:从网站搜索到 Apache 顶级项目

Solr(读作"solar")的故事始于 2004 年,当时 CNET 公司的开发人员 Yonik Seeley 需要为其新闻网站构建一个搜索功能。虽然 Lucene 提供了强大的核心搜索能力,但直接使用 Lucene 需要编写大量 Java 代码,缺乏开箱即用的功能。

Seeley 决定在 Lucene 之上构建一个更易用的搜索服务器,于是 Solr 诞生了。最初的目标很明确:通过 HTTP/XML 接口提供搜索服务,让任何编程语言都能轻松集成搜索功能。

2006 年,Solr 捐赠给 Apache 基金会,2007 年成为顶级项目。2010 年,Solr 与 Lucene 项目合并,形成了今天我们所知的 Apache Lucene/Solr 项目。

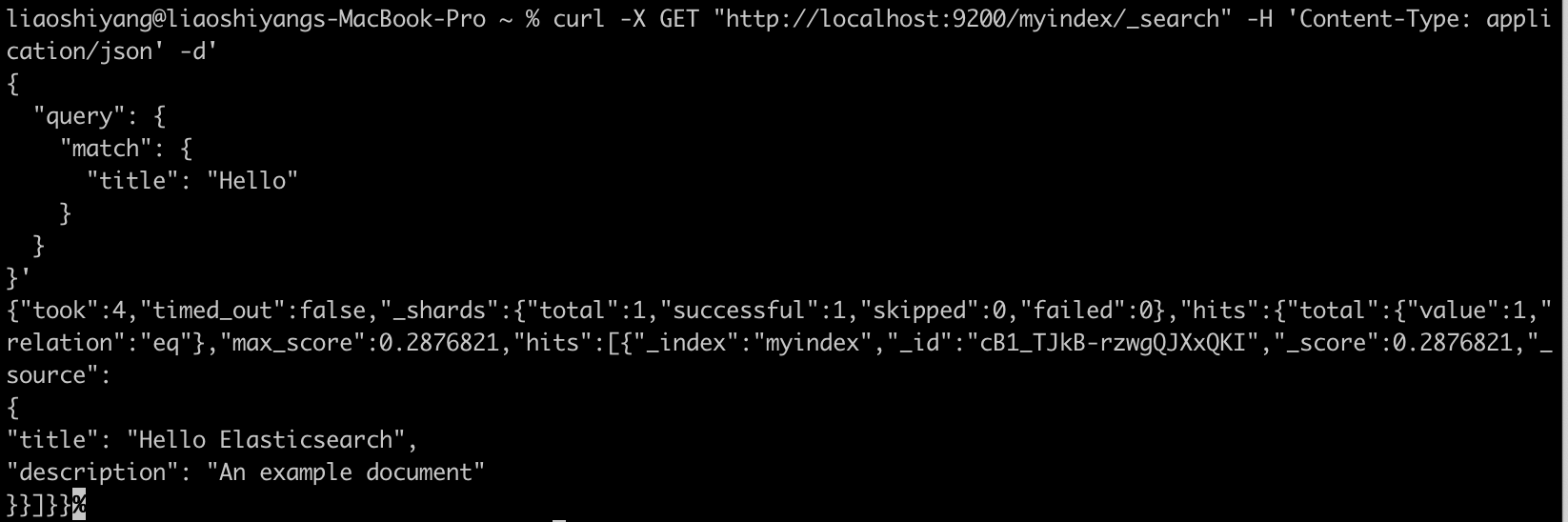

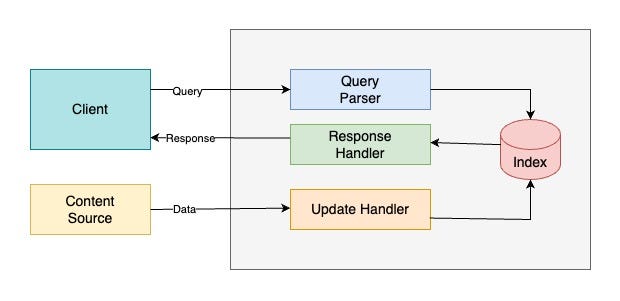

技术架构

Index(索引)

Apache Solr 的索引就像是用于管理结构化 / 非结构化数据的“数据库”。它以便于分析和全文检索的方式存储数据。

Query Parser(查询解析器)

所有由客户端提交的查询都会由查询解析器处理。

Response Handler(响应处理器)

响应处理器负责为客户端生成合适格式的响应(如 JSON/XML/CSV)。

Update Handler(更新处理器)

更新处理器用于索引操作,即对索引中的数据进行插入、更新和删除。例如,如果我们希望 MySQL 数据与 Apache Solr 保持同步,就需要创建一个负责同步的更新处理器。

功能亮点

- 全文检索:高效支持关键词搜索、布尔查询、短语匹配等。

- 分面搜索(Faceted Search):可以对搜索结果进行分类和聚合统计。

- 分布式架构(SolrCloud):支持集群部署、自动分片、副本和容错。

- 丰富的数据接口:提供 RESTful API,支持 JSON、XML、CSV 等多种格式的数据交互。

- 扩展性与可定制性:通过插件机制支持多语言分词、排序、评分模型等个性化定制。

- 地理位置搜索:内置空间搜索能力,支持基于经纬度的范围查询和排序。

对比: Solr vs Elasticsearch 如何选择?

虽然两者都基于 Lucene,但在设计哲学上有所不同:

| 特性 | Apache Solr | Elasticsearch |

|---|---|---|

| 定位 | 企业级搜索服务器 | 分布式搜索和分析引擎 |

| API | 更标准化,遵循传统 REST | 更灵活,JSON 原生 |

| 分布式 | 需要 ZooKeeper 协调 | 内置分布式协调 |

| 上手难度 | 相对简单,开箱即用 | 学习曲线较陡峭 |

| 生态系统 | 搜索功能更丰富 | 分析和可视化更强 |

| 适用场景 | 传统企业搜索、电商 | 日志分析、实时监控 |

简单来说:Solr 更像"精装房",开箱即用;Elasticsearch 更像"毛坯房",需要更多自定义但更灵活。

快速开始:5 分钟搭建 Solr 服务

1. 下载和安装

# 下载 8.x 版 Solr

wget https://dlcdn.apache.org/solr/solr/8.11.4/solr-8.11.4.tgz

# 解压

tar -xzf solr-8.11.4.tgz

# 启动 Solr(单机模式)

cd solr-8.11.4

bin/solr start2. 创建 Core

# 创建测试 Core

bin/solr create -c test_core

# 查看 Core 状态

bin/solr status3. 索引文档

# 使用 curl 索引 JSON 文档

curl http://localhost:8983/solr/test_core/update -d '

[

{"id": "1", "title": "Solr 入门指南", "content": "Apache Solr 是企业级搜索平台"},

{"id": "2", "title": "搜索技术演进", "content": "从 Lucene 到 Solr 的技术发展"}

]' -H 'Content-type:application/json'

# 提交更改

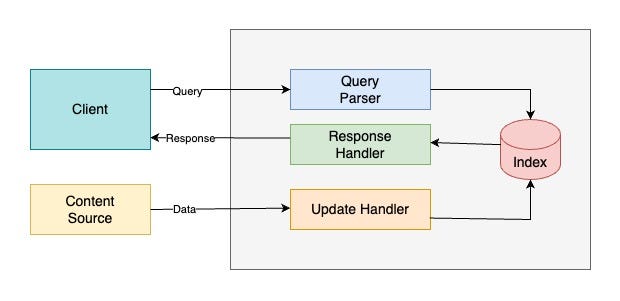

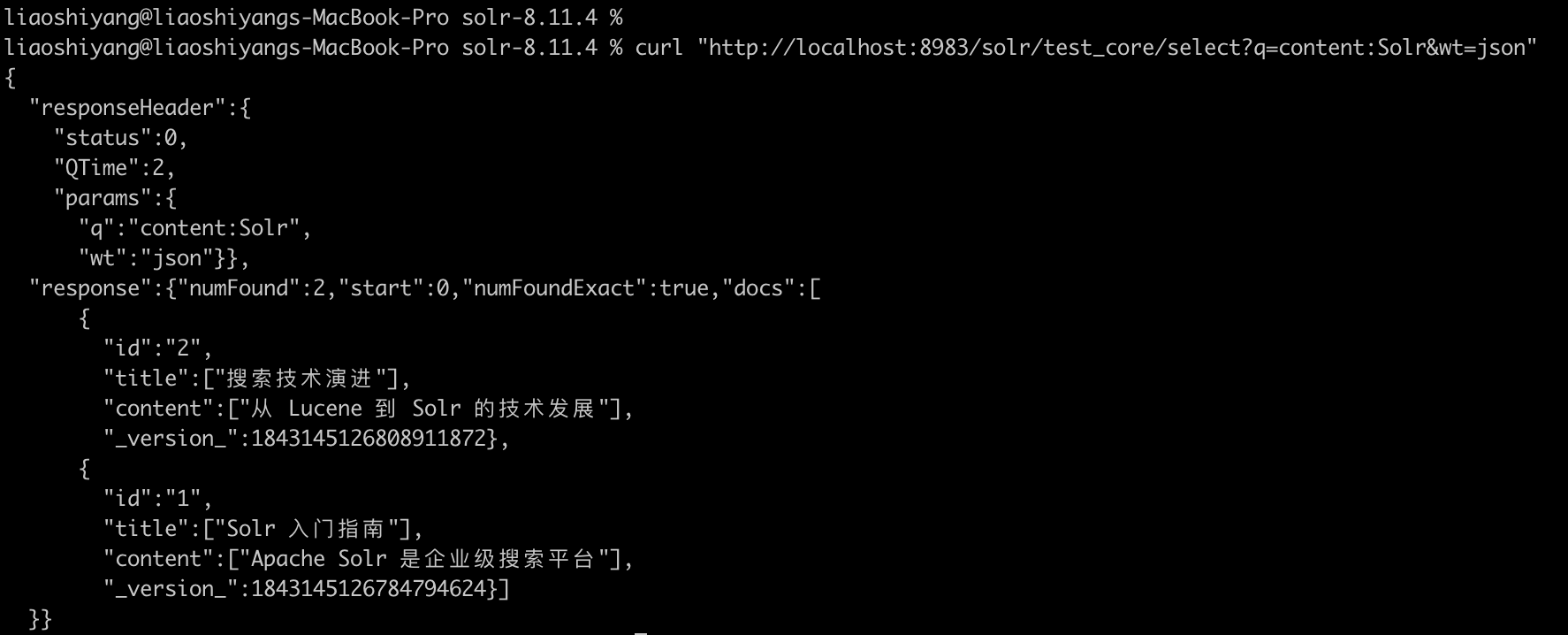

curl http://localhost:8983/solr/test_core/update -d '<commit/>' -H 'Content-type:application/xml'4. 执行搜索

# 搜索"Solr"

curl "http://localhost:8983/solr/test_core/select?q=content:Solr"

# 使用 JSON 格式返回

curl "http://localhost:8983/solr/test_core/select?q=content:Solr&wt=json"执行搜索返回结果:

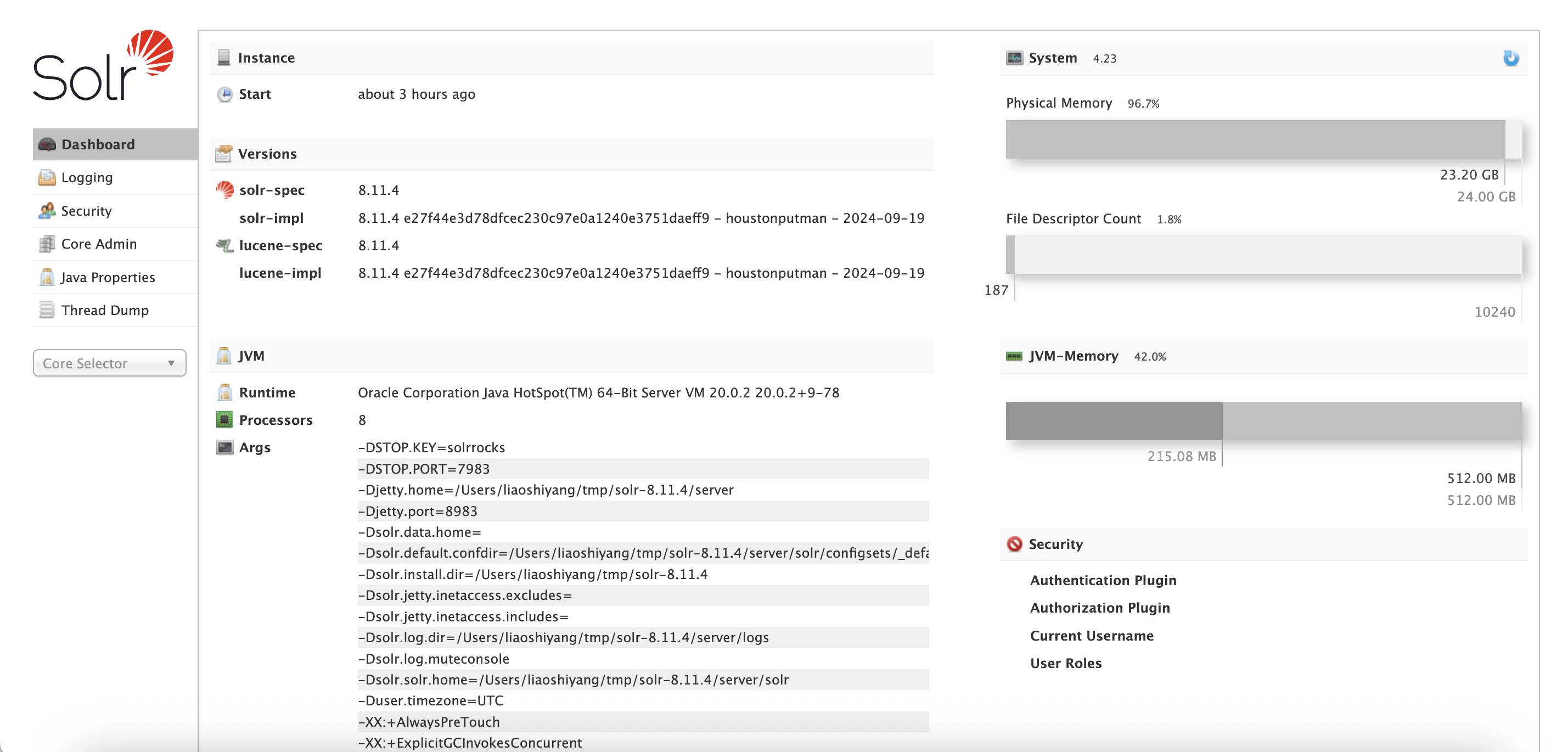

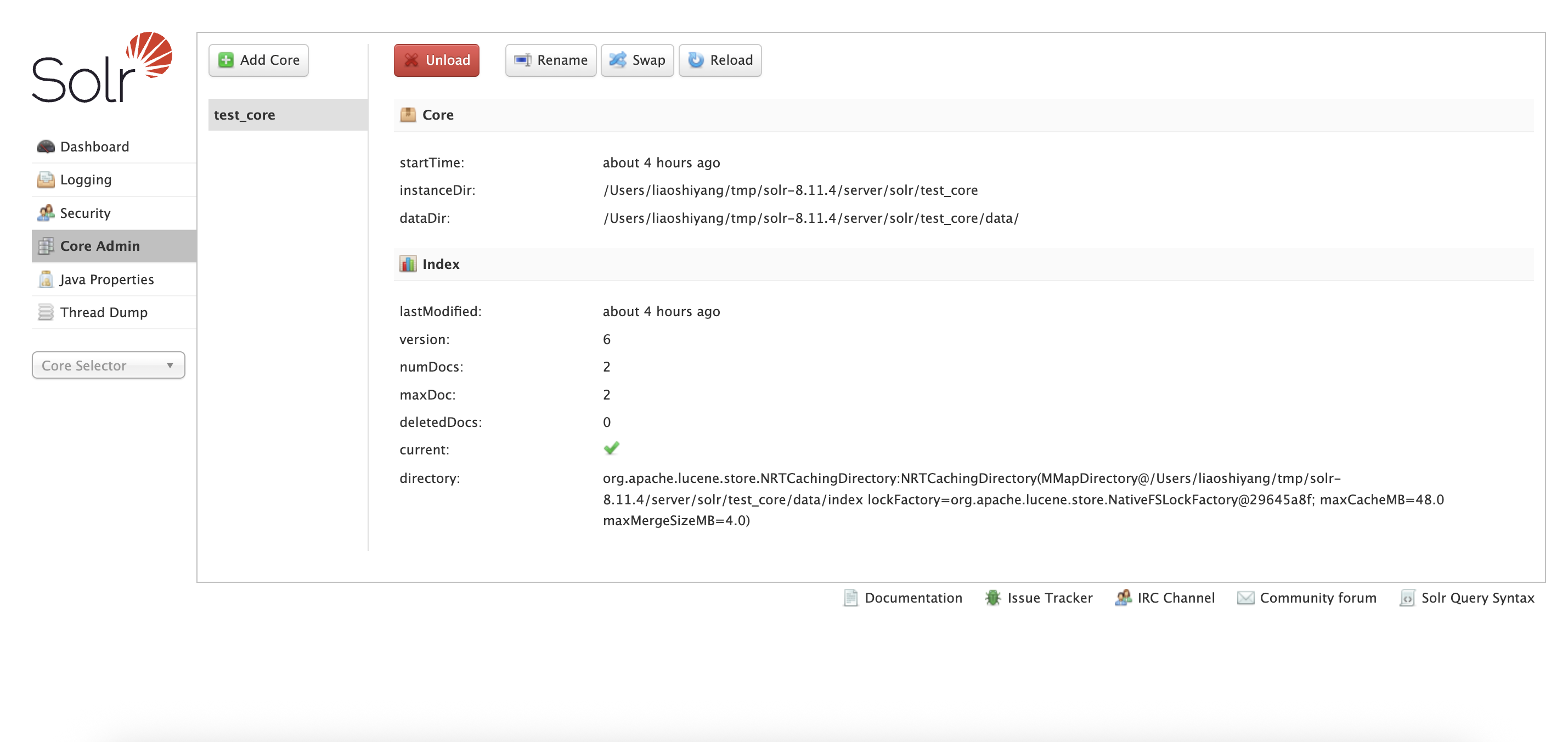

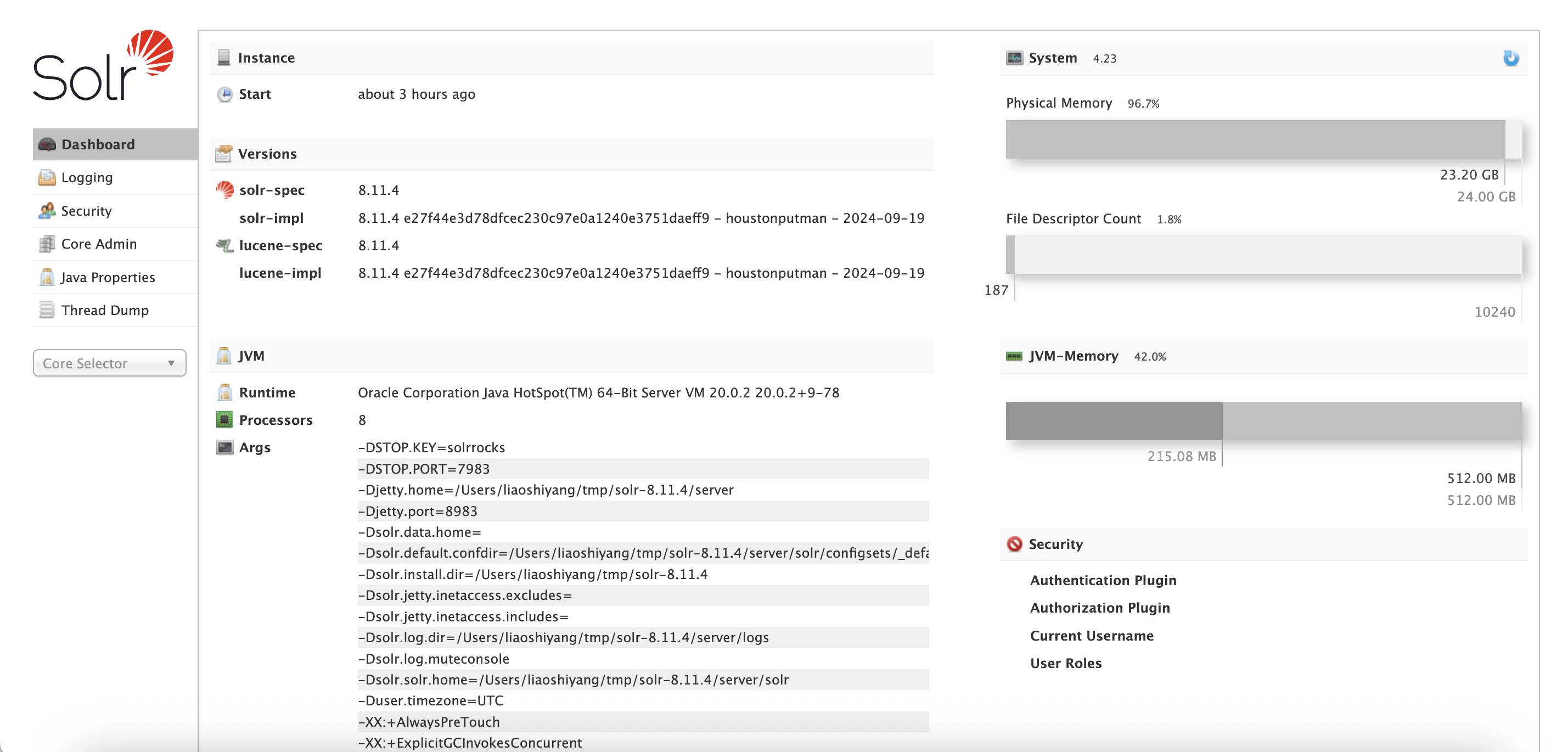

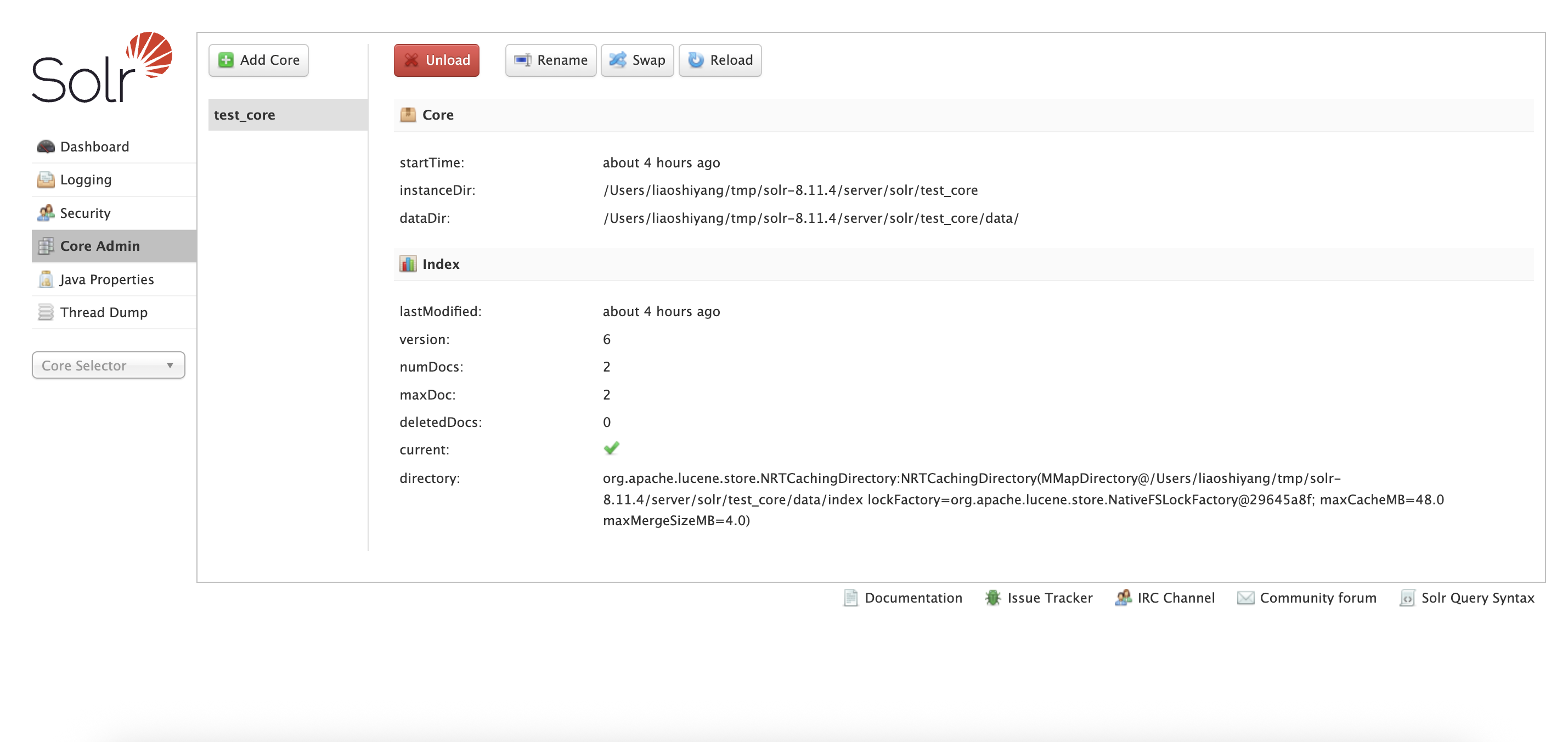

访问 http://localhost:8983/solr 即可使用 Solr 的管理界面。

Dashboard:

Core Admin:

结语

从最初的公司内部工具,到成为全球范围内广泛使用的开源搜索引擎,Apache Solr 见证并推动了搜索技术的进化。尽管近年来 Elasticsearch、向量数据库和 AI 驱动的搜索技术逐渐崛起,但 Solr 依然是许多企业可靠且成熟的选择。它的故事不仅属于开源社区,也代表了搜索技术发展的一个重要阶段。

🚀 下期预告

在下一篇「搜索百科」中,我们将介绍它的明星兄弟 —— Elasticsearch。

💬 三连互动

- 你现在还在用 Solr 吗?

- 在 Solr 和 Elasticsearch 之间做过技术选型?

- 遇到过有趣的 Solr 使用案例或挑战?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

🔗 参考

【 INFINI Workshop 北京站】1月18日一起动手实验玩转 Easysearch

活动 • liaosy 发表了文章 • 0 个评论 • 5268 次浏览 • 2023-12-15 16:22

与 INFINI Labs 的技术专家面对面,第一时间了解极限实验室的发布最新产品和功能特性,通过动手实战,快速掌握最前沿的搜索技术,并用于实际项目中。欢迎大家扫描海报二维码免费报名参加。

活动时间:2024-01-18 13:30~17:30

活动地点:北京市海淀区 Wework 辉煌时代大厦 3 楼 3E 会议室

分享议题

- Easysearch 总体介绍及搭建实战

- 基于 INFINI Console 实现跨版本、跨引擎统一管控

- Elasticsearch -> Easysearch 在线迁移实操

参会提示

- 请务必自备电脑(Windows 系统环境请提前安装好 Linux 虚拟机)

- 请提前在 INFINI Labs 官网下载对应平台最新安装包(INFINI Easysearch、INFINI Gateway、INFINI Console)

- 下载地址:https://www.infinilabs.com/download

- 如有任何疑问可添加 INFINI Labs 小助手(微信号: INFINI-Labs)进行联系

elasticsearcg索引配置不变,doc数量不变却越写越慢

回复Elasticsearch • kin122 回复了问题 • 2 人关注 • 3 个回复 • 12584 次浏览 • 2025-07-30 08:47

【字节跳动】 深圳/上海招聘Elasticsearch研发工程师

回复求职招聘 • tinycols 发起了问题 • 1 人关注 • 0 个回复 • 4227 次浏览 • 2024-12-05 16:57

3月26日 OpenSearch Community Meeting 视频回放

回复OpenSearch • Charele 回复了问题 • 2 人关注 • 1 个回复 • 5941 次浏览 • 2024-04-05 16:58

ElasticSearch自动补全,中文不准确的问题,请大家帮我看一下

回复Elasticsearch • God_lockin 回复了问题 • 2 人关注 • 1 个回复 • 4310 次浏览 • 2023-11-21 22:17

【搜索客社区日报】第2174期 (2026-01-05)

社区日报 • Muses 发表了文章 • 0 个评论 • 15521 次浏览 • 2026-01-05 10:49

【搜索客社区日报】第2150期 (2025-11-24)

社区日报 • Muses 发表了文章 • 0 个评论 • 8314 次浏览 • 2025-11-24 16:00

【搜索客社区日报】第2138期 (2025-11-03)

社区日报 • Muses 发表了文章 • 0 个评论 • 8220 次浏览 • 2025-11-03 20:22

搜索百科(6):Meilisearch — Rust 打造的轻量级搜索新锐

开源项目 • liaosy 发表了文章 • 0 个评论 • 9851 次浏览 • 2025-10-31 18:00

大家好,我是 INFINI Labs 的石阳。

欢迎关注 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

在之前的几期中,我们认识了搜索技术的基石 Lucene、企业级搜索先锋 Solr、搜索界的“流量明星” Elasticsearch 以及它的分叉兄弟 OpenSearch 和 ES 国产替代方案 Easysearch。它们大多基于 Lucene 构建,形成了庞大且功能丰富的生态。

今天,我们将介绍一位“非主流”选手:一款基于 Rust 编写、主打“快”和“简单”的现代搜索引擎——Meilisearch。它以全新的姿态,为开发者带来了不同的搜索体验。

Meilisearch 概述

Meilisearch 是一款开源的、用 Rust 编写的即时搜索引擎。它提供了一个快速、轻量且可定制的搜索 API,旨在为用户提供毫秒级的搜索体验。

它的核心优势在于为应用内搜索和电商搜索等对延迟敏感的场景提供了出色的用户体验。

- 首次发布:2020 年

- 最新版本:1.24.0(截止 2025 年 10 月)

- 核心语言:Rust

- 开源协议:MIT License

- 官方网址:https://www.meilisearch.com/

- GitHub 仓库:https://github.com/meilisearch/meilisearch

诞生故事

Meilisearch 的故事始于 2018 年,当时法国工程师 Quentin de Quelen 在开发一个电商项目时,发现现有的搜索引擎要么太重量级,要么配置太复杂。他想要一个"开箱即用"的搜索解决方案,能够快速集成到应用中,并提供优秀的搜索体验。

于是,他决定用 Rust 语言从头编写一个搜索引擎。选择 Rust 是因为其出色的性能、内存安全性和并发能力,非常适合构建高性能的搜索核心。

项目最初只是一个内部工具,但随着功能的完善和社区的反馈,Meilisearch 在 2019 年正式开源,并迅速获得了开发者的青睐。2020 年,团队获得了 150 万美元的种子轮融资,正式成立了 Meilisearch 公司。

核心特性

Meilisearch 在设计上做了大量的取舍,专注于核心的搜索功能,但做到了极致。

- 极速响应:核心目标是实现 50 毫秒以下的响应时间,即使在大型数据集中也能提供“所见即所得”的搜索体验。

- 零配置:开箱即用,部署和索引数据都非常简单,不需要预定义 Schema 或复杂的配置文件。

- 相关的默认值:内置一个强大的 相关性排名(Relevance Ranking) 算法,结合 Typos(拼写错误)、Word Proximity(词语距离)和 Attributes(字段权重)等因素,无需额外调优即可获得高质量的搜索结果。

- 语言无关性:支持多种语言的分词与搜索,能很好地处理中文、日文等非拉丁语系文本。

- 无分布式架构:为了追求极致的速度和简单性,Meilisearch 被设计为单机搜索引擎,不支持开箱即用的分布式集群,这简化了运维,但也限制了其 PB 级数据的处理能力。

对比优势:Meilisearch vs Lucene/ES 体系

Meilisearch 与基于 Lucene 的 Elasticsearch 体系,在设计哲学上有着本质区别:

| 特性 | Meilisearch | Elasticsearch |

|---|---|---|

| 核心目标 | 极速的应用内搜索体验 | 分布式搜索、日志分析、可观测性 |

| 基础架构 | 单机、轻量级 | 分布式集群(主从节点、分片) |

| 核心语言 | Rust | Java(基于 Lucene) |

| 性能瓶颈 | 单机 CPU / 内存限制 | 分布式协调开销 |

| 上手难度 | 简单,开箱即用,REST API | 相对复杂,需要了解集群、分片等概念 |

| 数据规模 | 适合中小型数据集(GB 级别) | 适合大型和超大型数据集(TB/PB 级别) |

| 全文检索 | 依赖内置的强相关性算法 | 依赖 Lucene 强大的分词、查询解析器 |

总结:

- 如果你的应用需要超低延迟、简单部署、数据量在 GB 级别,并且搜索是应用的核心功能,Meilisearch 是一个极佳的选择。

- 如果你的需求涉及日志分析、大规模数据存储、集群高可用和复杂的聚合分析,那么 Elasticsearch 仍然是更成熟和全面的解决方案。

快速上手:5 分钟体验 Meilisearch

部署 Meilisearch 非常简单,你甚至不需要 Docker,只需一个命令即可运行。

1. 运行 Meilisearch

# 安装 Meilisearch

curl -L https://install.meilisearch.com | sh

# 启动 Meilisearch

meilisearch --master-key 'aStrongMasterKey'

# 或使用 Docker

docker run -it --rm -p 7700:7700 getmeili/meilisearch:latest --master-key 'aStrongMasterKey'2. 添加索引(创建 Index)

Meilisearch 不需要预先定义索引结构(Schema-less)。

curl -X POST 'http://localhost:7700/indexes' \

-H 'Authorization: Bearer aStrongMasterKey' \

-H 'Content-Type: application/json' \

--data-binary '{

"uid": "movies",

"primaryKey": "id"

}'3. 索引文档(添加 Documents)

curl -X POST 'http://localhost:7700/indexes/movies/documents' \

-H 'Authorization: Bearer aStrongMasterKey' \

-H 'Content-Type: application/json' \

--data-binary '[

{"id": 1, "title": "泰坦尼克号", "genres": ["剧情", "爱情"]},

{"id": 2, "title": "黑客帝国", "genres": ["科幻", "动作"]}

]'4. 执行搜索

# 搜索关键词 "泰坦"

curl -X GET 'http://localhost:7700/indexes/movies/search?q=泰坦'返回结果:

{

"hits": [

{

"id": 1,

"title": "泰坦尼克号",

"genres": ["剧情", "爱情"]

}

],

"offset": 0,

"limit": 20,

"estimatedTotalHits": 1,

"processingTimeMs": 1,

"query": "泰坦"

}注意 processingTimeMs: 1,这是 Meilisearch 速度的最好证明!

5. 场景演示

结语

Meilisearch 的出现,代表了新一代搜索引擎对于开发者体验和即时性的追求。它在应用内搜索领域展现了强大的竞争力,证明了不必依赖 Lucene 的庞大体系,也能打造出极致性能的搜索产品。

虽然它还无法完全取代 Elasticsearch 在日志分析、可观测性等大型分布式场景的地位,但在许多新兴应用和对搜索速度有极高要求的场景中,它无疑是一个值得尝试的开源新星。

🚀 下期预告

下一篇我们将把目光转向搜索领域的云端先锋 —— Algolia。作为搜索即服务(Search-as-a-Service)的开创者,Algolia 如何以其卓越的 API 设计、惊人的搜索速度和精准的相关性排序,重新定义云端搜索体验?

💬 三连互动

- 你会把 ES/Solr 换成 Meilisearch 吗?

- 在你的应用中,搜索延迟达到多少毫秒你会觉得无法接受?

- 在什么场景下你会考虑使用 Meilisearch 而不是 Elasticsearch?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

- 搜索百科(5):Easysearch — 自主可控的国产分布式搜索引擎

- 搜索百科(4):OpenSearch — 开源搜索的新选择

- 搜索百科(3):Elasticsearch — 搜索界的"流量明星"

- 搜索百科(2):Apache Solr — 企业级搜索的开源先锋

- 搜索百科(1):Lucene — 打开现代搜索世界的第一扇门

🔗 参考资源

【搜索客社区日报】第2134期 (2025-10-27)

社区日报 • Muses 发表了文章 • 0 个评论 • 8275 次浏览 • 2025-10-27 17:18

搜索百科(5):Easysearch — 自主可控的国产分布式搜索引擎

Easysearch • liaosy 发表了文章 • 0 个评论 • 7464 次浏览 • 2025-10-20 15:54

大家好,我是 INFINI Labs 的石阳。

欢迎关注 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

在上一篇我们介绍了 OpenSearch —— 那个因协议争议而诞生的开源搜索分支。今天,我们把目光转向国内,聊聊极限科技研发的一款轻量级搜索引擎:Easysearch。

引言

在搜索技术的世界里,从 Lucene 的出现到 Solr、Elasticsearch 的崛起,搜索引擎技术已经发展了二十余年。然而,随着开源协议的变更与国际形势的变化,国产自主搜索引擎的需求愈发迫切。在这样的背景下,Easysearch 作为一款自主可控、轻量高效、兼容 Elasticsearch 的分布式搜索引擎应运而生,为国内企业带来了全新的选择。

Easysearch 概述

Easysearch 是一款分布式搜索型数据库,实现非结构化数据检索、全文检索、向量检索、地理位置信息查询、组合索引查询、多语种支持、聚合分析、AI 集成等。Easysearch 衍生自开源协议 Apache 2.0 的 Elasticsearch 7.10 版本,并不断往前迭代更新,紧跟 Lucene 最新版本的更新。Easysearch 可以替代 Elasticsearch,同时添加和完善多项企业级功能。

- 首次发布:2023 年 4 月

- 最新版本:1.15.4(截止 2025 年 10 月)

- 主导企业:极限科技 (INFINI Labs)

- 官方网址:https://easysearch.cn

诞生背景:为什么要有 Easysearch?

Easysearch 由极限科技(INFINI Labs)团队推出。项目的起点源于团队长期在搜索引擎和大数据领域的深厚实践积累,团队深刻认识到国内企业在使用 Elasticsearch 时普遍面临以下痛点:

- 开源协议变化带来的商业风险 —— Elastic 于 2021 年将许可更改为 SSPL,导致社区分裂,增加了企业在合规和商用上的不确定性;

- 高并发与高可靠性场景下对稳定可控方案的需求 —— 企业级应用亟需一个性能可靠、可深度优化的搜索基础设施;

- 技术栈自主可控的迫切需求 —— 随着国产化进程加快,国内生态中缺乏轻量化、易部署、且完全可控的搜索引擎产品;

- 本地化服务与快速响应能力的缺口 —— 国内企业更需要本地团队提供高效的技术支持与服务,对本土化、个性化功能需求能得到及时响应与反馈。

基于这些考虑,Easysearch 在设计之初就明确了目标:构建一款兼容 Elasticsearch API、简洁易用、性能出众且完全自主可控的国产搜索引擎。

核心特性

- 轻量级:安装包大小不到 60 MB,安装部署简洁,资源占用低,开箱即用;

- 跨平台:支持主流操作系统和 CPU 架构,支持国产信创运行环境;

- 高性能:针对不同场景进行的极致优化,可用更少硬件成本获得更高服务性能,降本增效。

- 稳定可靠:修复大量内核问题,解决内存泄露,集群卡顿、查询缓慢等问题,久经严苛业务环境考验。

- 安全增强:默认就提供完整的企业级安全功能,支持 LDAP/AD 集成,支持索引、文档、字段粒度细权管控。

- 兼容性强:兼容 Elasticsearch 7.x 的 REST API 和数据格式,迁移成本低;

- 可视化运维:无需 Kibana 即可通过内置 Web UI 插件界面管理索引、节点与监控指标等。

对比优势

| 对比维度 | Easysearch | Elasticsearch | OpenSearch |

|---|---|---|---|

| 用户协议 | 社区免费+商业授权 | SSPL/AGPL v3 | Apache 2.0 |

| API 兼容性 | 高度兼容 ES | 原生 | 高度兼容 ES |

| 最小安装体积 | 57MB | 482MB | 682MB |

| 部署复杂度 | 简单 | 中等 | 相对复杂 |

| 信创环境支持 | 全面兼容 | 无 | 无 |

| 可视化管理 | 开箱即用管理后台 | 需独立部署 Kibana | 需独立部署 OpenSearch Dashboards |

| 本地化与中文支持 | 强 | 弱 | 弱 |

| AI 插件支持 | 较弱 | 强 | 较强 |

| 社区与生态 | 快速成长中 | 成熟广泛 | 活跃增长 |

快速开始:5 分钟体验 Easysearch

1. 使用 Docker 启动

# 直接运行镜像使用随机密码(数据及配置未持久化)

docker run --name easysearch \

--ulimit memlock=-1:-1 \

-p 9200:9200 \

infinilabs/easysearch:1.15.42. 验证集群状态

curl -ku "username:password" -X GET "https://localhost:9200/"返回结果示例:

{

"name": "easysearch-node",

"cluster_name": "easysearch-6yhwn91v80gf",

"cluster_uuid": "Gfu_fuF1QViJfeUWVbiFCA",

"version": {

"distribution": "easysearch",

"number": "1.15.4",

"distributor": "INFINI Labs",

"build_hash": "9110128946b0af3de639966cfa74b5498346949d",

"build_date": "2025-10-14T03:30:41.948590Z",

"build_snapshot": false,

"lucene_version": "8.11.4",

"minimum_wire_lucene_version": "7.7.0",

"minimum_lucene_index_compatibility_version": "7.7.0"

},

"tagline": "You Know, For Easy Search!"

}3. 索引与搜索示例

# 写入文档

curl -ku "username:password" -X POST "https://localhost:9200/my_index/_doc" -H 'Content-Type: application/json' -d'

{

"title": "Easysearch 入门",

"content": "这是一个轻量级搜索引擎的示例文档。",

"tags": ["搜索", "国产", "轻量级"]

}'

# 搜索文档

curl -ku "username:password" -X GET "https://localhost:9200/my_index/_search" -H 'Content-Type: application/json' -d'

{

"query": {

"match": {

"content": "搜索引擎"

}

}

}'4. 使用 Easysearch UI

Easysearch 提供了轻量级界面化管理功能,不再依赖第三方组件即可对集群进行管理,真正做到开箱即用。如果你安装了 Easysearch UI 插件或者下载捆绑包,可通过 https://localhost:9200/\_ui/ 访问,进行节点、索引、分片、查询调试和监控查看等管理。

图 1:系统登录

图 2:集群概览

图 3:节点列表

图 4:节点概览

图 5:索引列表

图 6:索引概览

图 7:分片管理

图 8:开发工具

以上仅列出了一些基本功能,其他如安全管理、主从复制、备份管理、生命周期管理等更多高级功能由于篇幅限制不一一展示,有兴趣的朋友可自行部署探索。

结语

Easysearch 的诞生,不仅填补了国产搜索引擎在分布式与轻量化领域的空白,也让更多企业在面对开源协议变动与外部技术依赖时,拥有了更加安全、灵活、可控的选择。

它既是国产替代方案的有力代表,更是新一代搜索技术生态的积极探索者,为企业级实时搜索与分析带来新的可能。

🚀 下期预告

下一篇我们将介绍 一款 AI 驱动的现代搜索引擎 - Meilisearch,基于 Rust 构建的开源搜索引擎,性能高、部署简单。号称比 Elasticsearch 快 10 倍,真的这么牛吗?

💬 三连互动

- 你是否在使用或考虑国产搜索替代方案?

- 在实际项目中,你最看重搜索引擎的哪些特性?(性能、兼容性、运维、成本)

- 对 Easysearch 有什么功能上的期待?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

- 搜索百科(4):OpenSearch — 开源搜索的新选择

- 搜索百科(3):Elasticsearch — 搜索界的"流量明星"

- 搜索百科(2):Apache Solr — 企业级搜索的开源先锋

- 搜索百科(1):Lucene — 打开现代搜索世界的第一扇门

🔗 参考资源

原文:https://infinilabs.cn/blog/2025/search-wiki-5-easysearch/

【搜索客社区日报】第2130期 (2025-10-20)

社区日报 • Muses 发表了文章 • 0 个评论 • 6542 次浏览 • 2025-10-20 14:45

【搜索客社区日报】第2123期 (2025-09-29)

社区日报 • Muses 发表了文章 • 0 个评论 • 10181 次浏览 • 2025-09-29 15:18

【搜索客社区日报】第2119期 (2025-09-22)

社区日报 • Muses 发表了文章 • 0 个评论 • 12165 次浏览 • 2025-09-22 13:44

招聘!搜索运维工程师(Elasticsearch/Easysearch)-全职/北京/12-20K

求职招聘 • INFINI Labs 小助手 发表了文章 • 0 个评论 • 10597 次浏览 • 2025-09-22 12:33

极限科技诚招全职搜索运维工程师(Elasticsearch/Easysearch)!

欢迎搜索技术热爱者加入我们,共同打造高效、智能的搜索解决方案!

在招岗位介绍

岗位名称

搜索运维工程师(Elasticsearch/Easysearch)

Base:北京

薪资待遇:12-20K,五险一金,双休等

岗位职责

- 负责客户现场的 Elasticsearch/Easysearch/OpenSearch 搜索引擎集群的日常维护、监控和优化,确保集群的高可用性和性能稳定;

- 协助客户进行搜索引擎集群的部署、配置及版本升级;

- 排查和解决 Elasticsearch/Easysearch/OpenSearch 集群中的各种技术问题,及时响应并处理集群异常;

- 根据业务需求设计和实施搜索索引的调优、数据迁移和扩展方案;

- 负责与客户沟通,提供技术支持及相关培训,确保客户需求得到有效满足;

- 制定并实施搜索引擎的备份、恢复和安全策略,保障数据安全;

- 与内部研发团队和外部客户进行协作,推动集群性能改进和功能优化。

岗位要求

- 全日制本科及以上学历,2 年以上运维工作经验;

- 拥有 Elasticsearch/Easysearch/OpenSearch 使用经验,熟悉搜索引擎的原理、架构和相关生态工具(如 Logstash、Kibana 等);

- 熟悉 Linux 操作系统的使用及常见性能调优方法;

- 熟练掌握 Shell 或 Python 等至少一种脚本语言,能够编写自动化运维脚本;

- 具有优秀的问题分析与解决能力,能够快速应对突发情况;

- 具备良好的沟通能力和团队合作精神,能够接受客户驻场工作;

- 提供 五险一金,享有带薪年假及法定节假日。

加分项

- 计算机科学、信息技术或相关专业;

- 具备丰富的大规模分布式系统运维经验;

- 熟悉 Elasticsearch/Easysearch/OpenSearch 分片、路由、查询优化等高级功能;

- 拥有 Elastic Certified Engineer 认证;

- 具备大规模搜索引擎集群设计、扩展和调优经验;

- 熟悉其他搜索引擎技术(如 Solr、Lucene)者优先;

- 熟悉大数据处理相关技术(比如: Kafka 、Flink 等)者优先。

简历投递

- 邮件:hello@infini.ltd(邮件标题请备注姓名 求职岗位)

- 微信:INFINI-Labs (加微请备注求职岗位)

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

我们在做什么

极限科技(INFINI Labs)正在致力于以下几个核心方向:

1、开发近实时搜索引擎 INFINI Easysearch INFINI Easysearch 是一个分布式的搜索型数据库,实现非结构化数据检索、全文检索、向量检索、地理位置信息查询、组合索引查询、多语种支持、聚合分析等。Easysearch 可以替代 Elasticsearch,同时添加和完善多项企业级功能。Easysearch 助您拥有简洁、高效、易用的搜索体验。详情参见:https://infinilabs.cn

2、打造下一代实时搜索引擎 INFINI Pizza INFINI Pizza 是一个分布式混合搜索数据库系统。我们的使命是充分利用现代硬件和人工智能的潜力,为企业提供量身定制的实时智能搜索体验。我们致力于满足具有挑战性的环境中高并发和高吞吐量的需求,同时提供无缝高效的搜索功能。详情参见:https://pizza.rs

3、为现代团队打造的统一搜索与 AI 智能助手 Coco AI Coco AI 是一款完全开源的统一搜索与 AI 助手平台,它通过统一搜索入口,连接企业内外部的异构数据源,融合大模型能力,帮助团队高效访问知识,智能决策协作。详情参见:https://coco.rs

4、积极参与全球开源生态建设 通过开源 Coco AI、Console、Gateway、Agent、Loadgen 等搜索领域产品和社区贡献,推动全球开源技术的发展,提升中国在全球开源领域的影响力。INFINI Labs Github 主页:https://github.com/infinilabs

5、提供专业服务 为客户提供包括搜索技术支持、迁移服务、定制解决方案和培训在内的全方位服务。

6、提供国产化搜索解决方案 针对中国市场的特殊需求,提供符合国产化标准的搜索产品和解决方案,帮助客户解决使用 Elasticsearch 时遇到的挑战。

极限科技(INFINI Labs)通过这些努力,旨在成为全球领先的实时搜索和数据分析解决方案提供商。

如何使用极限网关实现 Elasticsearch 集群迁移至 Easysearch

Elasticsearch • INFINI Labs 小助手 发表了文章 • 0 个评论 • 15001 次浏览 • 2025-09-21 14:50

之前有博客介绍过通过 Reindex 的方法将 Elasticsearch 的数据迁移到 Easysearch 集群,今天再介绍一个方法,通过 极限网关(INFINI Gateway) 来进行数据迁移。

测试环境

| 软件 | 版本 |

|---|---|

| Easysearch | 1.12.0 |

| Elasticsearch | 7.17.29 |

| INFINI Gateway | 1.29.2 |

迁移步骤

- 选定要迁移的索引

- 在目标集群建立索引的 mapping 和 setting

- 准备 INFINI Gateway 迁移配置

- 运行 INFINI Gateway 进行数据迁移

迁移实战

- 选定要迁移的索引

在 Elasticsearch 集群中选择目标索引:infinilabs 和 test1,没错,我们一次可以迁移多个。

- 在 Easysearch 集群使用源索引的 setting 和 mapping 建立目标索引。(略)

- INFINI Gateway 迁移配置准备

去 github 下载配置,修改下面的连接集群的部分

1 env:

2 LR_GATEWAY_API_HOST: 127.0.0.1:2900

3 SRC_ELASTICSEARCH_ENDPOINT: http://127.0.0.1:9200

4 DST_ELASTICSEARCH_ENDPOINT: http://127.0.0.1:9201

5 path.data: data

6 path.logs: log

7 progress_bar.enabled: true

8 configs.auto_reload: true

9

10 api:

11 enabled: true

12 network:

13 binding: $[[env.LR_GATEWAY_API_HOST]]

14

15 elasticsearch:

16 - name: source

17 enabled: true

18 endpoint: $[[env.SRC_ELASTICSEARCH_ENDPOINT]]

19 basic_auth:

20 username: elastic

21 password: goodgoodstudy

22

23 - name: target

24 enabled: true

25 endpoint: $[[env.DST_ELASTICSEARCH_ENDPOINT]]

26 basic_auth:

27 username: admin

28 password: 14da41c79ad2d744b90cpipeline 部分修改要迁移的索引名称,我们迁移 infinilabs 和 test1 两个索引。

31 pipeline:

32 - name: source_scroll

33 auto_start: true

34 keep_running: false

35 processor:

36 - es_scroll:

37 slice_size: 1

38 batch_size: 5000

39 indices: "infinilabs,test1"

40 elasticsearch: source

41 output_queue: source_index_dump

42 partition_size: 1

43 scroll_time: "5m"- 迁移数据

./gateway-mac-arm64

#如果你保存的配置文件名称不叫 gateway.yml,则需要加参数 -config 文件名

数据导入完成后,网关 ctrl+c 退出。

至此,数据迁移就完成了。下一篇我们来介绍 INFINI Gateway 的数据比对功能。

有任何问题,欢迎加我微信沟通。

关于极限网关(INFINI Gateway)

INFINI Gateway 是一个开源的面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway,可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。

官网文档:https://docs.infinilabs.com/gateway

开源地址:https://github.com/infinilabs/gateway

搜索百科(4):OpenSearch — 开源搜索的新选择

OpenSearch • liaosy 发表了文章 • 0 个评论 • 9272 次浏览 • 2025-09-21 14:31

大家好,我是 INFINI Labs 的石阳。

欢迎关注 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

上一篇我们围观了 “流量明星” Elasticsearch — 从食谱搜索到 PB 级明星产品,从 Apache 2.0 到 SSPL 协议风波;今天我们来聊聊它的“分叉兄弟” OpenSearch。

引言

2021 年,当 Elasticsearch 宣布将其许可证从 Apache 2.0 变更为 SSPL/Elastic License 时,整个搜索社区为之震动。这一变更直接催生了一个新的开源分支 — OpenSearch。这个由 AWS 主导的项目不仅在短短几年内迅速发展成熟,更成为了许多企业在云原生环境下搜索解决方案的新选择。

OpenSearch 概述

OpenSearch 是从 Elasticsearch 7.10.2 分支而来的开源搜索与分析套件,由 AWS 主导开发并贡献给开源社区。OpenSearch 包括 OpenSearch(搜索引擎)和 OpenSearch Dashboards(可视化界面),完全兼容 Apache 2.0 协议,旨在为用户提供一个真正开源、社区驱动的搜索与分析解决方案。

- 首次发布:2021 年 4 月

- 最新版本:3.2.0(截止 2025 年 9 月)

- 开源协议:Apache License 2.0

- 主导企业:Amazon Web Services (AWS)

- 官方网址:https://opensearch.org/

- GitHub 仓库:https://github.com/opensearch-project

诞生故事:开源协议争议的产物

时间回到 2021 年 1 月,Elastic 公司宣布 Elasticsearch 从 7.11 版本起不再使用 Apache 2.0 协议,而改为 Elastic License 与 SSPL。这一决定立刻在社区和产业界引发巨大争议。

AWS(亚马逊云)作为 Elasticsearch 的重要用户与云服务提供商,不愿意被 Elastic 的商业条款所限制,随即牵头将 Elasticsearch 7.10 版本 fork 出来,并与 Kibana 一起重命名为 OpenSearch 与 OpenSearch Dashboards。

从此,开源世界分裂成了两条路线:

- Elastic 官方的 Elasticsearch + Kibana(带有商业许可)。

- 社区驱动的 OpenSearch + OpenSearch Dashboards(继续遵循 Apache 2.0 协议)。

这个分叉,既是开源协议之争的产物,也是云厂商与开源公司之间博弈的缩影。虽然初期被质疑过“是否真开源”,但经过数年的迭代,OpenSearch 已形成了相对独立的开发节奏和用户群体,插件和生态也逐渐丰富。

技术架构与特性

OpenSearch 是一个基于 Apache Lucene 的分布式搜索与分析引擎。在将数据添加到 OpenSearch 后,可以对其执行各种功能完备的全文搜索操作:按字段搜索、跨多个索引搜索、提升字段权重、按得分排序结果、按字段排序结果以及对结果进行聚合。

OpenSearch 的核心架构由集群、节点、索引、分片和文档组成。最高层是 OpenSearch 集群,它是由多个节点组成的分布式网络,每个节点会根据其类型负责不同的集群操作。数据节点负责存储索引(即文档的逻辑分组),并处理数据写入、搜索和聚合等任务。

每个索引会被划分为多个分片,分片包含主数据和副本数据。分片会分布在多台机器上,从而实现水平扩展,提升性能并高效利用存储资源。

OpenSearch vs Elasticsearch:详细对比

| 特性 | OpenSearch | Elasticsearch |

|---|---|---|

| 许可证 | Apache 2.0(完全开源) | SSPL/Elastic License/AGPLv3 |

| 起始版本 | 基于 Elasticsearch 7.10.2 | 从 7.11 开始协议变更 |

| 社区治理 | 开放治理模式,由社区驱动 | 由 Elastic NV 公司主导 |

| 安全性 | 所有安全功能默认开源 | 部分高级安全功能需要付费 |

| AI/向量检索 | 近年快速跟进,兼容性较好 | 原生支持,功能逐步增强 |

| 部署选择 | AWS OpenSearch Service / 自建 | Elastic Cloud / 自建 |

| 升级路径 | 从 Elasticsearch 7.x 平滑迁移 | 原生升级路径 |

| 社区活跃度 | 社区逐渐壮大,受到纯开源拥护者欢迎 | 用户基础庞大,但分裂带来争议 |

快速开始:5 分钟部署 OpenSearch

1. 使用 Docker 部署

# 拉取 OpenSearch 镜像

docker pull opensearchproject/opensearch:3.2.0

# 启动 OpenSearch 节点

docker run -d --name opensearch-node \

-p 9200:9200 -p 9600:9600 \

-e "discovery.type=single-node" \

-e "plugins.security.disabled=true" \

opensearchproject/opensearch:3.2.0

# 拉取 OpenSearch Dashboards

docker pull opensearchproject/opensearch-dashboards:3.2.0

# 启动 Dashboards

docker run -d --name opensearch-dashboards \

-p 5601:5601 \

-e "OPENSEARCH_HOSTS=http://opensearch-node:9200" \

opensearchproject/opensearch-dashboards:3.2.02. 验证安装

# 检查集群状态

curl -X GET "http://localhost:9200/"出现如下结果说明安装成功。

3. 创建索引和搜索

# 索引文档

curl -X POST "http://localhost:9200/my-first-index/_doc" -H 'Content-Type: application/json' -d'

{

"title": "OpenSearch 入门指南",

"content": "这是我在 OpenSearch 中的第一个文档",

"timestamp": "2025-09-18T10:00:00"

}'

# 执行搜索

curl -X GET "http://localhost:9200/my-first-index/_search" -H 'Content-Type: application/json' -d'

{

"query": {

"match": {

"content": "第一个文档"

}

}

}'4. 访问控制台

打开浏览器访问 http://localhost:5601 即可使用 OpenSearch Dashboards 界面。

结语

OpenSearch 的出现,是开源社区的一次“自救”。它不仅延续了 Elasticsearch 的核心功能,还代表了另一种治理模式:由云厂商和社区共同维护,保证了开源协议的延续。

在搜索技术的版图里,Elasticsearch 与 OpenSearch 的分叉,注定会成为一个重要的历史节点。未来,两者可能会继续竞争,也可能各自发展出独特的生态。

🚀 下期预告

下一篇我们将介绍 OpenSearch 的另一个兄弟 Easysearch,一个衍生自开源协议 Apache 2.0 的 Elasticsearch 7.10.2 版本的轻量级搜索引擎,作为一个 ES 国产替代方案,看看它如何以其极致的速度和易用性在国内搜索领域占据一席之地。

💬 三连互动

- 您是否考虑过从 Elasticsearch 迁移到 OpenSearch?

- 在开源协议方面,您更倾向于哪种模式?Apache 2.0 还是 Elastic 的多重许可?

- 对于云厂商与开源项目之间的关系,您有什么看法?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

🔗 参考资源

原文:https://infinilabs.cn/blog/2025/search-wiki-4-opensearch/

Easysearch 国产替代 Elasticsearch:8 大核心问题解读

Easysearch • liaosy 发表了文章 • 0 个评论 • 11905 次浏览 • 2025-09-18 09:43

近年来,随着数据安全与自主可控需求的不断提升,越来越多的企业开始关注国产化的搜索与日志分析解决方案。作为极限科技推出的国产 Elasticsearch 替代产品,Easysearch 凭借其对搜索场景的深入优化、轻量级架构设计以及对 ES 生态的高度兼容,成为众多企业替代 Elasticsearch 的新选择。

我们在近期与用户的交流中,整理出了大家最关心的八大问题,并将它们浓缩为一篇技术解读,希望帮助你快速了解 Easysearch 的优势与定位。

用户最关心的八大问题

- Easysearch 对数据量的支撑能力如何,能应对 PB 级数据存储吗?

答:完全可以。Easysearch 支持水平扩展,通过增加节点即可线性提升存储与计算能力。在实际应用中,已成功支撑 PB 级日志与检索数据。同时,其存储压缩率相比 Elasticsearch 7.10.2 平均高出 2.5~3 倍,显著节省硬件成本。

- 在高并发写入场景下,Easysearch 和 ES 的性能差异有多大?

答:在相同硬件配置下,使用 Nginx 日志进行 bulk 写入压测,Easysearch 在多种分片配置下的写入性能相比 Elasticsearch 7.10.2 提升 40%-70%,更适合高并发写入场景。

- 是否支持中文分词?需要额外插件吗?

答:中文分词一直是 Elasticsearch 用户的「必装插件」。而在 Easysearch 中,中文分词是开箱即用的,同时支持 ik、pinyin 等主流分词器,还能自定义词典,方便电商、内容平台等场景。

- 从 ES 迁移到 Easysearch 是否复杂?会影响业务吗?

答:迁移往往是国产替代的最大顾虑。为此,Easysearch 提供了 极限网关 工具,支持全量同步和实时增量同步。迁移过程中业务可继续读写,只需短暂切换连接地址,几乎无感知。

- 监控与运维工具是否完善?是否支持 Kibana?

答:Easysearch 提供完整的监控与运维体系。从 Easysearch 1.15.x 版本起自带 Web UI 管理控制台(类似简化版 Kibana),支持索引管理、查询调试、权限控制等功能。同时还提供 INFINI Console 实现多集群管理与深度监控等。也可以通过配置让 Kibana 连接 Easysearch(部分高级功能可能受限)。

- 小型团队技术能力有限,用 Easysearch 运维难度高吗?

答:Easysearch 的一大设计理念就是降低运维门槛。Easysearch 提供一键部署脚本,减少手动配置参数,支持自动分片均衡与故障节点恢复,无需专职运维人员也能稳定运行,非常适合技术资源有限的团队。

- Easysearch 是否支持数据备份与恢复?操作复杂吗?

答:支持快照(Snapshot),可备份到本地磁盘或对象存储(S3、OSS 等)。恢复时仅需执行快照恢复命令,满足企业级数据安全需求。

- 对比 ES,Easysearch 在使用体验上最大的不同是什么?

答:Easysearch 保持与 Elasticsearch 类似的接口与查询 DSL,用户几乎无学习成本即可上手。同时,它针对国产化环境和搜索场景做了优化,运维更轻量,成本更可控。

结语:Easysearch,国产化搜索的新选择

作为一款国产自主可控的搜索与日志分析引擎,Easysearch 不仅继承了 Elasticsearch 的核心能力,更在性能、易用性、资源效率和中文支持等方面进行了深度优化。对于希望实现国产化替代、降低运维成本、提升系统性能的企业来说,Easysearch 是一个值得认真考虑的新选择。

如果你正在评估 Elasticsearch 的替代方案,不妨从 Easysearch 开始,体验更轻量、更高效的搜索新架构。

如需了解更多技术细节与使用案例,欢迎访问官方文档与社区资源:

- Easysearch 官网文档

- Elasticsearch VS Easysearch 性能测试

- 使用 Easysearch,日志存储少一半

- Kibana OSS 7.10.2 连接 Easysearch

- 自建 ES 集群通过极限网关无缝迁移到云上

- INFINI Console 一站式的数据搜索分析与管理平台

搜索百科(3):Elasticsearch — 搜索界的“流量明星”

Elasticsearch • liaosy 发表了文章 • 0 个评论 • 16824 次浏览 • 2025-09-16 11:20

大家好,我是 INFINI Labs 的石阳。

欢迎关注 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

前两篇我们探讨了搜索技术的基石 Apache Lucene 和企业级搜索解决方案 Apache Solr。今天,我们来聊聊一个真正改变搜索游戏规则,但也充满争议的产品 — Elasticsearch。

引言

如果说 Lucene 是幕后英雄,那么 Elasticsearch 就是舞台中央的明星。借助 REST API、分布式架构、强大的生态系统,它让搜索 + 分析成为“马上可用”的服务形式。

在日志平台、可观察性、安全监控、AI 与语义检索等领域,Elasticsearch 的名字几乎成了默认选项。

Elasticsearch 概述

Elasticsearch 是一个开源的分布式搜索和分析引擎,构建于 Apache Lucene 之上。作为一个检索平台,它可以实时存储结构化、非结构化和向量数据,提供快速的混合和向量搜索,支持可观测性与安全分析,并以高性能、高准确性和高相关性实现 AI 驱动的应用。

- 首次发布:2010 年 2 月

- 最新版本:9.1.3(截止 2025 年 9 月)

- 核心依赖:Apache Lucene

- 开源协议:AGPL v3

- 官方网址:https://www.elastic.co/elasticsearch/

- GitHub 仓库:https://github.com/elastic/elasticsearch

起源:从食谱搜索到全球“流量明星”

Elasticsearch 的故事始于以色列开发者 Shay Banon。2010 年,当时他在学习厨师课程的妻子需要一款能够快速搜索食谱的工具。虽然当时已经有 Solr 这样的搜索解决方案,但 Shay 认为它们对于分布式场景的支持不够完善。

基于之前开发 Compass(一个基于 Lucene 的搜索库)的经验,Shay 开始构建一个完全分布式的、基于 JSON 的搜索引擎。2010 年 2 月,Elasticsearch 的第一个版本发布。

随着用户日益增多、企业级需求增强,Shay 在 2012 年创立了 Elastic 公司,把 Elasticsearch 不仅作为开源项目,也逐渐商业化运营起来,包括提供托管服务、企业支持,加入 Logstash 日志处理、Kibana 可视化工具等,Elastic 公司也逐渐从一个纯搜索引擎项目演变为一个更广泛的“数据搜索与分析”平台。

协议变更:开源和商业化的博弈

Elasticsearch 的发展并非一帆风顺。其历史上最具转折性的事件当属与 AWS 的冲突及随之而来的开源协议变更。

- 早期:Apache 2.0 协议

2010 年 Shay Banon 开源 Elasticsearch 时,最初采用的是 Apache 2.0 协议。Apache 2.0 属于宽松的自由协议,允许任何人免费使用、修改和商用(包括 SaaS 模式)。这帮助 Elasticsearch 快速壮大,成为事实上的“搜索引擎标准”。

- 协议变更:应对云厂商“白嫖”

随着 Elasticsearch 的流行,像 AWS(Amazon Web Services) 等云厂商直接将 Elasticsearch 做成托管服务,并从中获利。Elastic 公司认为这损害了他们的商业利益,因为云厂商“用开源赚钱,却没有回馈社区”。2021 年 1 月,Elastic 宣布 Elasticsearch 和 Kibana 不再采用 Apache 2.0,改为 双重协议:SSPL + Elastic License。这一步导致社区巨大分裂,AWS 带头将 Elasticsearch 分叉为 OpenSearch,并继续以 Apache 2.0 协议维护。

- 再次转向开源:AGPL v3

2024 年 3 月,Elastic 宣布新的版本(Elasticsearch 8.13 起)又新增 AGPL v3 作为一个开源许可选项。AGPL v3 既符合 OSI 真正开源标准,又能约束云厂商闭源托管服务,同时修复社区关系,Elastic 希望通过重新拥抱开源,减少分裂,吸引开发者回归。

Elasticsearch 从宽松到收紧,再到回归开源,是在社区生态与商业利益间寻找平衡的过程。

基本概念

要学习 Elasticsearch,得先了解其五大基本概览:集群、节点、分片、索引和文档。

- 集群(Cluster)

由一个或多个节点组成的整体,提供统一的搜索与存储服务。对外看起来像一个单一系统。

- 节点(Node)

集群中的一台服务器实例。节点有不同角色:

- Master 节点:负责集群管理(分片分配、元数据维护)。

- Data 节点:存储数据、处理搜索和聚合。

- Coordinating 节点:接收请求并调度任务。

- Ingest 节点:负责数据写入前的预处理。

- 索引(Index)

类似于传统数据库的“库”,按逻辑组织数据。一个索引往往对应一个业务场景(如日志、商品信息)。

- 分片(Shard)

为了让索引能水平扩展,Elasticsearch 会把索引拆分为多个 主分片,并为每个主分片创建 副本分片,提升高可用和查询性能。

- 文档(Document)

Elasticsearch 存储和检索的最小数据单元,通常是 JSON 格式。多个文档组成一个索引。

集群架构

Elasticsearch 通过 Master、Data、Coordinating、Ingest 等不同角色节点的协作,将数据切分成分片并分布式存储,实现了高可用、可扩展的搜索与分析引擎架构。

快速开始:5 分钟体验 Elasticsearch

1. 使用 Docker 启动

# 拉取最新镜像

docker pull docker.elastic.co/elasticsearch/elasticsearch:9.1.3

# 启动单节点集群

docker run -d --name elasticsearch \

-p 9200:9200 -p 9300:9300 \

-e "discovery.type=single-node" \

-e "xpack.security.enabled=false" \

docker.elastic.co/elasticsearch/elasticsearch:9.1.32. 验证安装

# 检查集群状态

curl -X GET "http://localhost:9200/"

3. 索引文档

# 索引文档

curl -X POST "http://localhost:9200/myindex/_doc" -H 'Content-Type: application/json' -d'

{

"title": "Hello Elasticsearch",

"description": "An example document"

}'

3. 搜索文档

# 搜索文档

curl -X GET "http://localhost:9200/myindex/_search" -H 'Content-Type: application/json' -d'

{

"query": {

"match": {

"title": "Hello"

}

}

}'

结语

Elasticsearch 是搜索与分析领域标杆性的产品。它将 Lucene 的能力包装起来,加上分布式、易用以及与数据可视化、安全监控等功能的整合,使搜索引擎从专业技术逐渐变为“随手可用”的基础设施。

虽然协议变动、与 OpenSearch 的分叉引发争议,但它在企业与开发者群体中的实际应用价值依然难以替代。

🚀 下期预告

下一篇我们将介绍 OpenSearch,探讨这个 Elasticsearch 分支项目的发展现状、技术特点以及与 Elasticsearch 的详细对比。如果您有特别关注的问题,欢迎提前提出!

💬 三连互动

- 你或公司最近在用 Elasticsearch 吗?拿来做了什么场景?

- 在 Elasticsearch 和 OpenSearch 之间做过技术选型?

- 对 Elasticsearch 的许可证变化有什么看法?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

🔗 参考

原文:https://infinilabs.cn/blog/2025/search-wiki-3-elasticsearch/

搜索百科(2):Apache Solr — 企业级搜索的开源先锋

开源项目 • liaosy 发表了文章 • 0 个评论 • 5743 次浏览 • 2025-09-15 18:12

大家好,我是 INFINI Labs 的石阳。

欢迎回到 《搜索百科》 专栏!每天 5 分钟,带你速览一款搜索相关的技术或产品,同时还会带你探索它们背后的技术原理、发展故事及上手体验等。

上一篇我们认识了搜索技术的基石 Apache Lucene,今天我们将继续这个旅程,了解基于 Lucene 构建的第一个成功商业级搜索平台 —— Apache Solr。

Solr 是什么?

Solr 是一款极速的开源多模态搜索平台,基于 Apache Lucene 的全文、向量和地理空间搜索能力构建而成。Solr 具备高可靠性、可扩展性和容错性,支持分布式索引、复制与负载均衡查询,提供自动故障转移与恢复、集中化配置等功能。如今,Solr 为全球众多大型互联网网站提供搜索和导航功能。

- 首次发布:2004 年,2006 年进入 Apache

- 最新版本:截至 2025 年,已更新至 9.x 系列

- 核心依赖:Apache Lucene

- 开源协议:Apache License 2.0

- 官方网址:https://solr.apache.org

- GitHub 仓库:https://github.com/apache/solr

它的定位是:把 Lucene 打造成独立的企业级搜索服务。相比 Lucene 需要写代码调用,Solr 提供了 Web 管理界面、REST API 和配置文件,让开发者更容易上手。

起源:从网站搜索到 Apache 顶级项目

Solr(读作"solar")的故事始于 2004 年,当时 CNET 公司的开发人员 Yonik Seeley 需要为其新闻网站构建一个搜索功能。虽然 Lucene 提供了强大的核心搜索能力,但直接使用 Lucene 需要编写大量 Java 代码,缺乏开箱即用的功能。

Seeley 决定在 Lucene 之上构建一个更易用的搜索服务器,于是 Solr 诞生了。最初的目标很明确:通过 HTTP/XML 接口提供搜索服务,让任何编程语言都能轻松集成搜索功能。

2006 年,Solr 捐赠给 Apache 基金会,2007 年成为顶级项目。2010 年,Solr 与 Lucene 项目合并,形成了今天我们所知的 Apache Lucene/Solr 项目。

技术架构

Index(索引)

Apache Solr 的索引就像是用于管理结构化 / 非结构化数据的“数据库”。它以便于分析和全文检索的方式存储数据。

Query Parser(查询解析器)

所有由客户端提交的查询都会由查询解析器处理。

Response Handler(响应处理器)

响应处理器负责为客户端生成合适格式的响应(如 JSON/XML/CSV)。

Update Handler(更新处理器)

更新处理器用于索引操作,即对索引中的数据进行插入、更新和删除。例如,如果我们希望 MySQL 数据与 Apache Solr 保持同步,就需要创建一个负责同步的更新处理器。

功能亮点

- 全文检索:高效支持关键词搜索、布尔查询、短语匹配等。

- 分面搜索(Faceted Search):可以对搜索结果进行分类和聚合统计。

- 分布式架构(SolrCloud):支持集群部署、自动分片、副本和容错。

- 丰富的数据接口:提供 RESTful API,支持 JSON、XML、CSV 等多种格式的数据交互。

- 扩展性与可定制性:通过插件机制支持多语言分词、排序、评分模型等个性化定制。

- 地理位置搜索:内置空间搜索能力,支持基于经纬度的范围查询和排序。

对比: Solr vs Elasticsearch 如何选择?

虽然两者都基于 Lucene,但在设计哲学上有所不同:

| 特性 | Apache Solr | Elasticsearch |

|---|---|---|

| 定位 | 企业级搜索服务器 | 分布式搜索和分析引擎 |

| API | 更标准化,遵循传统 REST | 更灵活,JSON 原生 |

| 分布式 | 需要 ZooKeeper 协调 | 内置分布式协调 |

| 上手难度 | 相对简单,开箱即用 | 学习曲线较陡峭 |

| 生态系统 | 搜索功能更丰富 | 分析和可视化更强 |

| 适用场景 | 传统企业搜索、电商 | 日志分析、实时监控 |

简单来说:Solr 更像"精装房",开箱即用;Elasticsearch 更像"毛坯房",需要更多自定义但更灵活。

快速开始:5 分钟搭建 Solr 服务

1. 下载和安装

# 下载 8.x 版 Solr

wget https://dlcdn.apache.org/solr/solr/8.11.4/solr-8.11.4.tgz

# 解压

tar -xzf solr-8.11.4.tgz

# 启动 Solr(单机模式)

cd solr-8.11.4

bin/solr start2. 创建 Core

# 创建测试 Core

bin/solr create -c test_core

# 查看 Core 状态

bin/solr status3. 索引文档

# 使用 curl 索引 JSON 文档

curl http://localhost:8983/solr/test_core/update -d '

[

{"id": "1", "title": "Solr 入门指南", "content": "Apache Solr 是企业级搜索平台"},

{"id": "2", "title": "搜索技术演进", "content": "从 Lucene 到 Solr 的技术发展"}

]' -H 'Content-type:application/json'

# 提交更改

curl http://localhost:8983/solr/test_core/update -d '<commit/>' -H 'Content-type:application/xml'4. 执行搜索

# 搜索"Solr"

curl "http://localhost:8983/solr/test_core/select?q=content:Solr"

# 使用 JSON 格式返回

curl "http://localhost:8983/solr/test_core/select?q=content:Solr&wt=json"执行搜索返回结果:

访问 http://localhost:8983/solr 即可使用 Solr 的管理界面。

Dashboard:

Core Admin:

结语

从最初的公司内部工具,到成为全球范围内广泛使用的开源搜索引擎,Apache Solr 见证并推动了搜索技术的进化。尽管近年来 Elasticsearch、向量数据库和 AI 驱动的搜索技术逐渐崛起,但 Solr 依然是许多企业可靠且成熟的选择。它的故事不仅属于开源社区,也代表了搜索技术发展的一个重要阶段。

🚀 下期预告

在下一篇「搜索百科」中,我们将介绍它的明星兄弟 —— Elasticsearch。

💬 三连互动

- 你现在还在用 Solr 吗?

- 在 Solr 和 Elasticsearch 之间做过技术选型?

- 遇到过有趣的 Solr 使用案例或挑战?

对搜索技术感兴趣的朋友,也欢迎加我微信(ID:lsy965145175)备注“搜索百科”,拉你进 搜索技术交流群,一起探讨与学习!

✨ 推荐阅读

🔗 参考