Elasticsearch:如何在不更新证书的情况下为集群之间建立互信

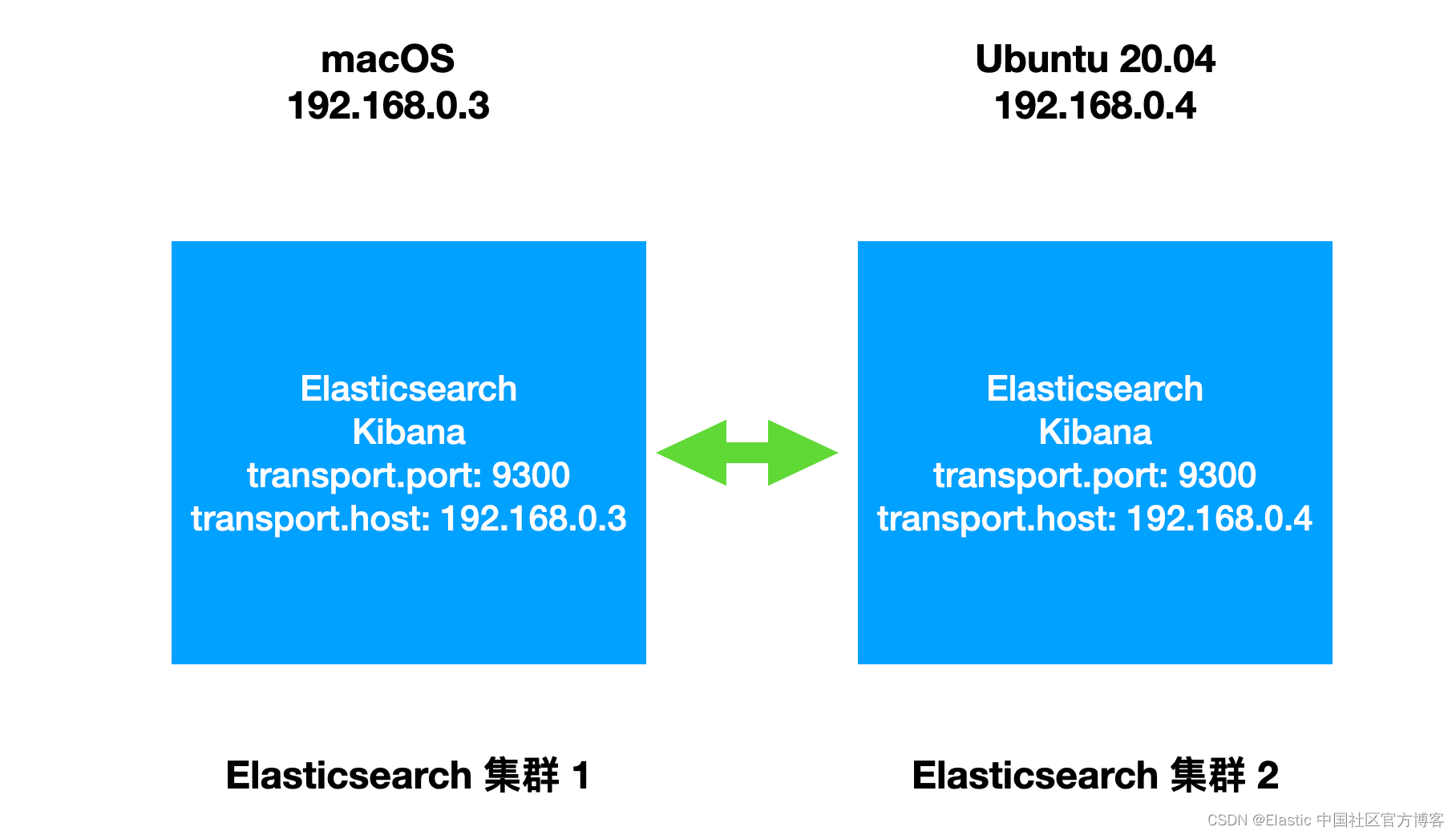

在今天的展示中,我将使用如下的架构:

如上所示,我们创建两个不同的集群。它们分别运行于两个不同的机器上。它们使用不同的 IP 地址。我将使用最新的 Elastic Stack 8.4.1 来进行展示。

如何在不更新证书的情况下为集群之间建立互信

针对非 keystore 及 truststore 的安装

如果你的 Elasticsearch 的部署不是按照 keystore 及 truststore 来进行安装的,而是参照我之前的文章 “Security:如何安装 Elastic SIEM 和 EDR” 来进行安装的话,那么你可以直接把另外一个集群的证书添加到相应的 config/elasticsearch.yml 的配置中去即可:

config/elasticsearch.yml

xpack.security.transport.ssl.enabled: true

xpack.security.transport.ssl.verification_mode: certificate

xpack.security.transport.ssl.key: /etc/elasticsearch/certs/elasticsearch.key

xpack.security.transport.ssl.certificate: /etc/elasticsearch/certs/elasticsearch.crt

xpack.security.transport.ssl.certificate_authorities: [ "/etc/elasticsearch/certs/ca/ca.crt", "certificate_from_another_cluster.crt ]

在这种情况下的配置就非常简单明了。我们就不赘述了。

更多阅读,请参阅 https://elasticstack.blog.csdn ... 26063

在今天的展示中,我将使用如下的架构:

如上所示,我们创建两个不同的集群。它们分别运行于两个不同的机器上。它们使用不同的 IP 地址。我将使用最新的 Elastic Stack 8.4.1 来进行展示。

如何在不更新证书的情况下为集群之间建立互信

针对非 keystore 及 truststore 的安装

如果你的 Elasticsearch 的部署不是按照 keystore 及 truststore 来进行安装的,而是参照我之前的文章 “Security:如何安装 Elastic SIEM 和 EDR” 来进行安装的话,那么你可以直接把另外一个集群的证书添加到相应的 config/elasticsearch.yml 的配置中去即可:

config/elasticsearch.yml

xpack.security.transport.ssl.enabled: true

xpack.security.transport.ssl.verification_mode: certificate

xpack.security.transport.ssl.key: /etc/elasticsearch/certs/elasticsearch.key

xpack.security.transport.ssl.certificate: /etc/elasticsearch/certs/elasticsearch.crt

xpack.security.transport.ssl.certificate_authorities: [ "/etc/elasticsearch/certs/ca/ca.crt", "certificate_from_another_cluster.crt ]

在这种情况下的配置就非常简单明了。我们就不赘述了。

更多阅读,请参阅 https://elasticstack.blog.csdn ... 26063

收起阅读 »

社区日报 第1497期 (2022-09-08)

https://elastic.martinliu.cn/c ... /%236

2.使用 ECK 在 Kubernetes 集群中管理 Elastic Stack

https://mp.weixin.qq.com/s/pByZr88Lf5JosOnbGf3WDg

3.使用 AWS ElasticSearch Service 监控 EKS 集群日志(需要梯子)

https://faun.pub/configure-aws ... 9e515

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://elastic.martinliu.cn/c ... /%236

2.使用 ECK 在 Kubernetes 集群中管理 Elastic Stack

https://mp.weixin.qq.com/s/pByZr88Lf5JosOnbGf3WDg

3.使用 AWS ElasticSearch Service 监控 EKS 集群日志(需要梯子)

https://faun.pub/configure-aws ... 9e515

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »

2022国际开源节延期通知 | 待疫去花开,我们相约鹏城,不见不散!

致尊敬的各参展商、合作单位、媒体及观众朋友:

鉴于近期深圳市新冠疫情防控形势严峻,为贯彻政府对疫情防控工作的相关要求,保障广大参展商、参观者的身体健康和展出、参观效果,经充分听取各方意见,深圳国际电子展和2022国际开源节组委会审慎决定原定于2022年9月15-17日在深圳会展中心举办的“2022国际开源节”将延期举办,复展具体时间,我们将根据疫情防控情况尽快通知。

衷心感谢社会各界一直以来对“2022国际开源节”的关注、支持与理解,我们深知展会延期给您带来不便,在此我们深表歉意。我们相信,所有与会人员都希望在一个安全、健康、有序、温馨的环境下共同参与盛会。作为“2022国际开源节”的主办方,我们将密切关注疫情的发展形势,动态调整大会预案,及时与各位参展商、观众、业界伙伴们沟通,竭诚做好后续服务,持续进行线上宣传推广,全力以赴保证大会的高品质举办,为行业发展增势储能。

众志成城,共克时艰!期待您继续关注2022国际开源节!

2022国际开源节组委会

2022年9月5日

致尊敬的各参展商、合作单位、媒体及观众朋友:

鉴于近期深圳市新冠疫情防控形势严峻,为贯彻政府对疫情防控工作的相关要求,保障广大参展商、参观者的身体健康和展出、参观效果,经充分听取各方意见,深圳国际电子展和2022国际开源节组委会审慎决定原定于2022年9月15-17日在深圳会展中心举办的“2022国际开源节”将延期举办,复展具体时间,我们将根据疫情防控情况尽快通知。

衷心感谢社会各界一直以来对“2022国际开源节”的关注、支持与理解,我们深知展会延期给您带来不便,在此我们深表歉意。我们相信,所有与会人员都希望在一个安全、健康、有序、温馨的环境下共同参与盛会。作为“2022国际开源节”的主办方,我们将密切关注疫情的发展形势,动态调整大会预案,及时与各位参展商、观众、业界伙伴们沟通,竭诚做好后续服务,持续进行线上宣传推广,全力以赴保证大会的高品质举办,为行业发展增势储能。

众志成城,共克时艰!期待您继续关注2022国际开源节!

2022国际开源节组委会

2022年9月5日

收起阅读 »

社区日报 第1496期 (2022-09-07)

https://www.jianshu.com/p/b479282917b2

2. Elasticsearch:从零开始创建一个 REST handler 插件

https://blog.csdn.net/UbuntuTo ... 17927

3.Elasticsearch:无需基本身份验证即可创建用于访问的不记名令牌

https://blog.csdn.net/UbuntuTo ... 03563

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://www.jianshu.com/p/b479282917b2

2. Elasticsearch:从零开始创建一个 REST handler 插件

https://blog.csdn.net/UbuntuTo ... 17927

3.Elasticsearch:无需基本身份验证即可创建用于访问的不记名令牌

https://blog.csdn.net/UbuntuTo ... 03563

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1495期 (2022-09-06)

https://mp.weixin.qq.com/s/o194AZVEDrCBNJsSL9u1zQ

2. 基于 ClickHouse 的复杂查询实现与优化

https://appukvkryx45804.h5.xia ... %25AB

3. 让机器人(AI)根据文字内容作画(中文支持很差)

https://midjourney.gitbook.io/docs/resource-links

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://mp.weixin.qq.com/s/o194AZVEDrCBNJsSL9u1zQ

2. 基于 ClickHouse 的复杂查询实现与优化

https://appukvkryx45804.h5.xia ... %25AB

3. 让机器人(AI)根据文字内容作画(中文支持很差)

https://midjourney.gitbook.io/docs/resource-links

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

收起阅读 »

社区日报 第1494期 (2022-09-05)

https://blog.csdn.net/weixin_4 ... 05373

2. PB级大规模Elasticsearch集群运维与调优实践

https://zhuanlan.zhihu.com/p/208284617

3. Elasticsearch 脑裂问题

https://zhuanlan.zhihu.com/p/471040063

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://blog.csdn.net/weixin_4 ... 05373

2. PB级大规模Elasticsearch集群运维与调优实践

https://zhuanlan.zhihu.com/p/208284617

3. Elasticsearch 脑裂问题

https://zhuanlan.zhihu.com/p/471040063

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1493期 (2022-09-01)

https://mp.weixin.qq.com/s/BcS8YYBFY4nDsYQ8YhMFqw

2.Elasticsearch:概念、部署选项和最佳实践

https://cloud.netapp.com/blog/ ... 3h_h1

3.巧用 Elastic Stack 实现 HTTP 端点数据的摄入和分析

https://www.bilibili.com/video ... d326e

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://mp.weixin.qq.com/s/BcS8YYBFY4nDsYQ8YhMFqw

2.Elasticsearch:概念、部署选项和最佳实践

https://cloud.netapp.com/blog/ ... 3h_h1

3.巧用 Elastic Stack 实现 HTTP 端点数据的摄入和分析

https://www.bilibili.com/video ... d326e

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »

社区日报 第1492期 (2022-08-31)

https://medium.com/%40hakanmaz ... ee78b

2. kibana控台的改进

https://blog.csdn.net/UbuntuTo ... 53891

3. Elasticsearch 使用point和shape字段类型

https://blog.csdn.net/UbuntuTo ... 28519

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://medium.com/%40hakanmaz ... ee78b

2. kibana控台的改进

https://blog.csdn.net/UbuntuTo ... 53891

3. Elasticsearch 使用point和shape字段类型

https://blog.csdn.net/UbuntuTo ... 28519

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

[阿里云]Elasticsearch SRE

● 负责的业务: 阿里云ES在公有云/集团云/混合云数十万核的集群,国内Top的体量

● 攻坚的技术: 深度参与ES云原生改造进程中,基于OAM模型的落地,多租/多集群的挑战

● 做到的要求: 在实践多年自动运维和数据运维的理念下,建设ES在超大规模云原生下的运维体系

● 入职的团队: 大数据运维领域的深耕十年的团队, 开源运维平台“SREWorks",在国际顶会发表多篇论文

岗位要求:

● 在ES,云原生或大数据其他任一领域攻坚2年以上

● 扎实的计算机基础,并深入掌握一门编程语言

● 持续学习的热情,承担重任的勇气

● 第一学历985/211院校

工作地点:阿里云总部杭州云谷园区

联系方式: aiyu.zyj@alibaba-inc.com/18611088266

● 负责的业务: 阿里云ES在公有云/集团云/混合云数十万核的集群,国内Top的体量

● 攻坚的技术: 深度参与ES云原生改造进程中,基于OAM模型的落地,多租/多集群的挑战

● 做到的要求: 在实践多年自动运维和数据运维的理念下,建设ES在超大规模云原生下的运维体系

● 入职的团队: 大数据运维领域的深耕十年的团队, 开源运维平台“SREWorks",在国际顶会发表多篇论文

岗位要求:

● 在ES,云原生或大数据其他任一领域攻坚2年以上

● 扎实的计算机基础,并深入掌握一门编程语言

● 持续学习的热情,承担重任的勇气

● 第一学历985/211院校

工作地点:阿里云总部杭州云谷园区

联系方式: aiyu.zyj@alibaba-inc.com/18611088266 收起阅读 »

社区日报 第1491期 (2022-08-30)

1. Elasticsearch in Action 之 基础数据类型(需要梯子)

https://mkonda007.medium.com/e ... f6919

2. Elasticsearch in Action 之 高级数据类型(需要梯子)

https://mkonda007.medium.com/e ... 21ed7

3. ES集群中的读写搜索是怎么做到的?(需要梯子)

https://medium.com/wix-enginee ... a7de9

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

1. Elasticsearch in Action 之 基础数据类型(需要梯子)

https://mkonda007.medium.com/e ... f6919

2. Elasticsearch in Action 之 高级数据类型(需要梯子)

https://mkonda007.medium.com/e ... 21ed7

3. ES集群中的读写搜索是怎么做到的?(需要梯子)

https://medium.com/wix-enginee ... a7de9

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1490期 (2022-08-29)

https://blog.csdn.net/jsugs/ar ... 76795

2. Elasticsearch 数据结构介绍

https://blog.csdn.net/star1210 ... 75823

3. Elasticsearch 突破性能瓶颈

https://zhuanlan.zhihu.com/p/341373870

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://blog.csdn.net/jsugs/ar ... 76795

2. Elasticsearch 数据结构介绍

https://blog.csdn.net/star1210 ... 75823

3. Elasticsearch 突破性能瓶颈

https://zhuanlan.zhihu.com/p/341373870

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1489期 (2022-08-27)

1、Elastic Enterprise Search 在电子商务中创造竞争优势的 6 种方式

https://elasticstack.blog.csdn ... 99068

2、如何使用 Elastic Agents 把微服务的数据摄入到 Elasticsearch 中

https://juejin.cn/post/7131957487380463629

3、LDAP 用户鉴权

https://juejin.cn/post/7132739314902892574

编辑:李静

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

1、Elastic Enterprise Search 在电子商务中创造竞争优势的 6 种方式

https://elasticstack.blog.csdn ... 99068

2、如何使用 Elastic Agents 把微服务的数据摄入到 Elasticsearch 中

https://juejin.cn/post/7131957487380463629

3、LDAP 用户鉴权

https://juejin.cn/post/7132739314902892574

编辑:李静

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

收起阅读 »

Kibana 中的巨大控制台改进

作者:CJ Cenizal

更多阅读请参阅 Elastic 中国社区官方博客。

在过去的 9 个月里,我们的一位工程师 Muhammad Ibragimov 一直在悄悄地构建新功能、修复错误,并全面完善 Kibana Console。 从性能改进到在请求正文中留下评论的能力,他和团队在这个被很多人使用和喜爱的应用程序上做了一些令人难以置信的工作。 继续阅读以了解这些和其他改进如何在 Elastic Stack 的 8.1 至 8.4 版本中提高你的工作效率。

主要功能

我想与你分享五个甜蜜的新功能。

-

向 Kibana API 发送请求

在 8.3 中,我们通过在路径前加上 “kbn:” 来提供向 Kibana API 发送请求的能力。 例如,你可以通过以下方式向 Export Saved Objects API 发送请求:

POST kbn:api/saved_objects/_export如果你构建与这些 API 通信的软件或脚本,这将特别有用。 你现在可以快速测试请求,而无需使用第三方工具并为这些工具配置身份验证。

-

请求正文中的评论

曾经看过一个庞大的请求体并且很难回忆起为什么要这样配置它? 在 8.4 中,你可以在请求正文中编写注释并留下有关其配置的注释。 你甚至可以注释掉特定行以暂时禁用它们并尝试请求的其他变体!

1. # This request searches all of your indices.

2. GET /_search

3. {

4. // The query parameter indicates query context.

5. "query": {

6. // Matches all documents.

7. /*"match_all": {

8. "boost": 1.2

9. }*/

10. "match_none": {} // Matches no documents.

11. }

12. }

-

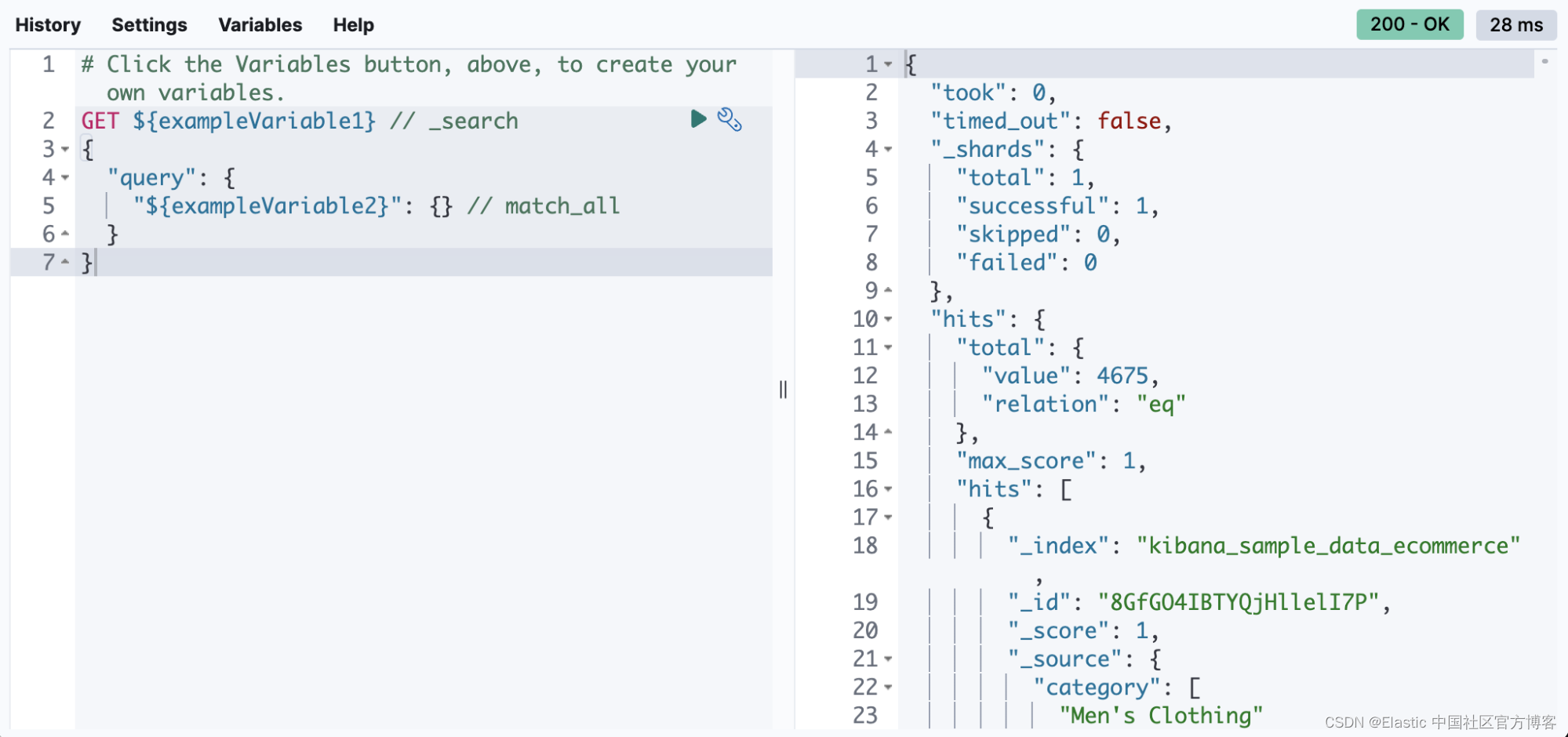

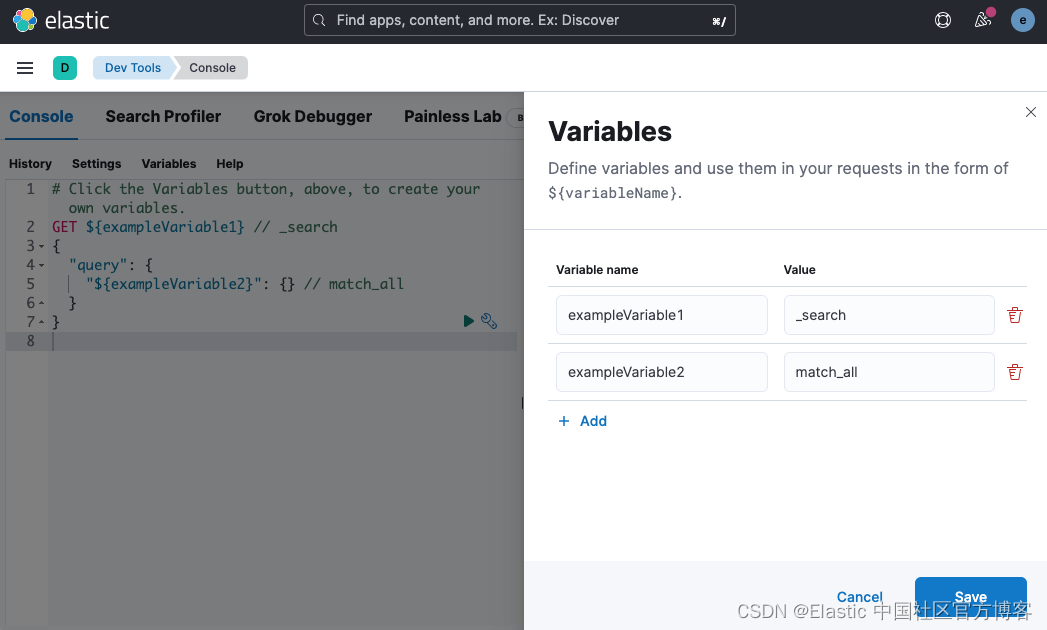

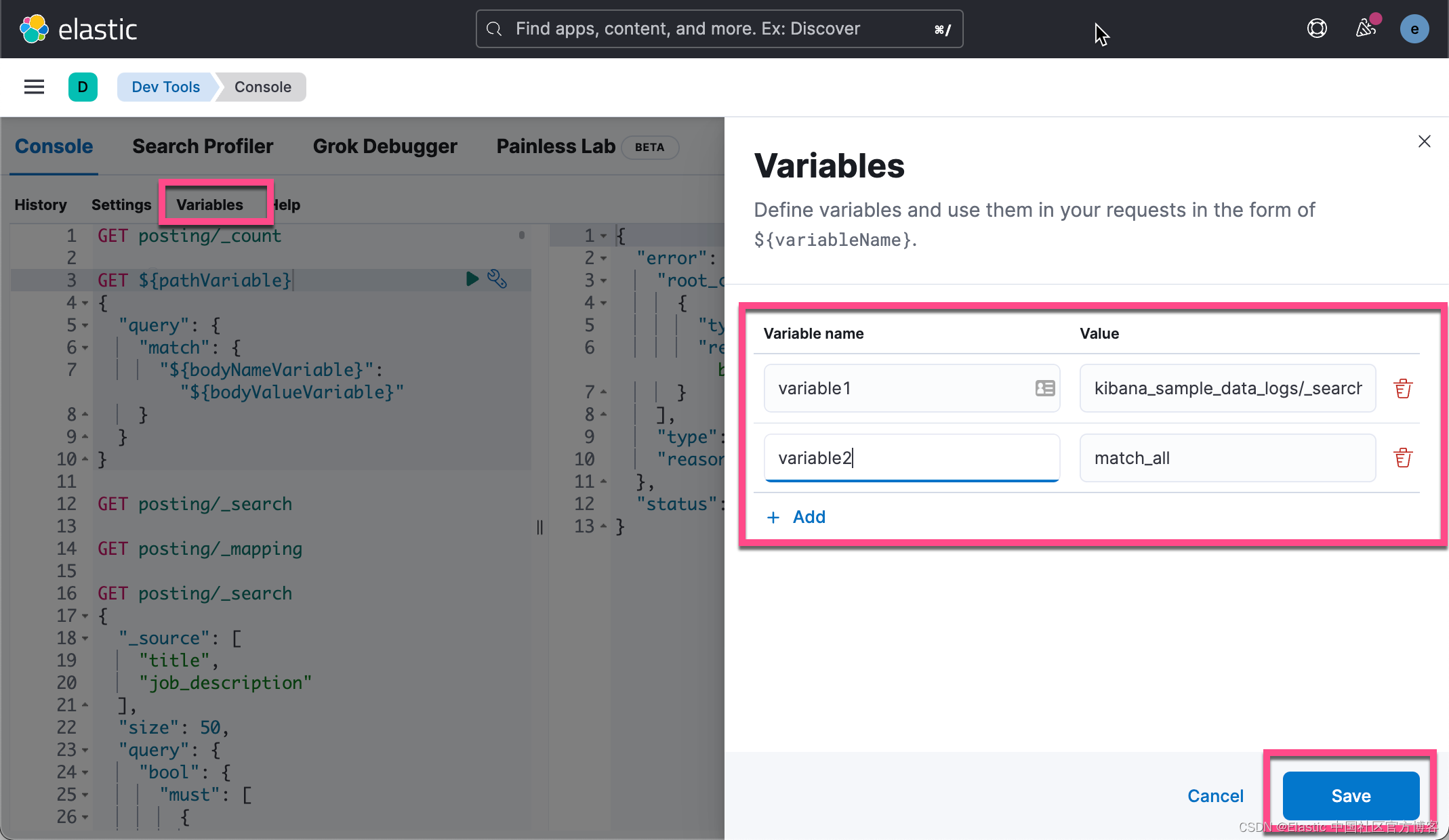

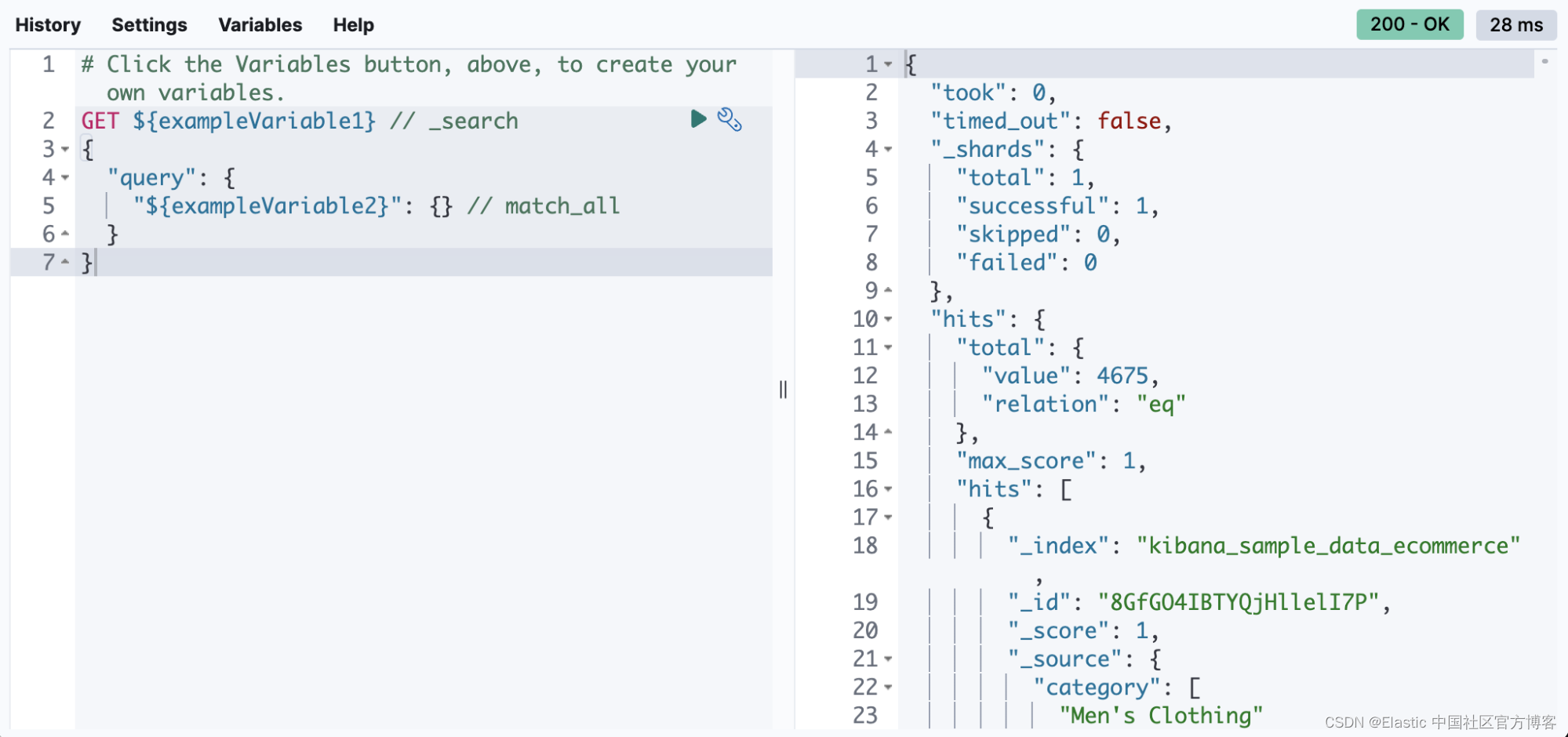

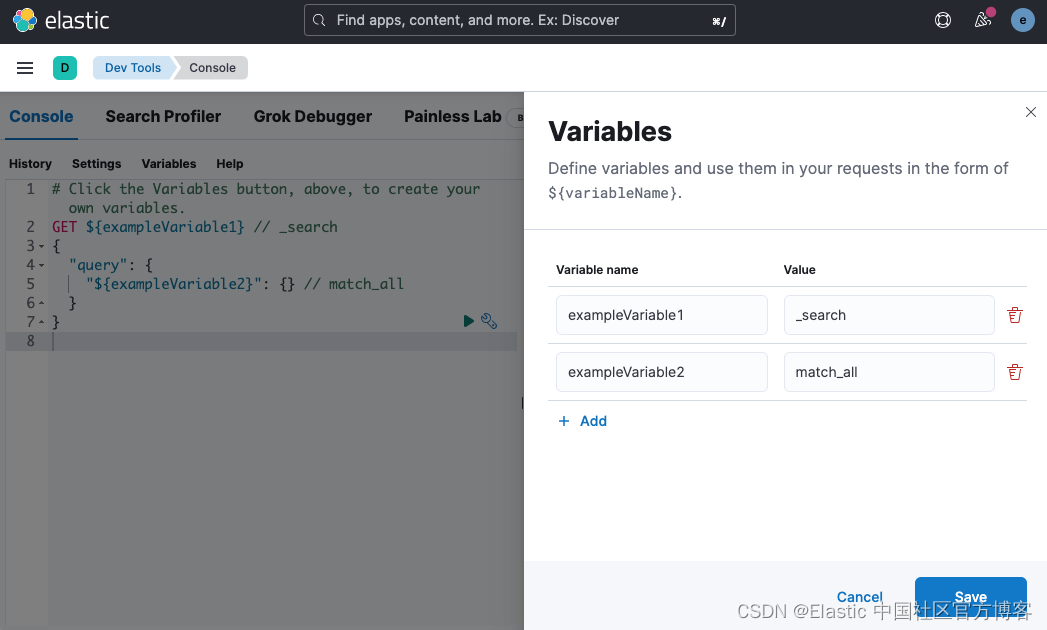

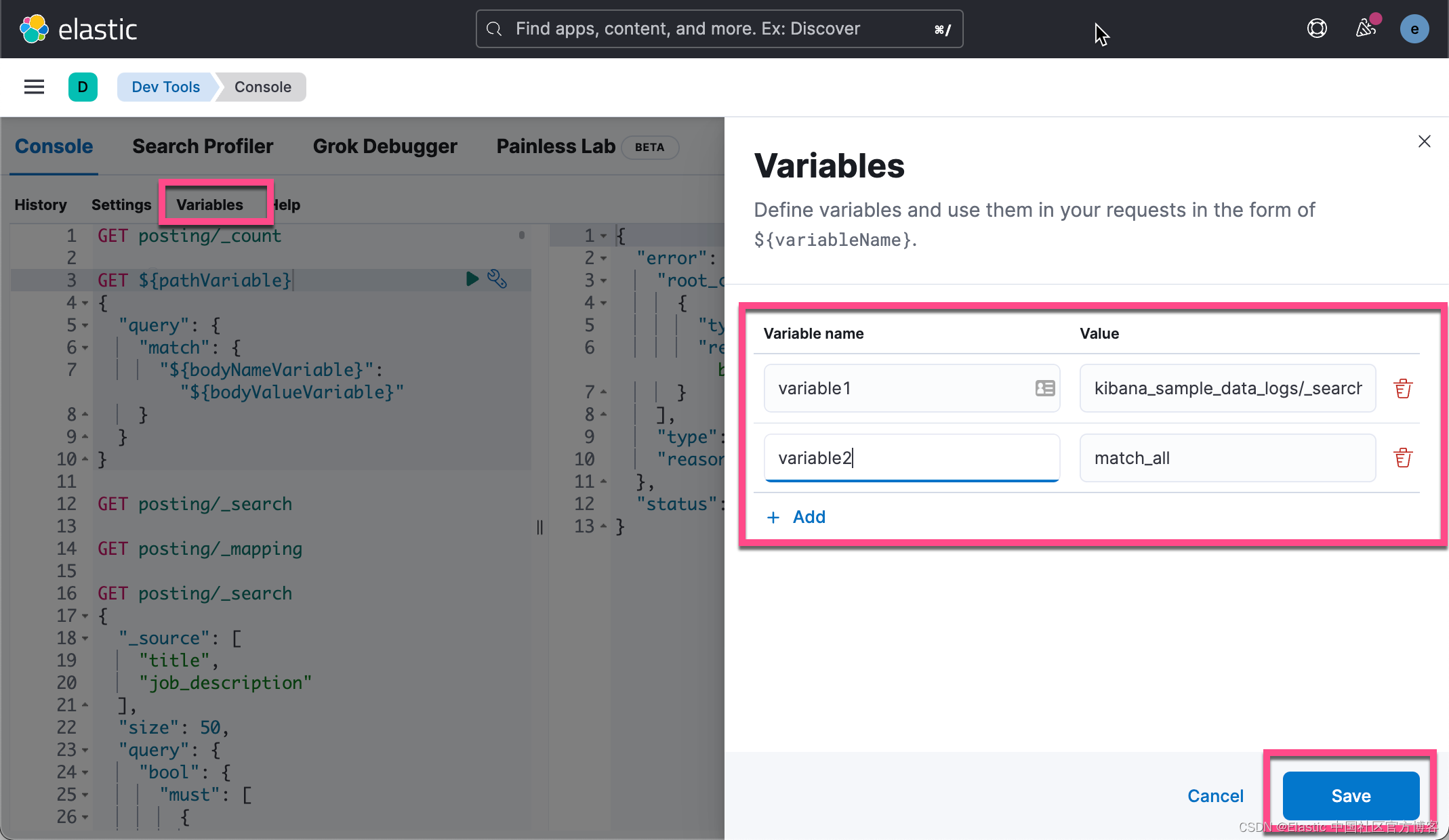

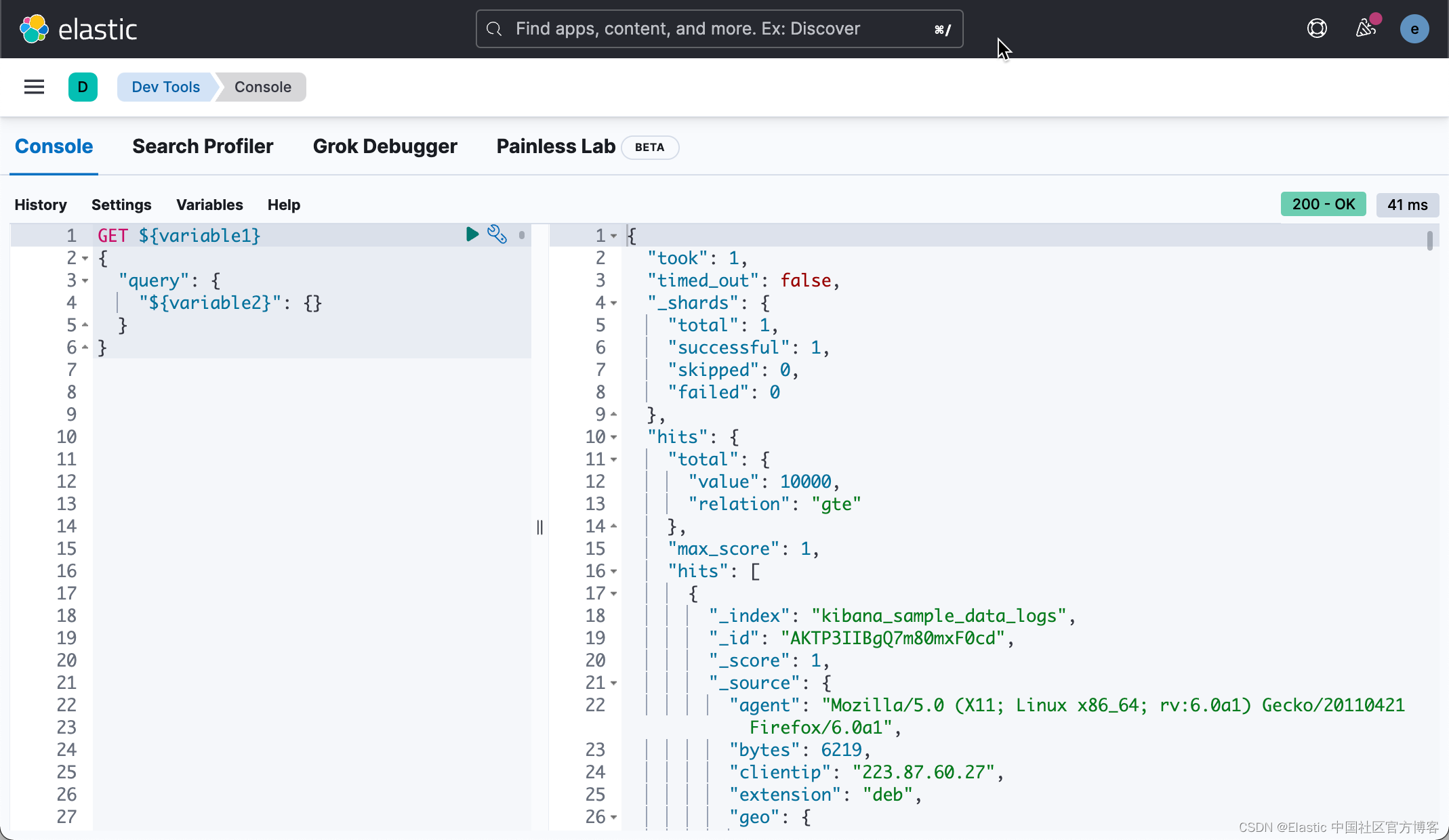

使用变量重用值

在 8.4 中,你可以在 Console 中定义变量并在你的请求中重用它们。 看起来是这样的:

你可以根据需要多次引用请求的路径和正文中的变量。

1. GET ${pathVariable}

2. {

3. "query": {

4. "match": {

5. "${bodyNameVariable}": "${bodyValueVariable}"

6. }

7. }

8. }

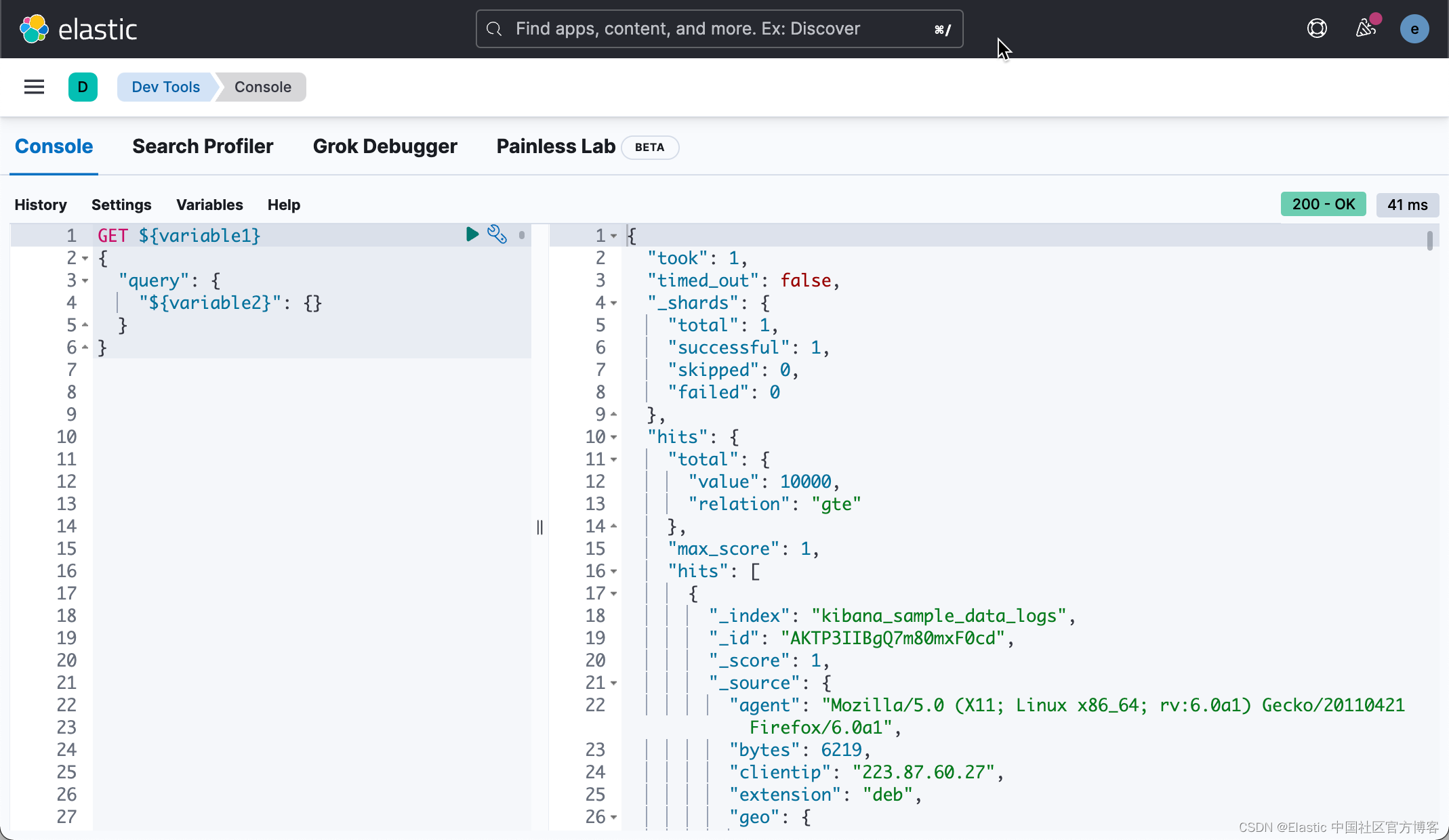

比如,我们可以创建如下的变量:

然后,我们可以使用这些变量进行如下的搜索:

1. GET ${variable1}

2. {

3. "query": {

4. "${variable2}": {}

5. }

6. }

4.多个请求的多个状态

控制台长期以来一直支持同时发送多个请求。 但从历史上看,如果一个请求失败,那么成功的响应就会从 UI 中丢弃。 从 8.3 开始,你可以查看对请求的所有响应,无论它们是失败还是成功。 在 8.4 的基础上,我们在每个响应旁边添加了 HTTP 状态标记。 这使得判断哪个请求失败和哪个请求成功变得更加容易。 最严重的状态位于 UI 的顶部,因此您可以快速了解您的任何请求是否有问题。

-

新 ES 实体的自动完成

自动完成是控制台的核心。 在 8.2 中,我们更新了自动完成功能,以建议部署中存在的特定可组合索引模板、组件模板和数据流的名称。

性能

控制台性能一直是大型部署的一个问题,尤其是对于经常使用控制台的人。 我们花了一些时间来处理这些案例。

优化映射检索

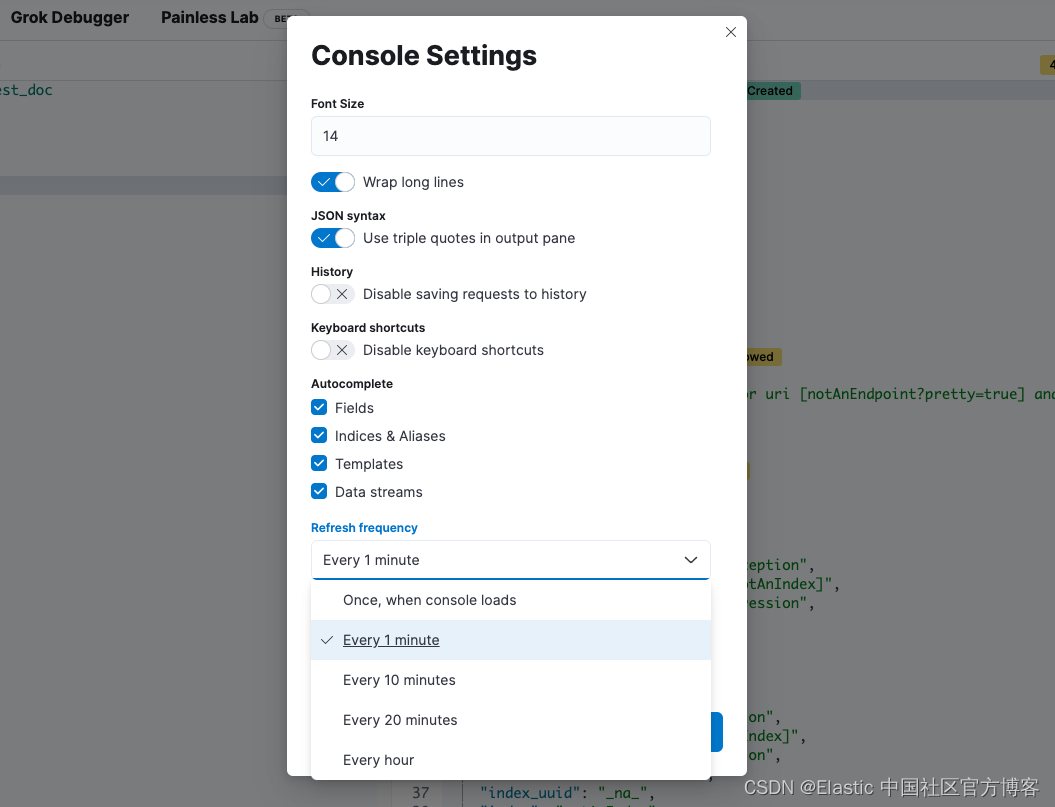

控制台在加载时从 ES 检索所有索引映射,以支持字段的自动完成。 对于具有许多映射的部署,此有效负载可能非常大,以至于可能导致集群不稳定。 在 8.1 和 7.17.3 中,我们通过压缩映射响应、减小其大小和响应时间来解决此问题。

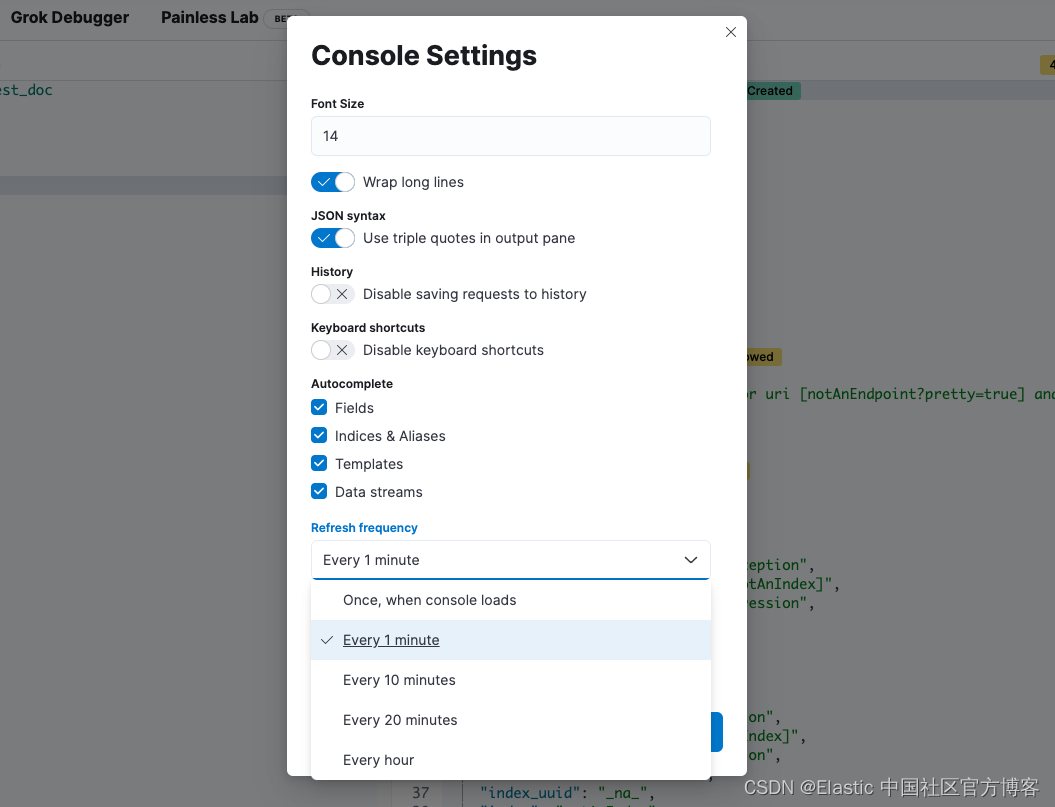

控制台可以按时间间隔自动刷新这些映射,但如果你的映射不经常更改,这将是低效的。 从 8.1 开始,你将能够配置刷新映射的速率、完全禁用获取映射或将 Console 配置为仅在用户导航到 Console 时获取它们一次。

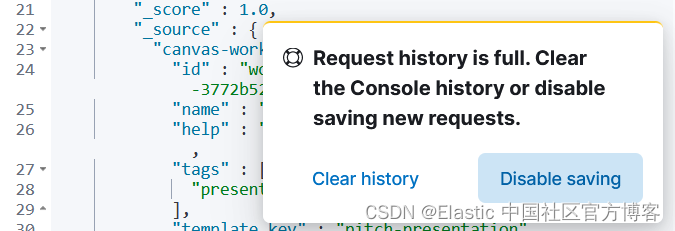

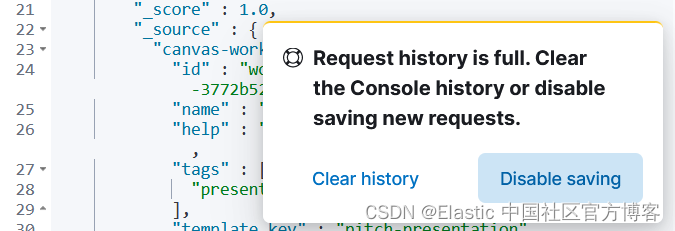

本地存储管理

你的控制台历史记录当前存储在浏览器的本地存储中。 如果你经常使用控制台并用历史数据填满存储空间,那么用完这个本地存储空间是一个真正的问题。 从 8.1 开始,当你用尽本地存储空间并能够清除你的历史记录或完全禁用历史记录时,你将看到一条警告。

尽情享受这些新功能吧!

我们希望这些新功能和增强功能能让您从 Console 中获得更多价值! 如果你希望看到我们对 Console 进行任何进一步的具体更改,请告知我们。

作者:CJ Cenizal

更多阅读请参阅 Elastic 中国社区官方博客。

在过去的 9 个月里,我们的一位工程师 Muhammad Ibragimov 一直在悄悄地构建新功能、修复错误,并全面完善 Kibana Console。 从性能改进到在请求正文中留下评论的能力,他和团队在这个被很多人使用和喜爱的应用程序上做了一些令人难以置信的工作。 继续阅读以了解这些和其他改进如何在 Elastic Stack 的 8.1 至 8.4 版本中提高你的工作效率。

主要功能

我想与你分享五个甜蜜的新功能。

-

向 Kibana API 发送请求

在 8.3 中,我们通过在路径前加上 “kbn:” 来提供向 Kibana API 发送请求的能力。 例如,你可以通过以下方式向 Export Saved Objects API 发送请求:

POST kbn:api/saved_objects/_export如果你构建与这些 API 通信的软件或脚本,这将特别有用。 你现在可以快速测试请求,而无需使用第三方工具并为这些工具配置身份验证。

-

请求正文中的评论

曾经看过一个庞大的请求体并且很难回忆起为什么要这样配置它? 在 8.4 中,你可以在请求正文中编写注释并留下有关其配置的注释。 你甚至可以注释掉特定行以暂时禁用它们并尝试请求的其他变体!

1. # This request searches all of your indices.

2. GET /_search

3. {

4. // The query parameter indicates query context.

5. "query": {

6. // Matches all documents.

7. /*"match_all": {

8. "boost": 1.2

9. }*/

10. "match_none": {} // Matches no documents.

11. }

12. }

-

使用变量重用值

在 8.4 中,你可以在 Console 中定义变量并在你的请求中重用它们。 看起来是这样的:

你可以根据需要多次引用请求的路径和正文中的变量。

1. GET ${pathVariable}

2. {

3. "query": {

4. "match": {

5. "${bodyNameVariable}": "${bodyValueVariable}"

6. }

7. }

8. }

比如,我们可以创建如下的变量:

然后,我们可以使用这些变量进行如下的搜索:

1. GET ${variable1}

2. {

3. "query": {

4. "${variable2}": {}

5. }

6. }

4.多个请求的多个状态

控制台长期以来一直支持同时发送多个请求。 但从历史上看,如果一个请求失败,那么成功的响应就会从 UI 中丢弃。 从 8.3 开始,你可以查看对请求的所有响应,无论它们是失败还是成功。 在 8.4 的基础上,我们在每个响应旁边添加了 HTTP 状态标记。 这使得判断哪个请求失败和哪个请求成功变得更加容易。 最严重的状态位于 UI 的顶部,因此您可以快速了解您的任何请求是否有问题。

-

新 ES 实体的自动完成

自动完成是控制台的核心。 在 8.2 中,我们更新了自动完成功能,以建议部署中存在的特定可组合索引模板、组件模板和数据流的名称。

性能

控制台性能一直是大型部署的一个问题,尤其是对于经常使用控制台的人。 我们花了一些时间来处理这些案例。

优化映射检索

控制台在加载时从 ES 检索所有索引映射,以支持字段的自动完成。 对于具有许多映射的部署,此有效负载可能非常大,以至于可能导致集群不稳定。 在 8.1 和 7.17.3 中,我们通过压缩映射响应、减小其大小和响应时间来解决此问题。

控制台可以按时间间隔自动刷新这些映射,但如果你的映射不经常更改,这将是低效的。 从 8.1 开始,你将能够配置刷新映射的速率、完全禁用获取映射或将 Console 配置为仅在用户导航到 Console 时获取它们一次。

本地存储管理

你的控制台历史记录当前存储在浏览器的本地存储中。 如果你经常使用控制台并用历史数据填满存储空间,那么用完这个本地存储空间是一个真正的问题。 从 8.1 开始,当你用尽本地存储空间并能够清除你的历史记录或完全禁用历史记录时,你将看到一条警告。

尽情享受这些新功能吧!

我们希望这些新功能和增强功能能让您从 Console 中获得更多价值! 如果你希望看到我们对 Console 进行任何进一步的具体更改,请告知我们。

收起阅读 »INFINI 产品更新啦 20220826

各位网友们晚上好,今天是 2022-08-26,星期五,天气晴朗,确切来说可以用炎热来形容,不如小编在此为大家赋诗一首:

啊!啊!时光飞梭,转眼已是秋天,难却烈日依旧炎炎,几度望穿雨下,窗外热风扑面,湘江滚烫,耀我中华,倩倩诗词。。。咳咳,实在编不下去了。。。

首先,我们来回顾一下历史上的今天:

然后,我们再看看 INFINI Labs 今天为大家带来了哪些产品更新吧,具体如下,请查收。

INFINI Gateway v1.7.0

极限网关本次迭代更新如下:

- Flow 过滤器支持基于上下文参数的动态转发,可以实现多域名和后端实例的对应关系

- Router 新增 IP 白名单

- LDAP 身份认证过滤器新增 LRU 缓存支持

- 新增基于 Centos 的 Docker 镜像

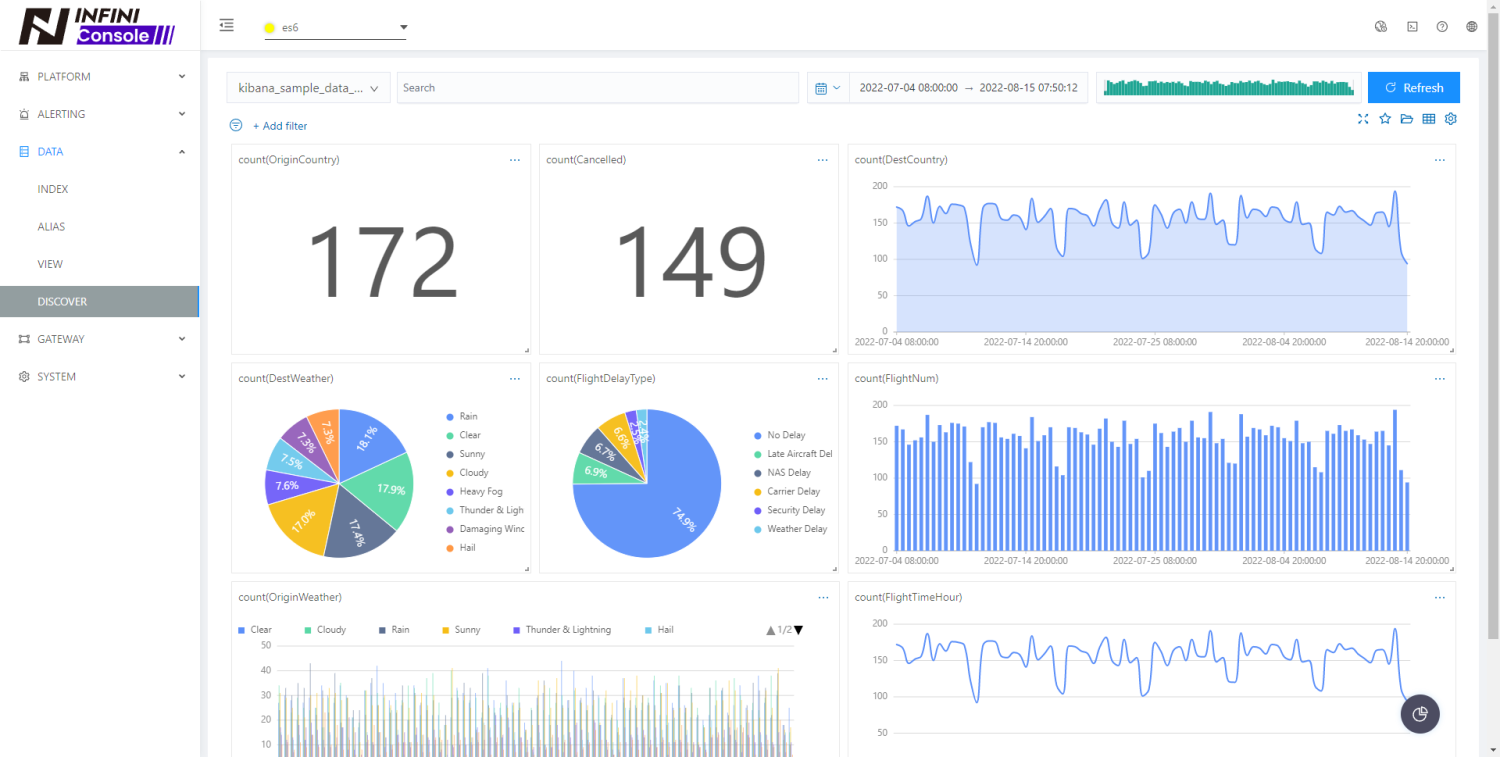

INFINI Console v0.5.0

口碑爆棚的 Elasticsearch 多集群管控平台继续在小步迭代中:

- 修复开发工具不能转发请求给后端集群为 Https 类型的问题

- 新增探针管理功能

- 集群监控节点层面添加 IO 指标(仅支持 Linux 版本 Elasticsearch 集群)

- 修复了存储数据 Elasticsearch 集群不可用时,采集监控指标队列不消费的问题

- 修复了 Docker 镜像时区加载失败的问题 (感谢反馈 @阿炳)

- 修复了 Gateway 实例列表刷新后多次请求的问题

- 优化刷新集群状态日志输出

- 新增基于 Centos 的 Docker 镜像

- 优化了未授权时跳转至登录界面频繁的弹窗提示

- INFINI Insight 新增图表类型(单值、饼图、面积图)

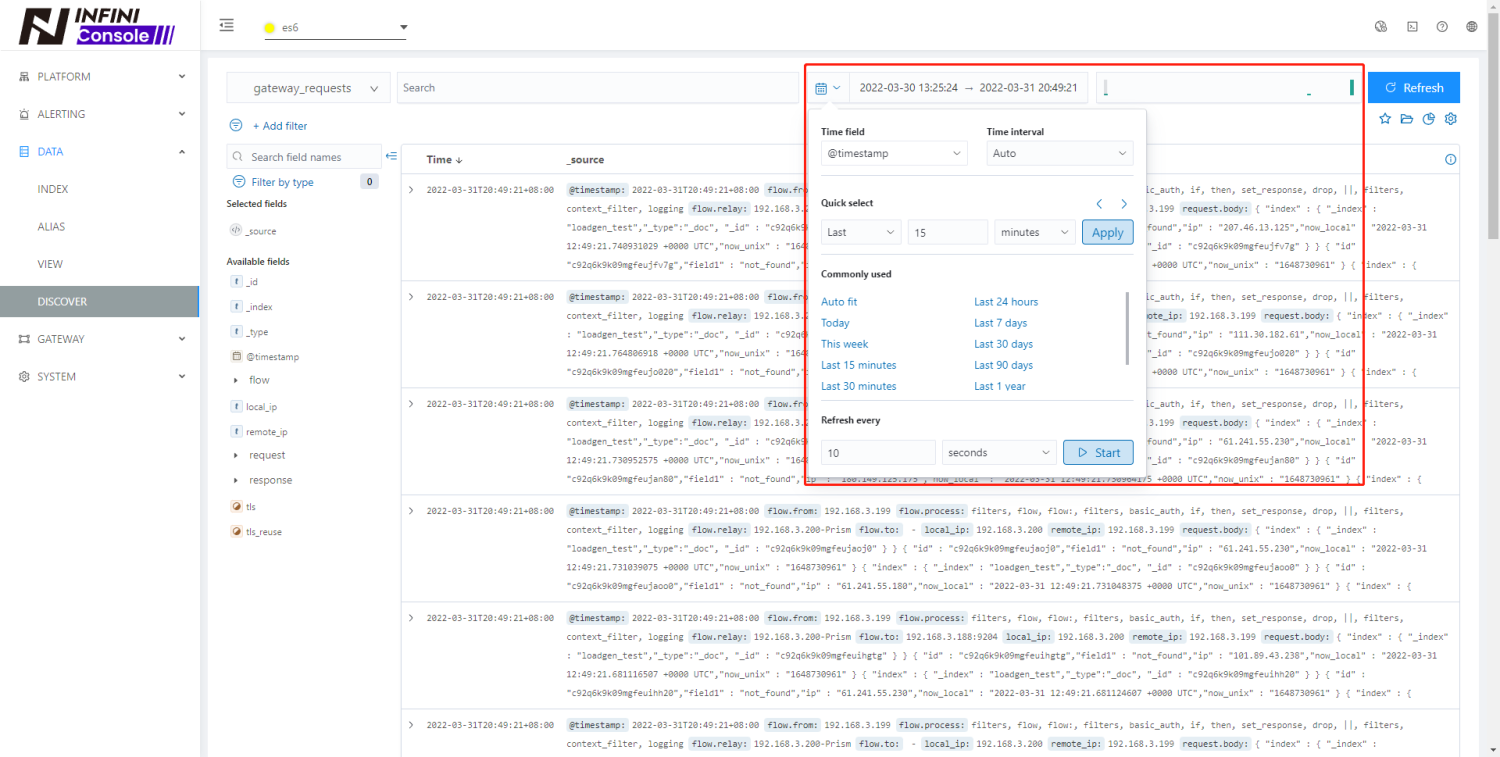

- 调整 Discover 搜索栏时间选择控件 UI,空间更紧凑,切换更方便

- 修复 INFINI Insight 编辑组件后所有组件又重新获取数据的问题

- 修复从其它页面的索引链接跳转到 Discover 时 Query 依然有旧状态的问题

INFINI Agent v0.1.0

为了支撑海量大规模集群的监控指标采集以及为了后续功能的开发做准备,INFINI 产品家族引入了新的成员:INFINI Agent,第一个版本 v.0.1.0 经过实验室小伙伴们的共同努力,终于发布了。 欢迎大家体验,期待大家的反馈~~

- 实现了 Agent 的自动注册,自动解析当前主机包含 Elasticsearch 集群/实例信息并上报给 Console

- 实现了 Agent 端的数据抓取,目前仅实现节点指标、集群指标的抓取

- 实现了 Agent 的状态管理,Console 端可以管理 Agent 状态和下发数据任务

- 实现了多平台兼容 (Linux/Mac/Windows)

- 集成了权限控制,Agent 需等待 Console 端审核通过之后,才会开始数据抓取

- 实现 Agent 多节点间任务调度,当 Agent 掉线了,也不用担心数据无法采集

INFINI Framework 20220826

作为 INFINI 家族公共的基础框架,INFINI Framework 也带来了很多改进:

- 系统内部运行统计指标新增 Prometheus 格式输出

- 合并配置加载过程中的时间, 避免没有必要的重复加载

- 完善了动态配置,并支持动态加载模版化的配置文件

- 集群拓扑发现关闭的情况下不使用和检测后端节点

- API 服务可以统一捕获异常的连接请求,完善输出

- 优先复用本地的 Elasticsearch 客户端实例

- 修复 Windows 磁盘占用统计不正确的错误

- 修复 Windows 服务安装之后启动失败的问题

- 修复 Makefile,避免循环依赖

其它更新

为了让集群运维起来更加自信,相信大家都在配置各种告警规则了,不过这个事情还是比较繁琐的,大家不要慌,针对 Elasticsearch 平台运维的常见指标,我们已经设置好了规则,方便到家快速复用,已提交到 Github 的样例仓库,欢迎大家自行导入到 INFINI Console 中。

访问地址:https://github.com/infinilabs/examples

期待反馈

如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs)中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址:https://www.infinilabs.com/#/download

您还可以通过邮件联系我们:hello@infini.ltd,或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手,加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

感谢大家的围观,祝大家周末愉快,本次发布的内容就到这里,下班啦,再见~

各位网友们晚上好,今天是 2022-08-26,星期五,天气晴朗,确切来说可以用炎热来形容,不如小编在此为大家赋诗一首:

啊!啊!时光飞梭,转眼已是秋天,难却烈日依旧炎炎,几度望穿雨下,窗外热风扑面,湘江滚烫,耀我中华,倩倩诗词。。。咳咳,实在编不下去了。。。

首先,我们来回顾一下历史上的今天:

然后,我们再看看 INFINI Labs 今天为大家带来了哪些产品更新吧,具体如下,请查收。

INFINI Gateway v1.7.0

极限网关本次迭代更新如下:

- Flow 过滤器支持基于上下文参数的动态转发,可以实现多域名和后端实例的对应关系

- Router 新增 IP 白名单

- LDAP 身份认证过滤器新增 LRU 缓存支持

- 新增基于 Centos 的 Docker 镜像

INFINI Console v0.5.0

口碑爆棚的 Elasticsearch 多集群管控平台继续在小步迭代中:

- 修复开发工具不能转发请求给后端集群为 Https 类型的问题

- 新增探针管理功能

- 集群监控节点层面添加 IO 指标(仅支持 Linux 版本 Elasticsearch 集群)

- 修复了存储数据 Elasticsearch 集群不可用时,采集监控指标队列不消费的问题

- 修复了 Docker 镜像时区加载失败的问题 (感谢反馈 @阿炳)

- 修复了 Gateway 实例列表刷新后多次请求的问题

- 优化刷新集群状态日志输出

- 新增基于 Centos 的 Docker 镜像

- 优化了未授权时跳转至登录界面频繁的弹窗提示

- INFINI Insight 新增图表类型(单值、饼图、面积图)

- 调整 Discover 搜索栏时间选择控件 UI,空间更紧凑,切换更方便

- 修复 INFINI Insight 编辑组件后所有组件又重新获取数据的问题

- 修复从其它页面的索引链接跳转到 Discover 时 Query 依然有旧状态的问题

INFINI Agent v0.1.0

为了支撑海量大规模集群的监控指标采集以及为了后续功能的开发做准备,INFINI 产品家族引入了新的成员:INFINI Agent,第一个版本 v.0.1.0 经过实验室小伙伴们的共同努力,终于发布了。 欢迎大家体验,期待大家的反馈~~

- 实现了 Agent 的自动注册,自动解析当前主机包含 Elasticsearch 集群/实例信息并上报给 Console

- 实现了 Agent 端的数据抓取,目前仅实现节点指标、集群指标的抓取

- 实现了 Agent 的状态管理,Console 端可以管理 Agent 状态和下发数据任务

- 实现了多平台兼容 (Linux/Mac/Windows)

- 集成了权限控制,Agent 需等待 Console 端审核通过之后,才会开始数据抓取

- 实现 Agent 多节点间任务调度,当 Agent 掉线了,也不用担心数据无法采集

INFINI Framework 20220826

作为 INFINI 家族公共的基础框架,INFINI Framework 也带来了很多改进:

- 系统内部运行统计指标新增 Prometheus 格式输出

- 合并配置加载过程中的时间, 避免没有必要的重复加载

- 完善了动态配置,并支持动态加载模版化的配置文件

- 集群拓扑发现关闭的情况下不使用和检测后端节点

- API 服务可以统一捕获异常的连接请求,完善输出

- 优先复用本地的 Elasticsearch 客户端实例

- 修复 Windows 磁盘占用统计不正确的错误

- 修复 Windows 服务安装之后启动失败的问题

- 修复 Makefile,避免循环依赖

其它更新

为了让集群运维起来更加自信,相信大家都在配置各种告警规则了,不过这个事情还是比较繁琐的,大家不要慌,针对 Elasticsearch 平台运维的常见指标,我们已经设置好了规则,方便到家快速复用,已提交到 Github 的样例仓库,欢迎大家自行导入到 INFINI Console 中。

访问地址:https://github.com/infinilabs/examples

期待反馈

如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs)中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址:https://www.infinilabs.com/#/download

您还可以通过邮件联系我们:hello@infini.ltd,或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手,加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

感谢大家的围观,祝大家周末愉快,本次发布的内容就到这里,下班啦,再见~

收起阅读 »

社区日报 第1488期 (2022-08-25)

https://opster.com/guides/elas ... mpose

2.腾讯云Elastic使用教程:使用Fleet集中管理Elastic Agent

https://cloud.tencent.com/deve ... 80255

3.Elasticsearch:使用向量搜索来搜索图片及文字

https://elasticstack.blog.csdn ... 85836

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://opster.com/guides/elas ... mpose

2.腾讯云Elastic使用教程:使用Fleet集中管理Elastic Agent

https://cloud.tencent.com/deve ... 80255

3.Elasticsearch:使用向量搜索来搜索图片及文字

https://elasticstack.blog.csdn ... 85836

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »