【社区日报】 第1741期 (2023-11-20)

https://www.qbitai.com/2023/11/99103.html

2、网易云音乐推荐系统的冷启动技术

https://zhuanlan.zhihu.com/p/666609016

3、70款ChatGPT插件评测:惊艳的开发过程与宏大的商业化愿景

https://zhuanlan.zhihu.com/p/629337429

4、大语言模型是推荐系统的解决方案吗?

https://zhuanlan.zhihu.com/p/666784325

5.作为程序员, 我如何使用ChatGPT来帮我写代码

https://blog.csdn.net/jeansboy ... 07126

编辑:yuebancanghai

更多资讯:http://news.searchkit.cn

https://www.qbitai.com/2023/11/99103.html

2、网易云音乐推荐系统的冷启动技术

https://zhuanlan.zhihu.com/p/666609016

3、70款ChatGPT插件评测:惊艳的开发过程与宏大的商业化愿景

https://zhuanlan.zhihu.com/p/629337429

4、大语言模型是推荐系统的解决方案吗?

https://zhuanlan.zhihu.com/p/666784325

5.作为程序员, 我如何使用ChatGPT来帮我写代码

https://blog.csdn.net/jeansboy ... 07126

编辑:yuebancanghai

更多资讯:http://news.searchkit.cn 收起阅读 »

通过 Canal 将 MySQL 数据实时同步到 Easysearch

Canal 是阿里巴巴集团提供的一个开源产品,能够通过解析数据库的增量日志,提供增量数据的订阅和消费功能。使用 Canal 模拟成 MySQL 的 Slave,实时接收 MySQL 的增量数据 binlog,然后通过 RESTful API 将数据写入到 Easysearch 中。

前提条件

- 部署 Easysearch 集群。

- 部署 MySQL 数据库。

- 部署 Gateway,Canal Adapter 不支持使用 HTTPS 协议连接,使用 Gateway 代理 Easysearch 。

- 部署 Console,方便查看 Easysearch 数据。

对于自建 MySQL , 需要先开启 Binlog 写入功能,配置 binlog-format 为 ROW 模式,my.cnf 中配置如下:[mysqld] log-bin=mysql-bin # 开启 binlog binlog-format=ROW # 选择 ROW 模式 server_id=1 # 配置 MySQL replaction 需要定义,不要和 canal 的 slaveId 重复创建 canal 用户,授权 canal 连接 MySQL 具有作为 MySQL slave 的权限。

CREATE USER canal IDENTIFIED BY 'canal'; GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%'; -- GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' ; FLUSH PRIVILEGES;操作步骤

在进行数据同步时支持自定义索引 Mapping,但需保证 Mapping 中定义的字段(名称+类型)与 MySQL 中一致。

1. 准备 MySQL 数据源

create database canal; use canal; CREATE TABLE `test` ( `id` bigint(32) NOT NULL, `name` text NOT NULL, `age` smallint NOT NULL, PRIMARY KEY (`id`) ) ENGINE=InnoDB DEFAULT CHARACTER SET=utf8;2. Easysearch 创建索引

PUT test { "settings" : { "index" : { "number_of_shards" : "1", "number_of_replicas" : "1" } }, "mappings" : { "properties" : { "id": { "type": "integer" }, "name": { "type" : "text" }, "age" : { "type" : "integer" } } } }3. 安装并启动 Canal-server

下载:https://github.com/alibaba/canal/releases/download/canal-1.1.7/canal.deployer-1.1.7.tar.gz

修改配置文件vi conf/example/instance.properties

启动 canal

启动 canal

sh bin/startup.sh

启动成功日志信息,logs/canal/canal.log 关闭 canal

关闭 canal

sh bin/stop.sh4. 安装并启动 Canal-adapter

下载:https://github.com/alibaba/canal/releases/download/canal-1.1.7/canal.adapter-1.1.7.tar.gz

修改配置文件:application.ymlserver: port: 8081 spring: jackson: date-format: yyyy-MM-dd HH:mm:ss time-zone: GMT+8 default-property-inclusion: non_null canal.conf: flatMessage: true syncBatchSize: 1000 retries: -1 timeout: accessKey: secretKey: consumerProperties: canal.tcp.server.host: 127.0.0.1:11111 canal.tcp.batch.size: 500 srcDataSources: defaultDS: url: jdbc:mysql://127.0.0.1:3306/canal?useUnicode=true username: canal password: canal canalAdapters: groups: - groupId: g1 outerAdapters: - name: logger - name: es7 properties: security.auth: admin:4ad8f8f792e81cd0a6de cluster.name: easysearch新增 canal-adapter/conf/es7/test.yml,配置索引和表的映射关系。

dataSourceKey: defaultDS destination: example groupId: g1 esMapping: _index: test # es 的索引名称 _id: _id # es 的_id, 如果不配置该项必须配置下面的pk项_id则会由es自动分配 # sql映射 sql: " select a.id as _id,a.id,a.name,a.age from test a " etlCondition: "where a.id>={}" commitBatch: 3000 # 提交批大小启动 canal-adapter

./bin/startup.sh

5. 验证增量数据同步

在 MySQL 数据库中,对 test 表插入两条数据。

inserttest(id,name,age) values(1,'canal_test1',11);

inserttest(id,name,age) values(2,'canal_test2',22);6. 在 Console 中,执行以下命令查询数据

最后

Canal 同步的是增量数据,不会同步之前的存量数据。要同步存量数据可参考《使用 Logstash 同步 MySQL 到 Easysearch》

Canal 是阿里巴巴集团提供的一个开源产品,能够通过解析数据库的增量日志,提供增量数据的订阅和消费功能。使用 Canal 模拟成 MySQL 的 Slave,实时接收 MySQL 的增量数据 binlog,然后通过 RESTful API 将数据写入到 Easysearch 中。

前提条件

- 部署 Easysearch 集群。

- 部署 MySQL 数据库。

- 部署 Gateway,Canal Adapter 不支持使用 HTTPS 协议连接,使用 Gateway 代理 Easysearch 。

- 部署 Console,方便查看 Easysearch 数据。

对于自建 MySQL , 需要先开启 Binlog 写入功能,配置 binlog-format 为 ROW 模式,my.cnf 中配置如下:[mysqld] log-bin=mysql-bin # 开启 binlog binlog-format=ROW # 选择 ROW 模式 server_id=1 # 配置 MySQL replaction 需要定义,不要和 canal 的 slaveId 重复创建 canal 用户,授权 canal 连接 MySQL 具有作为 MySQL slave 的权限。

CREATE USER canal IDENTIFIED BY 'canal'; GRANT SELECT, REPLICATION SLAVE, REPLICATION CLIENT ON *.* TO 'canal'@'%'; -- GRANT ALL PRIVILEGES ON *.* TO 'canal'@'%' ; FLUSH PRIVILEGES;操作步骤

在进行数据同步时支持自定义索引 Mapping,但需保证 Mapping 中定义的字段(名称+类型)与 MySQL 中一致。

1. 准备 MySQL 数据源

create database canal; use canal; CREATE TABLE `test` ( `id` bigint(32) NOT NULL, `name` text NOT NULL, `age` smallint NOT NULL, PRIMARY KEY (`id`) ) ENGINE=InnoDB DEFAULT CHARACTER SET=utf8;2. Easysearch 创建索引

PUT test { "settings" : { "index" : { "number_of_shards" : "1", "number_of_replicas" : "1" } }, "mappings" : { "properties" : { "id": { "type": "integer" }, "name": { "type" : "text" }, "age" : { "type" : "integer" } } } }3. 安装并启动 Canal-server

下载:https://github.com/alibaba/canal/releases/download/canal-1.1.7/canal.deployer-1.1.7.tar.gz

修改配置文件vi conf/example/instance.properties

启动 canal

启动 canal

sh bin/startup.sh

启动成功日志信息,logs/canal/canal.log 关闭 canal

关闭 canal

sh bin/stop.sh4. 安装并启动 Canal-adapter

下载:https://github.com/alibaba/canal/releases/download/canal-1.1.7/canal.adapter-1.1.7.tar.gz

修改配置文件:application.ymlserver: port: 8081 spring: jackson: date-format: yyyy-MM-dd HH:mm:ss time-zone: GMT+8 default-property-inclusion: non_null canal.conf: flatMessage: true syncBatchSize: 1000 retries: -1 timeout: accessKey: secretKey: consumerProperties: canal.tcp.server.host: 127.0.0.1:11111 canal.tcp.batch.size: 500 srcDataSources: defaultDS: url: jdbc:mysql://127.0.0.1:3306/canal?useUnicode=true username: canal password: canal canalAdapters: groups: - groupId: g1 outerAdapters: - name: logger - name: es7 properties: security.auth: admin:4ad8f8f792e81cd0a6de cluster.name: easysearch新增 canal-adapter/conf/es7/test.yml,配置索引和表的映射关系。

dataSourceKey: defaultDS destination: example groupId: g1 esMapping: _index: test # es 的索引名称 _id: _id # es 的_id, 如果不配置该项必须配置下面的pk项_id则会由es自动分配 # sql映射 sql: " select a.id as _id,a.id,a.name,a.age from test a " etlCondition: "where a.id>={}" commitBatch: 3000 # 提交批大小启动 canal-adapter

./bin/startup.sh

5. 验证增量数据同步

在 MySQL 数据库中,对 test 表插入两条数据。

inserttest(id,name,age) values(1,'canal_test1',11);

inserttest(id,name,age) values(2,'canal_test2',22);6. 在 Console 中,执行以下命令查询数据

最后

Canal 同步的是增量数据,不会同步之前的存量数据。要同步存量数据可参考《使用 Logstash 同步 MySQL 到 Easysearch》

INFINI Labs 产品更新 | 发布 Easysearch Java 客户端,Console 支持 SQL 查询等功能

INFINI Labs 产品又更新啦~,本次更新概要如下:发布 Easysearch-client Java 客户端,开发者通过 client 与 Easysearch 集群的交互变得更加简洁和直观;Console 开发工具新增 SQL 特性,支持 SELECT 查询等语法高亮和自动提示等;Gateway 的系统 API 添加了基于基本身份验证的安全功能。

以下是本次更新的详细说明。

INFINI Easysearch-client v1.0.1

正式发布 Easysearch Java 客户端。

这一里程碑式的更新为开发人员带来了前所未有的便利性,使得与 Easysearch 集群的交互变得更加简洁和直观。现在,通过 Easysearch-client 客户端,开发者可以直接使用 Java 方法和数据结构来进行交互,而不再需要依赖于传统的 HTTP 方法和 JSON。这一变化大大简化了操作流程,使得数据管理和索引更加高效。高级客户端的功能范围包括处理数据操作,管理集群,包括查看和维护集群的健康状态,并对 Security 模块全面兼容。它提供了一系列 API,用于管理角色、用户、权限、角色映射和账户。这意味着安全性和访问控制现在可以更加细粒度地管理,确保了数据的安全性和合规性。

使用说明参见:快速开始

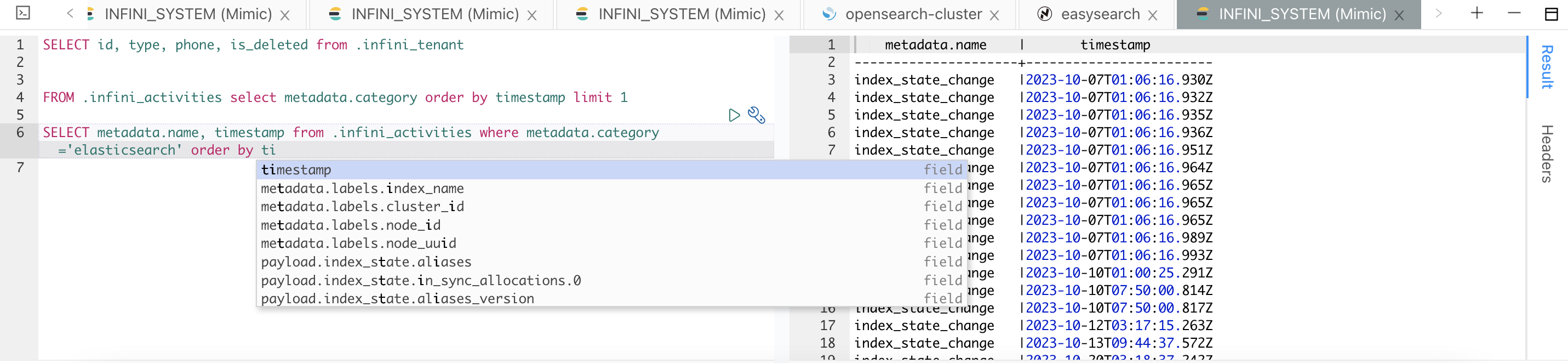

INFINI Console v1.11.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

Console 本次更新如下:

Features

- 开发工具 SQL 查询支持

- 支持 SELECT 查询及语法高亮

- 支持索引和字段自动提示

- 支持 FROM 前置语法

Bug fix

- 修复平台概览集群指标为空的问题

Improvements

- LDAP 支持从 DN 中解析 OU 属性

- 集群动态优化显示,新增节点名称和索引名称的聚合统计过滤

INFINI Gateway v1.19.0

INFINI Gateway 是一个面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway 可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。

Gateway 本次更新如下:

Features

- 添加

http处理器 - 在 API 模块中添加基于基本身份验证的安全性

- 允许将自身注册到配置管理器

- 允许在配置错误时触发 panic

Bug fix

- 修复

rewrite_to_bulk在较新版本中缺少_type的问题 - 修复

rewrite_to_bulk,支持无索引文档操作

Improvements

- 更新测试,断言解析结果

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

欢迎加入 Discord 聊天室:https://discord.gg/4tKTMkkvVX

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群一起讨论交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

INFINI Labs 产品又更新啦~,本次更新概要如下:发布 Easysearch-client Java 客户端,开发者通过 client 与 Easysearch 集群的交互变得更加简洁和直观;Console 开发工具新增 SQL 特性,支持 SELECT 查询等语法高亮和自动提示等;Gateway 的系统 API 添加了基于基本身份验证的安全功能。

以下是本次更新的详细说明。

INFINI Easysearch-client v1.0.1

正式发布 Easysearch Java 客户端。

这一里程碑式的更新为开发人员带来了前所未有的便利性,使得与 Easysearch 集群的交互变得更加简洁和直观。现在,通过 Easysearch-client 客户端,开发者可以直接使用 Java 方法和数据结构来进行交互,而不再需要依赖于传统的 HTTP 方法和 JSON。这一变化大大简化了操作流程,使得数据管理和索引更加高效。高级客户端的功能范围包括处理数据操作,管理集群,包括查看和维护集群的健康状态,并对 Security 模块全面兼容。它提供了一系列 API,用于管理角色、用户、权限、角色映射和账户。这意味着安全性和访问控制现在可以更加细粒度地管理,确保了数据的安全性和合规性。

使用说明参见:快速开始

INFINI Console v1.11.0

INFINI Console 是一款非常轻量级的多集群、跨版本的搜索基础设施统一管控平台。通过对流行的搜索引擎基础设施进行跨版本、多集群的集中纳管, 企业可以快速方便的统一管理企业内部的不同版本的多套搜索集群。

Console 在线体验: http://demo.infini.cloud (用户名/密码:readonly/readonly)。

Console 本次更新如下:

Features

- 开发工具 SQL 查询支持

- 支持 SELECT 查询及语法高亮

- 支持索引和字段自动提示

- 支持 FROM 前置语法

Bug fix

- 修复平台概览集群指标为空的问题

Improvements

- LDAP 支持从 DN 中解析 OU 属性

- 集群动态优化显示,新增节点名称和索引名称的聚合统计过滤

INFINI Gateway v1.19.0

INFINI Gateway 是一个面向搜索场景的高性能数据网关,所有请求都经过网关处理后再转发到后端的搜索业务集群。基于 INFINI Gateway 可以实现索引级别的限速限流、常见查询的缓存加速、查询请求的审计、查询结果的动态修改等等。

Gateway 本次更新如下:

Features

- 添加

http处理器 - 在 API 模块中添加基于基本身份验证的安全性

- 允许将自身注册到配置管理器

- 允许在配置错误时触发 panic

Bug fix

- 修复

rewrite_to_bulk在较新版本中缺少_type的问题 - 修复

rewrite_to_bulk,支持无索引文档操作

Improvements

- 更新测试,断言解析结果

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

欢迎加入 Discord 聊天室:https://discord.gg/4tKTMkkvVX

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群一起讨论交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

收起阅读 »社区日报 第1740期 (2023-11-17)

1、IBM 工程师分享 大模型实战日常博客全集

https://heidloff.net/archives/

2、学术报告:基于深度学习的神经语义搜索

https://hub.baai.ac.cn/view/16490

3、语义检索在工业界使用 PPT

https://zliu.org/files/talks/ccir2019-20190921.pdf

4、号外!——Elastic 官方收编了 OpsterHQ。

https://www.elastic.co/cn/blog ... orces

编辑:铭毅天下

更多资讯:http://news.searchkit.cn

1、IBM 工程师分享 大模型实战日常博客全集

https://heidloff.net/archives/

2、学术报告:基于深度学习的神经语义搜索

https://hub.baai.ac.cn/view/16490

3、语义检索在工业界使用 PPT

https://zliu.org/files/talks/ccir2019-20190921.pdf

4、号外!——Elastic 官方收编了 OpsterHQ。

https://www.elastic.co/cn/blog ... orces

编辑:铭毅天下

更多资讯:http://news.searchkit.cn 收起阅读 »

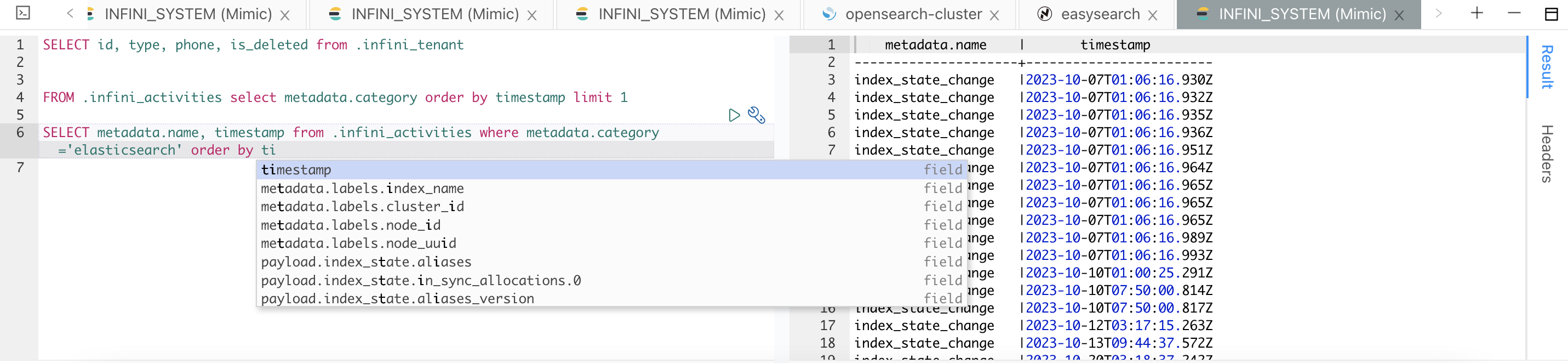

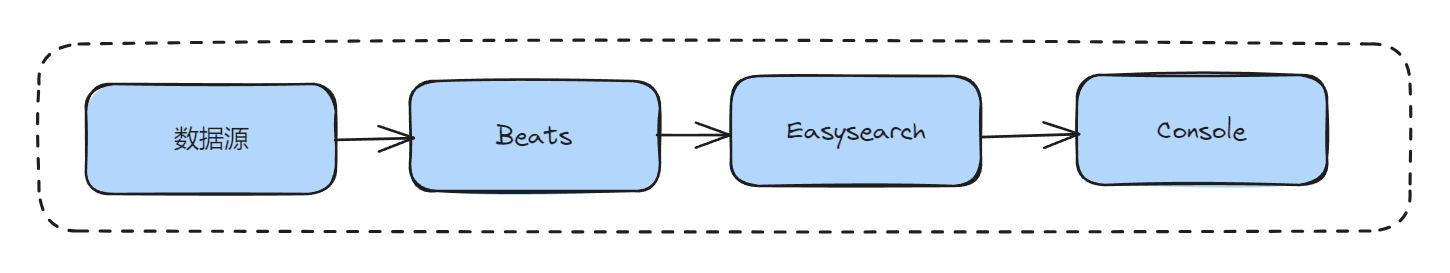

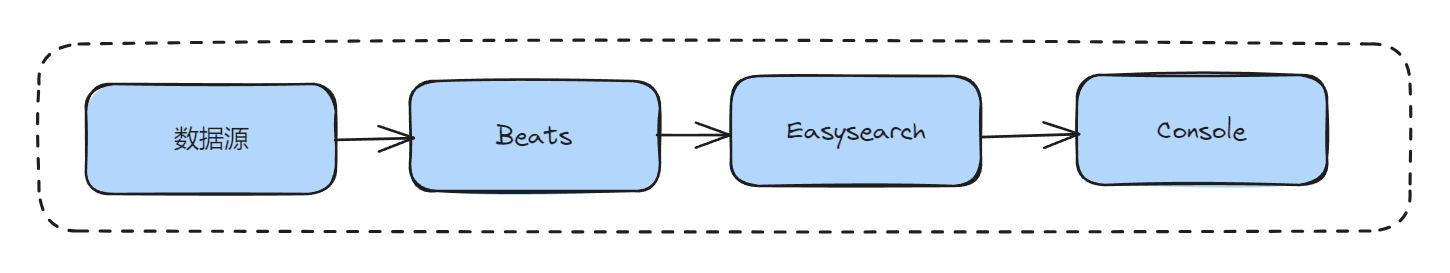

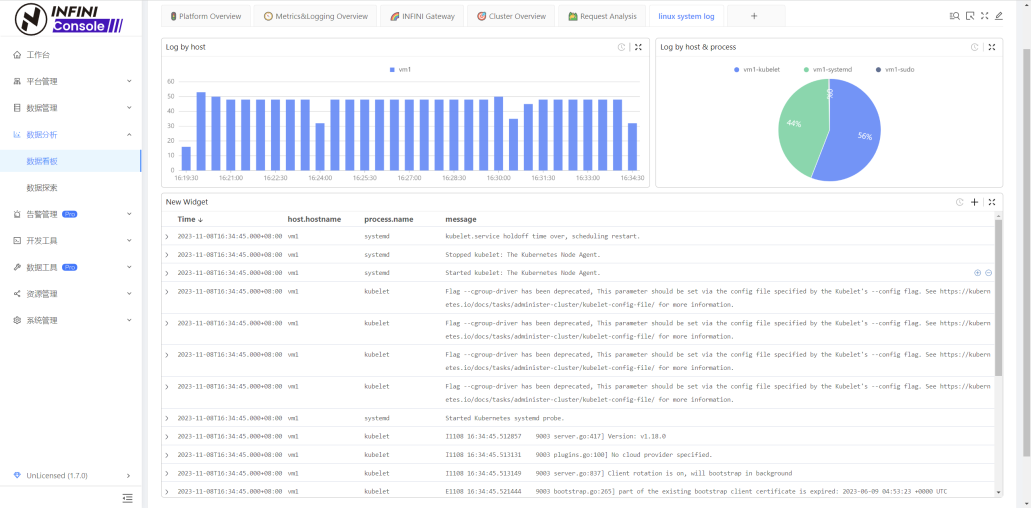

使用 Filebeat+Easysearch+Console 打造日志管理平台

近年来,日志管理平台越来越流行。使用日志管理平台可以实时地、统一地、方便地管理和查看日志,挖掘日志数据价值,驱动运维、运营,提升服务管理效率。

方案架构

- Beats 是轻量级采集器,包括 Filebeat、Metricbeat 等。

- Easysearch 是个分布式搜索引擎,提供搜集、分析、存储数据等主要功能。

- Console 是一个可视化工具,提供可视化查询,制作报表等功能。

本文将搭建一个统一日志管理平台。使用 Filebeat 采集 OS 中的日志(其他日志大同小异),发送到 Easysearch 中。最后通过 Console 进行日志的可视化查询与分析。

操作步骤

- 准备工作

- 部署 Easysearch

- 编辑 easysearch.yml 文件,打开注释 elasticsearch.api_compatibility: true

- 部署 Console

- 部署 Easysearch

- 安装并配置 Filebeat

- 下载 Filebeat,版本建议选择 7.10.2。下载地址:https://www.elastic.co/cn/downloads/past-releases/filebeat-oss-7-10-2

- 修改配置 filebeat.yml 文件

setup.template.name: "filebeat"

setup.template.pattern: "system-log*"

setup.template.fields: "${path.config}/fields.yml"

output.elasticsearch:

hosts: ["localhost:9200"]

protocol: "https"

ssl.verification_mode: none

username: "admin"

password: "4ad8f8f792e81cd0a6de"

index: "system-log"- 启用 system 模块并导入 pipeline

./filebeat modules enable system

./filebeat setup --pipelines --modules system

- 创建索引模板及初始索引,使用 ZSTD+SOURCE_REUSE 技术节省磁盘空间

PUT _template/system_log

{

"order": 100,

"index_patterns": [

"system_log*"

],

"settings": {

"index": {

"format": "7",

"lifecycle": {

"name": "ilm_.infini_metrics-30days-retention",

"rollover_alias": "system_log"

},

"codec": "ZSTD",

"source_reuse": true,

"number_of_shards": "1",

"translog": {

"durability": "async"

}

}

},

"mappings": {

"dynamic_templates": [

{

"strings": {

"mapping": {

"ignore_above": 256,

"type": "keyword"

},

"match_mapping_type": "string"

}

}

]

}

}

PUT system-log-00001

{

"aliases":{

"system-log":{

"is_write_index":true

}

}

}- 启动 filebeat

nohup ./filebeat -c filebeat.yml 2>&1>/dev/null &

- 进入 Console 查看、搜索日志

- 进入 Console 创建 dashboard 进行日志分析

近年来,日志管理平台越来越流行。使用日志管理平台可以实时地、统一地、方便地管理和查看日志,挖掘日志数据价值,驱动运维、运营,提升服务管理效率。

方案架构

- Beats 是轻量级采集器,包括 Filebeat、Metricbeat 等。

- Easysearch 是个分布式搜索引擎,提供搜集、分析、存储数据等主要功能。

- Console 是一个可视化工具,提供可视化查询,制作报表等功能。

本文将搭建一个统一日志管理平台。使用 Filebeat 采集 OS 中的日志(其他日志大同小异),发送到 Easysearch 中。最后通过 Console 进行日志的可视化查询与分析。

操作步骤

- 准备工作

- 部署 Easysearch

- 编辑 easysearch.yml 文件,打开注释 elasticsearch.api_compatibility: true

- 部署 Console

- 部署 Easysearch

- 安装并配置 Filebeat

- 下载 Filebeat,版本建议选择 7.10.2。下载地址:https://www.elastic.co/cn/downloads/past-releases/filebeat-oss-7-10-2

- 修改配置 filebeat.yml 文件

setup.template.name: "filebeat"

setup.template.pattern: "system-log*"

setup.template.fields: "${path.config}/fields.yml"

output.elasticsearch:

hosts: ["localhost:9200"]

protocol: "https"

ssl.verification_mode: none

username: "admin"

password: "4ad8f8f792e81cd0a6de"

index: "system-log"- 启用 system 模块并导入 pipeline

./filebeat modules enable system

./filebeat setup --pipelines --modules system

- 创建索引模板及初始索引,使用 ZSTD+SOURCE_REUSE 技术节省磁盘空间

PUT _template/system_log

{

"order": 100,

"index_patterns": [

"system_log*"

],

"settings": {

"index": {

"format": "7",

"lifecycle": {

"name": "ilm_.infini_metrics-30days-retention",

"rollover_alias": "system_log"

},

"codec": "ZSTD",

"source_reuse": true,

"number_of_shards": "1",

"translog": {

"durability": "async"

}

}

},

"mappings": {

"dynamic_templates": [

{

"strings": {

"mapping": {

"ignore_above": 256,

"type": "keyword"

},

"match_mapping_type": "string"

}

}

]

}

}

PUT system-log-00001

{

"aliases":{

"system-log":{

"is_write_index":true

}

}

}- 启动 filebeat

nohup ./filebeat -c filebeat.yml 2>&1>/dev/null &

- 进入 Console 查看、搜索日志

- 进入 Console 创建 dashboard 进行日志分析

社区日报 第1739期 (2023-11-16)

https://medium.com/%40adrirajc ... 80e02

2.通过图像搜索找到您的小狗

https://www.elastic.co/search- ... earch

3.在 Elasticsearch 和 Go 中通过矢量搜索寻找 gophers

https://www.elastic.co/search- ... ector

编辑:Se7en

https://medium.com/%40adrirajc ... 80e02

2.通过图像搜索找到您的小狗

https://www.elastic.co/search- ... earch

3.在 Elasticsearch 和 Go 中通过矢量搜索寻找 gophers

https://www.elastic.co/search- ... ector

编辑:Se7en 收起阅读 »

社区日报 第1738期 (2023-11-15)

https://zhuanlan.zhihu.com/p/658027772

2.《搜索引擎与程序化广告》新书直播:文字总结(下篇)

https://zhuanlan.zhihu.com/p/658029038

3MySQL, Redis和Lucene 索引设计思考

https://zhuanlan.zhihu.com/p/480308919

编辑:kin122

https://zhuanlan.zhihu.com/p/658027772

2.《搜索引擎与程序化广告》新书直播:文字总结(下篇)

https://zhuanlan.zhihu.com/p/658029038

3MySQL, Redis和Lucene 索引设计思考

https://zhuanlan.zhihu.com/p/480308919

编辑:kin122 收起阅读 »

社区日报 第1737期 (2023-11-14)

1. 我和ES结缘的第一天(需要梯子)

https://medium.com/%40bairagia ... 0f977

2. 拿ES怼时序数据也可以哦(需要梯子)

https://medium.com/data-reply- ... 68f56

3. ELK 全家初探(需要梯子)

https://medium.com/codenx/expl ... c26d6

编辑:斯蒂文

1. 我和ES结缘的第一天(需要梯子)

https://medium.com/%40bairagia ... 0f977

2. 拿ES怼时序数据也可以哦(需要梯子)

https://medium.com/data-reply- ... 68f56

3. ELK 全家初探(需要梯子)

https://medium.com/codenx/expl ... c26d6

编辑:斯蒂文

收起阅读 »

搜索客:Elasticsearch 中文社区的崭新征程

社区就是一个大家庭,很多小伙伴可能现在已经没有活跃在相关领域了,但是在咱们社区发展的过程中,有很多优秀的小伙伴积极参与做出了大量杰出的贡献,第一次大会的场地离不开 @三斗室 的大力支持,还记得只有 20-30 号人,糙的很,连拍照都没有来得及进行,社区里面带来各种干货分享 @wood 大叔,一直在社区默默奉献的石阳,说学逗唱样样精通的斌哥,深圳分会的杨振涛,武汉分会的白凡,南京分会的李啸,广州分会的鸿智等等其他各个城市的社区分会主席们,咱们甚至台湾还有分会,还记得 Advent 分享文章接力么,还记得咱们的翻译小组么,还记得咱们一起通宵达旦编写 Elasticsearch 权威指南中文版本的的日子么, 80 多人浩浩荡荡分成 5 个团队,中国开源史上最早的大协作,咱们还有社区编辑部,现在还在坚持每天一篇相关行业新闻的社区日报社,迄今为止已经 1700 多期了,还有每次大会的志愿者们,还有给咱们社区带来几百个分享的嘉宾们,名字实在太多了,不能一一列举了,但我都记下了,这个社区正是因为有了你们,才这么精彩,感谢你们。

然而,没有哪项技术能永远保持新鲜活力,当一些技术逐渐成熟,相应的讨论似乎也变得有限。然而,搜索领域的从业者并未停止前行的脚步,每一年都有新的搜索技术涌现,今年的最火话题必然是 GenAI 或者 AIGC 啦,Embedding、LLM、向量数据库、RAG 摩拳擦掌,传统搜索是否还能再战几个回合?硬件发展也是一日千里,几百核,上 TB SSD 的机器成为常态,快速迭代的硬件架构需要与时俱进的软件架构,兼顾安全和高效的 Rust 发展也是热火朝天,我于 2021 年底离开 Elastic 出来创办了 INFINI Labs 也在积极探索下一代搜索引擎的发展,不过可以预见的是,未来的搜索必定将更加智能化,性能更加强悍,使用更加简单,相信大家和我一样我对新技术的发展充满了期待,拭目以待吧。

从业十多年来一直在围绕搜索打转,深感搜索技术所涵盖的领域极为广泛,从文本分析到从自然语言处理,从算法到数据结构,从单机高性能到海量 PB 分布式,从机器学习到大模型,从传统的运维日志分析到上天揽月的前沿科技,都有搜索技术的身影。众行致远,国外有类似 BERLIN BUZZWORDS 这样优质的大会和交流社区,而国内这样垂直且优质的社区还相对较为缺乏,希望咱们的社区能够成为这样一个专注于搜索领域的小圈子。并且应该更加开放,除了 Elasticsearch,其他任何跟搜索相关的技术和框架我们都欢迎交流,也希望国内更多和我们一样参与搜索核心技术研究的厂商和同仁们也能参与进来,并且希望在这里,不仅是可以围绕搜索的各种相关技术进行讨论交流,还能找到志同道合的朋友一起共同进步,共同构建一个咱们自己的小家园。

因此,Elasticsearch 中文社区进行全新的品牌升级,正式更名为“搜索客”,以新的 Slogan:“搜索人自己的社区” 为宣言,并以全新的面貌来迎接社区的小伙伴们,相信你们已经注意到了我们的社区网站已经更新了全新的 Logo 和视觉风格,后续调整完毕也将启用新的域名:searchkit.org/searchkit.cn。 我们期望新的搜索客社区能够为广大搜索领域的从业者提供更为丰富和便捷的交流平台。希望在这里,我们能够共同见证搜索技术的新篇章,为整个搜索领域的发展添砖加瓦。

Medcl

社区就是一个大家庭,很多小伙伴可能现在已经没有活跃在相关领域了,但是在咱们社区发展的过程中,有很多优秀的小伙伴积极参与做出了大量杰出的贡献,第一次大会的场地离不开 @三斗室 的大力支持,还记得只有 20-30 号人,糙的很,连拍照都没有来得及进行,社区里面带来各种干货分享 @wood 大叔,一直在社区默默奉献的石阳,说学逗唱样样精通的斌哥,深圳分会的杨振涛,武汉分会的白凡,南京分会的李啸,广州分会的鸿智等等其他各个城市的社区分会主席们,咱们甚至台湾还有分会,还记得 Advent 分享文章接力么,还记得咱们的翻译小组么,还记得咱们一起通宵达旦编写 Elasticsearch 权威指南中文版本的的日子么, 80 多人浩浩荡荡分成 5 个团队,中国开源史上最早的大协作,咱们还有社区编辑部,现在还在坚持每天一篇相关行业新闻的社区日报社,迄今为止已经 1700 多期了,还有每次大会的志愿者们,还有给咱们社区带来几百个分享的嘉宾们,名字实在太多了,不能一一列举了,但我都记下了,这个社区正是因为有了你们,才这么精彩,感谢你们。

然而,没有哪项技术能永远保持新鲜活力,当一些技术逐渐成熟,相应的讨论似乎也变得有限。然而,搜索领域的从业者并未停止前行的脚步,每一年都有新的搜索技术涌现,今年的最火话题必然是 GenAI 或者 AIGC 啦,Embedding、LLM、向量数据库、RAG 摩拳擦掌,传统搜索是否还能再战几个回合?硬件发展也是一日千里,几百核,上 TB SSD 的机器成为常态,快速迭代的硬件架构需要与时俱进的软件架构,兼顾安全和高效的 Rust 发展也是热火朝天,我于 2021 年底离开 Elastic 出来创办了 INFINI Labs 也在积极探索下一代搜索引擎的发展,不过可以预见的是,未来的搜索必定将更加智能化,性能更加强悍,使用更加简单,相信大家和我一样我对新技术的发展充满了期待,拭目以待吧。

从业十多年来一直在围绕搜索打转,深感搜索技术所涵盖的领域极为广泛,从文本分析到从自然语言处理,从算法到数据结构,从单机高性能到海量 PB 分布式,从机器学习到大模型,从传统的运维日志分析到上天揽月的前沿科技,都有搜索技术的身影。众行致远,国外有类似 BERLIN BUZZWORDS 这样优质的大会和交流社区,而国内这样垂直且优质的社区还相对较为缺乏,希望咱们的社区能够成为这样一个专注于搜索领域的小圈子。并且应该更加开放,除了 Elasticsearch,其他任何跟搜索相关的技术和框架我们都欢迎交流,也希望国内更多和我们一样参与搜索核心技术研究的厂商和同仁们也能参与进来,并且希望在这里,不仅是可以围绕搜索的各种相关技术进行讨论交流,还能找到志同道合的朋友一起共同进步,共同构建一个咱们自己的小家园。

因此,Elasticsearch 中文社区进行全新的品牌升级,正式更名为“搜索客”,以新的 Slogan:“搜索人自己的社区” 为宣言,并以全新的面貌来迎接社区的小伙伴们,相信你们已经注意到了我们的社区网站已经更新了全新的 Logo 和视觉风格,后续调整完毕也将启用新的域名:searchkit.org/searchkit.cn。 我们期望新的搜索客社区能够为广大搜索领域的从业者提供更为丰富和便捷的交流平台。希望在这里,我们能够共同见证搜索技术的新篇章,为整个搜索领域的发展添砖加瓦。

Medcl 收起阅读 »

社区日报 第1736期 (2023-11-13)

https://mp.weixin.qq.com/s/GCcmBixIvOjblkHZiAGXCw

2. Elasticsearch 性能监控

https://blog.csdn.net/mingongg ... 98538

3. Elasticsearch分片数量选择及如何保证数据一致性

https://blog.csdn.net/github_3 ... 83971

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://mp.weixin.qq.com/s/GCcmBixIvOjblkHZiAGXCw

2. Elasticsearch 性能监控

https://blog.csdn.net/mingongg ... 98538

3. Elasticsearch分片数量选择及如何保证数据一致性

https://blog.csdn.net/github_3 ... 83971

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1735期 (2023-11-10)

https://www.elastic.co/fr/blog ... -11-0

2、Elasticsearch ES|QL 牛在哪里

https://www.elastic.co/cn/blog ... guage

3、Elasticsearch 向量检索视频解读(梯子)

https://www.elastic.co/cn/vide ... earch

编辑:铭毅天下

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://www.elastic.co/fr/blog ... -11-0

2、Elasticsearch ES|QL 牛在哪里

https://www.elastic.co/cn/blog ... guage

3、Elasticsearch 向量检索视频解读(梯子)

https://www.elastic.co/cn/vide ... earch

编辑:铭毅天下

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »

社区日报 第1734期 (2023-11-09)

https://mp.weixin.qq.com/s/tU9nN7AOFJs13QazPLfKJA

2.使用 Elastic Beat 采集 Prometheus 数据(需要梯子)

https://thomasdecaux.medium.co ... 1fedd

3.ES|QL(Elasticsearch 查询语言)入门

https://www.elastic.co/blog/ge ... guage

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://mp.weixin.qq.com/s/tU9nN7AOFJs13QazPLfKJA

2.使用 Elastic Beat 采集 Prometheus 数据(需要梯子)

https://thomasdecaux.medium.co ... 1fedd

3.ES|QL(Elasticsearch 查询语言)入门

https://www.elastic.co/blog/ge ... guage

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »

社区日报 第1733期 (2023-11-08)

https://medium.com/%40andre.lu ... 0c055

2.Elasticsearch:搜索架构

https://elasticstack.blog.csdn ... 44073

3.Elasticsearch:处理 Elasticsearch 中的字段名称不一致

https://elasticstack.blog.csdn ... 75664

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://medium.com/%40andre.lu ... 0c055

2.Elasticsearch:搜索架构

https://elasticstack.blog.csdn ... 44073

3.Elasticsearch:处理 Elasticsearch 中的字段名称不一致

https://elasticstack.blog.csdn ... 75664

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

从白日梦到现实:推出 Elastic 的管道查询语言 ES|QL

!(https://img-blog.csdnimg.cn/a5 ... 63.png)

今天,我们很高兴地宣布 Elastic® 的新管道查询语言 [ES|QL](https://www.elastic.co/guide/e ... .html "ES|QL")(Elasticsearch 查询语言)的技术预览版,它可以转换、丰富和简化数据调查。 ES|QL 由新的查询引擎提供支持,通过并发处理提供高级搜索功能,无论数据源和结构如何,都可以提高速度和效率。 通过在单个屏幕上创建聚合和可视化来快速解决问题,以实现迭代和流畅的工作流程。

ES|QL 介绍

Elasticsearch 的演变

-----------------

在过去 13 年中,[Elasticsearch®](https://www.elastic.co/elasticsearch/ "Elasticsearch®") 取得了显着发展,适应了用户需求和不断变化的数字环境。 Elasticsearch 最初用于全文搜索,后来根据用户反馈扩展到支持更广泛的用例。 在整个过程中,Elasticsearch [Query DSL](https://www.elastic.co/guide/e ... .html "Query DSL")(我们第一个采用的搜索语言)为过滤器、聚合和其他操作提供了丰富的查询集。 这种基于 JSON 的 DSL 最终成为我们 [_search](https://www.elastic.co/guide/e ... .html "_search") API 端点的基础。

随着时间的推移和需求的多样化,逐渐显现出用户需要的不仅仅是查询 DSL 所提供的功能。我们开始在查询 DSL 下引入和融合了其他 DSL,用于[脚本编写](https://www.elastic.co/guide/e ... .html "脚本编写")、安全调查中的[事件](https://www.elastic.co/guide/e ... .html "事件")等等。然而,尽管这些扩展功能非常多才多艺,它们并没有完全满足用户的一些需求。

用户想要一种能够:

* 简化威胁和安全调查,同时通过提供全面和迭代方法的单个查询观察和解决生产问题

* 通过单一界面搜索、丰富、聚合和可视化更多内容来简化数据调查

* 使用高级搜索功能(例如带有并发处理的查找)提高查询大量数据的速度和效率,无论来源和结构如何

更多阅读,请点击 https://elasticstack.blog.csdn ... 86439

!(https://img-blog.csdnimg.cn/a5 ... 63.png)

今天,我们很高兴地宣布 Elastic® 的新管道查询语言 [ES|QL](https://www.elastic.co/guide/e ... .html "ES|QL")(Elasticsearch 查询语言)的技术预览版,它可以转换、丰富和简化数据调查。 ES|QL 由新的查询引擎提供支持,通过并发处理提供高级搜索功能,无论数据源和结构如何,都可以提高速度和效率。 通过在单个屏幕上创建聚合和可视化来快速解决问题,以实现迭代和流畅的工作流程。

ES|QL 介绍

Elasticsearch 的演变

-----------------

在过去 13 年中,[Elasticsearch®](https://www.elastic.co/elasticsearch/ "Elasticsearch®") 取得了显着发展,适应了用户需求和不断变化的数字环境。 Elasticsearch 最初用于全文搜索,后来根据用户反馈扩展到支持更广泛的用例。 在整个过程中,Elasticsearch [Query DSL](https://www.elastic.co/guide/e ... .html "Query DSL")(我们第一个采用的搜索语言)为过滤器、聚合和其他操作提供了丰富的查询集。 这种基于 JSON 的 DSL 最终成为我们 [_search](https://www.elastic.co/guide/e ... .html "_search") API 端点的基础。

随着时间的推移和需求的多样化,逐渐显现出用户需要的不仅仅是查询 DSL 所提供的功能。我们开始在查询 DSL 下引入和融合了其他 DSL,用于[脚本编写](https://www.elastic.co/guide/e ... .html "脚本编写")、安全调查中的[事件](https://www.elastic.co/guide/e ... .html "事件")等等。然而,尽管这些扩展功能非常多才多艺,它们并没有完全满足用户的一些需求。

用户想要一种能够:

* 简化威胁和安全调查,同时通过提供全面和迭代方法的单个查询观察和解决生产问题

* 通过单一界面搜索、丰富、聚合和可视化更多内容来简化数据调查

* 使用高级搜索功能(例如带有并发处理的查找)提高查询大量数据的速度和效率,无论来源和结构如何

更多阅读,请点击 https://elasticstack.blog.csdn ... 86439 收起阅读 »

社区日报 第1732期 (2023-11-07)

1. K8S里的日志处理,这次我想试试EFK(需要梯子)

https://medium.com/%40kishorch ... c5e84

2. 你看到的相关性分数,你看不到的核心库 —— lucene(需要梯子)

https://medium.com/%40josemamg ... 95a09

3. prometheus VS ES 全家监控和日志分析的巅峰对决(需要梯子)

https://medium.com/cloud-nativ ... 791cd

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

1. K8S里的日志处理,这次我想试试EFK(需要梯子)

https://medium.com/%40kishorch ... c5e84

2. 你看到的相关性分数,你看不到的核心库 —— lucene(需要梯子)

https://medium.com/%40josemamg ... 95a09

3. prometheus VS ES 全家监控和日志分析的巅峰对决(需要梯子)

https://medium.com/cloud-nativ ... 791cd

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »