社区日报 第1640期 (2023-06-05)

https://blog.51cto.com/u_10535186/5382523

2. Elasticsearch 预处理

https://blog.csdn.net/laoyang3 ... 28606

3. Elasticsearch:异步搜索

https://blog.csdn.net/UbuntuTo ... 64176

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://blog.51cto.com/u_10535186/5382523

2. Elasticsearch 预处理

https://blog.csdn.net/laoyang3 ... 28606

3. Elasticsearch:异步搜索

https://blog.csdn.net/UbuntuTo ... 64176

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1639期 (2023-06-01)

https://medium.com/%40domainad ... 6b7e1

2.RediSearch vs Elasticsearch(需要梯子)

https://medium.com/%40aytuncca ... 3222f

3.如何将 GitHub 高级安全警报与 Elasticsearch 集成(需要梯子)

https://blog.devgenius.io/how- ... 44cb4

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://medium.com/%40domainad ... 6b7e1

2.RediSearch vs Elasticsearch(需要梯子)

https://medium.com/%40aytuncca ... 3222f

3.如何将 GitHub 高级安全警报与 Elasticsearch 集成(需要梯子)

https://blog.devgenius.io/how- ... 44cb4

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »

社区日报 第1638期 (2023-05-31)

https://blog.csdn.net/UbuntuTo ... 39327

2.Elasticsearch 实现distinct计算方法(需要梯子)

https://pratik-patil.medium.co ... ad4a7

3.使用 LangChain 和 Elasticsearch 的隐私优先 AI 搜索

https://blog.csdn.net/UbuntuTo ... 40333

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://blog.csdn.net/UbuntuTo ... 39327

2.Elasticsearch 实现distinct计算方法(需要梯子)

https://pratik-patil.medium.co ... ad4a7

3.使用 LangChain 和 Elasticsearch 的隐私优先 AI 搜索

https://blog.csdn.net/UbuntuTo ... 40333

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1637期 (2023-05-30)

https://medium.com/appscode/de ... 20dd0

2. 多领域数据是怎么打破数据孤岛的?(需要梯子)

https://medium.com/ownbackup/b ... e932d

3. 为啥用了倒排索引,日志搜索可以嗖嗖的(需要梯子)

https://blog.devgenius.io/what ... 81d20

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://medium.com/appscode/de ... 20dd0

2. 多领域数据是怎么打破数据孤岛的?(需要梯子)

https://medium.com/ownbackup/b ... e932d

3. 为啥用了倒排索引,日志搜索可以嗖嗖的(需要梯子)

https://blog.devgenius.io/what ... 81d20

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

收起阅读 »

社区日报 第1636期 (2023-05-29)

https://blog.csdn.net/wwd0501/ ... 84146

2. 使用 Elastic 机器学习进行 data frame 分析

https://blog.csdn.net/UbuntuTo ... 90329

3. Elasticsearch 电商实战经验深度复盘

https://blog.51cto.com/u_14886891/5283265

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://blog.csdn.net/wwd0501/ ... 84146

2. 使用 Elastic 机器学习进行 data frame 分析

https://blog.csdn.net/UbuntuTo ... 90329

3. Elasticsearch 电商实战经验深度复盘

https://blog.51cto.com/u_14886891/5283265

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

INFINI Labs 产品更新 | Console 新增数据比对、新增数据看板表格组件及支持下钻功能等

INFINI Labs 产品更新啦~,本次产品版本更新包括 Gateway v1.14.0、Console v1.2.0、Easysearch v1.1.1 等,其中 Console 在上一版基础上做了很多优化改进以及新增了一些特性,如新增数据比对校验功能、数据看板模块新增了表格组件、图表组件支持下钻功能等。欢迎下载体验。

INFINI Gateway v1.14.0

极限网关本次更新如下:

Features

- 支持自定义服务名称

metrics增加实例 user_in_ms 和 sys_in_ms 采集elasticsearch增加 dial_timeout 选项

Bug Fix

- 修复网关开启实时日志推送后命令行日志无法输出的问题

logging修复 min_elapsed_time_in_ms 选项不生效的问题- 修复一个消费闲置队列造成 CPU 占用高的问题

更多更新参见【 Gateway 版本历史 】。

INFINI Console v1.2.0

Console 本次更新如下:

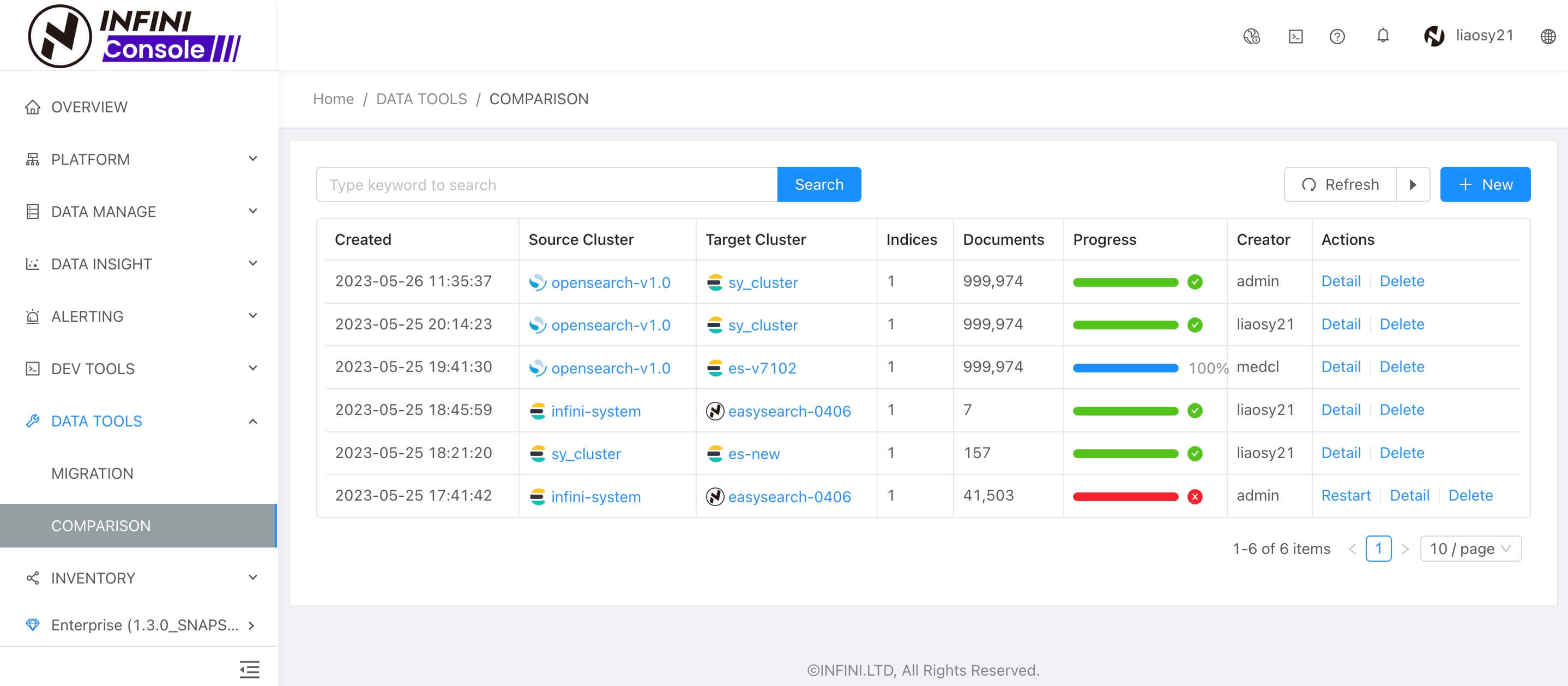

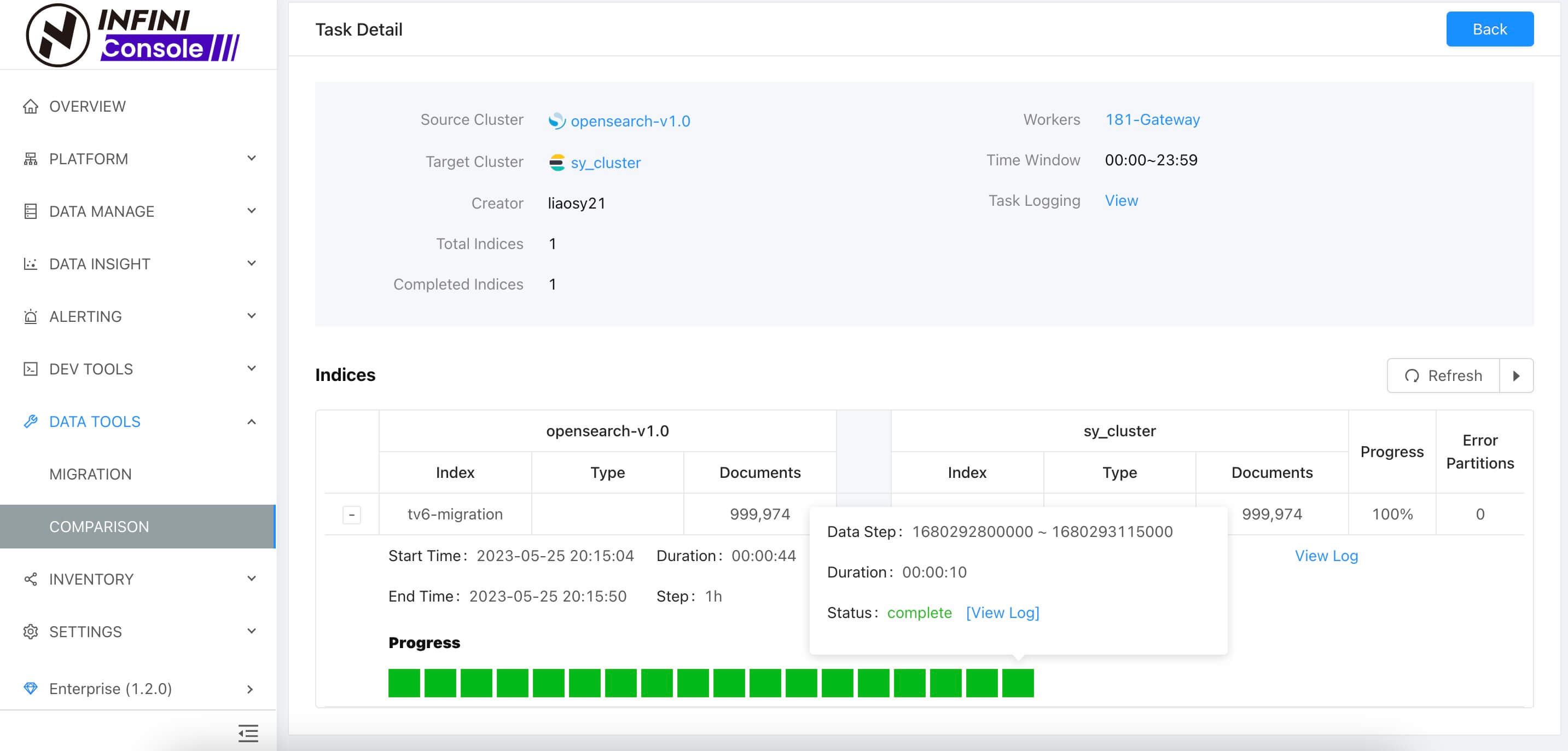

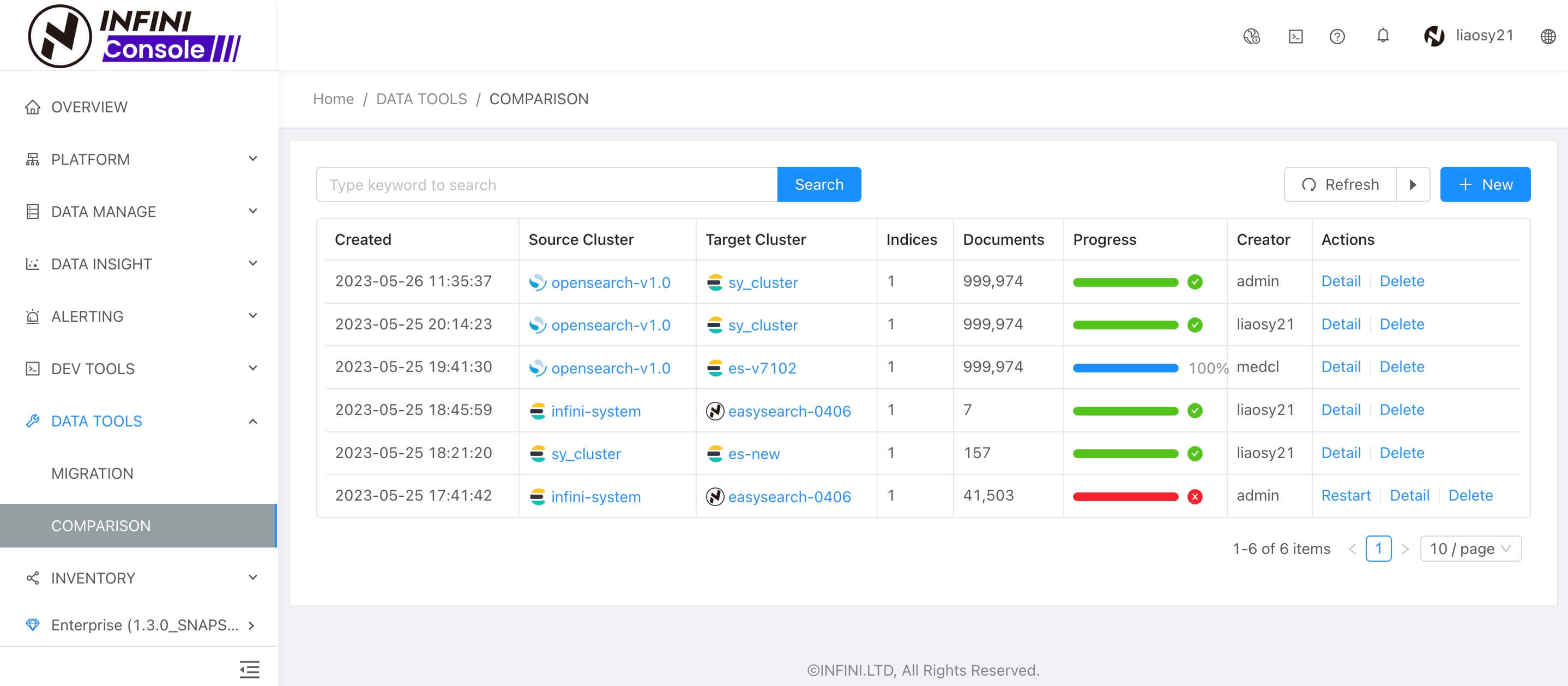

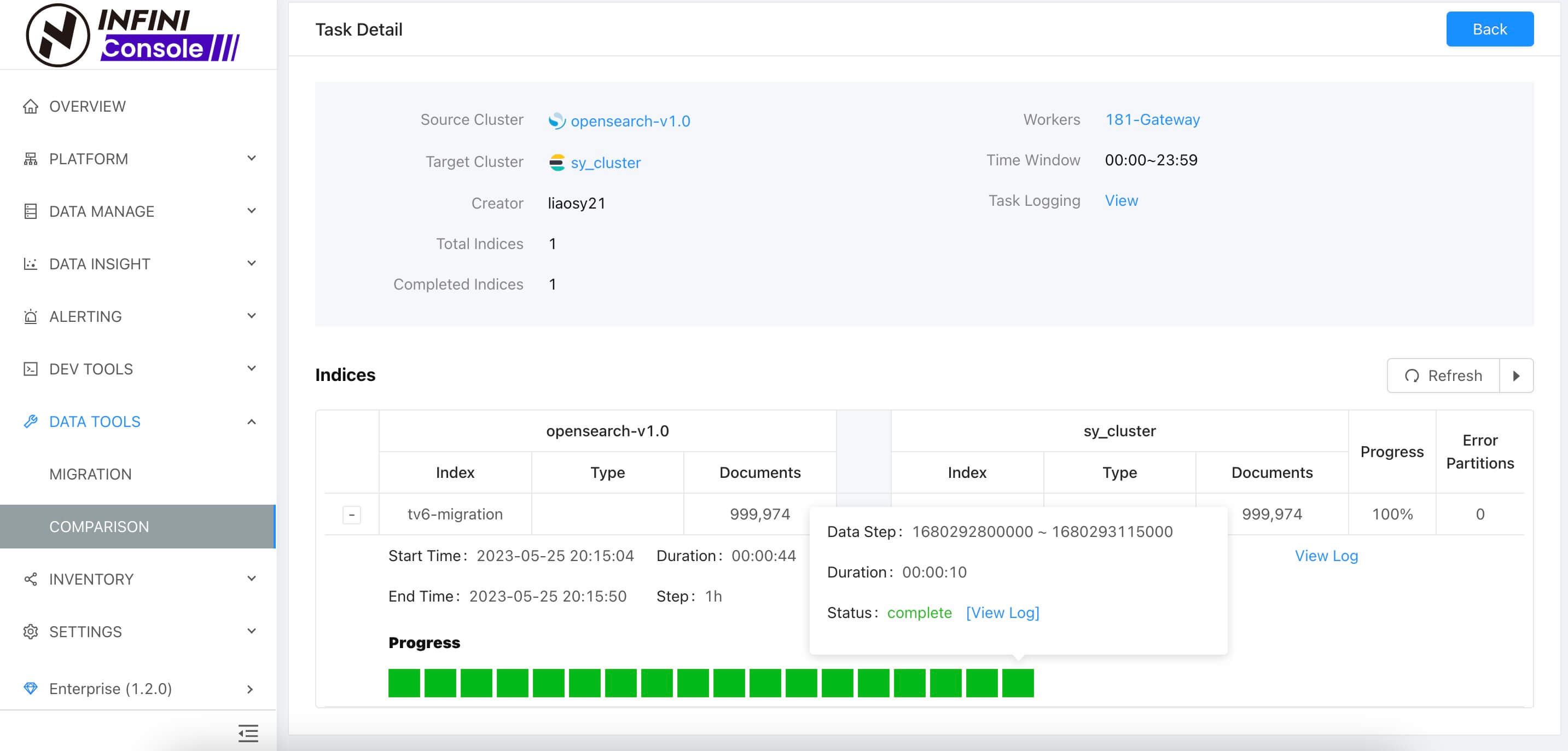

数据比对

数据比对目前支持跨集群索引全量数据校验,常用于索引数据迁移之后,校验两端的数据是否一致,保障数据迁移的正确性。通过 UI 界面创建数据校验任务和管理。

进入校验任务详情,能够可视化展示分区子任务的进度,不同的颜色方块表示进度状态,如绿色表示校验成功、红色表示校验失败,如失败了可以查看 log 日志进行错误原因定位。

具体操作参见:教程。

数据看板

Console 数据看板模块新增了表格组件,进一步扩展 Dashboard 看板图表多样化,增强数据可视化能力。详情查看 操作演示视频。

同时,数据看板模块新增了下钻功能,支持图表组件配置自定义下钻 URL 链接,在图表组件上进行时间范围框选后即可点击下钻按钮进行链接跳转。详情查看 操作演示视频。

告警模板支持环境变量

新版 Console 支持解析系统环境变量和配置文件中配置的环境变量。在配置告警规则消息内容时可通过 {{$.env.VARIABLE}} 方式设置环境变量,详情参见:教程。

除了以上主要新增功能外,Console 其他更新如下:

Bug fix

- 修复数据看板组件复制的问题

- 修复开启实时推送日志后,不写文件日志的问题

- 修复初始化时,系统集群没有索引,节点元数据的问题

- 修复网关重启后,数据迁移任务无法结束的问题

- 修复数据迁移任务统计数据重复的问题

- 修复数据探索列表时间字段排序问题

Improvements

- 告警规则表达式显示优化

- 优化数据迁移任务调度流程,减少 ES 调用次数

- 数据迁移任务增加跳过 scroll/bulk 文档数检查选项

更多更新参见【 Console 版本历史 】。

INFINI Framework

INFINI Framework 作为 INFINI Search Platform 各产品组件的公共框架模块,其更新如下:

Features

- 支持自定义服务名称,可用于单机多实例部署

- 新增统计接口别名:

/stats/prometheus

INFINI Easysearch v1.1.1

Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 衍生自基于开源协议 Apache 2.0 的 Elasticsearch 7.10.2 版本。本次主要更新如下:

Bug fix

- 修复模板别名在某些场景不生效的 Bug

- 防止 BigArray 在某些场景发生内存泄漏

- 修复 SourceValueFetcher 可能遗漏字段的 Bug

Improvements

- easysearch.yml 增加 elasticsearch.api_compatibility 配置项,兼容 logstash-oss,filebeat-oss,apm-server-oss 等 elasticsearch 的客户端

更多更新参见【 Easysearch 版本历史 】。

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

最后祝大家周末愉快!

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

INFINI Labs 产品更新啦~,本次产品版本更新包括 Gateway v1.14.0、Console v1.2.0、Easysearch v1.1.1 等,其中 Console 在上一版基础上做了很多优化改进以及新增了一些特性,如新增数据比对校验功能、数据看板模块新增了表格组件、图表组件支持下钻功能等。欢迎下载体验。

INFINI Gateway v1.14.0

极限网关本次更新如下:

Features

- 支持自定义服务名称

metrics增加实例 user_in_ms 和 sys_in_ms 采集elasticsearch增加 dial_timeout 选项

Bug Fix

- 修复网关开启实时日志推送后命令行日志无法输出的问题

logging修复 min_elapsed_time_in_ms 选项不生效的问题- 修复一个消费闲置队列造成 CPU 占用高的问题

更多更新参见【 Gateway 版本历史 】。

INFINI Console v1.2.0

Console 本次更新如下:

数据比对

数据比对目前支持跨集群索引全量数据校验,常用于索引数据迁移之后,校验两端的数据是否一致,保障数据迁移的正确性。通过 UI 界面创建数据校验任务和管理。

进入校验任务详情,能够可视化展示分区子任务的进度,不同的颜色方块表示进度状态,如绿色表示校验成功、红色表示校验失败,如失败了可以查看 log 日志进行错误原因定位。

具体操作参见:教程。

数据看板

Console 数据看板模块新增了表格组件,进一步扩展 Dashboard 看板图表多样化,增强数据可视化能力。详情查看 操作演示视频。

同时,数据看板模块新增了下钻功能,支持图表组件配置自定义下钻 URL 链接,在图表组件上进行时间范围框选后即可点击下钻按钮进行链接跳转。详情查看 操作演示视频。

告警模板支持环境变量

新版 Console 支持解析系统环境变量和配置文件中配置的环境变量。在配置告警规则消息内容时可通过 {{$.env.VARIABLE}} 方式设置环境变量,详情参见:教程。

除了以上主要新增功能外,Console 其他更新如下:

Bug fix

- 修复数据看板组件复制的问题

- 修复开启实时推送日志后,不写文件日志的问题

- 修复初始化时,系统集群没有索引,节点元数据的问题

- 修复网关重启后,数据迁移任务无法结束的问题

- 修复数据迁移任务统计数据重复的问题

- 修复数据探索列表时间字段排序问题

Improvements

- 告警规则表达式显示优化

- 优化数据迁移任务调度流程,减少 ES 调用次数

- 数据迁移任务增加跳过 scroll/bulk 文档数检查选项

更多更新参见【 Console 版本历史 】。

INFINI Framework

INFINI Framework 作为 INFINI Search Platform 各产品组件的公共框架模块,其更新如下:

Features

- 支持自定义服务名称,可用于单机多实例部署

- 新增统计接口别名:

/stats/prometheus

INFINI Easysearch v1.1.1

Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 衍生自基于开源协议 Apache 2.0 的 Elasticsearch 7.10.2 版本。本次主要更新如下:

Bug fix

- 修复模板别名在某些场景不生效的 Bug

- 防止 BigArray 在某些场景发生内存泄漏

- 修复 SourceValueFetcher 可能遗漏字段的 Bug

Improvements

- easysearch.yml 增加 elasticsearch.api_compatibility 配置项,兼容 logstash-oss,filebeat-oss,apm-server-oss 等 elasticsearch 的客户端

更多更新参见【 Easysearch 版本历史 】。

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

最后祝大家周末愉快!

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

收起阅读 »社区日报 第1635期 (2023-05-26)

1、Elasticsearch — 搜索的解决方案(梯子)

https://blog.devgenius.io/elas ... 0c82f

2、管理Elasticsearch索引的最佳实践(梯子)

https://logz.io/blog/managing- ... ices/

3、在几分钟内将大数据集(>10M)索引到Elastic Search中(梯子)

https://blog.changecx.com/inde ... 53163

编辑:铭毅天下

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

1、Elasticsearch — 搜索的解决方案(梯子)

https://blog.devgenius.io/elas ... 0c82f

2、管理Elasticsearch索引的最佳实践(梯子)

https://logz.io/blog/managing- ... ices/

3、在几分钟内将大数据集(>10M)索引到Elastic Search中(梯子)

https://blog.changecx.com/inde ... 53163

编辑:铭毅天下

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »

社区日报 第1634期 (2023-05-25)

https://dev.to/strapi/how-to-s ... -3nnc

2.使用 React 和 ElasticSearch 搭建一个 Airbnb

https://hackernoon.com/how-to- ... 73yna

3.Manticore Search, Elasticsearch, ClickHouse 性能测试

https://hackernoon.com/analyzi ... -news

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://dev.to/strapi/how-to-s ... -3nnc

2.使用 React 和 ElasticSearch 搭建一个 Airbnb

https://hackernoon.com/how-to- ... 73yna

3.Manticore Search, Elasticsearch, ClickHouse 性能测试

https://hackernoon.com/analyzi ... -news

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »

社区日报 第1633期 (2023-05-24)

https://lazypro.medium.com/boo ... 114bc

2.Elasticsearch:使用 query_string 查询的短语及模糊查询

https://blog.csdn.net/UbuntuTo ... 76683

3.去理解一下 apache lucene 的存储系统(需要梯子)

https://medium.com/%40vaibhavk ... 6e230

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://lazypro.medium.com/boo ... 114bc

2.Elasticsearch:使用 query_string 查询的短语及模糊查询

https://blog.csdn.net/UbuntuTo ... 76683

3.去理解一下 apache lucene 的存储系统(需要梯子)

https://medium.com/%40vaibhavk ... 6e230

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1632期 (2023-05-23)

1. ES 知识点串讲(6)路由(需要梯子)

https://braineanear.medium.com ... 390d7

2. 奈飞的数据资产管理系统想了解一下吗?(需要梯子)

https://netflixtechblog.com/da ... c35c9

3. 华为云里装ELK有啥特别的吗?(需要梯子)

https://medium.com/huawei-deve ... dd806

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

1. ES 知识点串讲(6)路由(需要梯子)

https://braineanear.medium.com ... 390d7

2. 奈飞的数据资产管理系统想了解一下吗?(需要梯子)

https://netflixtechblog.com/da ... c35c9

3. 华为云里装ELK有啥特别的吗?(需要梯子)

https://medium.com/huawei-deve ... dd806

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

收起阅读 »

社区日报 第1631期 (2023-05-22)

https://mp.weixin.qq.com/s/YtCAIODjKNdyURnjisERsA

2. Elasticsearch 生产数据备份恢复

https://zhuanlan.zhihu.com/p/147705038

3. 使用Kibana 进行Elasticsearch 8.2.2数据备份

https://blog.csdn.net/weixin_4 ... 83675

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://mp.weixin.qq.com/s/YtCAIODjKNdyURnjisERsA

2. Elasticsearch 生产数据备份恢复

https://zhuanlan.zhihu.com/p/147705038

3. 使用Kibana 进行Elasticsearch 8.2.2数据备份

https://blog.csdn.net/weixin_4 ... 83675

编辑:yuebancanghai

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili 收起阅读 »

社区日报 第1630期 (2023-05-18)

https://medium.com/naukri-engi ... 47181

2.Prometheus 监控 Elasticsearch 的主要指标

https://dev.to/sysdig/top-metr ... -3pca

3.如何使用 Elasticsearch 在零售业创造卓越的用户体验

https://dev.to/egeninc/how-to- ... l-4c3

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

https://medium.com/naukri-engi ... 47181

2.Prometheus 监控 Elasticsearch 的主要指标

https://dev.to/sysdig/top-metr ... -3pca

3.如何使用 Elasticsearch 在零售业创造卓越的用户体验

https://dev.to/egeninc/how-to- ... l-4c3

编辑:Se7en

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili 收起阅读 »

社区日报 第1629期 (2023-05-17)

https://cloud.tencent.com/deve ... 66781

2.Elasticsearch:Standard Text Analyzer - 标准文本分析器

https://elasticstack.blog.csdn ... 78016

3.Elasticsearch:NLP 和 Elastic:入门

https://elasticstack.blog.csdn ... 91484

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

https://cloud.tencent.com/deve ... 66781

2.Elasticsearch:Standard Text Analyzer - 标准文本分析器

https://elasticstack.blog.csdn ... 78016

3.Elasticsearch:NLP 和 Elastic:入门

https://elasticstack.blog.csdn ... 91484

编辑:kin122

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站:https://ela.st/bilibili

收起阅读 »

社区日报 第1628期 (2023-05-16)

1. ES 知识点串讲(3)分片与拓展(需要梯子)

https://braineanear.medium.com ... 6321f

2. ES 知识点串讲(4)副本(需要梯子)

https://braineanear.medium.com ... 32e42

3. ES 知识点串讲(5)节点角色(需要梯子)

https://braineanear.medium.com ... 4257e

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

1. ES 知识点串讲(3)分片与拓展(需要梯子)

https://braineanear.medium.com ... 6321f

2. ES 知识点串讲(4)副本(需要梯子)

https://braineanear.medium.com ... 32e42

3. ES 知识点串讲(5)节点角色(需要梯子)

https://braineanear.medium.com ... 4257e

编辑:斯蒂文

归档:https://ela.st/cn-daily-all

订阅:https://ela.st/cn-daily-sub

沙龙:https://ela.st/cn-meetup

B站: https://ela.st/bilibili

收起阅读 »

INFINI Labs 产品更新 | 重磅推出 Easysearch 一个分布式的近实时搜索与分析引擎

INFINI Labs 产品又更新啦,包括 Easysearch v1.1.0、Gateway v1.13.0、Console v1.1.0、Agent v0.4.0,其中 Easysearch 经过团队的数月打磨,现正式对外推出。Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 衍生自基于开源协议 Apache 2.0 的 Elasticsearch 7.10.2 版本。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。与 Elasticsearch 相比,Easysearch 更关注在搜索业务场景的优化和继续保持其产品的简洁与易用性。欢迎大家下载体验。

INFINI Easysearch v1.1.0

INFINI Easysearch 本次更新最重要的功能是引入了 ZSTD 压缩算法,对索引进行全方位的压缩,尤其针对日志数据压缩效果更加明显,针对 1.1G 的 Nginx 日志进行测试,采用 ZSTD 策略后,膨胀率只有 0.94,甚至比原始数据还要小,而且还能进一步压缩,和 index.source_reuse 结合使用后,膨胀率只有 0.7,索引大小只有 Elasticsearch 原生 best_compression 的 59%,是 Elasticsearch 6.x 的 49%。下面是一张索引大小对比图:

更多介绍查看 详情。

其他更新功能如下:

Breaking changes

- Lucene 版本升级到 8.11.2

Breaking changes

- 增加 ZSTD codec, 引入 ZSTD 压缩算法,对存储字段,doc_values,词典进行压缩。

- 增加 index.source_reuse 索引级别配置,对 _source 进一步压缩。

- 提供索引生命周期管理 ILM 模块的功能,绝大部分 api 兼容 elasticsearch

Breaking changes

- 减少冗余日志输出。

- 减少 modules 模块整体大小。

下载地址:https://www.infinilabs.com/download

INFINI Gateway v1.13.0

极限网关本次更新如下:

Features

router.rules增加 enabled 选项,控制是否启用 flow- 增加对 loong64 架构的支持

- 增加对 riscv64 架构的支持

- elasticsearch filter 增加 dial_timeout 选项

Bug fix

- 修复 http/elasticsearch 转发后 HTTP 响应头丢失的问题

- 修复 pipeline 热加载出现重复 pipeline 同时运行的问题

- 修复 bulk_indexing 退出后泄漏 goroutine 的问题

Improvements

- 优化 HTTP 头设置方式,避免出现重复的 HTTP 头

- 优化 pipeline 停止的响应速度

- pipeline 增加 enabled 选项,控制是否启用 pipeline

更多 Gateway 更新可参考【Gateway 版本历史】。

INFINI Console v1.1.0

本次 INFINI Console 版本发布主要新增了网关实时日志查看功能、完善了数据迁移功能和数据看板的可视化能力、以及修复了已知 Bug。

实时日志

登录 Console,进入 [资源管理][网关管理] 界面,可以看到网关实时日志入口(前提需要注册网关)如下图所示:

进入实时日志展示界面,点击“开始”按钮后,服务端将 Gateway 日志实时推送到 Console 界面展示,在该界面可以动态调整输出不同的日志级别(DEBUG、INFO、WARN、ERROR 等),同时也支持文件名、方法名、消息内容加通配符进行过滤。

数据迁移

数据迁移模块,基于上个版本做了优化,添加 ILM,Template,Alias 初始化操作。方便用户根据各自的需求迁移索引生命周期、模板、别名等。

数据看板

数据看板图表支持复制、快速切换、时间框选、缩放、标记高亮,进一步增强 Console 可视化能力。

详情查看 操作演示视频。

除以上主要功能更新外,Console 其他功能优化如下:

Bug fix

- 修复数据探索保存查询出现 mapping 错误的问题

- 修复数据看板组件数据源配置的问题

- 修复数据探索左侧字段栏样式的问题

- 修复集群注册向导点击跳转后丢失集群类型的问题

Improvements

- 数据看板汉化

更多 Console 更新可参考【Console 版本历史】。

INFINI Agent v0.4.0

数据采集工具探针(INFINI Agent)更新如下:

Features

- 新增 logs_processor ,配置采集本地日志文件

Breaking changes

- es_logs_processor 调整日志字段

- created 重命名为 timestamp

- 自动提取 payload.timestamp payload.@timestmap 字段到 timestamp

- es_logs_processor 删除 enable 选项

下载地址: https://www.infinilabs.com/download/?product=agent

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

详情参见官网:https://www.infinilabs.com

INFINI Labs 产品又更新啦,包括 Easysearch v1.1.0、Gateway v1.13.0、Console v1.1.0、Agent v0.4.0,其中 Easysearch 经过团队的数月打磨,现正式对外推出。Easysearch 是一个分布式的近实时搜索与分析引擎,核心引擎基于开源的 Apache Lucene。Easysearch 衍生自基于开源协议 Apache 2.0 的 Elasticsearch 7.10.2 版本。Easysearch 的目标是提供一个轻量级的 Elasticsearch 可替代版本,并继续完善和支持更多的企业级功能。与 Elasticsearch 相比,Easysearch 更关注在搜索业务场景的优化和继续保持其产品的简洁与易用性。欢迎大家下载体验。

INFINI Easysearch v1.1.0

INFINI Easysearch 本次更新最重要的功能是引入了 ZSTD 压缩算法,对索引进行全方位的压缩,尤其针对日志数据压缩效果更加明显,针对 1.1G 的 Nginx 日志进行测试,采用 ZSTD 策略后,膨胀率只有 0.94,甚至比原始数据还要小,而且还能进一步压缩,和 index.source_reuse 结合使用后,膨胀率只有 0.7,索引大小只有 Elasticsearch 原生 best_compression 的 59%,是 Elasticsearch 6.x 的 49%。下面是一张索引大小对比图:

更多介绍查看 详情。

其他更新功能如下:

Breaking changes

- Lucene 版本升级到 8.11.2

Breaking changes

- 增加 ZSTD codec, 引入 ZSTD 压缩算法,对存储字段,doc_values,词典进行压缩。

- 增加 index.source_reuse 索引级别配置,对 _source 进一步压缩。

- 提供索引生命周期管理 ILM 模块的功能,绝大部分 api 兼容 elasticsearch

Breaking changes

- 减少冗余日志输出。

- 减少 modules 模块整体大小。

下载地址:https://www.infinilabs.com/download

INFINI Gateway v1.13.0

极限网关本次更新如下:

Features

router.rules增加 enabled 选项,控制是否启用 flow- 增加对 loong64 架构的支持

- 增加对 riscv64 架构的支持

- elasticsearch filter 增加 dial_timeout 选项

Bug fix

- 修复 http/elasticsearch 转发后 HTTP 响应头丢失的问题

- 修复 pipeline 热加载出现重复 pipeline 同时运行的问题

- 修复 bulk_indexing 退出后泄漏 goroutine 的问题

Improvements

- 优化 HTTP 头设置方式,避免出现重复的 HTTP 头

- 优化 pipeline 停止的响应速度

- pipeline 增加 enabled 选项,控制是否启用 pipeline

更多 Gateway 更新可参考【Gateway 版本历史】。

INFINI Console v1.1.0

本次 INFINI Console 版本发布主要新增了网关实时日志查看功能、完善了数据迁移功能和数据看板的可视化能力、以及修复了已知 Bug。

实时日志

登录 Console,进入 [资源管理][网关管理] 界面,可以看到网关实时日志入口(前提需要注册网关)如下图所示:

进入实时日志展示界面,点击“开始”按钮后,服务端将 Gateway 日志实时推送到 Console 界面展示,在该界面可以动态调整输出不同的日志级别(DEBUG、INFO、WARN、ERROR 等),同时也支持文件名、方法名、消息内容加通配符进行过滤。

数据迁移

数据迁移模块,基于上个版本做了优化,添加 ILM,Template,Alias 初始化操作。方便用户根据各自的需求迁移索引生命周期、模板、别名等。

数据看板

数据看板图表支持复制、快速切换、时间框选、缩放、标记高亮,进一步增强 Console 可视化能力。

详情查看 操作演示视频。

除以上主要功能更新外,Console 其他功能优化如下:

Bug fix

- 修复数据探索保存查询出现 mapping 错误的问题

- 修复数据看板组件数据源配置的问题

- 修复数据探索左侧字段栏样式的问题

- 修复集群注册向导点击跳转后丢失集群类型的问题

Improvements

- 数据看板汉化

更多 Console 更新可参考【Console 版本历史】。

INFINI Agent v0.4.0

数据采集工具探针(INFINI Agent)更新如下:

Features

- 新增 logs_processor ,配置采集本地日志文件

Breaking changes

- es_logs_processor 调整日志字段

- created 重命名为 timestamp

- 自动提取 payload.timestamp payload.@timestmap 字段到 timestamp

- es_logs_processor 删除 enable 选项

下载地址: https://www.infinilabs.com/download/?product=agent

期待反馈

欢迎下载体验使用,如果您在使用过程中遇到如何疑问或者问题,欢迎前往 INFINI Labs Github(https://github.com/infinilabs) 中的对应项目中提交 Feature Request 或提交 Bug。

- INFINI Gateway: https://github.com/infinilabs/gateway/issues

- INFINI Console: https://github.com/infinilabs/console/issues

- 下载地址: https://www.infinilabs.com/download

您还可以通过邮件联系我们:hello@infini.ltd

或者拨打我们的热线电话:(+86) 400-139-9200

也欢迎大家微信扫码添加小助手(INFINI-Labs),加入用户群讨论,或者扫码加入我们的知识星球一起学习交流。

关于极限科技(INFINI Labs)

极限科技,全称极限数据(北京)科技有限公司,是一家专注于实时搜索与数据分析的软件公司。旗下品牌极限实验室(INFINI Labs)致力于打造极致易用的数据探索与分析体验。

极限科技是一支年轻的团队,采用天然分布式的方式来进行远程协作,员工分布在全球各地,希望通过努力成为中国乃至全球企业大数据实时搜索分析产品的首选,为中国技术品牌输出添砖加瓦。

详情参见官网:https://www.infinilabs.com

收起阅读 »