请教下,聚合中 如何统计 buckets下一共有多少个key?

Elasticsearch • martindu 回复了问题 • 4 人关注 • 5 个回复 • 12509 次浏览 • 2016-09-27 01:01

elasticsearch新建一个新的索引慢

Elasticsearch • weizijun 回复了问题 • 6 人关注 • 4 个回复 • 11617 次浏览 • 2016-09-28 12:32

logsash报错阻塞

Logstash • jy 回复了问题 • 3 人关注 • 1 个回复 • 6034 次浏览 • 2016-09-30 12:02

logstash每天8点报错

Logstash • 三斗室 回复了问题 • 2 人关注 • 1 个回复 • 7004 次浏览 • 2016-10-11 10:45

elasticsearch mapping如何修改?

Elasticsearch • novia 回复了问题 • 5 人关注 • 4 个回复 • 12246 次浏览 • 2016-09-27 13:36

Elasticsearch 5.0.0 Java API 连接问题

Elasticsearch • 超超大猴子 回复了问题 • 5 人关注 • 1 个回复 • 7858 次浏览 • 2016-09-29 15:49

Elasticsearch中索引和类型关系的疑问??

Elasticsearch • Jea 回复了问题 • 2 人关注 • 1 个回复 • 6620 次浏览 • 2016-09-22 14:53

elasticsearch高耗能

Elasticsearch • yangruideyang 回复了问题 • 4 人关注 • 2 个回复 • 4244 次浏览 • 2016-09-23 17:42

如何做两个聚合时,可以按照某个度量值做top10

回复Elasticsearch • linyongzhi 发起了问题 • 1 人关注 • 0 个回复 • 4712 次浏览 • 2016-09-22 10:09

关于elasticsearch-analysis-pinyin 关于elasticsearch-analysis-pinyin插件的请教

Elasticsearch • medcl 回复了问题 • 5 人关注 • 6 个回复 • 5091 次浏览 • 2016-10-13 16:11

packetbeat结合elasticsearch和logstash使用报错怎么解决

Beats • stab 回复了问题 • 2 人关注 • 1 个回复 • 7941 次浏览 • 2016-09-22 18:07

Elastic{ON} Dev China 2016 开始报名了!

资讯动态 • medcl 发表了文章 • 8 个评论 • 6764 次浏览 • 2016-09-20 22:23

大会网站:[url=http://conf.elasticsearch.cn]http://conf.elasticsearch.cn[/url]

大会介绍:

Elastic 中国开发者大会 2016(Elastic{ON} Dev China 2016)是由 Elastic 官方在中国举办的第一次开发者大会,前身 ESCC (Elasticsearch China Conference) 是由 Elastic 中文社区每年定期举办的线下交流活动,主要围绕 Elastic 的开源产品: Elasticsearch、Logstash、Kibana 和 Beats,探讨在搜索、数据实时分析、日志分析、安全等领域的实践与应用。

大会时间:

2016-12-10 08:00 至 2016-12-10 18:00 周六

如何参与:

提供赞助:http://elasticsearch.mikecrm.com/nECSP4

提交演讲:http://elasticsearch.mikecrm.com/x0y56G

当志愿者:http://elasticsearch.mikecrm.com/n5BVwP

购买门票:http://event.3188.la/460820612/

大会具体场地和日程不断更新中,敬请关注!

ElasticSearch java API - 聚合查询

Elasticsearch • carlislelee 发表了文章 • 3 个评论 • 55308 次浏览 • 2016-09-20 17:16

index的mapping为:

"mappings": {

"player": {

"properties": {

"name": {

"index": "not_analyzed",

"type": "string"

},

"age": {

"type": "integer"

},

"salary": {

"type": "integer"

},

"team": {

"index": "not_analyzed",

"type": "string"

},

"position": {

"index": "not_analyzed",

"type": "string"

}

},

"_all": {

"enabled": false

}

}

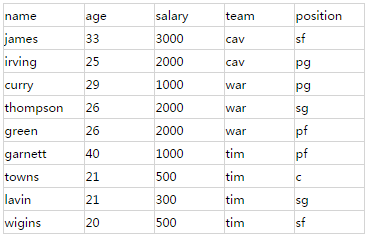

}索引中的全部数据:

首先,初始化Builder:

SearchRequestBuilder sbuilder = client.prepareSearch("player").setTypes("player");- group by/count

例如要计算每个球队的球员数,如果使用SQL语句,应表达如下:

select team, count(*) as player_count from player group by team;TermsBuilder teamAgg= AggregationBuilders.terms("player_count ").field("team");

sbuilder.addAggregation(teamAgg);

SearchResponse response = sbuilder.execute().actionGet();- group by多个field

例如要计算每个球队每个位置的球员数,如果使用SQL语句,应表达如下:

select team, position, count(*) as pos_count from player group by team, position;TermsBuilder teamAgg= AggregationBuilders.terms("player_count ").field("team");

TermsBuilder posAgg= AggregationBuilders.terms("pos_count").field("position");

sbuilder.addAggregation(teamAgg.subAggregation(posAgg));

SearchResponse response = sbuilder.execute().actionGet();- max/min/sum/avg

例如要计算每个球队年龄最大/最小/总/平均的球员年龄,如果使用SQL语句,应表达如下:

select team, max(age) as max_age from player group by team;TermsBuilder teamAgg= AggregationBuilders.terms("player_count ").field("team");

MaxBuilder ageAgg= AggregationBuilders.max("max_age").field("age");

sbuilder.addAggregation(teamAgg.subAggregation(ageAgg));

SearchResponse response = sbuilder.execute().actionGet();- 对多个field求max/min/sum/avg

例如要计算每个球队球员的平均年龄,同时又要计算总年薪,如果使用SQL语句,应表达如下:

select team, avg(age)as avg_age, sum(salary) as total_salary from player group by team;TermsBuilder teamAgg= AggregationBuilders.terms("team");

AvgBuilder ageAgg= AggregationBuilders.avg("avg_age").field("age");

SumBuilder salaryAgg= AggregationBuilders.avg("total_salary ").field("salary");

sbuilder.addAggregation(teamAgg.subAggregation(ageAgg).subAggregation(salaryAgg));

SearchResponse response = sbuilder.execute().actionGet();- 聚合后对Aggregation结果排序

例如要计算每个球队总年薪,并按照总年薪倒序排列,如果使用SQL语句,应表达如下:

select team, sum(salary) as total_salary from player group by team order by total_salary desc;TermsBuilder teamAgg= AggregationBuilders.terms("team").order(Order.aggregation("total_salary ", false);

SumBuilder salaryAgg= AggregationBuilders.avg("total_salary ").field("salary");

sbuilder.addAggregation(teamAgg.subAggregation(salaryAgg));

SearchResponse response = sbuilder.execute().actionGet();- Aggregation结果条数的问题

默认情况下,search执行后,仅返回10条聚合结果,如果想反悔更多的结果,需要在构建TermsBuilder 时指定size:

TermsBuilder teamAgg= AggregationBuilders.terms("team").size(15);- Aggregation结果的解析/输出

得到response后:

Map<String, Aggregation> aggMap = response.getAggregations().asMap();

StringTerms teamAgg= (StringTerms) aggMap.get("keywordAgg");

Iterator<Bucket> teamBucketIt = teamAgg.getBuckets().iterator();

while (teamBucketIt .hasNext()) {

Bucket buck = teamBucketIt .next();

//球队名

String team = buck.getKey();

//记录数

long count = buck.getDocCount();

//得到所有子聚合

Map subaggmap = buck.getAggregations().asMap();

//avg值获取方法

double avg_age= ((InternalAvg) subaggmap.get("avg_age")).getValue();

//sum值获取方法

double total_salary = ((InternalSum) subaggmap.get("total_salary")).getValue();

//...

//max/min以此类推

}- 总结

综上,聚合操作主要是调用了SearchRequestBuilder的addAggregation方法,通常是传入一个TermsBuilder,子聚合调用TermsBuilder的subAggregation方法,可以添加的子聚合有TermsBuilder、SumBuilder、AvgBuilder、MaxBuilder、MinBuilder等常见的聚合操作。

从实现上来讲,SearchRequestBuilder在内部保持了一个私有的 SearchSourceBuilder实例, SearchSourceBuilder内部包含一个List<AbstractAggregationBuilder>,每次调用addAggregation时会调用 SearchSourceBuilder实例,添加一个AggregationBuilder。

同样的,TermsBuilder也在内部保持了一个List<AbstractAggregationBuilder>,调用addAggregation方法(来自父类addAggregation)时会添加一个AggregationBuilder。有兴趣的读者也可以阅读源码的实现。

如果有什么问题,欢迎一起讨论,如果文中有什么错误,欢迎批评指正。

注:文中使用的Elastic Search API版本为2.3.2